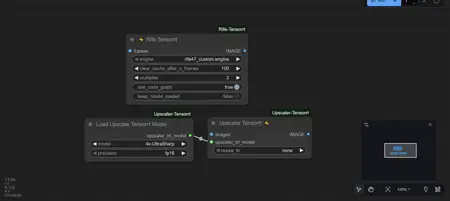

RifeTensorrt Interpolation using Tensortcore and upscaler.

详情

下载文件

关于此版本

模型描述

- 与 ComfyUI 桌面版和 ComfyUI Portable 兼容的一键安装:

首先在上方版本列表中选择你的 CUDA 版本,然后下载、解压,接着点击 INSTALL_RIFE.bat。将你的 ComfyUI 文件夹拖入(例如:G:\ComfyUI_windows_portable1),在命令提示符中拖入该文件夹后,系统会询问你希望安装哪个 wheel 包。请选择你的 Python 版本(CP38 至 CP313,即你的 Python 版本)。完成!你现在可以像疯子一样进行插帧了。注意,安装完成后,你还可以通过管理器安装 comfyui-upscaler-tensorrt。

安装完成后,你可以安全删除安装文件。

https://github.com/yuvraj108c/ComfyUI-Rife-Tensorrt?tab=readme-ov-file

https://github.com/yuvraj108c/ComfyUI-Upscaler-Tensorrt

感谢 https://github.com/yuvraj108c/ComfyUI-Rife-Tensorrt 制作该节点。

我想分享这个,因为我之前使用 VF1 电影插帧和 RIFE 插帧,但插帧一个 20 秒的视频时速度较慢。于是我制作了一个教程,教你怎么让 Rife TensorRT 正常工作。它非常快,还有一个使用 TensorCore 的上采样器,速度也相当快。

- 手动安装方法:

- 步骤 1:前往 NVIDIA TensorRT 下载页面:https://developer.nvidia.com/tensorrt

- 步骤 2:你需要一个账户,因此请登录或注册 NVIDIA 账号

- 步骤 3:登录后,下载合适的文件。对我而言,是 TensorRT 10.14.1 GA for Windows 10, 11, Server 2022 和 CUDA 13.0 ZIP 包,因为我下载的是最新版 ComfyUI Portable,它使用的是 CUDA 13.0。

- 步骤 4:下载完成后,将其解压到某个文件夹中。打开该文件夹,进入 PYTHON 文件夹,你会看到:tensorrt-10.14.1.48-cp313-none-win_amd64.whl。CP313 是 Python 版本。

- 步骤 5:现在你需要安装步骤 4 中的 wheel 包。前往你的 ComfyUI 文件夹(例如:G:\ComfyUI_windows_portable\python_embedded),在搜索栏中输入 CMD,打开命令窗口,输入:python.exe -m pip install ...\...\python\tensorrt-10.14.1.48-cp313-none-win_amd64.whl(请将路径替换为你实际存放 tensorrt-10.14.1.48-cp313-none-win_amd64.whl 文件的位置)。然后安装它。

- 步骤 6:进入你的 python_embedded 文件夹(例如:G:\ComfyUI_windows_portable\python_embedded\Lib\site-packages),在 site-packages 文件夹内创建一个名为 tensorrt_libs 的新文件夹。然后将以下链接中的所有文件复制到该文件夹中:https://huggingface.co/pitou69/tensorrt_libs/tree/main/tensorrt_libs。(注意:这些文件适用于 Python 3.13 或 3.12 及任意 CUDA 版本)。下载所有文件并复制到 tensorrt_libs 文件夹中。

- 步骤 7:现在你需要在你的模型文件夹中创建一个新文件夹(例如:G:\ComfyUI_windows_portable\ComfyUI\models),命名为 tensorrt。在该文件夹内再创建一个名为 rife 的文件夹,然后下载引擎文件:https://huggingface.co/pitou69/tensorrt_libs/tree/main/tensorrt/rife,并将 rife47_custom.engine 文件放入其中。

如果你想测试所有 RIFE 引擎(模型),请访问:https://huggingface.co/pitou69/tensorrt_libs/tree/main/rife%20engine。由于 RIFE 49 被推荐使用,我已为 RIFE 49 和 48 构建了引擎。

- 手动下载:(仅适用于 Python 3.13 和 3.12 + CUDA 13.0。你仍可使用 tensorrt_libs 文件,但需按教程完成步骤 1 至 4。如果你使用的是其他 CUDA 版本(如 CUDA 12.4),请自行构建 wheel 包。)

如果你决定信任我的压缩包并下载我的文件,其中包含了 python_embedded 的全部内容,操作如下:

- 步骤 1:下载压缩包并解压到某个文件夹。

- 步骤 2:将三个文件夹 tensorrt、tensorrt_libs 和 tensorrt-10.14.1.48.dist-info 复制到:G:\ComfyUI_windows_portable\python_embedded\Lib\site-packages。

- 步骤 3:进入你的模型文件夹(例如:G:\ComfyUI_windows_portable\ComfyUI\models),创建一个名为 tensorrt 的文件夹,再在其中创建一个名为 rife 的文件夹,然后将 rife47_custom.engine 文件复制到该文件夹中即可。

此快速安装方法仅适用于信任他人下载文件的情况。否则,请按我制作的教程操作。此外,此快速安装仅适用于新版 ComfyUI Portable(即 Python 3.13 或 3.12 + CUDA 13.0)。

完成!你现在可以享受超快的插帧效果了。

编辑:完成所有安装后,你还可以安装 TensorRT 上采样器。https://github.com/yuvraj108c/ComfyUI-Upscaler-Tensorrt 你可以在管理器中同时下载插帧器和上采样器。上采样器在完成教程或下载压缩包后即可使用。注意:上采样器在将 480p 或更高分辨率(如 720p)进行上采样时会占用一定显存,我尚未找到降低显存占用的方法。建议在 Rife TensorRT 插帧节点后添加一个“清空显存”节点,这可能会有所帮助。