DPO (Direct Preference Optimization) LoRA for XL and 1.5 - OpenRail++

詳細

ファイルをダウンロード

モデル説明

DPOとは?

DPOはDirect Preference Optimization(直接的選好最適化)の略で、人間が選択した画像をもとにディフュージョンモデルを微調整するプロセスを指します。Meihua Dangらは、この手法を用いてStable Diffusion 1.5およびStable Diffusion XLを学習し、https://huggingface.co/datasets/yuvalkirstain/pickapic_v2で公開されているPick-a-Pic v2データセットを使用しました。この研究についてはhttps://huggingface.co/papers/2311.12908で論文が公開されています。

何ができる?

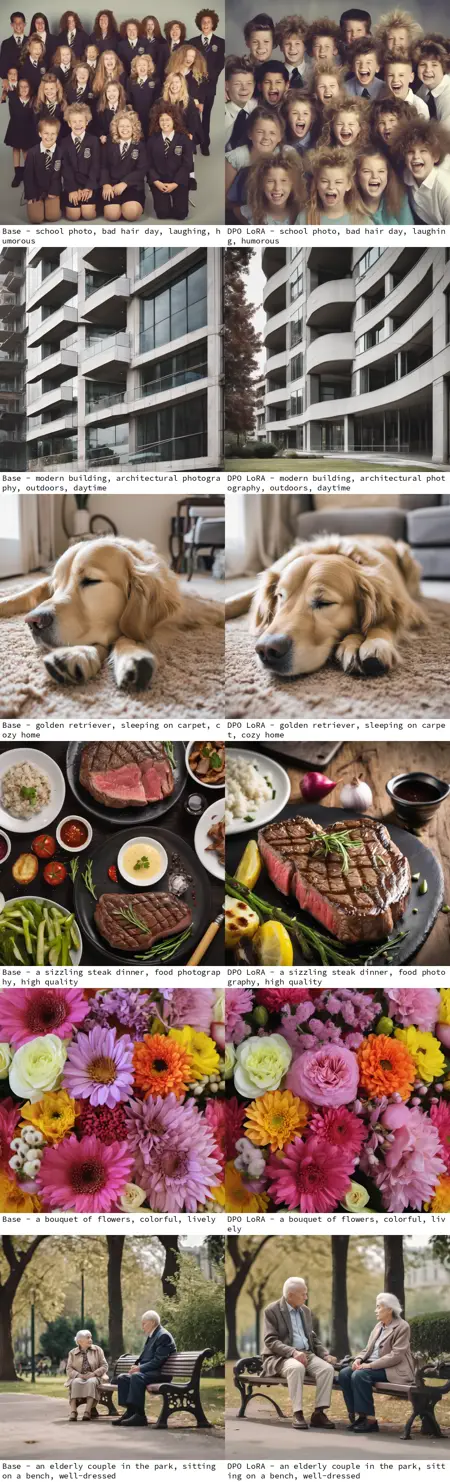

学習済みのDPOモデルは、微調整されていないモデルと比較して、より高品質な画像を生成することが観察されており、特にプロンプトへの忠実性が大幅に向上しています。これらのLoRAは、他の微調整済みStable Diffusionモデルにもこのプロンプト忠実性を適用できます。

誰が学習した?

これらのLoRAは、Meihua Dangさん(https://huggingface.co/mhdang)の研究成果に基づいています:

https://huggingface.co/mhdang/dpo-sdxl-text2image-v1 および https://huggingface.co/mhdang/dpo-sd1.5-text2image-v1

OpenRail++ライセンスのもとで提供されています。

これらのLoRAはどのように作られた?

これらはKohya SSを使用して、CivitAIおよびHuggingFace上の他のOpenRail++ライセンス対象のチェックポイントから抽出して作成されました。

1.5: /model/240850/sd15-direct-preference-optimization-dpo は、https://huggingface.co/fp16-guy/Stable-Diffusion-v1-5_fp16_cleaned/blob/main/sd_1.5.safetensors から抽出。

XL: /model/238319/sd-xl-dpo-finetune-direct-preference-optimization は、https://huggingface.co/stabilityai/stable-diffusion-xl-base-1.0/blob/main/sd_xl_base_1.0_0.9vae.safetensors から抽出。

これらはまたHuggingFaceのhttps://huggingface.co/benjamin-paine/sd-dpo-offsets/でもホストされています。