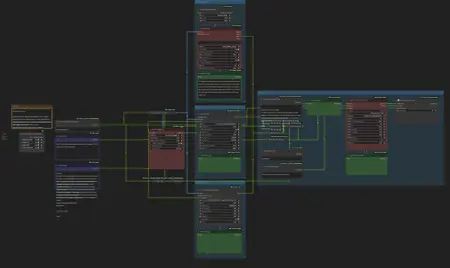

Workflow to generate image descriptions on Apple Silicon Mac

详情

下载文件

关于此版本

模型描述

关于

这是一个工作流,利用多个图像到文本工具和一个大语言模型(LLM),为文件夹中的一批图像生成最终的图像描述,并输出对应的 .txt 文件。

这在为 NSFW 图像生成标注/描述以用于 LoRA 训练或微调时特别有用,因此我们选用了以下三个视觉语言模型(VLM):

- Florence2、WD1.4 标签生成器

- JoyCaption alpha 2

- huihui-ai/Qwen2-VL-7B-Instruct-abliterated

最终图像描述的合成部分通过 ollama 节点完成,可以说这是使用本地 LLM 最简单的方式之一。

通过使用未经审查的大型模型,例如 huihui-ai/Llama-3.3-70B-Instruct-abliterated,你将获得惊人的效果。

(为达到最佳效果,无论是否涉及 NSFW 内容,Qwen2-VL 和 LLM 均应使用 abliterated / 未经审查的模型)。

安装

除了 ComfyUI_Qwen2-VL-Instruct 和 Comfyui_JC2 节点外,其余缺失节点请通过 ComfyUI 管理器安装。

ComfyUI_Qwen2-VL-Instruct

为使此工作流正常运行,你需要使用来自以下 fork 的 Qwen2-VL-Instruct 节点:

https://github.com/edwios/ComfyUI_Qwen2-VL-Instruct

此 fork 包含两项重大改进:支持与其它 VLM 工具相同的图像输入,并可在 macOS 的 GPU(mps)上运行,兼容 Python 3.12 及以上版本,最高支持 PyTorch 2.6。

Comfyui_JC2

你也可以使用此 ComfyUI_JC2 fork 来在 JoyCaption: Alpha 2 中启用 Mac GPU 加速。

使用方法

所有与该工作流交互所需的内容均位于最左侧。

最简单的方式是输入包含图像的目录路径。结果将写入同一目录,文件名与图像相同,但扩展名为 .txt。

你还可以选择进行以下操作:

- 修改 VLM 提示词,使 Qwen2-VL 专注于图像的特定方面

- 修改 LLM 提示词以获得更好的推理效果,或要求其以 SFW 方式撰写描述(建议至少使用 70B 级别的 instruct 模型)。[不,这与使用“安全”模型完全不是一回事。]

致谢

感谢所有为 ComfyUI 及这些节点的开源做出贡献的人。

特别感谢以下项目:

ComfyUI_Qwen-VL-Instruct,

ComfyUI_JC2,

ComfyUI-WD14-Tagger,

ComfyUI-Ollama,

ComfyUI-Florence2

以及 Ollama,使这些强大的机器学习模型能在 mps 上运行,或至少不强制仅限于 NVIDIA 解决方案。