Onimai-characters-LoHa/LoRa おにまい || Oyama Mahiro / Oyama Mihari / Hozuki Kaede / Hozuki Momiji / Murosaki Miyo / Oka Asahi

详情

下载文件

关于此版本

模型描述

请注意,第一个模型是使用 clip skip 1 训练的。如果你希望使用 clip skip 2,请使用第二个模型。

在大多数情况下,这两个模型的表现应该非常相似(只要你使用与模型训练时对应的 clip skip 设置)。最后两张示例图像中提供了一些对比。

--

更新后的模型使用了截至 2023 年 4 月 30 日我收集的全部动画系列作品及粉丝艺术作品进行训练。

我认为这在 Miyo 和 Asahi 的表现上应该有所提升。

FujimiNemu 和 TenkawaNayuta 的图像数量较少,我认为它们并未被充分学习。

其他训练步骤的检查点可在配套的 Hugging Face 仓库中找到 https://huggingface.co/alea31415/onimai-characters,特别是 https://huggingface.co/alea31415/onimai-characters/tree/main/loha_all_0430。

和往常一样,这些网络是在 ACertainty 的基础上训练的,应能与大多数主流动画模型兼容。

对于 LoHa,我提供了 clip skip 1 和 clip skip 2 两个版本,而旧版 LoRa 是基于 clip skip 1 训练的(据我记忆是这样)。

你也可以尝试切换多种风格:aniscreen、fanart、edstyle、manga cover。但需要注意:

- aniscreen 可能与风格模型产生冲突

- edstyle 通常会带来文字,且一旦出现很难去除

- manga cover 有时也可能生成文字,但可通过合适的提示词和采样器缓解

- 大多数情况下,留空提示词可能是最稳妥的做法

补充说明:

- 服装似乎已被正确学习。我不确定触发每种服装所需的最低条件。请使用常识:例如制服可写为“school uniform, jacket”或“school uniform, suspenders”;对于 Mihari,可写“bolo tie, labcoat”。使用负向提示词避免混合效果。

- 训练过程中我仅移除了与眼睛相关的标签。因此在提示词中你可能需要提供更多关于发型的描述。我做出这个决定是因为每个角色在不同场景中会呈现多种发型。

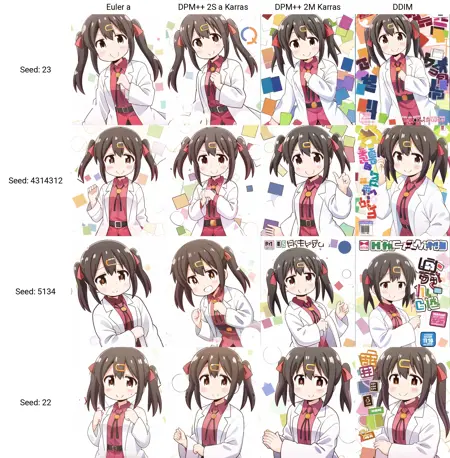

- 采样器的选择主要取决于个人偏好,但有时会产生奇怪的效果。例如,当我使用 DDIM 时,manga cover 风格会出现大量奇怪内容。相比之下,Euler a 和 DPM++ 2S Karras 通常产生更好的结果。但该风格的训练图像中并无任何文字,因此这些内容的出现实在令人费解。

--

我不需要支持或署名,但如果知道你正在使用我训练的模型并觉得有用,我会感到欣慰。

此外,我非常希望推动更多跨作品角色模型的发展。

如果你感兴趣,可以查看我的工作流 https://github.com/cyber-meow/anime_screenshot_pipeline。

我只是想传达一个事实:没有必要为每个 LoRA 只编码单一概念。