Studio Ghibli 🎥 HunyuanVideo

세부 정보

파일 다운로드

모델 설명

면책사항

기본적인 HunyuanVideo는 LoRA 없이도 일반적인 애니메이션 스타일을 잘 이해하며, 스타디오 지브리의 예술 스타일에 대해 일부 지식을 가지고 있습니다. 그러나 이 스타일은 일관되지 않으며, 프롬프트에 매우 의존적이며 가끔 현실적인 스타일로 되돌아가는 경우가 있습니다. 그리고 셰이딩, 팔레트, 선 작업도 상당히 다를 수 있습니다. 그래서 이 LoRA를 만들며, HunyuanVideo에 지브리 예술 스타일을 더 강화하려고 시도했습니다.

이 LoRA는 세 번째 버전입니다. 이전 두 버전은 성공하지 못했고, 저는 이를 공개하지 않았습니다.

업데이트. 2025년 8월 1일 불행히도, 이전 모델을 작업할 여유 시간이 없어 이 모델의 재학습은 더 이상 계획되지 않습니다.

업데이트. 2025년 3월 14일 Wan2.1-14B-T2V을 일주일 동안 테스트한 결과, 이 모델이 HV보다 우수함을 인정해야 합니다. 따라서 저는 Wan 학습으로 전환하기로 결정했고, 더 이상 HV 모델을 출시할 계획이 없습니다. 그러나 저는 아직도 이 LoRA를 완성할 의무를 느껴, 향후 다른 계획된 Flux/Wan 모델을 마친 후, 단순 이미지가 아닌 영상으로 적절히 학습된 Ghibli LoRA 업데이트를 출시하기 위해 최선을 다하겠습니다.

업데이트. 2025년 3월 2일 Lumina-2와 Wan-2.1에 몰입하다가 다시 Flux 학습으로 돌아왔고, v0.7은 약간 연기될 예정입니다. 하지만 확실히 출시할 예정이며(아마도 또 다른 애니메이션 LoRA와 함께)입니다.

업데이트. 2025년 2월 8일 v0.6 는 실망이었습니다. 저는 몇 가지 위험한 결정을 내렸는데, 이 결정들은 그 결과를 정당화하지 못했고, RTX 3090에서 84시간의 학습 시간에 값하지 않았습니다. v0.7을 기대해 주세요! 🙂

업데이트. 2025년 1월 5일 musubi-tuner로 v.0.4 학습을 완료했지만, v0.3보다 성능이 더 나빴기 때문에 공개하지 않겠습니다( v0.5에는 diffusion-pipe를 사용합니다).

업데이트. 2025년 1월 21일 v0.5 학습 중에 너무 많은 실수를 저질렀고, 따라서 이 버전을 폐기하고 향상된 데이터셋과 학습 파라미터로 처음부터 다시 시작하기로 결정했습니다(또 한 번 musubi를 시도해 보겠습니다). 32시간이 낭비되었지만, 이는 좋은 결과를 위한 투자입니다 :)

사용법

추론 시 저는 기본 ComfyUI 파이프라인에 단순히 추가 LoRA 로더 노드만 사용합니다. Kijai의 래퍼도 작동할 것입니다(적어도 일주일 전에는 작동했지만, 그 이후로는 네이티브 워크플로로 전환했습니다). 파라미터는 기본값이며, 다음만 다릅니다:

guidance: 7.0

steps: 30

이 값들이 최적은 아닙니다. 단지 저는 주로 이 값들로 클립을 생성했을 뿐이며, 다른 조합이 더 나은 결과를 낼 수도 있습니다.

현재 사용하는 프롬프트 템플릿은 다음과 같습니다:

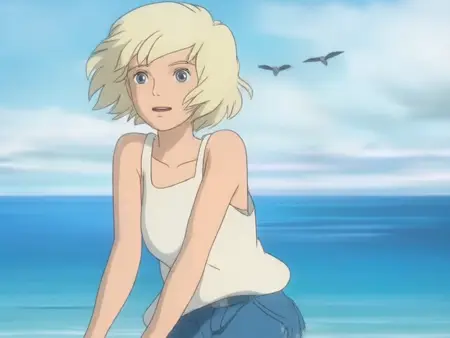

A scene from a Studio Ghibli animated film, featuring [CHARACTER DESCRIPTION], as they [ACTION] at [ENVIRONMENT], under [LIGHTING], with [ADDITIONAL SETTING DETAILS], while the camera [CAMERA WORK], emphasizing [MOOD AND AMBIANCE].

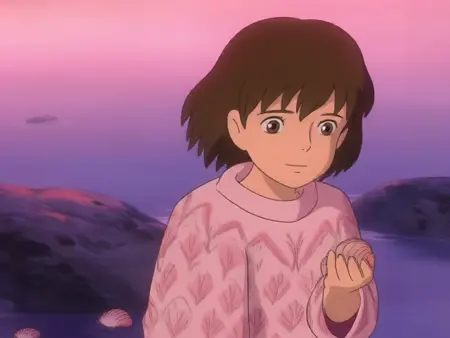

저는 일반적으로 “blonde woman, barefeet, ocean seashore, fine weather” 등의 태그를 LLM에 입력하고, 이 템플릿에 따라 자연스러운 언어로 일관된 프롬프트를 생성해 달라고 요청합니다.

학습

저의 학습 방식이 최적은 아니라는 점을 명심해 주세요. 저는 단지 테스트와 실험을 하고 있을 뿐이며, 이 LoRA가 효과를 발휘한 이유가 좋은 방법 때문이 아니라, 오히려 나쁜 방법임에도 불구하고 작동했을 가능성이 있습니다.

현재 버전의 LoRA는 다양한 지브리 영화의 스크린캡 185개(512x512)로 학습되었습니다. 이 이미지들은 CogVLM2를 사용해 캡션화되었습니다. 캡션 생성 프롬프트는 다음과 같습니다:

Create a very detailed description of this image as if it was a frame from Studio Ghibli movie. The description should necessarily 1) describe the main content of the scene, detail the scene's content, which notably includes scene transitions and camera movements that are integrated with the visual content, such as camera follows some subject 2) describe the environment in which the subject is situated 3) identify the type of video shot that highlights or emphasizes specific visual content, such as aerial shot, close-up shot, medium shot, or long shot 4) include description of the atmosphere of the video, such as cozy, tense, or mysterious. Do not use numbered lists or line breaks. IMPORTANT: output description MUST ALWAYS start with unaltered phrase 'A scene from Studio Ghibli animated film, featuring...', and then insert your detailed description.

학습에는 diffusion-pipe.를 사용했습니다. 다른 가능한 선택지는 finetrainers (현재 HV 학습에는 >24GB VRAM 필요), musubi-tuner (아직 좋은 결과를 얻지 못했지만, 소프트웨어 탓은 아님), 그리고 OneTrainer (아직 시도하지 않음)입니다.

학습은 Windows 11 Home (WSL2), 64GB RAM, RTX 3090 단일 GPU에서 진행되었습니다. 학습 파라미터는 기본값(main, dataset)이며, 다음만 변경되었습니다:

rank = 16

lr = 6e-5

각 에포크마다 저장했고, 총 20 에포크를 진행했으며, 각 에포크는 462 스텝으로 구성되어 총 9240 스텝이었습니다. RTX 3090에서의 속도는 약 7초/스텝이었고, 각 에포크는 약 1시간 미만이 소요되었습니다. 13번째에서 20번째 에포크를 테스트한 결과, 19번째 에포크가 가장 일관성이 높고 에러가 가장 적어 선택했습니다.

결과는 여전히 완벽하지 않지만, 향상된 버전을 제공하고자 합니다. 다음 버전은 이미지가 아닌 클립으로 학습될 예정이지만, 데이터셋 준비에 시간이 필요합니다.

또한 향후 출시될 I2V 모델이 스타일 LoRA를 무의미하게 만들 가능성도 있습니다.

P.S.

이러한 뛰어난 로컬 비디오 모델이 나왔다는 사실에 여전히 놀라움을 금치 못합니다. 이제 로컬 비디오 생성 분야에 진정한 Stable Diffusion의 순간이 도래했다고 느낍니다. 미래에 더 뛰어난 모델이 등장할 것임은 분명하지만, HunyuanVideo는 저에게는 분명히 처음이자 유일한 모델일 것입니다 ❤️