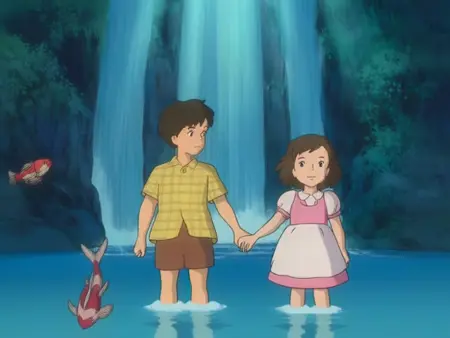

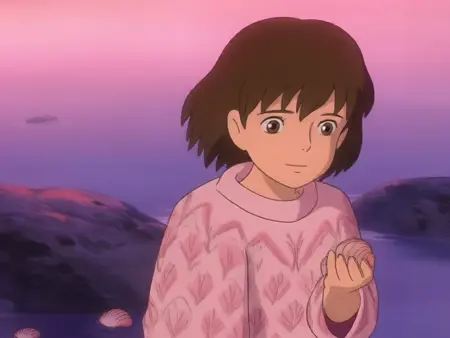

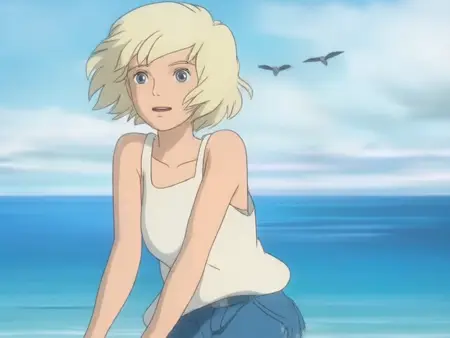

Studio Ghibli 🎥 HunyuanVideo

詳細

ファイルをダウンロード

モデル説明

免責事項

ベースのHunyuanVideoは、LoRAなしでも一般的なアニメスタイルを十分に理解しており、スタジオジブリのアートスタイルについてもある程度の知識を持っていますが、後者は一貫性がなく、プロンプトに非常に依存しており、時々リアルなスタイルに戻ってしまうことがあります。また、シェーディング、パレット、ラインワークもかなり異なることがあります。そのため、このLoRAを作成したのは、HunyuanVideoに対してジブリのアートスタイルをより強く強化しようという意図からです。

これはLoRAの3回目のバージョンです。前の2バージョンは成功せず、公開していません。

更新:2025年8月1日 残念ながら、古いモデルの開発に使える時間が取れなくなったため、このモデルの再学習は今後行いません。

更新:2025年3月14日 Wan2.1-14B-T2Vを1週間テストした結果、これはHunyuanVideoよりも優れていると認めざるを得ません。そのため、今後はWanの学習にシフトし、これ以上HunyuanVideo用モデルをリリースする予定はありません。ただし、私が計画している他のFlux/Wanモデルの開発が完了次第、ジブリLoRAの更新版をリリースするつもりです(なぜなら、画像だけでなく動画を用いた適切な学習でこのLoRAを完成させなければならないと感じているからです)。

更新:2025年3月2日 Lumina-2とWan-2.1に夢中になり、再びFluxの学習に戻ってしまったため、v0.7のリリースは少し延期されます。ただし、必ずリリースします(おそらくもう1つのアニメLoRAと同時に)。

更新:2025年2月8日 v0.6 はがっかりする結果でした。いくつかのリスクの高い決定を下しましたが、それらは正当化されず、RTX 3090で84時間も学習する価値はなかったため、v0.7をお楽しみに!🙂

更新:2025年1月5日 musubi-tunerで**v0.4**の学習を完了しましたが、v0.3よりも劣っていたため、公開しません(v0.5ではdiffusion-pipeを使用します)。

更新:2025年1月21日 v0.5 の学習中に多くのミスを犯したため、データセットと学習パラメータをアップグレードしてゼロからやり直すことにし(musubi-tunerももう一度試してみます)、32時間の学習は無駄でしたが、良い結果につながるでしょう :)。

使用方法

推論には、追加のLoRAローダーノードを一つ付け加えたデフォルトのComfyUIパイプラインを使用しています。Kijaiのラッパーも動作するはずです(少なくとも1週間前は動作しましたが、その後ネイティブワークフローに移行しました)。パラメータはデフォルトのままですが、以下の点のみ変更しています:

guidance: 7.0

steps: 30

これらが最適というわけではなく、単に私は主にこれらの値でクリップを生成してきたというだけです。他の組み合わせの方が良い結果を出す可能性もあります。

現在使用しているプロンプトテンプレートは以下の通りです:

A scene from a Studio Ghibli animated film, featuring [CHARACTER DESCRIPTION], as they [ACTION] at [ENVIRONMENT], under [LIGHTING], with [ADDITIONAL SETTING DETAILS], while the camera [CAMERA WORK], emphasizing [MOOD AND AMBIANCE].

私は通常、LLMに「金髪の女性、素足、海辺、快晴、など」といったタグのセットを入力し、このテンプレートに従って自然言語で整合性のあるプロンプトを生成するよう依頼します。

学習

私の学習プロセスは最適ではありません。単に試行錯誤と実験を行っているだけなので、うまくいったのは「良い方法だから」ではなく、「悪かったにもかかわらずうまくいった」可能性もあります。

現在のLoRAバージョンは、さまざまなジブリ映画のスクリーンキャップ(185個、512x512)を用いて学習されています。これらの画像にはCogVLM2でキャプションを付与しました。キャプション生成のプロンプトは以下の通りです:

この画像をスタジオジブリのアニメ映画の1コマであるかのように、非常に詳細に描写してください。描写には必ず以下の4項目を含めてください:1) シーンの主な内容と、カメラの動きやシーンの遷移などの視覚的要素と一体化した描写(例:カメラが対象を追う)2) 対象が置かれている環境の描写 3) 視覚的コンテンツを強調する映像の種類(例:空撮、クローズアップ、ミディアムショット、ロングショットなど)4) 動画の雰囲気(例:居心地が良い、緊張感のある、謎めいたなど)。番号リストや改行は使用しないでください。重要:出力の記述は必ず、変更せずに「A scene from Studio Ghibli animated film, featuring...」というフレーズで始めて、その後に詳細な描写を続けます。

学習にはdiffusion-pipeを使用しました。他の選択肢としてはfinetrainers(現時点ではHVを学習するには24GB以上のVRAMが必要です)、musubi-tuner(まだ良い結果が出せていませんが、ソフトウェアの問題ではありません)、OneTrainer(試したことはありません)があります。

学習はWindows 11 Home(WSL2)、64GB RAM、RTX 30901台で実行しました。学習パラメータはデフォルトのまま(main、dataset)でしたが、以下の2点のみ変更しました:

rank = 16

lr = 6e-5

各エポックで保存し、20エポックを実行しました。各エポックは462ステップで、合計9240ステップです。RTX 3090での学習速度は約7秒/ステップ(つまり、1エポックはほぼ1時間未満で終了)。エポック13〜20をテストした結果、エポック19が最も一貫性が高く、エラーが少なかったため選択しました。

結果はまだ完璧ではありませんが、改善版を提供できるよう努めます。次バージョンは画像ではなく動画クリップで学習する予定ですが、データセットの準備に時間がかかります。

また、今後登場するI2Vモデルによって、スタイルLoRAは無意味になる可能性もあります。

P.S.

このような優れたローカル動画モデルが実現できたことに、まだ驚いています。今やローカル動画生成の「Stable Diffusionの瞬間」が訪れたと感じます。将来、これより優れたモデルが登場するのは間違いありませんが、少なくとも私にとっては、HunyuanVideoはこの分野の最初のモデルであり続けるでしょう ❤️