Hunyuan Video / Wan LoRA training toolkit

세부 정보

파일 다운로드

모델 설명

LoRA용 데이터셋을 준비하는 것은 귀찮은 일일 수 있습니다. 게으른 제가 이 과정의 가능한 한 많은 부분을 자동화하려고 시도했습니다.

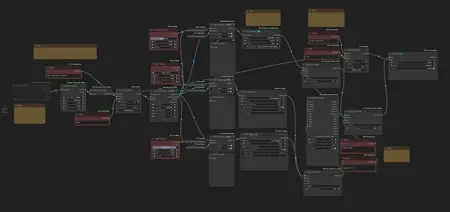

첫째, 폴더에서 비디오를 추출하고 프레임 속도를 원하는 목표 프레임 속도(기본값은 Hunyuan용으로 24fps)로 변환하는 워크플로를 만들었습니다. 이를 위해 원래 프레임 속도와 목표 프레임 속도의 최소공배수(LCM)를 계산합니다(예: 30과 24의 경우 120). 그런 다음 FILM을 사용하여 두 수의 LCM까지 프레임을 보간한 후, 목표 프레임 속도로 되돌리기 위해 필요한 프레임만 유지합니다. 약간 과도할 수 있지만, 컴퓨터 성능이 충분하다면 이 과정을 통해 번거로움을 줄일 수 있습니다.

수학 계산을 위한 맞춤형 노드를 직접 만들어야 했으며, 매니저에서 찾을 수 없는 경우 여기에 링크를 제공합니다: https://github.com/EmilioPlumed/ComfyUI-Math.

둘째, 폴더 내 비디오에 자막을 부여하는 다른 워크플로를 만들었습니다. Joy Captioner alpha 2를 사용하여 상세한 설명을 생성하고, 두 개의 wd14 태거를 사용하여 서로 다른 지점에서 태그를 추출하도록 설정했습니다. 세 개의 자막 각각에는 비디오의 어느 구간에서 설명이나 태그를 추출할지 선택할 수 있는 슬라이더가 있습니다. 그런 다음 중복 태그를 제거하고 텍스트를 하나의 .txt 파일로 결합합니다.

이 워크플로는 파일 이름을 연속적으로 번호로 재명명해야 합니다.