ON-THE-FLY 实时生成!Wan-AI 万相/ Wan2.1 Video Model (multi-specs) - CausVid&Comfy&Kijai - workflow included

세부 정보

파일 다운로드

이 버전에 대해

모델 설명

모든 것을 하나로, 만으로 모두를

우리의 재능 있는 커뮤니티 창작자들에게 우리의 최신 모델을 소개하게 되어 기쁩니다:

Wan2.1-VACE, 모든 것을 하나로 통합한 비디오 생성 및 편집 모델.

모델 크기: 1.3B, 14B 라이선스: Apache-2.0

만약 우리가 만상 세계에 있다면, 어떻게 될까요?

모델은 두 가지 텍스트-투-비디오 모델(1.3B 및 14B)과 두 가지 해상도(480P 및 720P)를 지원합니다.

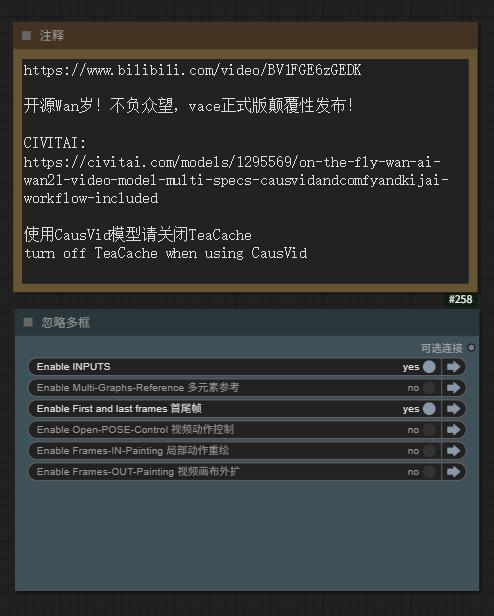

WAN-VACE는 본질적으로 T2V 모델이 아니라, R(참조)2V입니다. WAN용 비디오 ControlNet으로 이해할 수 있으므로 T2V 워크플로우를 제공할 수 없습니다. CausVid 가속기는 WAN-VACE에 적용할 수 있는 디스틸레이션 가속 기술로, 4~8단계의 가속 생성을 제공합니다.

WAN-VACE 자체는 T2V 모델이 아니라 R(참조)2V이며, WAN의 비디오 CN으로 이해할 수 있으므로 T2V 워크플로우를 제공할 수 없습니다. CausVid 가속기는 디스틸레이션 가속 기술로, WAN-VACE에 적용하여 4-8단계의 가속 생성을 제공합니다.

소개

VACE는 비디오 생성 및 편집을 위한 모든 기능을 통합한 모델입니다. 참조-투-비디오 생성(R2V), 비디오-투-비디오 편집(V2V), 마스킹된 비디오-투-비디오 편집(MV2V) 등 다양한 작업을 포함하며, 사용자가 이 작업들을 자유롭게 조합할 수 있습니다. 이 기능을 통해 사용자는 다양한 가능성을 탐색하고 워크플로우를 효과적으로 간소화할 수 있으며, Move-Anything, Swap-Anything, Reference-Anything, Expand-Anything, Animate-Anything 등 다양한 기능을 제공합니다.

VACE는 비디오 생성 및 편집을 위한 일체형 모델입니다. 참조-투-비디오 생성(R2V), 비디오-투-비디오 편집(V2V), 마스크된 비디오-투-비디오 편집(MV2V) 등 다양한 작업을 포함하며, 사용자가 자유롭게 이 작업들을 조합할 수 있습니다. 이 기능은 사용자가 다양한 가능성을 탐색하고 워크플로우를 효과적으로 단순화하며, Move-Anything, Swap-Anything, Reference-Anything, Expand-Anything, Animate-Anything 등의 기능을 제공합니다.

CausVid**-Wan2-1**에 대해:

5-16 Kijai의 CausVid를 위한 최고의 솔루션 (최선의 실천 사례)

Wan21_CausVid_14B_T2V_lora_rank32.safetensors · Kijai/WanVideo_comfy

가중치 추출 및 블록 분리를 통해,

KJ는 어떤 14B WAN 모델에도 사용 가능한 범용 CausVid LoRA를 rank32로 제공합니다,

심지어 FT 모델 및 I2V 모델을 포함합니다!

이것이 CausVid의 초기 의도는 아니었을 수 있지만, LoRA 매개변수를 유연하게 조정함으로써(0.3~0.5), 가정용 그래픽 카드에서도 전례 없는 접근성을 달성했습니다!

KJ-신과 같은 개발자는 1.3B 양방향 추론 버전의 LoRA 내보내기 파일도 제공합니다.

Wan21_CausVid_bidirect2_T2V_1_3B_lora_rank32.safetensors

동시에, xunhuang1995가 tianweiy/CausVid에서 제공하는 Warp-4Step_cfg2 자회귀 버전 1.3B CausVid 모델을 업로드했습니다.

상과 위가 하나가 되어, 모두가 만 속에

WAN-VACE 전체 모델을 위한 최적의 적합성

5/15 REDCausVid**-Wan2-1**-14B-DMD2-FP8 업로드, 8-15단계 CFG 1

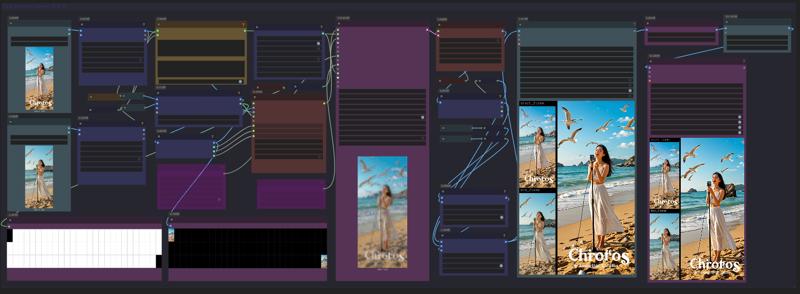

이 페이지 오른쪽 다운로드 목록은 Safetensors 형식이며, 워크플로우는 Training data 압축 파일 내에 포함되어 있습니다.

이 페이지 오른쪽의 다운로드 목록은 Safetensors 형식이며, 워크플로우는 Training data 압축 파일 내에 포함되어 있습니다. 예제 이미지와 비디오에도 워크플로우가 포함되어 있습니다(예, 원본 비디오 파일을 ComfyUI에 직접 넣고 워크플로우를 추출해 보세요).

5/15 Aiwood WAN-ACE 완전 기능 워크플로우 업로드

5/15 ComfyUI KJ-WanVideoWrapper 업데이트됨

5/14 autoregressive_checkpoint.pt 1.3b 업로드, PT UNET 로더

5/14 bidirectional_checkpoint2.pt 1.3b 업로드, PT UNET 로더

KJ-WanVideoWrapper에 새로운 샘플러 Flowmatch_causvid 추가

출처:

⭐ 별 한 개 달아주세요 ⭐

[WAN1.2 LoRAs의 VACE에 대한 적합성 테스트 결과에 따르면, 약 **75%**의 I2V/T2V LoRA 가중치가 효과를 발휘하지만, 민감도가 낮아집니다(LoRA 가중치를 100% 이상으로 증가시키는 것이 도움이 될 수 있습니다).]

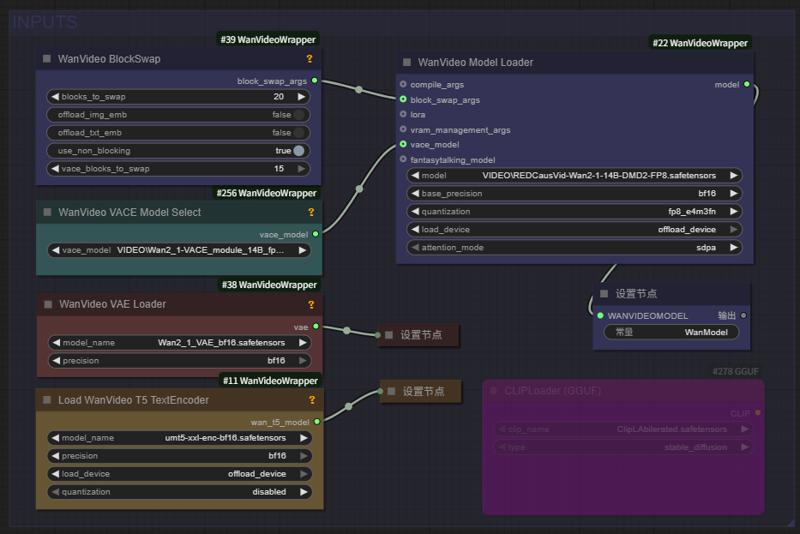

Aiwood WAN-ACE 완전 기능 워크플로우 전체 보기:

출처: https://www.bilibili.com/video/BV1FGE6zGEDK ⭐ 별 한 개 달아주세요 ⭐

CausVid 가속기 페이지 https://causvid.github.io/

CausVid 가속기 페이지 https://causvid.github.io/

WAN-VACE 모델의 파라미터 및 설정은 다음과 같습니다:

📌 Wan2.1-VACE는 참조-투-비디오 생성(R2V), 비디오-투-비디오 편집(V2V), 마스크된 비디오-투-비디오 편집(MV2V) 등 다양한 작업에 대한 솔루션을 제공하며, 창작자가 이러한 기능을 자유롭게 조합하여 복잡한 작업을 달성할 수 있습니다.

👉 다중 모달 입력으로 비디오 생성의 제어력을 강화합니다.

👉 작업 간 일관된 솔루션을 위한 통일된 단일 모델.

👉 자유로운 기능 조합으로 더 깊은 창의성을 해방합니다.

📌 Wan2.1-VACE는 참조-투-비디오 생성(R2V), 비디오-투-비디오 편집(V2V), 마스크된 비디오-투-비디오 편집(MV2V) 등 다양한 작업에 대한 솔루션을 제공하며, 창작자가 이러한 기능을 자유롭게 조합하여 복잡한 작업을 달성할 수 있습니다.

👉 다중 모달 입력으로 비디오 생성의 제어력을 강화합니다.

👉 작업 간 일관된 솔루션을 위한 통일된 단일 모델.

👉 자유로운 기능 조합으로 더 깊은 창의성을 해방합니다.

WAN실시간 생성이 도래했습니다! 하이브리드 AI 모델이 몇 초 만에 부드럽고 고품질의 비디오를 제작합니다

CausVid 생성형 AI 도구는 확산 모델을 사용하여 자회귀(프레임별) 시스템이 빠르게 안정적이고 고해상도 비디오를 생성하도록 가르칩니다.

Wan2.1 기반 하이브리드 AI 모델은 초당 9프레임으로 부드럽고 고품질의 비디오를 몇 초 안에 제작합니다.

CausVid 생성형 AI 도구는 확산 모델을 사용하여 자회귀(프레임별) 시스템이 빠르게 안정적이고 고해상도 비디오를 생성하도록 가르칩니다.

느린 양방향에서 빠른 자회귀 비디오 확산 모델로

CausVid https://causvid.github.io/

tianweiy (Tianwei Yin)

RedCaus/REDCausVid**-Wan2-1**-14B-DMD2-FP8 업로드 / WAN-VACE14B 최적의 적합성

CausVid**/autoregressive_checkpoint** 업로드 / 자회귀 모델은 WAN1.3B 기반 포함됨

CausVid**/bidirectional_checkpoint2** 업로드 / 양방향 추론 모델은 WAN1.3B 기반 포함됨

Kijai/Wan2_1-T2V-14B_CausVid_fp8_e4m3fn.safetensors / HF 저장소 WanVideo_comfy

⭐ 별 한 개 달아주세요 ⭐

Creative Commons Attribution Non Commercial 4.0 라이선스

이 친구의 추가 댓글에 감사드립니다. 어제 밤 너무 흥분해서 잠을 못 자고, 완료하지 못한 상태에서 업데이트를 멈췄습니다:

우리는 공식 Python 기반 추론 코드를 사용해야 합니다.

https://github.com/tianweiy/CausVid를 클론하고 요구사항 설치 지침을 따르세요

https://huggingface.co/Wan-AI/Wan2.1-T2V-1.3B를 wan_models/Wan2.1-T2V-1.3B에 클론하세요

pt 파일을 checkpoint_folder/model.pt에 넣으세요

추론 코드 실행: python minimal_inference/autoregressive_inference.py --config_path configs/wan_causal_dmd.yaml --checkpoint_folder XXX --output_folder XXX --prompt_file_path XXX

CausVid에 대한 Reddit 게시물: https://www.reddit.com/r/StableDiffusion/comments/1khjy4o/causvid_generate_videos_in_seconds_not_minutes/

https://www.reddit.com/r/StableDiffusion/comments/1k0gxer/causvid_from_slow_bidirectional_to_fast/

우리는 Wan1.3b 버전 기반의 CausVid를 테스트했으며, 놀라운 속도를 보였고, 현재 lightx2v가 생산한 14B 버전을 테스트 중입니다.

LightX2V: 가벼운 비디오 생성 추론 프레임워크

LightX2V: 가벼운 비디오 생성 추론 프레임워크

지원 모델 목록

실행 방법

lightx2v의 문서를 참조하세요.

⭐ 별 한 개 달아주세요 ⭐

통의 실험실 WAN 2.1 모델 저지

지능형 컴퓨팅 연구소는 다양한 분야의 대규모 모델 기술 개발 및 혁신적 응용에 집중하고 있습니다. 연구 방향은 자연어 처리, 다중 모달, 시각 AIGC, 음성 등 다방면을 포함합니다. 우리는 연구 성과의 산업 적용을 적극적으로 추진하고 있으며, 오픈소스 커뮤니티 구축에도 적극 참여하여 AI 모델의 오픈 및 공유를 함께 탐색합니다.

개발자 / 모델 이름 / Kijai`s ComfyUI 모델

RedCaus/REDCausVid**-Wan2-1**-14B-DMD2-FP8 업로드 / WAN-VACE14B 최적의 적합성

CausVid**/autoregressive_checkpoint** 포함 / 자회귀 모델은 WAN1.3B 기반 포함됨

CausVid**/bidirectional_checkpoint2** 포함 / 양방향 추론 모델은 WAN1.3B 기반 포함됨

CausVid**/wan_causal_ode_checkpoint_model** 테스트 중 / 자회귀 인과 추론 테스트 중

CausVid**/wan_i2v_causal_ode_checkpoint_model** 테스트 중 / 이미지-투-비디오 모델 테스트 중

lightx2v**/Wan2.1-T2V-14B-CausVid** 부적합 / 자회귀 모델 14B AiWood 테스트 결과 부적합

lightx2v**/Wan2.1-T2V-14B-CausVid quant** 부적합 / 자회귀 모델 14B 양자화 버전 테스트 결과 부적합

Wan 팀**/1.3B 텍스트-투-비디오** 포함 / 텍스트-투-비디오 1.3B 포함됨

Wan 팀**/14B 텍스트-투-비디오** 포함 / 텍스트-투-비디오 14B 포함됨

Wan 팀**/14B 이미지-투-비디오 480P** 포함 / 이미지-투-비디오 14B 포함됨

Wan 팀**/14B 이미지-투-비디오 720P** 포함 / 이미지-투-비디오 14B 포함됨

Wan 팀**/14B 초-말 프레임-투-비디오 720P** 포함 / 비디오 초-말 프레임 포함됨

Wan 팀**/Wan2_1_VAE** 포함 / KiJai의 WAN비디오 VAE 포함됨

ComfyORG**/Wan2.1_VAE** 포함 / Comfy의 WAN비디오 VAE 포함됨

google/umt5-xxl umt5-xxl-enc safetensors 포함 / TE 인코더 포함됨

mlf/open-clip-xlm-roberta-large-vit-huge-14 safetensors 포함 / CLIP 인코더 포함됨

DiffSynth-Studio 팀/1.3B 미적 LoRA 미적 디스틸레이션-통의만상2.1-1.3B-LoRA-v1

DiffSynth-Studio 팀/1.3B 고해상도 수정 LoRA 고해상도 복원-통의만상2.1-1.3B-LoRA-v1

DiffSynth-Studio 팀/1.3B 영상 길이 확장 LoRA 길이 확장-통의만상2.1-1.3B-LoRA-v1

DiffSynth-Studio 팀/1.3B 속도 제어 어댑터 속도 제어-통의만상2.1-1.3B-어댑터-v1

PAI 팀/ WAN2.1 Fun 1.3B InP 초-말 프레임 지원 / Kijai/WanVideo_comfy

PAI 팀/ WAN2.1 Fun 14B InP 초-말 프레임 지원 / Kijai/WanVideo_comfy

PAI 팀/ WAN2.1 Fun 1.3B Control 컨트롤러 / Kijai/WanVideo_comfy

PAI 팀/ WAN2.1 Fun 14B Control 컨트롤러 / Kijai/WanVideo_comfy

PAI 팀/ WAN2.1 Fun 14B Control 컨트롤러 / Kijai/WanVideo_comfy

PAI 팀/ WAN2.1-Fun-V1_1-14B-Control-Camera / Kijai/WanVideo_comfy

IIC 팀/ VACE-통의만상2.1-1.3B-Preview / Kijai/WanVideo_comfy

IC (문맥 내) 컨트롤러 다중 모달 컨트롤러:

ali-vilab/ VACE: All-in-One Video Creation and Editing / Kijai/WanVideo_comfy

Phantom-video/Phantom 교차 모달 정렬을 통한 주체 일관성

KwaiVGI/ ReCamMaster 카메라 제어 다각도 렌즈 / Kijai/WanVideo_comfy

Wan2.1을 통한 디지털 캐릭터 :

ali-vilab/ UniAnimate-DiT 장시퀀스 골격 캐릭터 비디오 / Kijai/WanVideo_comfy

Fantasy-AMAP/ 오디오 기반 디지털 캐릭터 Fantasy토킹 / Kijai/WanVideo_comfy

Fantasy-AMAP/ 캐릭터 일관성 및 신원 보존 FantasyID / Fantasy-AMAP/fantasy-id

무제한 NSFW 해제 버전:

REDCraft AIGC / WAN2.1 720P NSFW 해제 / 개인용 전용【비공개】

CubeyAI / WAN 일반 NSFW 모델 (수정됨) / 최고의 범용 LoRA

昆仑万维 발표 _SkyReels, 기반: Wan2.1

Skywork / SkyReels-V2-I2V-14B-720P / 이미지에서 비디오로 / Kijai/WanVideo_comfy

Skywork / SkyReels-V2-I2V-14B-540P / 이미지에서 비디오로 / Kijai/WanVideo_comfy

Skywork / SkyReels-V2-T2V-14B-540P / 텍스트에서 비디오로 / Kijai/WanVideo_comfy

Skywork / SkyReels-V2-T2V-14B-720P / 텍스트에서 비디오로 / Kijai/WanVideo_comfy

Skywork / SkyReels-V2-I2V-1.3B-540P / 이미지에서 비디오로 / Kijai/WanVideo_comfy

자동 재귀적 Diffusion-Forcing 무한 길이 생성 아키텍처

Skywork / SkyReels-V2-DF-14B-720P / 텍스트에서 비디오로 / Kijai/WanVideo_comfy

Skywork / SkyReels-V2-DF-14B-540P / 텍스트에서 비디오로 / Kijai/WanVideo_comfy

Skywork / SkyReels-V2-DF-1.3B-540P / 텍스트에서 비디오로 / Kijai/WanVideo_comfy

昆仑万维 발표 SkyReels 비디오 캡션 모델:

Skywork / SkyCaptioner-V1 Skywork (Skywork) / Skywork/SkyCaptioner-V1

작은 AutoEncoder / taew2_1 safetensors / Kijai/WanVideo_comfy

이미지를 잠재 공간으로 인코딩하고, 잠재 표현을 이미지로 디코딩하기 위한 작은 디스틸린 VAE 모델

WAN Comfy-Org/Wan_2.1_ComfyUI_repackaged

【예시 페이지의 파란색 Nodes 또는 webp 파일 다운로드 - 비디오 워크플로 재현 가능】

Gallery 샘플 이미지/비디오 (WEBP 형식), ComfyUI 네이티브 워크플로 포함

이것은 간결하고 명확한 GGUF 모델 로딩 및 타일링 샘플링 워크플로입니다:

Wan 2.1 Low vram Comfy UI Workflow (GGUF) 4gb Vram - v1.1 | Wan Video Workflows | Civitai

노드: (또는 comfyui manager로 사용자 정의 노드 설치)

https://github.com/city96/ComfyUI-GGUF

https://github.com/kijai/ComfyUI-WanVideoWrapper

https://github.com/BlenderNeko/ComfyUI_TiledKSampler

* 최신 버전의 comfyui-KJNodes 업데이트 필수 GitHub - kijai/ComfyUI-KJNodes: Various custom nodes for ComfyUI ComfyUI KJNodes를 최신 버전으로 업데이트

Kijai ComfyUI wrapper 노드 for WanVideo

진행 중

@kijaidesign의 작업

Huggingface - Kijai/WanVideo_comfy

GitHub - kijai/ComfyUI-WanVideoWrapper

주요 영상은 AiWood에서 가져왔습니다.

https://www.bilibili.com/video/BV1TKP3eVEue

Text encoders를 ComfyUI/models/text_encoders에 저장

Transformer를 ComfyUI/models/diffusion_models에 저장

Vae를 ComfyUI/models/vae에 저장

현재 I2V 모델만 성공적으로 실행되었습니다.

프레임 수 81 이하에서는 작동하지 않습니다. 이는 512x512x81입니다.

약 16GB 사용, 20/40 블록 오프로드됨

DiffSynth-Studio 추론 GUI

Wan-Video LoRA 및 학습 세부 조정

DiffSynth-Studio/examples/wanvideo at main · modelscope/DiffSynth-Studio · GitHub

💜 Wan | 🖥️ GitHub | 🤗 Hugging Face | 🤖 ModelScope | 📑 논문 (곧 출시) | 📑 블로그 | 💬 웨이신 그룹 | 📖 Discord

Wan: Open and Advanced Large-Scale Video Generative Models

통의만상 Wan2.1 비디오 모델 오픈소스! 비디오 생성 모델의 새 기준, 중국어 텍스트 지원 + 고품질 비디오 생성

이 저장소에서는 Wan2.1을 발표합니다. 이는 비디오 생성의 경계를 확장하는 포괄적이고 오픈된 비디오 기반 모델 스위트입니다. Wan2.1은 다음 주요 기능을 제공합니다:

👍 최고 성능: Wan2.1은 여러 벤치마크에서 기존 오픈소스 모델 및 최신 상용 솔루션을 일관되게 능가합니다.

👍 소비자용 GPU 지원: T2V-1.3B 모델은 단지 8.19GB VRAM만 필요하며, 거의 모든 소비자용 GPU와 호환됩니다. RTX 4090에서 최적화 기술(양자화 등) 없이 약 4분 만에 5초 분량의 480P 비디오를 생성할 수 있습니다. 일부 폐쇄형 모델과도 성능이 비교됩니다.

👍 다양한 작업: Wan2.1은 텍스트에서 비디오로, 이미지에서 비디오로, 비디오 편집, 텍스트에서 이미지로, 비디오에서 오디오로의 작업에서 뛰어난 성능을 보이며 비디오 생성 분야를 선도합니다.

👍 시각적 텍스트 생성: Wan2.1은 중국어 및 영어 텍스트를 모두 생성할 수 있는 최초의 비디오 모델로, 강력한 텍스트 생성 기능을 제공하여 실제 응용성을 향상시킵니다.

👍 강력한 비디오 VAE: Wan-VAE는 뛰어난 효율성과 성능을 제공하여 길이에 상관없이 1080P 비디오를 인코딩/디코딩하며 시간적 정보를 보존합니다. 이는 비디오 및 이미지 생성에 이상적인 기반을 제공합니다.

이 저장소에는 우리 T2V-14B 모델이 포함되어 있으며, 오픈소스 및 폐쇄형 모델 모두에서 새로운 SOTA 성능 기준을 수립했습니다. 이 모델은 뛰어난 시각적 품질과 큰 움직임 역동성을 생성할 수 있으며, 중국어 및 영어 텍스트를 모두 생성할 수 있는 유일한 비디오 모델이며, 480P 및 720P 해상도의 비디오 생성을 지원합니다.