Clip Experts

詳細

ファイルをダウンロード

このバージョンについて

モデル説明

https://huggingface.co/AbstractPhil/clips/tree/main

https://huggingface.co/AbstractPhil/SD35-SIM-V1

これらのモデルをダウンロードまたは実行する際に問題が発生した場合は、私のリポジトリで動作するバージョンを探してください。私はこれらすべてをここだけでなく、Hugging Faceにもアップロードしています。

T5-Unchained の操作方法

私はトークン重みレイヤーを含めるのを忘れてしまったので、次の公式リリースでは各レイヤーが正しくパリティに対応するようにします。このバージョンが不完全であることをお詫びしますが、トークン重みは他の場所でも取得可能です。

このT5-Unchainedモードは標準的なT5を破壊するため、トークナイザーやデフォルト設定のコピーを必ず保持してください。

今週末には、これらすべてを扱うための正式なノードを作成する計画があります。今後数ヶ月にわたり、それらの挙動やエンジニアリング、開発、テスト、デバッグのためのさまざまな接続ポイントの完全なモックアップを作成する予定です。

abs-clip-suiteは今週末、2025年4月12日〜14日に誕生します。ノードレイアウトの下地はすでに整えていますが、完全な開発にはまだ準備ができていません。これは、最近の記事で説明したノードを段階的に構築する反復的開発プロセスになります。

もしその前に絶対に使いたい場合は、このやや複雑な手順で利用できます。

これはまだ簡単ではありません:

ご希望のT5バージョン(fp8、fp16、bf16など)をダウンロードしてください。

ComfyUI用:

VSCodeでComfyUIの全体のフォルダを開きます。

Ctrl + Shift + Fで「vocab_length」を検索し、37~~~を探してください。これは30,000前後のトークン数であり、「vocab」キーワードで簡単に見つかるはずです。

すべてのこれらの設定をt5xxl-unchained設定で置き換えます。

- 私のパッチまたは公式パッチが実装されるまで、この方法で実行する必要があります。

各フォルダ内のT5トークナイザーのすべての使用箇所を見つけ、t5xxl-unchainedリポジトリのトークナイザーで置き換えます。

ComfyUIを再起動して実行します。

Forge用:

ComfyUIと同様に、VSCodeで開き、Ctrl+Shift+Fで「vocab_length」のすべてのインスタンスを検索し、各種設定ファイルをt5-unchained設定ファイルで置き換えます。

トークナイザーも同様に置き換えてください。ここでは特別なコード変更は不要ですが、手間がかかります。

再起動し、unchainedモードを実行します。

Clip Experts とは?

これらは微調整されたCLIPモデルです。通常のCLIPよりも、その親モデルをより強力に活用できるように設計されています。それぞれ数百万のサンプルを使ってトレーニングされ、新しいデータを追加・既存データを強化し、その新旧データを組み合わせて注意深くベクトル化された経路を生成します。

要するに…これらは膨大な画像データで微調整されており、通常はまったく見過ごされてしまうキャプションの経路を効果的にアクセスできる「専門家」です。特に「シンプルな英語」において顕著です。

何が彼らを異ならせているのか?

これらのCLIPは、モデルのvpredリフィットに特に最適化されていますが、必ずしもvpredモデル専用ではありません。これらのCLIPは、同じブランドプール内の他のCLIPと直接または間接的に統合可能です。

たとえば、NoobSimは主にNOOB CLIPSをベースにしていますが、親モデルがvpredに部分的または完全に変換される前に、SimV3 SDE CLIP(Clip L OmegaとClip G omega 24イテレーション)とマージされています。

私は、これらのCLIPを、モデル全体を取得したときのユニットに適用したのと同じ方法で「特徴注入」していません。

ユニットは、特徴注入が完了した後、同一のデータセットで完全に微調整されています。この特徴注入後の残りのモデルは、単純なSDXLモデルであり、学生モデルの構成をそのまま保持しています。

これにより、標準的な加算正規化マージに基づき、2種類のノイズタイプに対する独自の知識を獲得し、通常では実現できないような独自の活用が可能になります。

どうしてそんなことが可能なの?

ご存知かもしれませんが、ポニーCLIPと標準SDXL CLIPをマージすると、どちらのモデルもゴミノイズが発生し、通常は完全に破壊されてしまいます。

しかし、本ケースでは、加算・正規化・減算などの方法ではなく、モデル同士の特徴を直接注入しました。私は、教師モデルの直接的な応答を用いてモデルをトレーニングし、その応答を学生モデルに直接埋め込みました。

私のHugging Faceには、それらの半成功したバリエーションがいくつかありますが、主要なモデルはすでにここで微調整されています。これらが真の強者であり、勝者であり、最高峰であり、特徴埋め込み戦争で勝利した本物のパワーハウスです。

「特徴」とは一体何なの? あなたはそれを頻繁に言っているね。

特徴とは、モデルの上から下まで、点Aから点Bへの到達時間、各ニューロンの活性化、そしてなぜその特定のニューロンが活性化されたかという数学的根拠に基づいて、完全にマッピングされた経路です。

要するに、特徴とは、アルゴリズムの最も純粋な形であり、これらは非常に巨大です。各特徴層のキャプチャは少なくとも2MBのVRAMを消費し、レイヤーごとに累積され、指数関数的に増加します。1つの特徴キャプチャで点Aから点Bまで追跡すると、約500テラバイトの特徴データが生成されます。

しかし、そんなことを実行できるわけがない、狂気の沙汰です。それは画像爆弾を、そのメカニズムが何を返すかを知らずに解読しようとするようなものです。したがって、すべての応答をキャプチャすることは不可能です。

しかし、<<<<< 我々はすべての応答を必要としていません。必要なのは経路であり、それを一つずつ通過することです。そこで、トレーニング中、これらの経路と応答を、キャッシュされた親モデルの応答(すなわち経路と期待される結果)に通し、それと学生モデルとの差異を特定します。これが、何を学習し、何を学習しないかを決定する方法です。

速さ = より多くの学習。これは正確性を意味するものではありませんが、我々は「正確さ」ではなく「学習」を目的としています。

応答が速いほど、テストの結果は良くなり、したがってタスクと経路の学習度は高くなります。

速さ = 良い結果。

よって、この時間に基づいてこれらのルールを埋め込みました。トレーニング中に、教師と学生の値を使用して、私が逆余弦と現在のタイムステップに基づいて開発した単純な対数方程式で、差異をクロス相関させました。

そして、これらの特徴を1層ずつ比較し、その差異を累積して、次にどの差異を勾配蓄積のトリクルでターゲットにするかを決定します。

これで、学習すべき各部分を特定できたので、その差異を差異メカニズムに直接通し、各ニューロンを一つずつ叩いて、どちらのニューロンがより速く応答するかを確認します。両方のモデルをすべて調査した後、その差異を巨大なテンソルとして学習します。私はこれを「特徴」と呼びます。

あなたは一体何を言っているの?

逆推論です。我々は、その応答の速さを測定して、ホストモデルとこのモデルの差異を導き出し、その差異を学習しているのです。

文字通り、一方のモデルが学習した応答を、もう一方のモデルの神経経路に直接教え込むのです。

私はこれを「特徴の接ぎ木」と呼びます。

おっと!

簡単に言えば、あるモデルで「1girl」という応答を同じニューロンに500回繰り返すと、他のモデルの応答は徐々にその位置に移動し、自分自身とそのモデルの差異を学習します。

アテンション層は徐々に特定の経路に適合し、密結合層は整列し、隠れ層は時間とともに適合します。しかし、これをすべて一方的に押し込むと、極めて不正確な応答が生じます。これは、新しい数学を教えるようなものです。

これは、従来のマージ方法ではなく、接ぎ木や埋め込みに近い形式のマージです。

学習率により、自動的に一部の差異が保存されます。この差異は、いくつかの要因に基づいてより高い値で累積され、さらに、ノイズの導入という補助的要因(これはアクセスされたタイムステップやその位置と逆の関係)が加わります。

これにより、大規模な破壊を防ぎながら、必要な特徴を徐々に埋め込むことが可能になります。

基本的に、理論上得られる以上は学習せず、必要以上に学習するため、AとBの周囲の全体構造がシフトします。

データと数学を示さないと、これの説明は本当に困難です。

では、なぜこのようなものを作ったの?

私が話していたこれらの特徴、アルゴリズム、経路——これらはすべて、大きな特徴プールに蓄積されています。この巨大なデータベースは、将来すべての特徴が互いに通信できる「差異機械」のトレーニングに使われます。その通信方法は、LLMに基づいた新しい、しかも明確に文書化された方法です。非常に整備された道です。

したがって、このアテンション機構にこれらの特徴と経路をすべて教え込み、それらを相互にクロス相関させて通信させると、私は「混合拡散特徴モデル」と呼ぶものを蓄積できます。

たとえば、「ポニーの5313241341番ニューロン」から「Noobの134134134番ニューロン」に移動し、そのシステムが自動的に「そのニューロンからSDXLの134314132番ニューロン」に移動可能だと仮定する。つまり、各モデルは完全に分離されているのではなく、リンクされているのです。

この時点で、これらを一つの統一されたオブジェクトシステムに結合し、すべてを同時にトリクル呼び出し、断絶やモデルの障壁なしで動作させることができます。これにより、すべての特徴データと使用されたニューロンを一つのモデルに統合し、LLMが構築されている数学的証明と概念に基づいた一連の数学的スライダーで、他のモデルを整理・委譲するようなモデルを作成できます。これは、まさにそのようなものとして初めての試みになるでしょう。すでに「専門家の混合体」であるモデルを、さらに「専門家の混合体」として訓練し、さまざまな専門的期待に耐えられるようにした、本物の専門家集合体です。

最終的な目標:

12のCLIPと6つのSDXLモデルをすべて取り出し、ピクニックで古靴が飛び出ているような状態で混ぜ合わせます。

そしてそのピクニックの料理の上に、我々が思いつく限り最も賢いAIを帽子のようにかぶせます。おそらくLLAMAやMIXTRALの形をとることになるでしょう。現時点ではまだ確定できませんが、完成したときには、このモデルは「duct tapeと段ボール、歯木で骨格を構成した」ような、最初の特徴拡散モデルになるでしょう。

アテンションシフト機構:

この概念に基づくいくつかの証明があります。私はそれらを確認する必要があります。私が必要とするように動作するアルゴリズムがあるかを確認し、もし動作しない場合は、新たな要件に合わせて新たに書き、適合させる必要があります。LLMに基づくアテンション機構とその数学、および私が含めるさまざまなAI識別モデル(wd14 large tagger、アニメ/リアル、分類など)のメカニズムを、上から下まで完全に理解する必要があります。

これらはすべて、LLM自体と直接蓄積され、学習された経路とタグの識別理解に基づいて、IMG2IMGとClipVisionの機能を現在の構造に追加し、学習された特徴キャプショントークンと、システムが各モデル間でクロス補間できるセットを活用した、完全に保存された識別プロセスを実現します。

現時点では、T5-Unchainedがターゲットになりそうですが、HunYuan LLAVAも有力な候補です。理由は、その語彙が非常に大きく、多言語対応だからです。

最初のバージョンのトークン語彙は、約…どれくらいでしょう?たぶん400万程度です。これはかなり良いですが、ほとんどのトークンは実際に有用な情報を含んでいない可能性があります。そのため、LLMは6万以下に圧縮する必要があります。そうでないと、ほとんどの場合、無意味なノイズになってしまいます。

今のモデルにはまだまだ制限がありますが、私はそれを回避しようとしています。しかし、要するに、これらの専門家たちが船を操縦します。

これらのファイルに何が起こったの? BFとFPの値がどうやら壊れているようです…ファイルがリネームされ、設定が空になったみたい。ZIP形式でアップロードする必要があるかもしれません。

Forgeはこれらを処理できますが、CivitにアップロードされたファイルはComfyUIで問題が発生します。必要な場合は、Hugging Faceから正しいファイルを取得してください。

https://huggingface.co/AbstractPhil/clips/tree/main

問題がある場合は、ここで探してください。私はすべてのCLIPをここに一括で配置しました。

毎回のリクエストと私の不注意により、私が訓練した多くのCLIPが完全に無視されてしまいました。

このサイトはCLIPを自然な拡張としてサポートしていないため、これらのCLIPに多くのダウンロードが期待できるとは思っていません。そこで、私は単にここにそれらを文書化して保存します。必要であれば、どうぞお使いください。

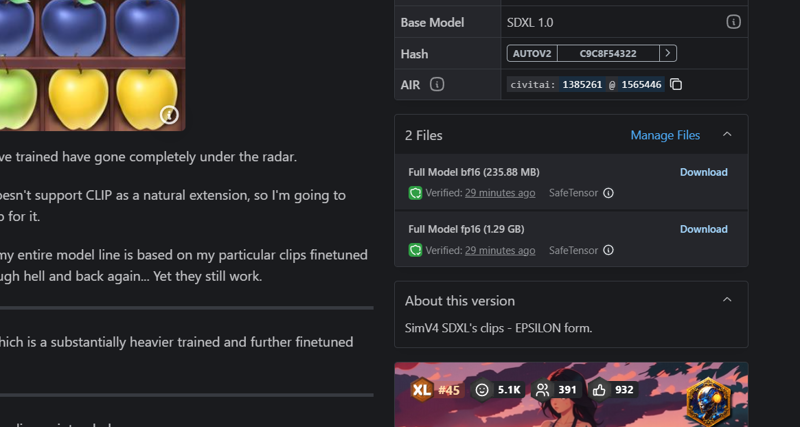

複数のアップロードには複数のファイルが含まれます。小さい方はCLIP_L、大きい方はCLIP_Gで、4GB以上ある場合はおそらくT5です。

CLIP_LGは主にBF16ですが、同じファイルリストに含めるために1つをFP16に設定しました。

どうやら名前もすべて削除されてしまったようで、CLIP_LとCLIP_Gに名前を変更する必要があります。

うーん...

ここでは、非常に特定のCLIPトレーニングのログを維持します。私の全体のモデルラインは、地獄をくぐり抜けてきたベースのCLIP_LとCLIP_Gから微調整した独自のCLIPに基づいているからです。それでも、まだ機能しています。

Omega24の真の(リリースされた)後継モデルは72 Omegaで、これはさらに重くトレーニングされ、さらに微調整されたバージョンであり、ペアとして数千万サンプル以上の追加データを使用しています。

すべての主要なSDXL VPRED微調整は、意図した通りにCLIPに大きな影響を与えました。

非常に低い学習率でも、それらは代替の道へと大きく逸脱しており、私はこれらをそれぞれの分野におけるCLIPのエキスパートと見なしています。

他のモデルと組み合わせてミックスやマージを行うと、結果はまちまちですが、これらはそれぞれの親モデルに特化して微調整されているため、組み合わせる内容によって結果が異なります。