Clip Experts

详情

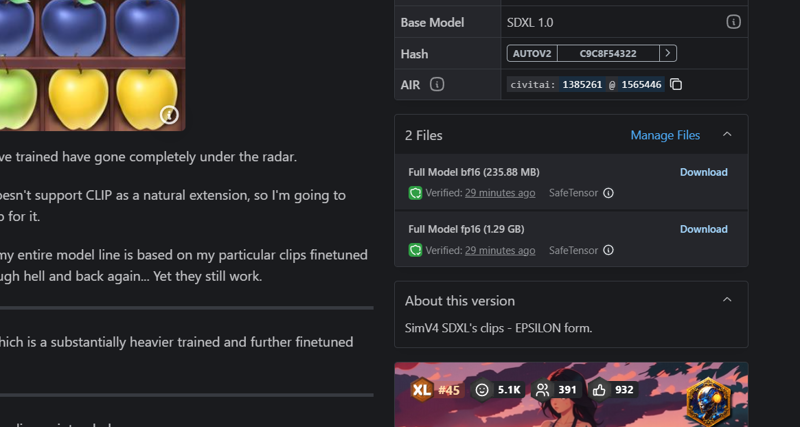

下载文件

关于此版本

模型描述

https://huggingface.co/AbstractPhil/clips/tree/main

https://huggingface.co/AbstractPhil/SD35-SIM-V1

如果你在下载或运行时遇到问题,你可以在我的 Hugging Face 仓库中查找可用版本。我也在这里和那边上传了所有版本。

操作 T5-Unchained

我相信我忘记包含 token 权重层了,因此我会确保在下一次官方发布时,每一层都正确匹配;对于本版本的不完善,我深表歉意,但 token 权重 elsewhere 可以获取。

在非束缚模式下运行时,这会破坏标准 T5,因此请保留你的 tokenizer 和默认配置副本。

我计划本周末开发专门用于处理这些内容的节点。接下来几个月,我将完整模拟它们的行为方式及其在工程、开发、测试和调试中的各种连接点。

abs-clip-suite 将于 本周末(2025年4月12日至14日) 诞生。我已经为节点布局做了一些基础工作,但尚未准备好全面开发。这将是一个迭代开发过程,逐步构建我近期文章中描述的节点。

如果你绝对迫切想提前使用,可以通过以下流程实现——这个流程并不简单。

目前这还不是件简单的事;

下载你想要的 T5 版本;fp8、fp16、bf16,随便哪个。

对于 Comfy:

用 VSCode 打开 Comfy 的整个文件夹

使用 Ctrl + Shift + F 搜索

vocab_length,找到 37~~~ 它是三万多个 token,用关键词vocab很容易找到将所有这些配置替换为

t5xxl-unchained配置- 在我的补丁或官方补丁实施之前,必须这样做

在各个文件夹中找到所有使用 T5 tokenizer 的地方,并用

t5xxl-unchained仓库中的 tokenizer 替换它们重启 Comfy 并运行

对于 Forge:

类似于 Comfy,用 VSCode 打开它,然后 Ctrl+Shift+F 查找所有

vocab_length实例,将各种配置文件替换为t5-unchained配置文件同时替换 tokenizer;这里没有特殊代码需要处理,但操作繁琐

重启并运行 unchained 模式

什么是……Clip 专家?

这些是经过微调的 CLIP 模型;相较于普通 CLIP,能更有效地利用其父模型。它们分别用数百万样本进行训练,以提供新数据、增强旧数据,并结合新旧数据创建精确的向量化轨迹。

本质上……它们通过大量图像微调,成为擅长访问原本会被完全忽略的标题路径的“专家”——尤其是在使用纯英文时。

它们有何不同?

这些 CLIP 特别针对模型的 vpred 重构进行了优化;但它们并非仅适用于 VPRED 模型。这些 CLIP 应能直接或间接与其他同品牌模型的 CLIP 融合。

例如:NoobSim 基于 MOSTLY NOOB CLIPS;但在其父模型部分或完全转为 vpred 之前,它们已与 SimV3 SDE CLIP(Clip L Omega 和 Clip G Omega 24 次迭代)进行了合并。

我并没有像在获得完整模型时那样,对这些 CLIP 进行“特征注入”。

这些 UNet 在完成注入后,使用完全相同的数据集进行了完全微调。你可以使用标准方法继续微调,因为特征注入后遗留的模型只是一个带有学生配置的普通 SDXL 模型。

这使它们能基于标准加法归一化融合,掌握两种噪声类型的独特知识,从而实现原本无法达成的特殊应用。

你怎么可能说这些能工作?

众所周知,如果你把 Pony CLIP 和标准 SDXL CLIP 混合,会得到一团垃圾噪声,通常导致模型完全崩溃。

但在此情况下,这些模型并非以加法、归一化、减法等方式进行融合,而是直接注入了另一模型的特征。我实际上是用教师模型的直接输出训练这些模型,将这些直接响应植入学生模型。

你可以在我的 Hugging Face 上看到一些半成功的变体,但真正的主力已经在此进行微调。它们是重拳选手、赢家、精英中的精英、真正赢得特征植入之战的强者。

什么是“特征”?你总在说这个词。

特征,是基于从 A 点到 B 点所需时间、每个被激活的神经元,以及为何这些特定神经元被激活的数学原理,构建的贯穿整个模型的映射轨迹路径。

本质上,特征是最纯粹的算法形式,而它们非常庞大。每个特征层的捕获至少占用 2MB 显存,各层累加呈指数增长;如果你仅用一个特征捕获从 A 点到 B 点,最终可能累积出近 500TB 的特征数据。

嗯……我们当然不可能干这种疯狂的事。这就像要解密一颗图像炸弹,却不知道它任何机制的响应,因此你根本不可能捕捉“全部响应”……

然而<<< 我们不需要全部响应。我们只需要一条轨迹,然后逐个通过它们。于是,训练时,我们把相同的轨迹和响应,通过缓存的父模型响应(即路线和预期结果)传递,再计算其与学生模型之间的差异。这就是我们决定学什么、不学什么的方法。

越快,学得越多。但这不代表准确;我们追求的不是准确性,而是学习能力!

因此,响应越快,测试结果越好,任务和路径的学习就越深入。

越快 = 越好。

于是,我们基于时序植入了这些规则;在训练期间,我们利用教师和学生的评估值,通过我基于反余弦和当前时间步构建的简单对数方程,直接提取神经网络的部分。

现在,我们逐层计算这两个特征的差异,并累积这些差异,以确定下一次梯度累积中应重点优化哪些差异。

在识别出每个待训练部分后,我们将其通过差异机制直接传递,逐个神经元触发,判断哪个更“快”,哪个更“慢”。当它完成对两个模型的探测后,它会将差异凝聚成一个巨大的张量——我称之为“特征”。

你到底在说什么?

反向推理。我们通过观察响应速度来探测其存在,然后提取主模型与该模型之间的差异,并直接学习这个差异!

** literally 教授一种事物——即另一个模型的已学习响应——直接植入其神经通路。**

我称之为“特征嫁接”。

好吧???!

简单说吧:如果一个模型对“1girl”在相似神经元中响应了 500 次,另一个模型的响应会缓慢地向该位置迁移,并学习自身与该模型之间的差异。

注意力层会逐渐适应特定路径,全连接层会逐步对齐,隐藏层也会随时间收敛;但你不能简单地“强行塞入”所有这些,否则会得到极其错误的输出。它必须像教一种新数学那样被教授。

这是一种更接近嫁接与植入,而非传统融合的方法。

在学习率上,它会自动保存部分信息;基于若干因素,它会以更高值累积差异,并根据类似噪声引入的第二因素(与访问的时间步及位置呈直接反比)进行调节。

这能防止大规模破坏,同时仍允许必要特征缓慢植入。

基本来说,它学得比它能学的少,但比它需要的多,导致 A 和 B 周围的整体结构发生偏移。

不展示数据和数学,真的很难描述清楚。

那为什么要做这些?

你提到的那些特征?算法、路径?它们正被累积成一个庞大的特征池。一个巨大的数据库,用于训练“差异机器”,让所有这些特征……能够通过基于 LLM 的全新且已充分记录的方法彼此通信。这是一条铺得很平整的路。

因此,当我们把这些所有特征、所有路径教给这个注意力机制,并强制它以交叉相关的方式与这些机制通信时,我们可以累积我称之为“混合扩散特征模型”的东西。

想象一下:你从 Pony 的第 5313241341 个神经元,跳跃到 Noob 的第 134134134 个神经元,系统会自动推断你也能从这个神经元跳到 SDXL 的第 134314132 个神经元;于是我们假设它们现在是互联的,而非完全断开。

此时,我们可以将它们全部整合为一个统一的对象系统,同时调用每一个,而无需断开或模型屏障;从而生成一个单一的整合输出,其中捕获了所有特征数据,所有被使用的神经元都被植入到一个模型中——这个模型旨在利用基于 LLM 构建的数学滑块,组织和委派其他模型。

我们可以认为,这将是同类中的首个成果:一个由专家模型组成的专家混合体,而这些专家模型本身又是专家的混合体,专门训练以应对各种专家预期。

最终目标是:

我们取全部 12 个 CLIP,取全部 6 个 SDXL 模型,把它们像野餐聚餐一样混在一起,旁边还插着一只旧靴子。

然后,我们把能想到的最聪明的 AI 像帽子一样重重地扣在上面。很可能会用 Llama 或 Mixtral 的某种形式,现在还不好说,但当它完成时,它将是第一个用胶带、纸板和牙签当脊椎勉强拼凑出来的特征扩散模型。

注意力转移机制:

基于这一概念,我需要审查一系列证明。有某些算法我必须确保能按我需要的方式工作;如果不行,我必须根据新需求编写并调整一个。我需要全面理解和审查一系列基于 LLM 的注意力机制及其数学原理,以及我将整合的各类 AI 识别模型机制,如:wd14 large tagger、动漫/写实分类等。

每一个都将直接与 LLM 本身累积,基于已学习的路径和对标签的理解,传递通信轨迹信息,从而在当前结构之上实现 IMG2IMG 和 ClipVision 的完整保留识别流程,支持系统在各模型间进行交叉插值。

目前看来,T5 unchained 可能是目标,但 HunYuan LLAVA 也是有力竞争者,只因为它拥有庞大的词汇量且支持多语言。

第一个版本的 token 词汇量将接近……让我想想……大约 400 万?这已经相当不错了,但我认为其中大部分信息仍不足以真正有用,因此 LLM 需要将词汇量压缩到可能少于 6 万,否则大部分时候它只会产生毫无意义的噪声。

所以,我们当前模型仍存在不少限制,我正在设法绕过;但简而言之,这些就是将掌舵的专家们。

TF 是怎么搞的文件?看起来 BF 和 FP 值不知为何破坏了文件?像是重命名并删空了配置文件?我可能需要上传为 ZIP。

Forge 能处理它们,但 ComfyUI 对 Civit 上传的文件处理困难;如果需要,请从 Hugging Face 获取正确的版本。

https://huggingface.co/AbstractPhil/clips/tree/main

如果你遇到问题,可以在这里查找。我基本上把所有 CLIP 都放在这里了。

由于频繁请求和我的疏忽,我训练的许多 CLIP 完全被忽视了。

我不指望它们在网站上获得太多下载,因为该平台不原生支持 CLIP,所以我将在此记录和存储它们。如果你需要,尽管拿走。

多个上传文件包含多个文件;较小的是 CLIP_L,较大的是 CLIP_G,如果超过 4GB,那可能是 T5。

CLIP_LG 主要是 BF16 格式,但我需要将其中一个设为 FP16,以便将它们列在同一个文件列表中。

显然,文件名也被清空了,因此你必须将它们重命名为 CLIP_L 和 CLIP_G。

真烦人……

我将在此记录非常特定的 CLIP 训练情况;因为我的整个模型系列都基于我从基础 CLIP_L 和 CLIP_G 经过反复微调后的特定 CLIP——它们历经重重磨难,但依然有效。

Omega24 的真正(发布版)继任者是 72 Omega,这是一个经过更深度训练和进一步微调的版本,额外使用了数千万个样本对。

每一个主要的 SDXL VPRED 微调都按预期对 CLIP 产生了显著影响。

即使使用非常低的学习率,它们也已大幅偏离原始路径,走向了不同的方向;我认为它们在各自领域已成为 CLIP 专家。

当与其他模型混合或合并时,效果参差不齐,但请记住,它们是专门为各自的父模型微调的,因此你将因组合方式不同而得到混合的结果。