T5xxl-Unchained Lora + Workflow

세부 정보

파일 다운로드

이 버전에 대해

모델 설명

Flux 수정 업데이트 - 2025년 7월 2일 저녁:

t5xxl에 대한 Flux 로더에 버그가 있었기 때문에 수정하여 오늘 저녁 릴리즈에 적용했습니다.

SD3 및 SD35에도 비슷한 조치가 필요할 것으로 보입니다.

워크플로우 릴리즈 - 2025년 7월 2일 아침:

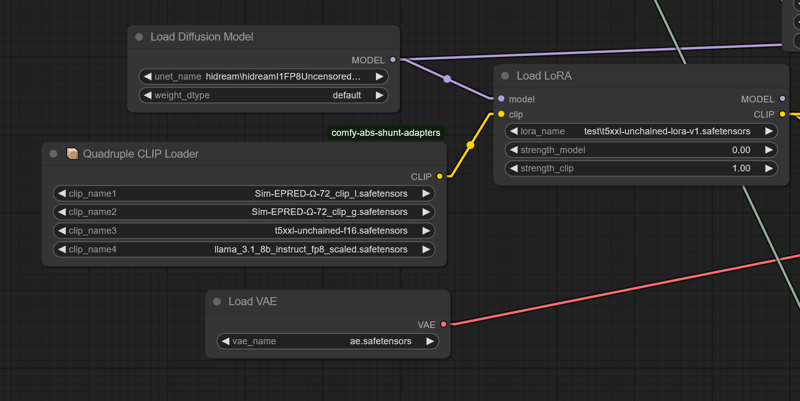

현재 워크플로우는 comfy-clip-shunts 노드 애드온을 필요로 합니다. shunts를 반드시 사용할 필요는 없지만, t5-unchained를 지원하는 clip 로더가 함께 제공됩니다.

이 로더는 원래 sd 함수 호출을 직접 활용 연결 함수 호출로 대체하기 때문에 작동합니다.

shunts를 사용할 경우 beatrix 대신 표준 bert uncased 또는 bert cased를 사용할 수 있지만, 결과의 정확도는 떨어집니다.

Unchained와 함께 사용하는 Shunt 코드:

https://github.com/AbstractEyes/comfy-clip-shunts/tree/dev

완전히 미학습된 unchained 모델:

https://huggingface.co/AbstractPhil/t5xxl-unchained

여기에 많은 클립을 로드했습니다. omega 24는 원래 vit-l-14 및 laion vit-bigG에 가까워서 이 작업에 매우 적합합니다.

https://huggingface.co/AbstractPhil/clips

res4lyf에 의해 보강 및 개선되었습니다. 설치를 추천합니다.

https://github.com/ClownsharkBatwing/RES4LYF

Kaoru8에게 기본 t5xxl-unchained 변환 및 저장소 제공에 감사드립니다. 이 모델은 기본 T5 위에 추가 학습을 하지 않았지만, 변환되어 있으며 제가 제공한 학습 데이터가 명확히 작동합니다.

https://huggingface.co/Kaoru8/T5XXL-Unchained

나름 괜찮습니다. 일주일 만에 SD35 프로토타입을 완성했습니다.

다음 주 이 시점에는 Flux 변형이 완전히 작동하고 클립 스위트가 프로토타입 단계에 도달할 것이라고 기대합니다.

저는 진심으로 휴식이 필요합니다. 이 작업은 제 정신 건강에 매우 큰 부담이었습니다. 회복하고 재충전할 시간을 갖겠습니다.

저는 전체 정밀 조정이 아니라 도구 개선과 작은 미세 조정에 시간을 할애할 것입니다. 이러한 대규모 미세 조정은 프로그램이 제대로 작동하지 않을 때 신체적·정신적 부담이 크고 비용이 많이 듭니다.

네, 이건 T5 LoRA입니다. T5xxl의 lora_te3를 "T5xxl" 텍스트 인코더처럼 처리했습니다. 원래 SD35 학습 LoRA에서 lora_te3 레이어를 추출하여 다시 저장했습니다. 정말 간단한 과정이며, 어떤 결함이 있을지 예측할 수 없습니다. 아마도 ComfyUI 또는 Forge에서만 로드될 것 같지만, 여기에 공유합니다.

LoRA 가중치를 적용한 T5xxl-unchained와 일반 LLM 추론을 사용하여 대화를 나눌 수 있으며, 요약 성능이 매우 우수합니다.

LoRA 크기: 800MB. 이 과정은 제가 생각한 것보다 훨씬 간단했습니다.

https://huggingface.co/AbstractPhil/SD35-SIM-V1/tree/main/REFIT-V1

from safetensors.torch import load_file, save_file

# Load the safetensors model

input_path = "I:/AIImageGen/AUTOMATIC1111/stable-diffusion-webui/models/Lora/test/sd35-sim-v1-t5-refit-v2-Try2-e3-step00003000.safetensors"

output_path = "I:/AIImageGen/AUTOMATIC1111/stable-diffusion-webui/models/Lora/test/t5xxl-unchained-lora-v1.safetensors"

model = load_file(input_path)

# Filter out TE1 and TE2 tensors

filtered = {k: v for k, v in model.items() if not (k.startswith("lora_te1") or k.startswith("lora_te2") or k.startswith("lora_unet")) }

print(f"Filtered out {len(model) - len(filtered)} tensors.")

print(f"Remaining tensors: {filtered.keys()}")

# Save result

save_file(filtered, output_path)

print(f"✅ Saved cleaned model without TE1/TE2 tensors to:\n{output_path}")

원하시면 직접 추출하십시오. 최신 T5는 여전히 학습 중입니다.

T5xxl용 올바른 토크나이저 및 구성이 필요하며, T5xxl 모델 가중치가 있어야 작동합니다.

기본 t5xxl-unchained, 토크나이저 및 올바른 차원 구성이 없으면 크기 불일치 오류가 발생합니다.

큰 T5xxl fp16 또는 fp8이 필요합니다. fp16로 학습되었기 때문에, 이 버전으로 미세 조정하면 더 나은 결과를 얻을 수 있습니다. ComfyUI 또는 Forge에 다운스케일하도록 지시할 수 있습니다.

https://huggingface.co/AbstractPhil/t5xxl-unchained/resolve/main/t5xxl-unchained-f16.safetensors

클립 스위트가 완성되면, 프로그램 내에서 자동으로 스케일링되고 하드웨어 수준의 정량화(호트-변환: Q2, Q4, Q8 등) 및 ComfyUI 내 저장 기능이 활성화됩니다.

그땐 하나의 모델만 있으면 되며, META C++ 라이브러리를 사용해 실행 중에 자동으로 변환됩니다.

https://huggingface.co/AbstractPhil/t5xxl-unchained/blob/main/config.json

https://huggingface.co/AbstractPhil/t5xxl-unchained/blob/main/tokenizer.json

Forge를 수정하려면 위 주소의 파일을 교체하면 됩니다. 단, sd3_conds.py 파일은 코드 내 템플릿을 직접 수정해야 합니다.

원래 구성 파일은 백업해두는 것이 좋습니다. 그러나 T5xxl-unchained는 원본 T5xxl과 동일하게 작동합니다.

------------------------------------------------------------------------

configs

------------------------------------------------------------------------

modules/models/sd3/sd3_conds.py

backend/huggingface/stabilityai/stable-diffusion-3-medium-diffusers/text_encoder_3

backend/huggingface/black-forest-labs/FLUX.1-dev/text_encoder_2/config.json

backend/huggingface/black-forest-labs/FLUX.1-schnell/text_encoder_2/config.json

-------------------------------------------------------------------------

tokenizers

-------------------------------------------------------------------------

backend/huggingface/black-forest-labs/FLUX.1-dev/tokenizer_2/tokenizer.json

backend/huggingface/black-forest-labs/FLUX.1-schnell/tokenizer_2/tokenizer.json

backend/huggingface/stabilityai/stable-diffusion-3-medium-diffusers/tokenizer_3/tokenizer.json