Nakagawa Natsuki/中川夏紀 (Sound! Euphonium)

详情

下载文件

关于此版本

模型描述

- 由于 Civitai 的服务条款,部分图片无法上传。完整的预览图片请参见 HUGGINGFACE。

- 对于模型版本 v1.5.1 或 v2.0+,您可以像使用其他 LoRA 一样直接在 WebUI 中使用它们,这些模型是使用 kohya 脚本训练的。

- 对于模型版本 v1.5 或 v1.4-,您必须同时使用两个文件才能运行。详情请参见描述中的“如何使用 Pivotal Tuned 模型”。

- 精简后的角色标签为:棕色头发、马尾、长发、紫色眼睛。当角色的核心特征(例如发色)不够稳定时,您可以在提示词中添加这些标签。

- pt 文件的推荐权重为 0.7–1.1,LoRA 的推荐权重为 0.5–0.85。

- 图片是使用一些固定提示词和基于数据集的聚类提示词生成的,使用了随机种子,排除了挑选行为。您看到的就是您能得到的。

- 服装方面未进行专门训练。您可以查看我们提供的预览帖子,获取与服装对应的提示词。

- 本模型使用了 846 张图片进行训练。

- 训练配置文件请见 这里。

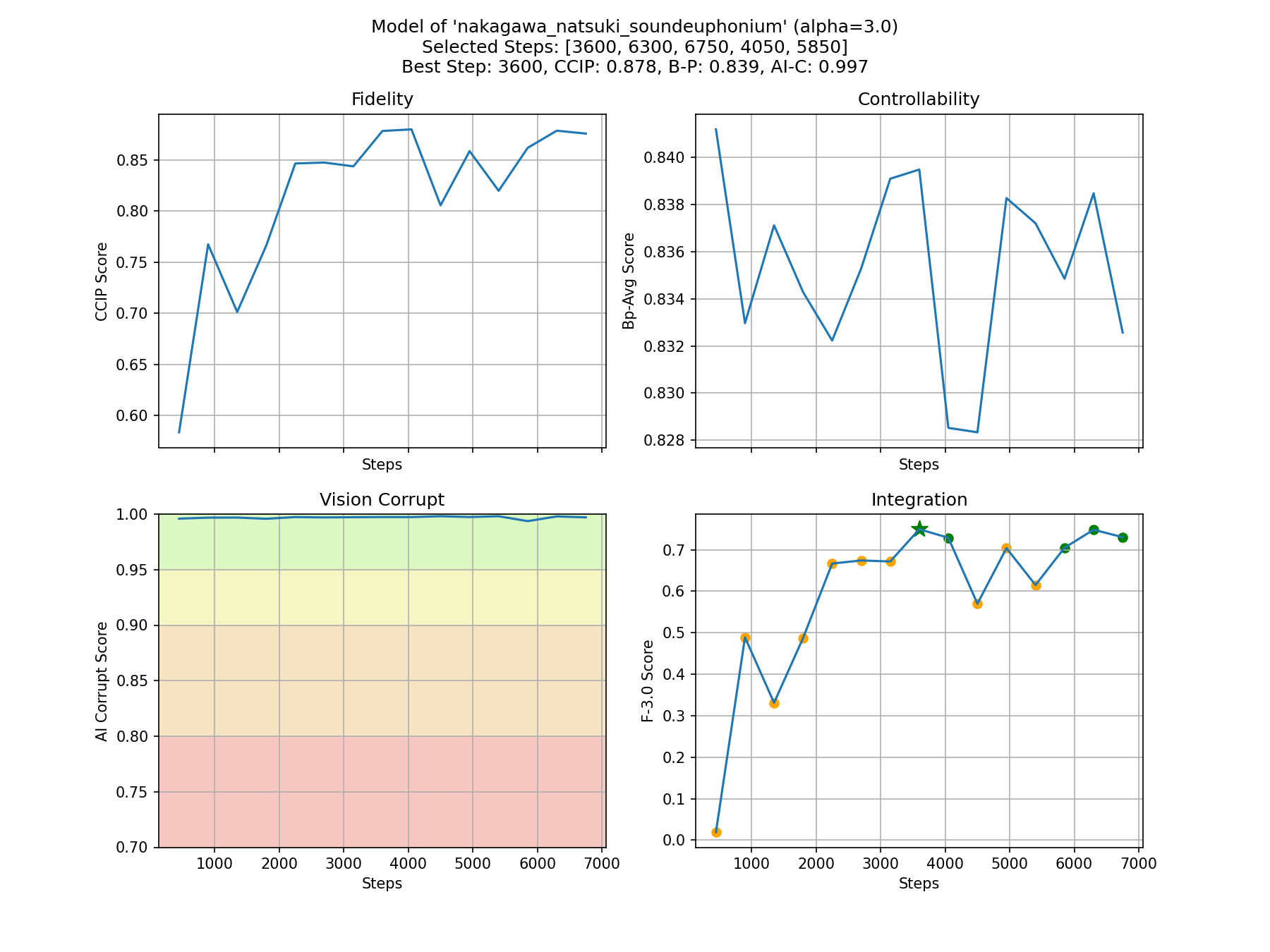

- 我们自动选择的步数为 3600,以平衡模型的保真度与可控性。所有步骤的概览如下。您可以在 huggingface 仓库 - CyberHarem/nakagawa_natsuki_soundeuphonium 中尝试其他推荐步数。

如何使用本模型

本部分仅适用于模型版本 v1.5.1 或 v2.0+。

您可以像使用其他 LoRA 一样直接使用它。我们使用 kohya 脚本训练了此模型。

他のLoRAと同様に簡単に使用できます。このモデルはkohyaスクリプトで訓練されました。

다른 LoRA처럼 간단히 사용할 수 있습니다. 우리는 이 모델을 kohya 스크립트로 훈련했습니다.

您可以像其他LoRAs一样简单地使用它。我们使用kohya脚本对该模型进行了训练。

(由 ChatGPT 翻译)

如果您正在寻找模型中的女角色,或对我们的技术感兴趣,欢迎加入我们的 Discord 服务器。

本模型的训练方式

- 本模型使用 kohya-ss/sd-scripts 训练,图像由 a1111 的 WebUI 和 API SDK 生成。

- 自动训练框架 由 DeepGHS 团队 维护。

- 用于训练的数据集为 CyberHarem/nakagawa_natsuki_soundeuphonium 中的

stage3-p480-1200,包含 846 张图片。 - 我们自动选择的步数为 3600,以平衡模型的保真度与可控性。

- 训练配置文件请见 这里。

如需更多训练细节和推荐步数,请参阅 huggingface 仓库 - CyberHarem/nakagawa_natsuki_soundeuphonium。

如何使用 Pivotal Tuned 模型

本部分仅适用于模型版本 v1.5 或 v1.4-。

本模型包含两个文件。如果您使用的是 WebUI v1.6 或更低版本,请务必同时使用这两个文件!!! 在此情况下,您需要下载 nakagawa_natsuki_soundeuphonium.pt 和 nakagawa_natsuki_soundeuphonium.safetensors 两个文件,然后将 nakagawa_natsuki_soundeuphonium.pt 放入 embeddings 文件夹,并同时将 nakagawa_natsuki_soundeuphonium.safetensors 作为 LoRA 加载。如果您使用的是 WebUI v1.7+,请像常规 LoRA 一样直接使用 safetensors 文件即可。这是因为嵌入式 LoRA/Lycoris 模型现已得到 a1111 WebUI 的官方支持,详情请见 此处。

このモデルには2つのファイルがあります。WebUI v1.6 以下のバージョンを使用している場合は、これらを一緒に使用する必要があります!!! この場合、nakagawa_natsuki_soundeuphonium.pt と nakagawa_natsuki_soundeuphonium.safetensors の両方をダウンロードする必要があり、 その後、nakagawa_natsuki_soundeuphonium.pt を embeddings フォルダに入れ、同時に nakagawa_natsuki_soundeuphonium.safetensors をLoRAとして使用します。 webui v1.7+を使用している場合、一般的なLoRAsのようにsafetensorsファイルを使用してください。 これは、埋め込みバンドルされたLoRA/Lycorisモデルが現在、a1111のwebuiに公式にサポートされているためです。 詳細についてはこちらをご覧ください。

此模型包含两个文件。如果您使用的是 WebUI v1.6 或更低版本,您需要同时使用这两个文件! 在这种情况下,您需要下载 nakagawa_natsuki_soundeuphonium.pt 和 nakagawa_natsuki_soundeuphonium.safetensors 两个文件, 然后将 nakagawa_natsuki_soundeuphonium.pt 放入 embeddings 文件夹中,并同时使用 nakagawa_natsuki_soundeuphonium.safetensors 作为 LoRA。 如果您正在使用 webui v1.7 或更高版本,只需像常规 LoRAs 一样使用 safetensors 文件。 这是因为嵌入式 LoRA/Lycoris 模型现在已经得到 a1111's webui 的官方支持, 更多详情请参见这里。

(由 ChatGPT 翻译)

触发词为 nakagawa_natsuki_soundeuphonium,精简标签为 brown_hair, ponytail, long_hair, purple_eyes。当某些特征(例如发色)在某些时候不够稳定时,您可以将这些标签添加到提示词中。

为何部分预览图看起来不像她

所有预览图所使用的提示词(点击图片可查看)均是基于训练数据集中提取的特征信息,通过聚类算法自动生成的。图像生成时使用的种子也是随机生成的,图像未经任何人工筛选或修改。因此,可能出现上述问题。

实际使用中,根据我们的内部测试,大多数出现此类问题的模型,在真实使用中的表现比预览图中看到的更好。您可能需要做的只是调整使用的标签。

我觉得这个模型可能过拟合或欠拟合,该怎么办

您看到的步数是自动选择的。我们也为您推荐了其他优质步数供尝试。点击 此处 选择您喜欢的步数。

我们的模型已发布于 huggingface 仓库 - CyberHarem/nakagawa_natsuki_soundeuphonium,所有步数的模型均已保存。同时,我们还发布了训练数据集于 huggingface 数据集 - CyberHarem/nakagawa_natsuki_soundeuphonium,可能对您有帮助。

为何不直接使用更好的精选图片

本模型从数据采集、训练、生成预览图到发布,全过程 100% 自动化,无人工干预。这是我们的团队进行的一项有趣实验,为此我们开发了一整套软件基础设施,包括数据筛选、自动训练和自动化发布。因此,若您能提供反馈或建议,我们将非常感激,因为它们对我们至关重要。

为何无法准确生成期望的角色服装

我们当前的训练数据来源于多个图片网站,而在全自动流程中,很难准确预测角色拥有哪些官方图像。因此,服装生成依赖于基于训练数据集中标签的聚类方法,以尽可能还原效果。我们将持续优化这一问题,但目前仍无法完全解决。服装还原的准确性也不太可能达到人工训练模型的水平。

事实上,本模型最大的优势在于还原角色固有特征及因数据集较大而具备的较强泛化能力。因此,本模型非常适合用于更换服装、调整角色姿势,当然也包括生成角色的 NSFW 图像!😉

对于以下群体,我们不推荐使用本模型,并深表遗憾:

- 无法容忍任何与原角色设计偏差,即使是最细微细节的人士。

- 对角色服装还原精度要求极高的人士。

- 无法接受 Stable Diffusion 算法生成图像潜在随机性的人士。

- 不适应使用 LoRA 自动训练角色模型流程,或认为训练角色模型必须完全手动操作以避免“不尊重角色”的人士。

- 觉得生成图像内容违背自身价值观的人士。