Simple Self-Forcing Wan1.3B+Vace workflow

详情

下载文件

模型描述

这是一个非常简单的流程,用于运行 Self-Forcing Wan 1.3B + VACE,它仅使用一个自定义节点,而每个制作视频的人都应该拥有它:Kosinkadink/ComfyUI-VideoHelperSuite。其余部分均为纯 Comfy 核心。

你需要从这里下载你选择的模型:lym00/Wan2.1-T2V-1.3B-Self-Forcing-VACE · Hugging Face,并将其放入你的 /path/to/models/diffusion_models 文件夹中。

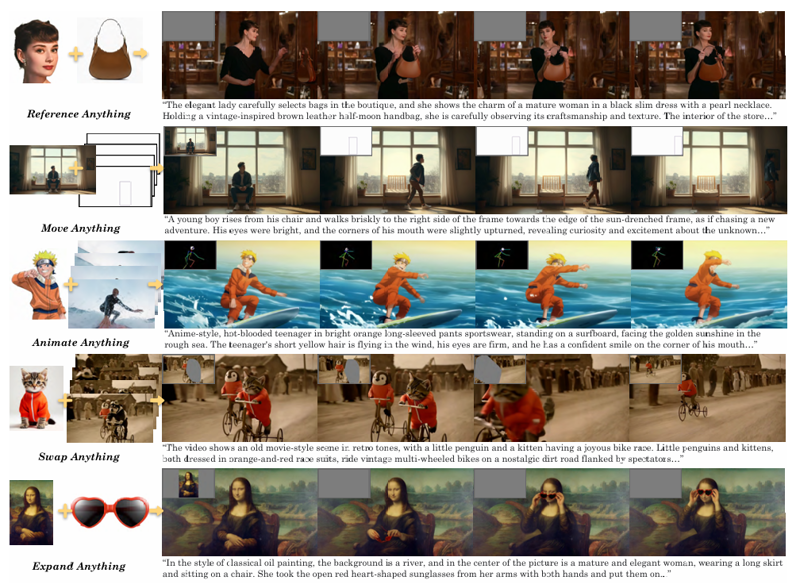

此流程可作为实验的绝佳起点。你可以参考这篇文献《[2503.07598] VACE: All-in-One Video Creation and Editing》(https://arxiv.org/abs/2503.07598) 了解如何使用 VACE。当然,你无需阅读整篇论文——你感兴趣的信息主要在第7页顶部,我将其复现如下:

基本上,在 WanVaceToVideo 节点中,你有三个可选输入:control_video、control_masks 和 reference_image。

control_video 和 control_masks 的名称可能有些误导。你无需提供完整视频,实际上你可以提供多种内容以实现不同效果。例如:

如果你提供单张图片,其效果大致等同于 image2video。

如果你提供一组由空白图像分隔的图片序列:img1, black, black, black, img2, black, black, black, img3 等,这相当于在这些图像之间进行插值,并填充黑色区域。一个更清晰的特例是:如果你有 img1, black, black, ..., black, img2,那就等同于从 start_img 到 end_img 的视频生成。

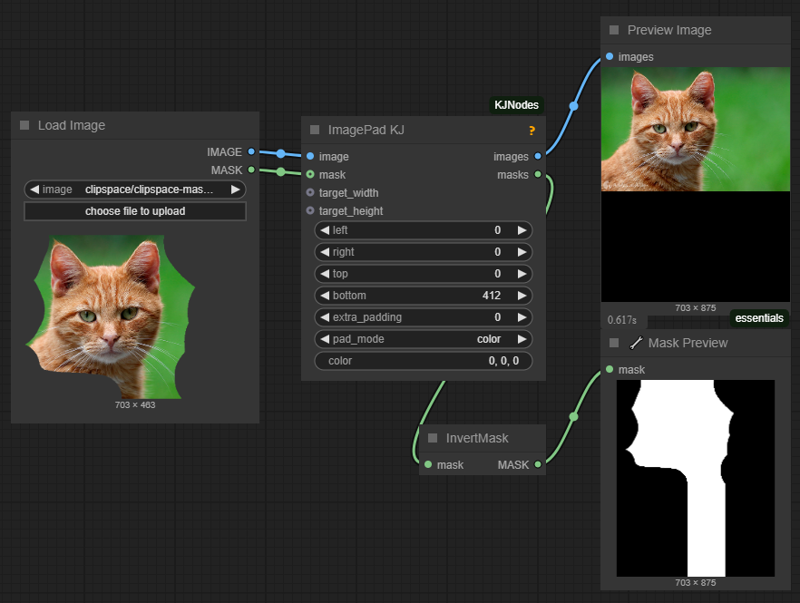

control_masks 控制 Wan 应该在哪些区域进行绘制。基本上,只要掩码值为 1,原始图像的对应区域就会被保留。因此,你可以对输入图像进行填充和/或掩码处理,例如:

然后将此图像和掩码分别作为 control_video 和 control_mask 使用,即可实现图像的内补(inpaint)和外补(outpaint)视频生成。

如果你在 control_video 中输入一段视频,你也可以通过 control_mask 控制变化发生的位置,但你需要为视频中的每一帧设置一个掩码。

如果你输入经过 OpenPose 或深度图预处理的图像,你可以更精细地控制视频输出中的运动。

reference_image 节点本质上是一张你提供给 Wan+VACE 的参考图像。例如,如果你在此处放入某人的面部图像,有很大概率你会得到包含该人面部的视频。