Wan 2.1 Image to Video Loop | Workflow

詳細

ファイルをダウンロード

モデル説明

このワークフローは、開始フレームと終了フレームとして1つの画像を参照してループ動画を作成します。動画の最初と最後からフレームを削除することで、より滑らかなループ遷移を実現できます。少なくとも12GBのVRAMを推奨します。動画生成には高性能なハードウェアが必要です。

- CFGを下げると生成時間が短縮されますが、動きが減少します。

- 4秒を超える動画は失敗するか、非常に長くかかる可能性があります。ループ用の最適な動画長は3秒です。

----------

このワークフローは、IMG to VIDEO simple workflow WAN2.1 と Wan 2.1 seamless loop workflow の組み合わせです。

このワークフローは、Live Wallpaper Fast Fusion モデルとの使用を推奨します。

ライセンスについては一切不明です。利用は自己責任でお願いします。

----------

自動プロンプト機能にはOllamaが必要です。インストール手順はComfyUIにノードを追加するだけでは完了しません。

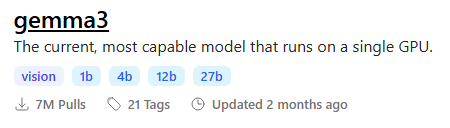

ビジョン対応のgemma3モデルを推奨します。

出力品質を最大化するには、Ollamaに以下のテキストを入力して、画像用のモーション認識プロンプトを生成できます:

You are an expert in motion design for seamless animated loops.

Given a single image as input, generate a richly detailed description of how it could be turned into a smooth, seamless animation.

Your response must include:

✅ What elements **should move**:

– Hair

– Eyes

– Clothing or fabric elements

– Light effects

– Floating objects if they are clearly not rigid or fixed

🚫 And **explicitly specify what should remain static**:

– Rigid structures (e.g., chairs, weapons, metallic armor)

– Body parts not involved in subtle motion (e.g., torso, limbs unless there’s idle shifting)

– Background elements that do not visually suggest movement

⚠️ Guidelines:

– The animation must be **fluid, consistent, and seamless**, suitable for a loop

– Do NOT include sudden movements, teleportation, scene transitions, or pose changes

– Do NOT invent objects or effects not present in the image (e.g., leaves, particles, dust)

– Do NOT describe static features like colors, names, or environment themes

– Return only the description (no lists, no markdown, no instructions, no think)

----------

📂ファイル:

このワークフローは、Live Wallpaper Fast Fusion モデルとの使用を推奨します。

models/diffusion_modelsに配置してください。

通常バージョン用

CLIP: umt5_xxl_fp8_e4m3fn_scaled.safetensors

models/clipに配置

GGUFバージョン用

24 GB VRAM: Q8_0

16 GB VRAM: Q5_K_M

<12 GB VRAM: Q3_K_S

量子化CLIP: umt5-xxl-encoder-QX.gguf

models/clipに配置

CLIP-VISION: clip_vision_h.safetensors

models/clip_visionに配置

VAE: wan_2.1_vae.safetensors

models/vaeに配置

任意のアップスケールモデル:

- リアリスティック: RealESRGAN_x4plus.pth

- アニメ: RealESRGAN_x4plus_anime_6B.pth

models/upscale_modelsに配置

----------

ノード:

ComfyUI-Custom-Scripts

rgthree-comfy

ComfyUI-Easy-Use

ComfyUI-KJNodes

ComfyUI-VideoHelperSuite

ComfyUI_essentials

ComfyUI-Frame-Interpolation

comfyui-ollama

ComfyUI-mxToolkit

was-node-suite-comfyui

ComfyUI-WanStartEndFramesNative