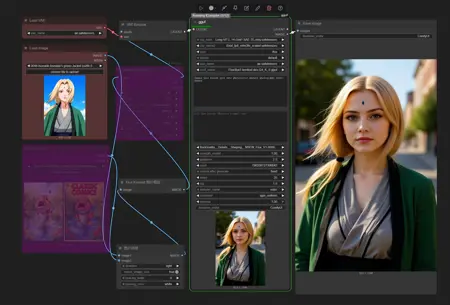

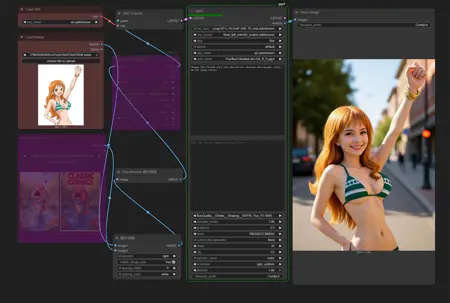

Flux1 kontext (nunchaku+Multi_input+Lora、gguf) 70% time savings,Improved accuracy

세부 정보

파일 다운로드

모델 설명

ヌンチャク Multi_input+Lora

이제 두 개의 별도 워크플로우를 포함합니다:

------Kontext_gguf&safetensors__Multi_input&Lora.json

------Kontext_nunchaku_Multi_input&Lora.json

mit-han-lab/ComfyUI-nunchaku를 설치했지만 제대로 작동하지 않나요? 여기를 확인하세요!

이번에는 정말 신경을 써서 이 워크플로우를 구성했습니다. 공식 노드를 사용해보긴 했지만, 여러 이미지 입력을 어떻게 사용하는지, 생성 해상도를 어떻게 커스터마이징하는지, 또는 누ン차쿠-텍스트인코더 모델로 전환하는 방법을 모르시는 분들에게 이 간소화된 워크플로우가 완벽합니다!

ヌンチャ쿠의 int4 모델을 사용할 때 이미지 생성 시간이 과거 대비 약 4분의 1로 단축되었고, 품질 손실은 거의 없습니다. 저는 이제 진심으로 gguf를 사용하고 싶지 않습니다.

ヌンチャ쿠 체크포인트:

https://huggingface.co/mit-han-lab/nunchaku-flux.1-kontext-dev/tree/main

aqw-int4-flux.1-t5xxl (선택 사항):

https://huggingface.co/mit-han-lab/nunchaku-t5/tree/main

ヌンチャ쿠 ComfyUI 노드:

https://github.com/mit-han-lab/ComfyUI-nunchaku

ComfyUI-nunchaku 설치 가이드 (Windows):

ComfyUI_windows_portable디렉토리 주소 표시줄에cmd를 입력하고 엔터를 누르세요. 그 후 다음 명령을 입력하여 torch 및 Python 버전을 확인하세요:

"python_embeded\python.exe""python_embeded\python.exe -m pip list"

예: 제 시스템은 Python 3.12와 torch 2.5.1+cu124를 표시합니다.

ComfyUI-Manager를 사용하여 누ン차쿠 노드(ComfyUI-nunchaku v0.3.3)를 설치하거나,

ComfyUI_windows_portable\ComfyUI\custom_nodes디렉토리 주소 표시줄에cmd를 입력한 후git clone https://github.com/mit-han-lab/ComfyUI-nunchaku.git명령을 실행하여 수동으로 설치할 수 있습니다.다음 링크에서 자신의 버전에 맞는 누ン차쿠 whl 파일을 다운로드하세요:

https://github.com/mit-han-lab/nunchaku/releases. 1단계에서 버전 정보를 확인했으므로, 저는nunchaku-0.3.1+torch2.5-cp312-cp312-win_amd64.whl을 다운로드하겠습니다. 다운로드 후, whl 파일을ComfyUI_windows_portable디렉토리에 두고"python_embeded\python.exe -m pip install nunchaku-0.3.1+torch2.5-cp312-cp312-win_amd64.whl"명령을 실행하여 설치하세요.설치 후, ComfyUI를 최신 버전으로 업데이트하고 재시작하는 것을 잊지 마세요. 또한 다운로드한 누ン차쿠 모델을

diffusion_models폴더에 위치시켜야 합니다. NVIDIA 40시리즈 이하 카드는int4를, 50시리즈 카드는FP4를 선택하세요.제 테스트에서 Python 3.11 기반의 ComfyUI는 제대로 작동하지 않았습니다. 그러나 이 점에 대해 확신은 없습니다.

gguf+Lora

"워크플로우가 너무 복잡한데?", "하드웨어 요구사항이 너무 높은가?", "모델은 어디서 다운로드하나?", "출력 결과가 입력 이미지를 무시하는 것 같아?" 같은 질문을 하신다면?

이 워크플로우는 정말 초보자를 위해 제작되었습니다. 이 단일 워크플로우 파일 하나만 있으면 충분합니다. 솔직히 말해, 제가 별다른 작업을 한 건 아니고, 공식 ComfyUI 워크플로우를 가져와 약간 수정한 뒤 gguf와 Lora 지원만 추가했습니다.

사용 방법:

1. 워크플로우 또는 예제 이미지를 ComfyUI에 드래그하고, 누락된 노드를 설치하세요.

2. 모델을 다운로드하여 diffusion_models 폴더에 넣고, ComfyUI를 업데이트한 후 재시작하세요.

체크포인트:

https://huggingface.co/bullerwins/FLUX.1-Kontext-dev-GGUF/tree/main

가이드:

https://docs.bfl.ai/guides/prompting_guide_kontext_i2i

https://docs.comfy.org/tutorials/flux/flux-1-kontext-dev

https://comfyui-wiki.com/en/tutorial/advanced/image/flux/flux-1-kontext

현재 Flux1 Kontext가 할 수 있는 기능은 아래와 같습니다. 전부 열거하기엔 너무 많아서 주요 기능만 소개합니다:

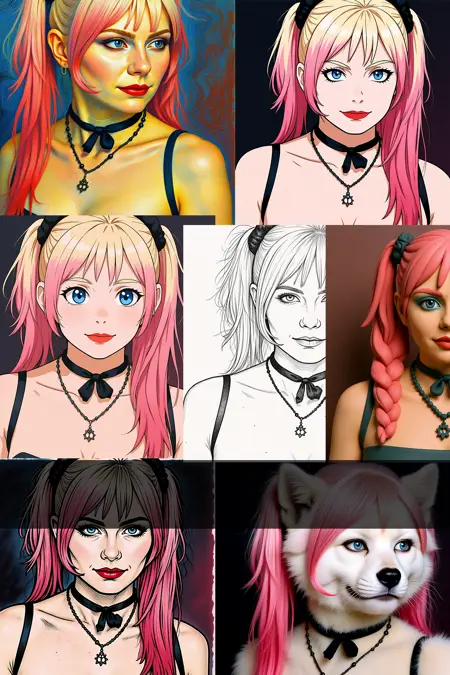

1. 이미지 스타일 변경 / 스타일 전이

2. 이미지 내 물체 추가 또는 제거

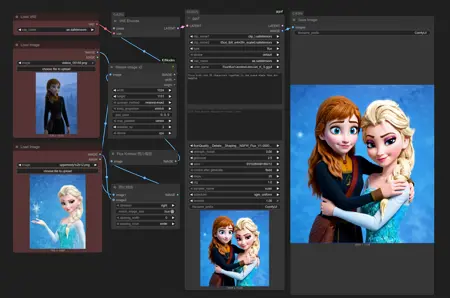

3. 캐릭터의 행동(예: 뒤돌기) 변경 또는 표정을 바꾸되 외형은 일관되게 유지

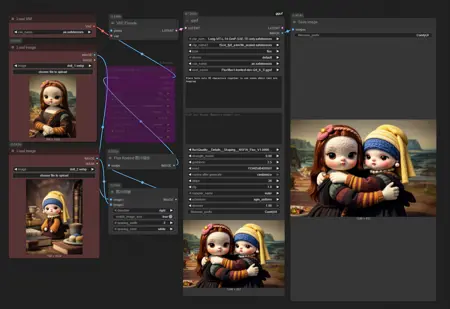

4. 여러 캐릭터 및 장면 결합

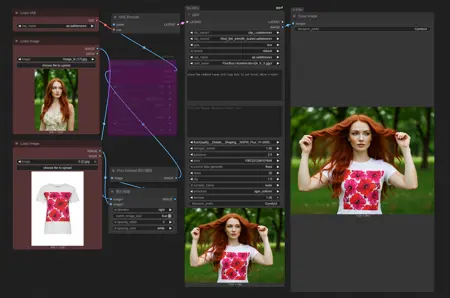

5. 가상 피팅 (모델 시험 착용) — 테스트에서는 아직 제대로 작동하지 않았습니다. 작동은 했지만 결과에 만족하지 못했습니다. ~좋은 소식은 이 도구가 오픈소스이며 무료라는 것입니다.

따라서 옷을 판매하신다면, 이 기능을 활용해 모델 시험 착용을 해보세요: 특정 모델을 지정하지 않고 단지 옷 이미지만 제공하면, Kontext가 자동으로 모델을 생성해줍니다. 이렇게 하면 훨씬 더 나은 결과를 얻을 수 있습니다!