Fast WAN I2V Compact

详情

下载文件

模型描述

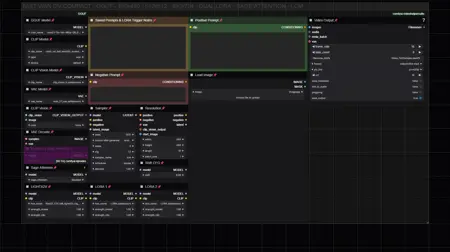

专为视觉紧凑和简化操作而设计。我个人认为这是最流畅的工作流程。整体布局旨在用户友好、直观,并在完美适配 ComfyUI 工作区窗口的同时,尽可能节省空间。总而言之,这是满足您所有 WAN 视频生成需求的一站式解决方案。

此工作流程在配备 4070ti 显卡的设备上,使用 Q8 GGUF 或 FP8 模型(未启用 Sage Attention)可在 60 秒内生成一段 5 秒、480x480 分辨率的视频,并采用 LCM 采样配合 Light X2V 加速生成时间。

该工作流程主要使用基础且常见的节点和扩展,因此只需极少努力即可顺利运行。点击“显示更多”查看详细要求和模型下载链接。

显著功能包括:无限 LoRA 加载器、Sage Attention、可提取生成视频的最后一帧用于视频扩展(需手动保存并加载)、独立的视频合成工具工作流,以及独立的超分辨率/插值工具工作流,便于对生成视频进行选择性且简易的后期处理,并充分考虑了从高性能 PC 到低配置设备的多种使用场景。

针对 WAN 2.2:

设计与之前相同,但仅针对运行 WAN 2.2 低噪模型优化。请参阅下方“所需模型”部分了解新的工作流要求。

Light X2V LoRA 在 WAN 2.2 上的强度设置为 1.1 至 2.0 时效果显著,可能以有益或有害的方式大幅改变模型行为。经测试后,我将默认强度设为 1.5,因其表现最稳定,但建议您自行实验以找到最适合您的设置。

WAN 2.2 更加动态,这意味着其提示方式可能与 WAN 2.1 不同。LoRA 的效果也会被放大,这可能有利也可能有弊,但总体而言,我已获得大量优质结果。因此,要获得良好效果,关键在于学习如何正确提示,并根据 LoRA 与您的提示和图像输入的配合情况,调整 LoRA 强度。甚至将步数调整为 6 或 8 步,也可能提升效果。

工作流的采样器/调度器设置表现良好,但仍需更多实验,可能存在更优的组合,尤其是 RES4LYF 自定义采样器与调度器扩展(见下方要求)。

有时可能出现失控的劣质生成,但一旦调校得当,WAN 2.2 能生成大量 WAN 2.1 完全无法实现的优质视频。

针对 WAN 2.1:

您可能需要调整的主要设置仅为输出分辨率或采样步数。其他采样器或调度器也可能适用,但我发现 LCM/SGM Uniform 或 LCM/Beta57 能提供最连贯的输出。您还可微调 LoRA 强度。此外,还有其他可调整的设置,例如“SHIFT”,其作用类似 CFG。根据我的经验,它能显著改变提示/LoRA 的表达方式,并增强运动变化,但通常建议保持默认值。512x512 或 640x640 分辨率也可使用,但可能降低提示一致性。

注意:Sage Attention 默认禁用。如已安装前置依赖,只需选中“启用 Sage Attention”节点并按 Ctrl+B 启用,然后在其下方将“sage_attention”选项从“禁用”改为“启用”。即使您不打算使用 Sage Attention,仍需安装该扩展以确保工作流正常运行。

所需及可选模型:

GGUF WAN 2.2 i2v 模型(仅使用“低噪”版本):

https://huggingface.co/bullerwins/Wan2.2-I2V-A14B-GGUF/tree/main

GGUF WAN 2.1 i2v 模型:

https://huggingface.co/city96/Wan2.1-I2V-14B-480P-gguf/tree/main

FP8 WAN 2.1 Light X2V(适用于 FP8 工作流,无需独立加速 LoRA,推荐作为运行 WAN 的新默认方式,提示一致性极佳,解决了大量质量缺陷):

CLIP 模型:

或更高精度的 BF16 CLIP 模型:

https://huggingface.co/minaiosu/Felldude/blob/main/wan21UMT5XxlFP32_bf16.safetensors

CLIP Vision 模型:

或专为 NSFW 优化的自定义 CLIP Vision 模型(推荐):

https://huggingface.co/ricecake/wan21NSFWClipVisionH_v10/tree/main

VAE 模型:

Light X2V T2V LoRA:https://huggingface.co/Kijai/WanVideo_comfy/blob/main/Wan21_T2V_14B_lightx2v_cfg_step_distill_lora_rank32.safetensors

或标准的 Light X2V I2V LoRA:

或 Kijai 的其他 Light X2V 实验版本:

https://huggingface.co/Kijai/WanVideo_comfy/tree/main/Lightx2v

或 2025 年 10 月发布的 Light X2V LoRA v2.0(若未使用内嵌 LoRA 的模型,推荐使用):

https://huggingface.co/lightx2v/Wan2.1-Distill-Loras/tree/main

https://huggingface.co/lightx2v/Wan2.2-Distill-Loras/tree/main

RES4LYF 自定义采样器与调度器:

https://github.com/ClownsharkBatwing/RES4LYF

秘密技巧:使用透明或纯色图像(如黑色)可将 i2v 模型转化为类似 t2v 模型。它将从空白输入图像快速过渡,并从零开始生成内容以匹配您的提示。这是一种无需更改工作流或模型即可获得 t2v 能力的简便方法。

其他有用信息:

WAN 的行为会因输出分辨率的改变而显著变化,当宽度或高度为 480 像素时,其响应效果最佳。WAN 2.2 本应是 480p 和 720p 模型,但其在不同分辨率下仍可能表现不同,可能需要调整设置,或在某些分辨率下无法正常工作。有些内容在 480x480 下表现良好,有些在 512x512 或更高分辨率下效果更佳或更差,但通常在宽度或高度为 480 或 720 时能获得最稳定的输出。