NetaYume Lumina (Neta Lumina/Lumina Image 2.0)

詳細

ファイルをダウンロード

モデル説明

I. はじめに

NetaYume Lumina は、Neta.art Lab が開発した高品質なアニメスタイルの画像生成モデルである Neta Lumina をファインチューニングして作成されたテキストから画像を生成するモデルです。これは、上海AI实验室のAlpha-VLLMチームが公開したオープンソースのベースモデルである Lumina-Image-2.0 を基盤としています。

主な特徴:

高品質なアニメ生成: 鮮明な輪郭、鮮やかな色合い、滑らかなシェーディングを備えた詳細なアニメスタイルの画像を生成します。

キャラクター理解の改善: 特にDanbooruデータセットからのキャラクターをより正確に捉え、一貫性があり正確なキャラクター表現を実現します。

微細な詳細の強化: アクセサリー、衣装の質感、ヘアスタイル、背景要素などをより鮮明に正確に生成します。

II. 情報

バージョン1.0について:

- このモデルは、

neta-lumina-beta-0624-rawというNetaLuminaモデルをベースに、約1000万枚の画像から構成されるカスタムデータセットを使用してファインチューニングされました。トレーニングは8枚のNVIDIA B200 GPUを用いて3週間行いました。

バージョン2.0について:

このバージョンには2つのサブバージョンがあります:

バージョン2.0:

ベースモデルをNeta Lumina v1に変更し、e621とDanbooruから収集した画像からなるカスタムデータセットでトレーニングしました。データセットのアノテーションは複数言語で構成されています:画像の30%は日本語、30%は中国語(Danbooruスタイルタグ50%、自然言語50%)、残りの40%は自然な英語説明でラベル付けされています。

アノテーションには、ChatGPTおよびその他のプロンプト最適化が可能なモデルを用いてタグの品質を向上させました。また、固定解像度1024でのトレーニングではなく、コードを修正して768〜1536の範囲で画像を動的にリサイズするマルチスケールトレーニングを実装しました。

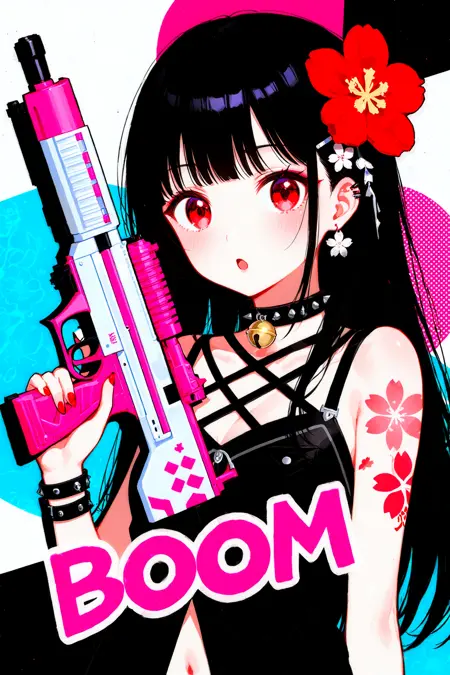

注記: 現在、このモデルはベンチマークテストのみで評価しており、その完全な能力はまだ不確定です。ただし、初期テストでは、私が提供したサンプル画像のように1312x2048の解像度で画像を生成する際に非常に優れた性能を発揮しています。

さらに、私のテスト結果によると、このバージョンでは最大2048x2048の解像度で画像を生成できます。

バージョン2.0 Plus:

このモデルは、より高品質な画像から構成されるデータセットでトレーニングされたバージョン2.0をベースにファインチューニングされています。このデータセットでは、各画像に自然言語の説明とDanbooruスタイルのタグの両方がアノテーションされています。

トレーニング手順はバージョン2と同様の設計ですが、3段階に分かれています。

最初の2段階では、上位10層を固定し、Danbooruラベル付きサブセットと自然言語ラベル付きサブセットで別々にトレーニングを行います。

最終段階では、すべての層をアンロックし、Danbooruと自然言語の両方のアノテーションを含むフルデータセット上で共同最適化を行います。

このバージョンは、生成画像の人工的または「AIらしさ」の問題を軽減し、空間的理解を向上させます。たとえば、プロンプトに従ってキャラクターを画像の左側または右側に配置できるようになります(サンプル画像参照)。また、アーティスト特有のスタイルのレンダリングにも小幅な改善が見られます。

GGUF量子化版はこちらでご利用いただけます: https://huggingface.co/Immac/NetaYume-Lumina-Image-2.0-GGUF

バージョン3.0:

このバージョンは新しいキャラクター知識を導入し、以前は生成できなかった一部の既存キャラクターの生成を改善しました(後ほど改善されたキャラクターのリストを提供します)。ただし、リスト内のすべてのキャラクターが必ずしも生成できるとは限らないことにご注意ください。私は古い知識を維持しつつ、テキストレンダリング、解剖学(アーティストスタイルを使用する際、モデルは不正確または不完全な解剖学を生成することがあります)、モデルの安定性、およびその他の追加の秘密の改善点を強化しています。

画像内にテキストを生成するには、以下のシステムプロンプトの使用を推奨します: "You are an image generation assistant if the prompt includes quoted or labeled on image text render it verbatim preserving spelling punctuation and case.

"。これにより、より良い結果を得られる可能性があります。 このバージョンで芸術的なスタイルで生成されたサンプル画像のギャラリーはこちら: Artist Style Gallery。@LyloGummy への貢献に感謝します。

バージョン3.5(事前トレーニングモデル)について:

このバージョンは事前トレーニングモデルです(正式な名称は不明ですが、Netaチームの前回の仕事の継続であり、Neta Lumina v1.0モデルを使用しています)。より明確に説明すると、バージョン2.0 Plusと3.0はこの事前トレーニングモデルからファインチューニングされています。私のワークフローでは、当時この事前トレーニングモデルの最良のチェックポイントを使用してファインチューニングしています。

このバージョンでは、データセット(Danbooruデータセットのみ、9月3日0時時点)を更新しました。新しいデータセットは自然言語プロンプトを検証できる人がいないため、タグのみを含んでいます。

基本的に、データセットは大きく変更せず、Netaチームの一部のデータを取得して従来のデータとマージし、最新データで更新しただけです。そのため、モデルは依然として非常に似た画像を生成します。ただし、適切なトリガープロンプトを使用すると出力が異なります。良い点は、以前の知識を正確に維持し続けていることです(一部のantistyleが改善されています)。

また、現在のモデルのデフォルトスタイルは安定しており、解剖学とテキスト生成の品質は以前より改善されています。

最後に、このモデルはHugging Faceで公開したテスト版とは異なります。

このバージョンのDiffusers形式はこちら: duongve/NetaYume-Lumina-Image-2.0-Diffusers-v35-pretrained · Hugging Face

III. モデル構成要素:

テキストエンコーダー: 事前トレーニング済み Gemma-2-2B

VAE: Flux.1 dev のVAEを採用

画像バックボーン: NetaLumina のバックボーンをファインチューニングしたバージョン

IV. ファイル情報

このすべてを含む1つのファイルには、VAE、テキストエンコーダー、画像バックボーンの重みが含まれており、ComfyUIおよびカスタムパイプラインをサポートするその他のシステムと完全に互換性があります。

画像バックボーンだけをダウンロードしたい場合は、私のHugging Faceページをご覧ください。分離されたファイルと、ファインチューニング用に使用したい

.pthファイルも含まれています。

V. 推奨設定

詳細情報およびより良い結果を得るには、Neta Lumina Prompt Book をご参照ください。

VI. 注意点とフィードバック

これは初期の実験的ファインチューニングリリースであり、今後のバージョンで継続的に改善を進めています。

フィードバック、提案、創造的なプロンプトアイデアは常に歓迎です!あらゆる貢献がこのモデルの更なる向上に役立ちます!

VII. 他のプラットフォームでのモデルの実行方法

(tensor.art) プラットフォームを通じてご利用いただけます。モデルリンクはこちら: https://tensor.art/models/898410886899707191

ただし、最適化された方法でモデルを実行するには、tensor.art の Comfyflow を使用することを推奨します(デフォルトリナーアは設定が不足しており、モデルが最適でない状態で実行されるため)。プラットフォームでご利用いただけるワークフローの例はこちら: https://huggingface.co/duongve/NetaYume-Lumina-Image-2.0/blob/main/Lumina_image_v2_tensorart_workflow.json

VIII. 謝辞

データセットの貢献者である narugo1992 に大変感謝します。

優れたベースモデルアーキテクチャを開発した Alpha-VLLM および Neta.art Lab に敬意を表します。

私の作業を支援したい場合は、Ko-fi からご支援をお願いします!