Wan 2.2 Workflows (t2v, i2v, v2v, flf2v) with MultiGPU + SageAttention + GGUF + Audio

详情

下载文件

模型描述

更新!https://huggingface.co/StefanFalkok/ComfyUI_portable_torch_2.9.0_cu129_sageattention_beta_non_official/blob/main/ComfyUI_windows_portable_cu129_p313_torch_2.9.0.zip 这是一个修改版的 ComfyUI_portable,内置了 torch 2.9.0 和 Sageattention 2.2.0。部分功能可能无法正常工作,但使用此版本可显著提升 WAN 2.2 的生成速度。不建议在 Flux 和 Qwen 中使用,仅适用于 WAN 2.2 生成。由于 ComfyUI 内嵌了修改版的 Python 3.13.7,部分 Python 设置可能无法正常运行,但你可以通过 oX-COMMAND 安装 Python 库,无需使用 python -m。此外,此版本已预装了一些自定义节点。

我的 TG 频道 - https://t.me/StefanFalkokAI

我的 TG 聊天室 - https://t.me/+y4R5JybDZcFjMjFi

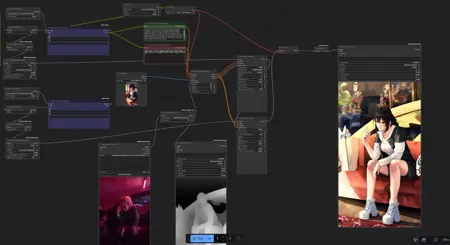

大家好!我向大家介绍我为 ComfyUI 制作的基于 Wan 2.2 生成的视频工作流。

你可以使用 RES4LYF 采样器 https://github.com/ClownsharkBatwing/RES4LYF 通过命令行安装自定义节点:pip.exe install -r requirements.txt

我已包含 5 个工作流:t2v、i2v、v2v、flf2v(首尾帧)以及带插值的超分辨率。

你需要拥有 Wan 2.2 模型(https://huggingface.co/Kijai/WanVideo_comfy_fp8_scaled/tree/main)、clip(https://huggingface.co/Kijai/WanVideo_comfy/blob/main/umt5-xxl-enc-bf16.safetensors)和 vae(wan 2.1 vae)。

此外,我还加入了 4 步 Lora:https://huggingface.co/lightx2v/Wan2.2-Lightning/tree/main/Wan2.2-T2V-A14B-4steps-lora-250928,以实现更快更优的生成效果。

对于 GGUF,我推荐使用 Lightx Lora:https://huggingface.co/Kijai/WanVideo_comfy/blob/main/Lightx2v/lightx2v_T2V_14B_cfg_step_distill_v2_lora_rank256_bf16.safetensors

如需 NSFW Lora,请安装:/model/1307155?modelVersionId=2073605 和 /model/1811313?modelVersionId=2190476

我建议将 Lora 强度设为 1.5,以获得最佳效果。

你还需要安装 Sageattention 2.2.0(含 Triton):https://github.com/woct0rdho/SageAttention/releases/tag/v2.2.0-windows,以及 Torch 2.7.0+ 以提升生成速度:https://github.com/pytorch/pytorch/releases。同时,你需要下载并安装 CUDA 12.8:https://developer.nvidia.com/cuda-12-8-0-download-archive 和 VS Code:https://visualstudio.microsoft.com/downloads/

安装 Sageattention 的说明(1.0.6 版本):如何安装 Sageattention 2.2.0?请将 .whl 文件重命名为 .zip,然后将 zip 中的文件夹解压至 ComfyUI\python_embeded\Lib\site-packages。

如果你的 GPU 等级为 5080(我当前的显卡),使用我的 ksampler 设置,生成 5 秒 720p 16fps 的视频需 9-10 分钟,24fps 则需 16-17 分钟。在 480p 或 540/576p 分辨率下,生成速度会快得多:在我的设备上,480p 5 秒 16fps 仅需 3-4 分钟,24fps 需 6-7 分钟。

如遇到问题或发现工作流有错误,请留言反馈。