hyperfusion_vpred finetune 3.3m images

세부 정보

파일 다운로드

이 버전에 대해

모델 설명

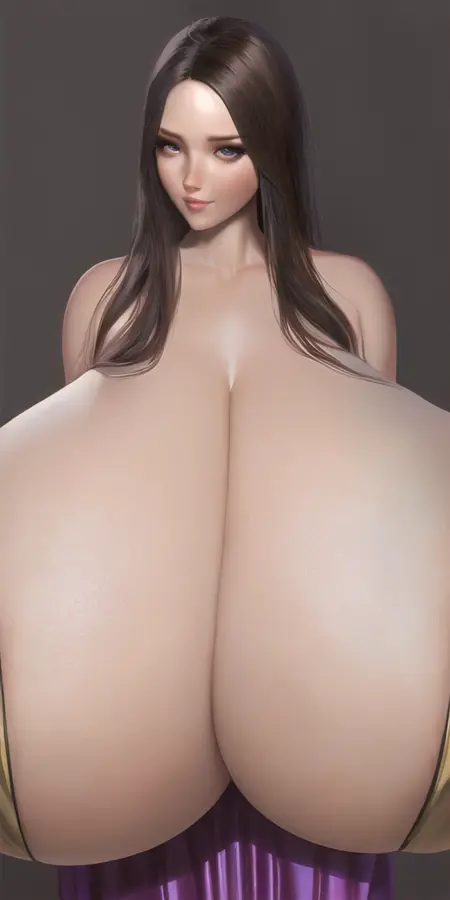

이 체크포인트는 일반에서 초대형 애니메이션 캐릭터의 330만 장의 이미지로 학습되었습니다. 주로 가슴/엉덩이/복부/허벅지에 초점을 맞추지만, 이제는 더 일반적인 태그 주제도 처리합니다. v8 기준으로 애니메이션과 퓨리 이미지가 약 50%/50% 비율입니다. 더 자세한 버전 정보와 향후 계획은 아래 변경 로그 기사를 참고하세요.

참고: 이 모델은 제가 마지막으로 제작하는 SD1x 모델입니다. hyperfusion 데이터셋이 sd1.5에서 실제로 어떤 성능을 낼 수 있는지 확인하고 싶었고, 그래서 2대의 3090 GPU에서 10개월 동안 학습시켜 개념 지식을 모두 끌어냈습니다. 지금까지 제가 학습한 가장 우수한 개념 모델이지만, 여전히 SD1x의 전형적인 결함을 가지고 있습니다. 아마도 Text Encoder 학습률을 지나치게 오랫동안 높게 유지했을 것입니다(0.5x → 0.3x).

저의 모델을 호스팅하고 피드백을 수집할 수 있도록 해주신 stuffer.ai에게 큰 감사의 인사를 전합니다. 이는 모델 초기 단계에서 문제를 해결하는 데 필수적이었고, 시간이 지남에 따라 개선해야 할 부분을 파악하는 데 훌륭한 방법이었습니다.

V9는 v_pred 모델이므로, A1111에서는 YAML 파일을 사용하거나, Comfy에서는 vpred 노드와 함께 cfg_rescale=0.6-0.8을 사용해야 합니다. A1111에서는 또한 CFG_Rescale 확장 프로그램 을 설치해야 합니다.

ComfyUI 워크플로우를 사용한 오래된 예시를 여기에 게시했습니다: https://civitai.com/images/64978187

기타 링크:

OG hyperfusion LoRAs는 여기서 찾을 수 있습니다: /model/16928

이 모델들의 백업 HuggingFace 링크: https://huggingface.co/thojm/HyperFusion

hyperfusion에서 사용된 140만 개의 사용자 정의 태그는 여기에 업로드했습니다: https://huggingface.co/datasets/thojm/hyperfusion_classified_tags_export (자신의 데이터셋에 통합하기 위한 것)

변경 로그 기사 링크

v9_vpred 미세 조정 권장 사항:

샘플러: Karras 샘플러가 아닌 것. Karras 사용 금지! --zero_ternimal_snr로 학습하면 이 샘플러가 문제를 일으킵니다. 또한 A1111에서는 uniform 스케줄러를, Comfy에서는 "simple, normal"을 적어도 사용해야 합니다.

네거티브: 각 태그를 개별적으로 테스트하여 긍정적인 효과가 있는지 확인했습니다:

worst quality, low rating, signature, artist name, artist logo, logo, unfinished, jpeg artifacts, artwork \(traditional\), sketch, horror, mutant, flat color, simple shading

포지티브: 이 모델에 학습된 기본 스타일에는 "best quality, high rating"을 사용하세요. 자세한 내용은 학습 데이터 문서 참조.

cfg: 7-9

cfg_rescale: 이 v_pred 모델에는 rescale_cfg가 필수입니다. 낮은 값은 신체의 혐오스러운 효과를 줄이지만, 이미지가 더 어두워질 수 있습니다.

해상도: 768-1024 (신체의 혐오스러운 효과를 줄이려면 896에 가깝게)

clip skip: 2

zero_terminal_snr: 활성화됨

스타일링: 먼저 스타일을 선택하세요. 기본 스타일은 별로입니다. v8+에 포함된 새로운 아티스트 태그를 시도해 보세요. 모든 태그는 tags.csv에서 "(artist)"로 검색해 확인할 수 있습니다. 예시 이미지를 통해 아트 스타일을 확인하세요.

LoRA/TI: 다른 모델에서 학습된 LoRA는 이 모델에서 작동하지 않습니다. 다른 v_pred 모델에서 학습된 LoRA도 작동하지 않을 수 있습니다.

v8 LoRA 권장 사항:

샘플러: Karras 샘플러가 아닌 것. Karras 사용 금지! --zero_ternimal_snr로 학습하면 이 샘플러가 문제를 일으킵니다.

LoRA/TI: NovelAI 기반 모델에서 학습된 LoRA/TI를 사용하면 오히려 해로울 수 있습니다. 먼저 그것 없이 시도해 보세요.

네거티브: low rating, lowres, text, signature, watermark, username, blurry, transparent background, ugly, sketch, unfinished, artwork \(traditional\), multiple views, flat color, simple shading, unfinished, rough sketch

cfg: 8 (LoRA hyperfusion보다 낮은 값 필요)

해상도: 768-1024 (신체의 혐오스러운 효과를 줄이려면 768에 가깝게)

clip skip: 2

스타일링: v8에 포함된 새로운 아티스트 태그를 시도하세요. 모든 태그는 tags.csv에서 "(artist)"로 검색해 확인할 수 있습니다.

태그 정보 (태그 문서를 꼭 읽어보세요: 학습 데이터)

hyperfusion은 여러 태그 체계의 혼합체이므로, 학습 데이터 다운로드 섹션에 태그 가이드를 포함했습니다. 이 가이드는 태그의 작동 방식(Danbooru 태그와 유사), 모델이 가장 잘 알고 있는 태그, 그리고 제가 사용자 정의한 모든 태그를 설명합니다.

대부분의 경우, 가슴/엉덩이/복부/허벅지/젖꼭지/vore/바디 쉐이프와 관련된 Danbooru, Gelbooru, r-34, e621의 태그 대부분을 사용할 수 있습니다.

태그 탐색을 위한 가장 좋은 방법은 위 booru 사이트 중 하나에 가서 좋아하는 이미지의 태그를 복사하여 기반으로 사용하는 것입니다. 이 모델에 학습된 태그가 너무 많아 모두 테스트할 수 없기 때문입니다.

팁

이 데이터셋의 크기와 다양성 때문에, 태그의 동작 방식은 대부분의 NovelAI 기반 모델과 다릅니다. 다른 모델에서 사용한 프롬프트는 조정이 필요할 수 있습니다.

특정 태그에서 원하는 결과를 얻지 못한다면, 유사한 다른 태그를 찾아 함께 사용하세요. 이 모델은 특정 태그에 대한 지식을 관련 태그들 사이에 분산시키는 경향이 있습니다. 따라서 더 많은 태그를 포함하면 원하는 결과를 얻을 확률이 높아집니다.

네거티브에 "3d"를 사용하면, 이미지가 렌더링된 모델처럼 보이는 경향을 줄이고 애니메이션 스타일로 더 가깝게 만드는 데 도움이 됩니다.

엉덩이 관련 태그는 뒷면 촬영을 선호합니다. 이를 보정하려면 낮은 강도의 ControlNet 포즈를 사용하거나, 네거티브에 "ass focus, from behind, looking back" 중 하나 이상을 추가하세요. 새로운 "ass visible from front" 태그도 도움이 됩니다.

...더 많은 팁은 태그 문서 참조

추가 정보

이 모델은 수개월간의 실패와 수많은 교훈(그 결과 v7이 나왔습니다!) 끝에 탄생했습니다. 향후 특정 태그를 개선하기 위해 몇 개의 이미지 분류기를 더 학습하고 싶지만, 지금은 모든 미래 계획이 중단되었습니다.

기존과 마찬가지로, 저는 제 모델을 통해 수익을 창출할 의도가 전혀 없습니다. 두툼함을 즐기세요!

-태그-

대규모 데이터셋의 태그 작업의 핵심은 모든 것을 자동화하는 것입니다. 저는 처음에 wd-tagger(또는 유사한 Danbooru 태거)를 사용해 원래 태그 위에 일반적인 태그를 추가했습니다. 나중에 e621 태거도 추가했지만, 일반적으로 전체 태그 목록이 아닌 제한된 태그 세트만 사용합니다(บาง 태그는 정확도가 낮음). 그 후, 가슴 크기, 가슴 형태, 오목/볼록 배꼽, 방향성, 움직임 선 등 약 20개 이상의 이미지 분류기를 학습시켜 자동으로 태그하게 했습니다. 이 분류기는 기존 태그를 개선할 뿐 아니라 데이터셋에 완전히 새로운 개념을 추가합니다. 마지막으로, 태그 문서에 설명된 대로 유사한 태그를 하나의 태그로 통합했습니다(이제는 하지 않습니다. 300만 장의 이미지에서는 크게 중요하지 않기 때문입니다).

즉, 특정 요소를 프롬프트하기 어려울 때마다 새로운 분류기를 만들었습니다. 지금까지 적용한 분류기 중 성능이 잘 나오지 않은 것은 이미지 내 작은 세부사항(예: 서명)을 분류하려는 분류기뿐입니다.

v9부터는 태그와 함께 약 10%의 캡션을 포함할 예정입니다. 이 캡션은 CogVLM으로 생성되었습니다.

이를 통해 이미지 분류기를 학습했습니다:

https://github.com/huggingface/transformers/tree/main/examples/pytorch/image-classification

이상적으로는 Danbooru 태거처럼 하나의 이미지에 다중 클래스를 분류하는 모델을 학습해야 하지만, 현재 단일 클래스-이미지 분류기로도 충분히 잘 작동합니다.

-소프트웨어/하드웨어-

학습은 Ubuntu에서 3090 GPU를 사용하여 수행되었습니다. 사용된 소프트웨어는 Kohya의 트레이너로, 현재 가장 많은 옵션을 제공하기 때문입니다.