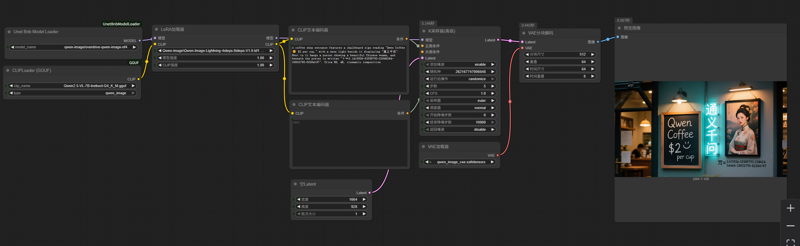

Qwen-image nf4 workflow (4-8steps, 16GB VRAM compatible)

세부 정보

파일 다운로드

모델 설명

이 워크플로우는 bnb 4비트 모델 로딩 플러그인을 사용하여 qwen-image 양자화 모델을 bnb nf4 형식으로 로드합니다.

누락된 플러그인은 ComfyUI Manager의 플러그인 관리 시스템에서 직접 설치하거나, "Unet Bnb Model Loader"를 검색하여 찾고 설치할 수 있습니다. 물론 수동으로 설치할 수도 있습니다.

사용된 모델: ovedrive/qwen-image-4bit · Hugging Face

이 모델은 분할(sharded) 모델이지만, 분할을 수동으로 병합할 필요는 없습니다. 단지 qwen-image-4bit와 같은 디렉토리에 분할 파일들을 모두 넣고, 그 디렉토리를 unet 디렉토리 안에 위치시키기만 하면 됩니다. 플러그인이 해당 분할 모델을 인식하고 로드합니다. 드롭다운 메뉴에서는 분할 모델이 속한 디렉토리 이름에 따라 표시됩니다.

다음 LoRA 가속 생성을 사용하세요: PJMixers-Images/lightx2v_Qwen-Image-Lightning-4step-8step-Merge · Hugging Face

다음 text_encoder를 사용하세요(GGUF 플러그인 필요): https://huggingface.co/unsloth/Qwen2.5-VL-7B-Instruct-GGUF/resolve/main/Qwen2.5-VL-7B-Instruct-Q4_K_M.gguf?download=true

이 전체 이미지 생성 프로세스는 GGUF 모델을 사용하는 것보다 약 2배 빠르며, 결과는 GGUF Q4와 유사합니다. 최대 메모리 사용량은 약 15GB이지만, 이미지를 반복 생성할 경우 약 14GB로 유지할 수 있습니다.

이미지 생성 속도는 약 1 it/s이며, 권장 스텝 수는 5-6입니다. 이 워크플로우는 BitsAndBytes 라이브러리에 의존하므로 NVIDIA 그래픽 카드 외에는 지원하지 않습니다.