Pusa

详情

下载文件

模型描述

Pusa 是适用于 Wan 2.2 的 LoRA 格式微调模型,可提升视频质量。

要求:Kijai WanWrapper 节点 https://github.com/kijai/ComfyUI-WanVideoWrapper

备注:截至 2025 年 9 月 3 日,ComfyUI 昨日刚更新了 Pusa 节点,现在使用起来应更简便一些。

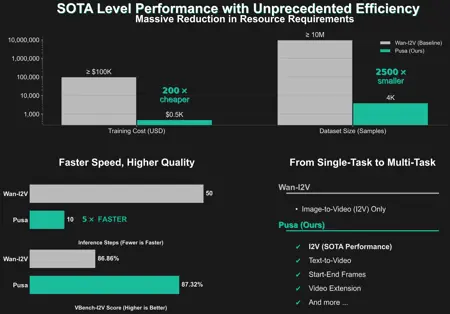

单个模型支持多种任务,全部支持使用 LightX2V 进行 4 步推理:图像到视频、起止帧、视频补全、视频扩展、文本到视频、视频转场等。

Wan 2.2 Pusa 的功能

视频生成任务:支持文本到视频、图像到视频(将静态图像转化为动态场景)、视频扩展、转场,甚至更复杂的任务,如将起始帧和结束帧无缝映射为完整视频。

多输入、多任务:与旧模型需为每个任务单独训练或使用不同模型不同,Wan 2.2 Pusa 独特的“Pusa 范式”使其能通过统一系统泛化到多种视频任务,仅需极少额外训练。

快速高效:得益于“LightX2V”加速技术和“向量化时间步自适应”(VTA),它仅需极少的推理步骤即可实现高质量输出,大幅降低视频生成所需的计算资源与时间。

工作原理

向量化时间步自适应(VTA):核心创新在于为每个视频帧使用多个“时间步”,使模型能够独立适应视频中各部分的运动与转场。这意味着视频各区域可拥有定制化运动,从而提升时间平滑性与创作控制力,同时不破坏基础视频模型原有的优势。

专家混合(MoE):Wan 2.2 使用两个专用子模型:一个处理“高噪声”(复杂运动),另一个处理“低噪声”(保留静态细节),融合二者优势以提升视频质量。

LoRA 微调:Pusa 模型采用轻量级“精准适配”技术(LoRA),在不覆盖基础模型原有能力的前提下,注入新功能(如图像到视频),在保留文本到视频能力的同时高效新增特性。

Wan 2.2 Pusa

https://github.com/Yaofang-Liu/Pusa-VidGen

https://huggingface.co/RaphaelLiu/Pusa-Wan2.2-V1

https://huggingface.co/Kijai/WanVideo_comfy/tree/main/Pusa

这些是 rank 256 的 LoRA,因此文件体积较大。这些 LoRA 旨在增强 Wan 2.2 的视频/图像质量。在本人实际使用中,效果通常较细微,但始终能提升视频质量。我不确定是否在 NSFW 数据上训练过,但它与 NSFW 内容兼容良好。

根据作者页面说明,建议使用 1.4–1.5 的权重。可配合 LightX2V 使用 4–8 步推理,或按常规步数使用。