Max quality QWEN Edit 2509 outputs, minimal workflow, and lots of info

세부 정보

파일 다운로드

모델 설명

중요:

여기서 처음이라면, qwedit_simple 워크플로우부터 시작하세요. 단일 이미지 워크플로우가 어떻게 작동하는지 익숙해질 때까지 다중 이미지 워크플로우는 사용하지 마세요.

업데이트

이 섹션은 버전 업데이트를 추적하기 위한 것입니다. 주 콘텐츠는 이 업데이트 섹션 바로 아래에 있습니다. 아직 주 콘텐츠는 업데이트하지 않았으며, 새로운 정보는 현재 이 업데이트 섹션에만 있습니다.

업데이트 2025-10-14: 다중 이미지 워크플로우

원래 게시물은 이 아래에 있습니다. 2개 이미지 및 3개 이미지용으로 두 가지 새로운 워크플로우를 추가했습니다. 가장 좋은 방법을 찾는 데 시간이 많이 걸렸고, 지난 주에는 실생활에서 매우 바빴기 때문에 오래 걸렸습니다. 하지만 여기 있습니다. 즐기세요!

이 업데이트 섹션에는 또한 새로운 lightning LoRA 등에 대한 추가 참고 사항도 포함되어 있습니다. 스포일러: 안 좋습니다 :(

-- 사용 참고사항 --

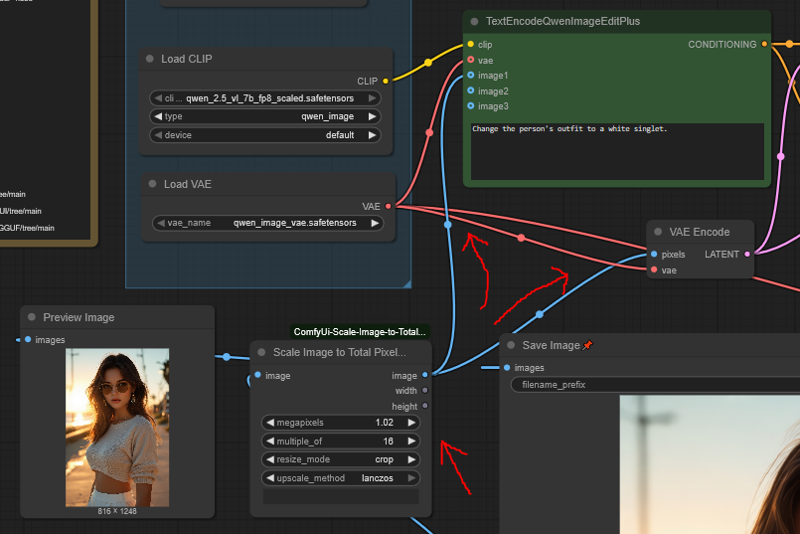

스파게티: 워크플로우 연결이 각 참조 이미지가 여러 노드와 다른 노드 간 교차 연결을 추가하기 때문에 스파게티처럼 복잡하게 보입니다. 여전히 간단하지만 더 이상 예쁘지 않습니다.

순서: 이미지를 입력할 때, 이미지 1은 오른쪽에 있습니다. 따라서 오른쪽에서 왼쪽으로 추가하세요. 또한 라벨이 붙어 있습니다.

올바른 워크플로우 사용: 추가 노드 때문에 2번째 또는 3번째 이미지를 제대로 우회하는 것이 불편합니다. 하나의 워크플로우로 모든 기능을 유연하게 처리하려고 하지 말고, 세 개의 워크플로우를 각각 별개로 사용하는 것이 좋습니다.

다중 이미지 생성은 매우 느립니다: 품질은 최대치이지만, 2-image 워크플로우는 1-image보다 3배, 3-image 워크플로우는 5배 더 오래 걸립니다.

이는 QWEN 편집에서 사용된 각 이미지가 시간에 1x 곱셈 인자로 추가되며, 이 워크플로우는 기술적으로 매번 2개의 새로운 이미지(참조 레이턴트 덕분에)를 추가하기 때문입니다.

참조 레이턴트 노드 없이 QWEN 편집을 사용하면, 다중 이미지 생성은 2배 및 3배 느려지지만, 품질이 흐릿해지므로 단점입니다.

이 문제는 오직 다중 이미지 워크플로우에만 해당하며, 단일 이미지용 qwedit_simple 워크플로우는 일반 Qwen 편집과 동일한 속도입니다.

스케일링: 참조 이미지는 엄격한 스케일링 요구사항이 없습니다. 더 크게 또는 작게 만들 수 있습니다. 더 크면 생성 시간이 길어지고, 작으면 빨라집니다.

- 주 이미지는 일반적으로 스케일링해야 하지만, 고급 사용자는 첫 번째 이미지를 원하는 대로 스케일링하고 k-샘플러에 수동 크기 출력 레이턴트를 입력할 수 있습니다(아래 "고급 품질"에서 설명).

옵션 "Consistence" LoRA 추가: 레딧의 u/Adventurous-Bit-5989가 이 LoRA를 제안했습니다.

링크: 여기, 워크플로우 내에서도 링크됨

이 LoRA는 미세한 세부 사항(예: 입술 텍스처와 같은 작은 얼굴 세부 사항)을 약간 더 잘 유지하는 것처럼 보입니다.

의상에 있는 로고 같은 임의의 특징이 새 의상으로 전이될 확률도 높아집니다.

그러나 종종 다른 부분의 품질을 무작위로 약간 저하시키기도 합니다. 예를 들어, LoRA를 사용하지 않았을 때보다 사람의 다리 모양을 정확히 전이하지 못할 수 있습니다.

또한 모델의 창의성을 줄입니다. 때로는 더 "흥미로운" 결과를 얻지 못할 수 있습니다.

따라서 약간의 트레이드오프입니다: 미세한 세부 사항을 원한다면 좋고, 그렇지 않다면 좋지 않습니다.

CivitAI 페이지의 지침을 따르되, 그들이 말하는 대로 그들의 워크플로우를 사용할 필요는 없습니다.

-- 기타 참고사항 --

새로운 2509 Lightning LoRA

평가: 나쁨(오늘 기준, 2025-10-14)

품질 측면에서 기존 LoRA들과 거의 동일함

일부 사용자는 오히려 더 나쁘다고 말함

기본적으로, 품질과 프롬프트 준수도가 낮아지기를 원하지 않는 한 사용하지 마세요.

"테스트"용으로도 유용하지 않습니다. 정상 모델과 비교해 절반은 완전히 다른 결과를 내기 때문입니다.

빠른 속도로 "테스트"하려면 이 워크플로우(LoRA 없음)를 10단계로 설정한 후, 품질을 회복하려면 다시 20단계로 돌리는 것을 추천합니다.

어떤 사용자들은 오프셋 문제를 해결했다고 주장합니다

해결했을 수도 있고, 안 했을 수도 있습니다. 그들은 어떤 예시나 증거도 제공하지 않았기 때문에 저도 모릅니다.

누군가 실제로 증명할 때까지, 해결되지 않았다고 간주하세요.

누군가 설득력 있게 문제를 해결하면 이 게시물과 제 레딧 게시물을 업데이트하겠습니다.

-- 업데이트 섹션 끝 --

이건 무엇인가요?

현재, 기본 버전에서 최고 품질의 2509 결과를 출력하는 워크플로우는 존재하지 않습니다. 이 워크플로우 구성은 공식 QWEN 챗 버전과 거의 동일한 결과를 제공합니다.

또한 다른 모든 워크플로우는 매우 복잡합니다. 이 워크플로우는 최소한의 설정으로 매우 간단합니다. 따라서 쉽게 시작할 수 있고, 확장하거나 더 복잡한 워크플로우에 추가하여 이점을 활용할 수 있습니다.

요약하면, 이 워크플로우는 두 가지를 제공합니다:

최고 품질의 2509 출력을 위한 구성, 원하는 곳에 복사 가능

불필요한 요소 없이 시작하기 위한 초간단 기본 워크플로우

아래에는 모델과 사용법에 대한 다양한 정보도 있습니다.

이 워크플로우에는 무엇이 포함되어 있나요?

최소 노드와 설정으로 구성된 작은 워크플로우

2509 모델에서 가능한 최대 품질 결과 제공 (제가 알고 있는 범위 내에서)

필요한 맞춤 노드는 하나: ComfyUi-Scale-Image-to-Total-Pixels-Advanced

- GGUF 버전 모델을 실행하려면 추가로 하나의 맞춤 노드가 필요합니다.

모델 다운로드 링크

필요한 모든 것들입니다. 이 링크들은 워크플로우 내에도 연결되어 있습니다.

QWEN Edit 2509 FP8 (22.5GB VRAM 필요):

저용량 VRAM용 GGUF 버전:

https://huggingface.co/QuantStack/Qwen-Image-Edit-2509-GGUF/tree/main

ComfyUI-GGUF 필요, "Unet Loader" 노드로 모델 로드

참고: GGUF는 FP8보다 느리고 품질이 낮습니다(단 Q8은 제외)

텍스트 인코더:

이에 대한 GGUF 버전 사용은 권장되지 않으며, 이상한 효과를 낼 수 있습니다.

VAE:

참조 이미지 링크

고양이: freepik

사이버펑크 바텐더 소녀: civitai

셔츠와 치마를 입은 임의의 소녀: 어디에도 업로드되지 않음, 예시로 생성함

빠른 사용법

ComfyUI를 최신 버전으로 업데이트했는지 확인하세요. QWEN 텍스트 인코더 노드는 2509 모델 출시 시 업데이트되었습니다.

원하는 이미지 크기를 입력하세요. 이미지 스케일링 노드가 자동으로 적절히 조정합니다.

1MP 이상의 이미지가 이상적입니다.

워크플로우의 이미지 스케일 노드를 사용해 이미지 크기를 줄이는 방향으로 설정하는 것이 좋습니다.

비율은 특별히 "정상적"일 필요 없습니다. 16:9 또는 9:16을 넘어서면 이상한 결과가 나오기 시작하지만, 그래도 작동할 때가 있습니다.

설정의 세부 사항을 건드리지 마세요. 이 설정은 의도적으로 이렇게 구성되었습니다.

참조 이미지 입력, 제로아웃, k-샘플러 설정 및 입력 이미지 리사이징이 중요합니다. 그대로 두세요.

k-샘플러 단계를 10으로 줄이면 빠르게 생성, 30으로 늘리면 더 느리지만 품질이 높아집니다.

낮은 VRAM을 위해 GGUF 버전을 사용할 수 있습니다. ComfyUI-GGUF 맞춤 노드를 설치하고 "UnetLoader" 노드로 모델을 로드하세요.

- 이 워크플로우는 기본적으로 22.5GB VRAM이 필요한 FP8을 사용합니다.

Lightning LoRA는 절대 사용하지 마세요. 2509에겐 정말 열악합니다.

기술적으로는 작동하긴 하지만, 2509 모델이 제공하는 대부분의 개선점을 제거합니다. 즉, 진짜로 2509 모델을 사용하는 것이 아닙니다.

예: 2509는 NSFW 콘텐츠를 잘 생성하지만, Lightning LoRA는 거의 불가능합니다.

예: 2509에 "옷을 모두 벗겨라"고 하면 즉시 수행하지만, Lightning LoRA는 "오, 그건 진짜 어렵겠네요"라고 합니다.

또 다른 예: 2509는 프롬프트 준수도가 매우 뛰어나지만, Lightning LoRA는 이를 망가뜨리므로 더 많은 생성을 반복해야 합니다.

이 워크플로우는 1개의 참조 이미지만 입력받지만, 더 추가할 수 있습니다. 체인에 ReferenceLatent 노드를 추가하고, 다른 ScaleImageToPixelsAdv 노드를 연결해서 동일하게 설정하세요.

저는 총 2개의 참조 이미지로만 테스트했지만, 잘 작동했습니다.

2개 이상에서 문제가 생기면 알려주세요.

필요하다면 더 많은 참조 이미지를 연결한 워크플로우를 제공할 수 있습니다.

출력 이미지 크기는 원하는 대로 설정할 수 있습니다. k-샘플러에 원하는 크기의 빈 레이턴트를 입력하세요.

새로운 이미지를 생성할 때(예: k-샘플러에 특정 크기 입력, 또는 여러 참조 이미지 입력) 참조 이미지를 1MP 이상으로 크게 해도 됩니다. 결과 품질이 향상됩니다.

세심하다면, 사람의 2MP 이미지를 입력하면 얼굴 전이 시 더 높은 정밀도를 얻을 수 있습니다.

네, 실제로 작동합니다.

유일한 단점은 참조 이미지 크기에 비례해 모델 실행 시간이 길어진다는 점입니다. 따라서 1.5MP~2MP 정도까지로 제한하는 것이 좋습니다(이 이상으로는 품질 향상이 없습니다).

자세한 내용은 아래 "고급 품질"을 참고하세요.

NSFW에 관해

많이 묻는 질문이므로 간략히 설명합니다. 이 섹션은 본문의 핵심이 아니므로 짧게 쓰겠습니다.

2509는 프롬프트 준수도가 매우 뛰어나고, 윤리적 제약을 전혀 고려하지 않습니다. 요청한 대로 무엇이든 생성하지만, 모든 것을 학습한 것은 아닙니다.

생식기 그리는 법을 모릅니다. 따라서 흐릿한 얼룩이나 켄 인형처럼 나옵니다.

- 그러나 유사한 각도의 참조 이미지를 제공하면 그려낼 수 있습니다. 아래는 신체 노출 참조 이미지를 사용해 생성한 새 이미지 예시입니다(NSFW): https://files.catbox.moe/lvq78n.png

유방은 매우 잘 그립니다(젖꼭지도). 단, 원본 이미지에서 커버되지 않은 상태에서는 크기를 일관되게 유지하지 못할 수 있습니다. 운이 좋으면 잘 나올 수도 있죠.

옷을 입은 상태에서는 유방 크기를 일관되게 유지합니다. 따라서 일관성을 원한다면 비키니 상태로 시작하세요.

브라나 스타킹 같은 라이너리 제품의 정확한 개념은 모르지만, 대신 일반 속옷을 그려서 시간을 낭비하지 않으려고 합니다.

이 모델은 더 복잡한 편집을 위한 최적의 시작점입니다. 일반 모델로 고통스럽게 편집할 필요 없이, 2509로 원하는 복장 상태까지 간단히 바꾼 후, 일반 모델로 세부 사항을 추가하면 됩니다. 빠르게 콘텐츠를 편집하거나 옷을 입혀보는 인형을 만드는 데 매우 편리합니다.

95% 확률로 작동하는 유용한 프롬프트

전부 벗기기 – 다른 모델로 세부 편집을 시작하거나 옷을 모델링할 때 최소한의 상태로 사용하기 좋습니다.

Remove all of the person's clothing. Make it so the person is wearing nothing.

속옷만 남기기(가능한 한 작게).

Change the person's outfit to a lingerie thong and no bra.

비키니 – 모든 신체 비율을 유지하면서 최대한 옷을 벗기는 데 가장 적합합니다. 옷을 입히는 인형으로 만드는 데 완벽합니다.

Change the person's outfit to a thong bikini.

이 프롬프트로 생성된 결과:

🚨NSFW 링크🚨 https://ibb.co/V005M1BP 🚨NSFW 링크🚨

외부 링크 없이도 예시 이미지에 업로드해 보려 합니다만, 여러 프롬프트를 사용했기 때문에(양성 프롬프트에 "various" 포함) 문제가 될지 모르겠습니다.

또한 말할 필요도 없지만, 실제 사람의 사진에 동의 없이 개입하지 마세요. 일반적인 확산 모델로도 이미 그렇게 어렵지 않지만, QWEN이나 Nano Banana 같은 도구들은 진입 장벽을 크게 낮췄습니다. 이는 큰 문제로 번질 것이며, 스스로 그 일에 관여하지 않는 것이 최선입니다.

QWEN Edit에 대한 전체 설명 및 자주 묻는 질문

아무리 설명해도 완전히 설명할 수 없는 이유로, 이 특정 구성은 가장 높은 품질의 결과를 제공하며, 그 차이가 매우 명확합니다. 일부는 설명할 수 있고, 아래에서 설명하겠습니다. 이 문서에서 이후로 QWEN Edit 2509를 'Qwedit'라고 부르겠습니다.

참조 이미지 및 Qwen 텍스트 인코더 노드

Comfy에 포함된 TextEncodeQwenImageEditPlus 노드는 최악의 방식으로 이미지를 무작정 리사이징하기 때문에 품질이 매우 떨어집니다.

그러나 이 노드를 사용해야 합니다. 완전히 우회하는 것(가능함)은 평균적인 품질의 결과만을 가져옵니다.

ReferenceLatent 노드를 사용하면 Qwedit에 참조 이미지를 두 번 제공할 수 있으며, 두 번째는 비어 있지 않은 적절한 스케일로 전달됩니다.

그런 다음 원래 조건부를 제로로 설정하고, 그 제로값을 ksampler의 네거티브에 입력함으로써, Comfy 노드가 만든 나쁜 스케일링된 이미지를 사용하지 않도록 유도하고, 대신 우리 측에서 훨씬 나은 스케일링된 버전을 사용하도록 합니다.

참고: 진짜 텍스트 인코더에서 나온 조건부를 반드시 제로 입력에 전달해야 합니다.

마치 모든 것을 "제로"로 만드는 것처럼 들리지만, 사실 ksampler에 여전히 많은 정보를 전달합니다.

따라서 제로 입력에 임의의 쓰레기를 넣지 마세요. 반드시 Qwen 텍스트 인코더 노드에서 나온 조건부를 입력해야 합니다.

이 과정이 이 워크플로가 우수한 결과를 내는 데 80%의 핵심입니다. 무엇을 복사하든 이 부분은 꼭 복사하세요.

이미지 리사이징

이 부분에는 유일하게 필요한 커스텀 노드가 등장합니다.

대부분의 워크플로는 ScaleImageToPixels 노드를 사용하는데, 이는 존재하는 가장 나쁜 노드 중 하나이며, ComfyUI에서 삭제되어야 합니다.

이 노드는 모든 이미지를 1MPx로 무작정 리사이징하며, 모든 확산 모델이 2, 4, 8, 또는 16의 배수로 작동한다는 사실을 전혀 고려하지 않습니다.

이미지를 1177x891 크기로 스케일링? 응, 잘 됐네, 내 Stable Diffusion 모델에 딱 좋아.

여기서 ScaleImageToPixelsAdv 노드가登場합니다.

이 강력한 노드는 이미지를 원하는 픽셀 수로 스케일링할 뿐만 아니라, 지정한 수로 나누어떨어지도록 조정해줍니다.

1MPx로 스케일링하는 것이 전부가 아닙니다. 워크플로가 실제로 1.02MPx로 설정되어 있는 것을 보실 수 있습니다.

그 이유는 TextEncodeQwenImageEditPlus 노드가 위에서 언급한 나쁜 방법으로 이미지를 두 번째로 다시 스케일링하기 때문입니다.

따라서 먼저 1.02MPx로 스케일링하면, 이 과정이 업스케일링이 아니라 다운스케일링이 되도록 강제하여 결과의 흐릿함을 크게 줄입니다.

게다가 ScaleImageToPixelsAdv는 내림 반올림을 하기 때문에, 이미지가 16으로 나누어떨어지지 않으면 1MPx보다 약간 작아집니다. 1.02로 설정하면 노드가 원하는 실제 1MPx에 훨씬 더 가깝게 됩니다.

Qwedit는 약 0.5MPx에서 1.1MPx 사이의 이미지까지 안정적으로 처리할 수 있으므로, ksampler에 1MPx보다 약간 큰 이미지를 입력해도 괜찮습니다.

16의 배수로 스케일링하는 것이 가장 좋은 결과를 줍니다. 112나 56 같은 다른 숫자를 주장하는 사람들은 무시하세요(아래에 설명).

"스트레치"보다 "크롭"을 사용하세요. 이미지 왜곡을 줄일 수 있고, 이미지에서 10픽셀 정도를 줄여도 품질을 높이는 데 가치가 있습니다.

이미지 오프셋 문제 - 아니요, 이 문제는 해결할 수 없습니다. 해결할 수 있다고 말하는 사람은 거짓말을 합니다

오프셋 문제는 편집된 버전에서 이미지의 객체가 원래 위치에서 약간(또는 많이) 이동하는 현상입니다.

이 워크플로는 오프셋 문제를 가장 적게 발생시킵니다.

- 예, "112나 56의 배수" 같은 다른 임의의 해결책보다도 더 낮습니다.

"112 또는 56의 배수"라는 방법은 다음과 같은 이유로 작동하지 않습니다:

- 이건 문제의 전부 원인이 아닙니다. Qwedit 모델은 그냥 무작위로 오프셋을 발생시키며, 이를 통제할 수 없습니다.

- 모델 구조상, 이미지를 112의 배수로 만들었더라도 의미가 없습니다. 1MPx 크기에 112의 배수를 맞추는 것은 불가능하며, 결국 이미지는 112의 배수가 아닌 크기로 리사이징되고 말기 때문입니다.

진지하게, 이 문제는 해결할 수 없습니다. 단지 발생 확률을 줄일 수 있을 뿐이며, 이 워크플로는 가능한 한 최대한 그 확률을 줄입니다.

이 워크플로가 실제로 오프셋 문제를 어떻게 줄이나요?

문제의 90%는 이미지 리사이징에서 비롯됩니다.

1.02MPx로 스케일링하고 16의 배수로 맞추면, Qwedit가 실제로 원하는 해상도에 가장 가까워집니다.

믿지 않으신다면 공식 Qwen 챗에 다양한 비율의 이미지를 넣어보세요.

편집된 이미지를 돌려받으면, 그 결과가 16의 배수인 1MPx로 스케일링된 것을 확인하실 수 있습니다. 이는 바로 ScaleImageToPixelsAdv 노드가 하는 방식입니다.

따라서 Qwedit에 이상적인 이미지 크기는: 1248x832, 832x1248, 1024x1024 입니다.

비정사각형 이미지의 경우, 일반적인 Stable Diffusion 크기보다 약간 더 길다는 점에 주목하세요.

- 하지만 걱정할 필요 없습니다. 이 워크플로는 적절한 화면비율이라면 모두 잘 작동합니다.

나머지 10%는 Qwedit 자체의 이상한 문제인데, 지금까지 아무도 해결하지 못했습니다.

심지어 완벽한 1024x1024 이미지에서도 이런 일이 발생합니다. 따라서 누군가 "이 문제를 해결했다"고 말하면, 법적으로 그 사람을 때려도 괜찮습니다.

입력한 프롬프트도 이 문제에 영향을 미치므로, 문제가 발생하면 프롬프트를 약간 바꿔보세요. 도움이 될 수 있습니다.

라이트닝 LoRA, 왜 안 쓰나요?

간단히 말해, 라이트닝 LoRA를 사용하면 출력 품질이 Qwedit 첫 버전으로 떨어지고, 2509의 모든 장점은 놓치게 됩니다.

2509에 비해 프롬프트를 잘 따르지 못합니다.

NSFW 콘텐츠 처리에 어려움이 있습니다.

그림을 더 못 그립니다.

비정상적인 화면비율일 때 자주 실패합니다.

더 적은 개념을 이해합니다.

빠른 생성이 필요하면, 20단계 대신 10단계만 사용하세요.

그림이 아닌 부분(예: 얼굴)은 여전히 잘 보이지만, 그려진 부분은 세부적인 품질이 낮아집니다.

그래도 그리 나쁘지 않으므로, 정말 속도가 급할 경우 10단계도 괜찮습니다.

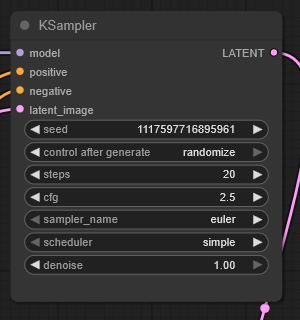

Ksampler 설정은?

왜 그런지 전혀 모르겠지만, 누군가의 워크플로에서 CFG 2.5와 20단계를 사용했고, 그것이 바로 작동했습니다.

CFG 4.0과 40단계도 가능하지만, 더 나아진 것 같지 않아 굳이 쓸 이유가 없습니다.

CFG 2.0 또는 3.0 같은 다른 값은 항상 결과를 나쁘게 만듭니다. 왜 그런지 모르겠지만 매우 민감합니다.

그냥 CFG 2.5를 사용하세요. 바꾸려는 노력은 고통스러울 뿐입니다.

더 빠른 생성을 위해 10단계를 사용할 수 있습니다. 얼굴이나 변하지 않는 부분은 완벽하게 보이지만, 그려진 부분(예: 가죽 자켓 등)은 세부사항이 덜 나옵니다.

그래도 그리 나쁘지 않으므로, 속도가 급하면 10단계도 괜찮습니다.

30단계에서는 20단계보다 세부사항이 향상되지만, 그 차이가 매우 미미하여 가치가 없습니다.

반드시 30단계 이상은 사용하지 마세요. 그 이상부터는 이미지 품질이 악화되기 시작합니다.

더 많은 참조 이미지?

이 워크플로는 단순함을 위해 하나만 사용하지만, 더 추가할 수 있습니다.

다른 ReferenceLatent 노드와 이미지 스케일러 노드를 추가하세요.

첫 번째 ReferenceLatent 바로 뒤에 두 번째 ReferenceLatent를 순차적으로 연결하고, 두 번째 이미지를 이를 통해 연결하세요(리사이저를 거친 후).

두 개의 이미지로 테스트해보았고, 잘 작동했습니다. 세 개는 시도해보지 않았습니다.

중요: 참조 이미지는 반드시 1MPx일 필요 없습니다. 만약 멋있게 하고 싶다면, 1.5 또는 2MPx 이미지를 참조로 입력하고, ksampler에는 1MPx 레이턴트만 제공하면, 훨씬 더 높은 품질의 결과를 얻을 수 있습니다.

예: 얼굴 전달 시 더 많은 디테일이 나타납니다.

단, 2MPx 이미지는 처리 속도가 훨씬 느립니다.

이 원리는 단일 이미지 입력에도 적용됩니다. ksampler에는 1MPx 레이턴트만 제공하면 됩니다.

고급 품질

참조 이미지에 대한 설명이 의미하는 것은...?

네! 2MPx 이미지를 16의 배수로 정확히 1MPx로 다운스케일링하여(사전 다운스케일링 없이) 입력하고, ksampler에는 정확한 1MPx 레이턴트를 제공하면, 2MPx 이미지를 직접 1MPx로 편집할 수 있습니다.

이는 훨씬 뚜렷한 품질 향상을 가져옵니다!

설정이 귀찮지만, 작동한다는 것이 멋집니다.

방법:

1MPx로 다운스케일링된 버전은 텍스트 인코더 노드에 입력하세요.

2MPx 버전은 ReferenceLatent에 입력하세요.

ksampler에는 정확히 1:1 비율이고 16의 배수인 1MPx 이미지를 입력하세요.

그러면 그냥 작동합니다™

Qwedit는 어떤 이미지 크기를 처리할 수 있나요?

1MPx 이하는 문제없습니다.

하지만 여전히 1MPx로 확장하는 것을 추천합니다. 프롬프트 준수와 흐릿함을 줄이는 데 도움이 됩니다.

1MPx 초과로 가면 Qwedit가 점차 이미지를 '딥 프라이'합니다.

프롬프트 준수도 떨어지고, 객체를 복제하여 이미지를 왜곡하는 경우가 많습니다.

그 외에는 실제로 작동합니다.

따라서 1MPx 이상을 사용하는 욕구는, 당신이 이미지를 얼마나 '딥 프라이'할 용의가 있고, 몇 번이나 재시도할 용의가 있는지에 비례합니다.

1.5메가픽셀(예: 1254x1254)까지는 이미지 품질이 심각하게 저하되지 않습니다. 여전히 눈에 띄지만, 목적이 따라 '수용 가능'할 수 있습니다.

- 그러나 몇 번의 생성을 반복해야 할 것입니다. 다른 방식으로도 실패할 수 있습니다.

2MPx 이상을 사용하면 심각한 딥 프라이가 발생하며, 이미지에 객체가 중복되어 왜곡됩니다.

하지만 상황에 따라 여전히 괜찮을 수 있습니다.

다음은 바텐더 여자 아이의 1760x1760(3MPx) 편집 결과입니다: https://files.catbox.moe/m00gqb.png

여기서 보면 대체로 괜찮아 보입니다. 장면이 어두워 딥 프라이가 눈에 띄지 않았습니다. 그러나 그녀의 손이 병 위에 이상하게 중복되어 있고, 얼굴을 확대하면 디테일이 왜곡된 것을 확인할 수 있습니다. 또한 양팔이 로봇처럼 유지되지 않았습니다. 상황에 따라 다르므로, 말씀드렸듯이 1MPx 이상은 권장하지 않습니다.