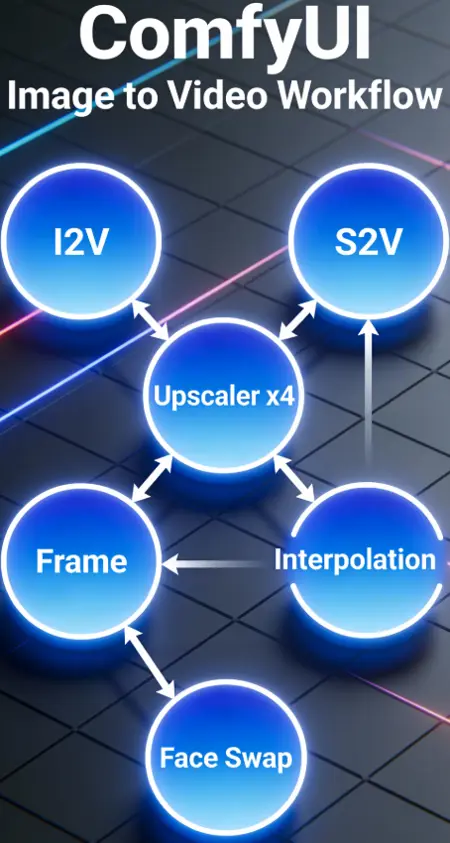

Wan2.2 AIO Workflow (I2V - S2V - Upscaler - Frame Interpolation - Faceswap)

详情

下载文件

模型描述

首先,所有功劳归于 thesharque588 对此 工作流 的基础贡献!

面向长视频、场景控制与自动化的全能工作流

我希望您能对这个工作流保持宽容(我从零开始独自在八月学习 ComfyUI)!

这个工作流的目标是将我所需的所有功能集中到一处,并能将它们串联起来。我认为它已经足够完善,值得分享。

此工作流包含:

- 通过索引控制场景

- 为每个索引单独设置持续时间

- 自动提示翻译

- 色彩匹配

- 人脸替换(ReActor 人脸替换)

- 帧插值(RIFE-VIF)

- S2V 结合 MMAudio(无需外部音频源)

- 2x 至 4x 超分辨率(Upscaler Tensorrt(x4) + 视频超分辨率(x2))

- 通过独立运行组来分组控制

此工作流如何运作?

第一要点!您必须使用“GroupExecutor”节点来运行各组,这样只会启动所选的组。此设计旨在让所有组保持激活状态,而无需加载备用组的模型。如果您使用 ComfyUI 中的“Execute”按钮运行生成,它将在 I2V 生成开始时并行加载 MMAudio 模型,从而导致可用于 I2V 的显存减少。有时,“GroupExecutor”节点会停止工作(我仍在寻找原因),只需用一个新的节点或工作流中的其他节点替换即可。

每个处理部分被划分为四个组:图像转视频、声音转视频、超分辨率、转至 72 FPS(帧插值)。

I2V

步骤 1:I2V 增强 - 选择您希望为视频添加的增强效果。

通过“选择源图像”选择 0 或 1 来选择源图像:

0 = 加载单张图像

1 = 从文件夹加载图像并处理设定数量的图像(适用于离线运行,工作流将循环并每次生成后使用文件夹中下一张图像继续 - 别忘了设置您的文件夹路径)。仍需改进,正在处理中。

步骤 2:准备 - 设置视频参数

在这里设置批次大小和总步数(每个索引为 1 步,若您设置步数为 3,则会使用索引 0 到 2,共 3 个索引)。

将图像调整至最大尺寸(每次不使用相同分辨率的图像,因此这是为自动化设计的;若您需要更多控制,可自由修改节点)。

使用滑块为每个索引单独选择持续时间(滑块默认与 WanImageToVideo 相同,以 4 帧递增,可通过连接另一个 INT 值节点更改,但需连接到负提示框后隐藏的 Any Switch Index)。

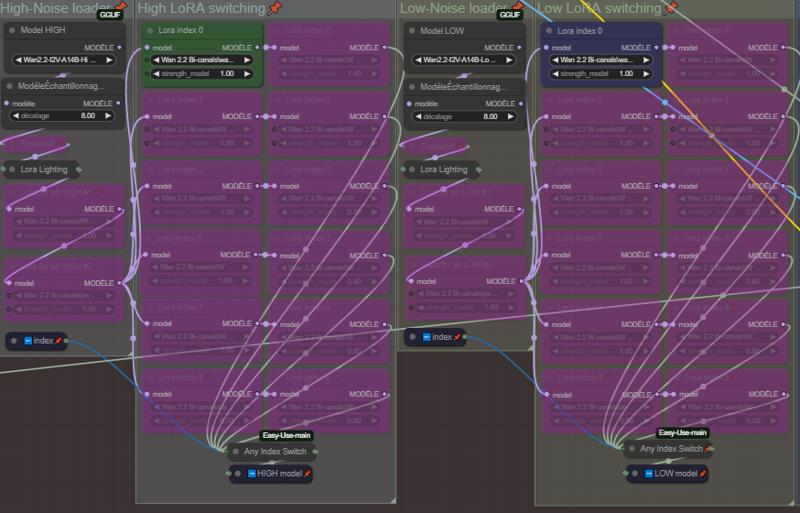

步骤 3:加载器 - 设置模型和 LoRAs

在“高噪声”和“低噪声”中选择您的模型(GGUFs)、Lightning LoRAs 和 FusionX LoRAs(Lightning 和 FusionX LoRAs 非必需,如不使用请停用相关节点)。

“高噪声加载器”和“低噪声加载器”组中的 LoRAs 为应用于每个索引的通用 LoRAs。

为每个索引选择 LoRAs。此部分默认设置为 5 个索引(从索引 0 开始,可自由增删。若添加,请将其连接至各列下方的 AnySwitchIndex)。

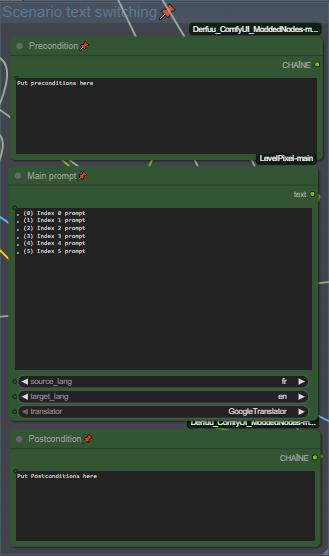

步骤 4:提示词 - 设置您的场景

🚨🚨🚨🚨 如果您不擅长英语,提示词内置翻译功能 🚨🚨🚨🚨

设置每个索引的前置与后置条件,并为每个索引编写提示词。索引间通过换行分隔,我使用 ", (0)", ", (1)" 来更好地观察我的场景(还有其他多种方式,如需更改,可修改组节点后隐藏的分隔方式)。

🚨🚨 别忘了设置翻译的源语言和目标语言 🚨🚨

步骤 5:人脸替换 - 设置人脸替换参数

Wan2.2 以存在大量导致人脸漂移/变化的 LoRAs 而闻名,因此我添加了 ReActor 人脸替换来补偿某些 LoRA 的人脸漂移。当前设置效果良好,但您可自由调整以进行实验。(可在 ComfyUI Manager 中获取,模型将自动下载)

选择人脸替换的源图像:

0 = 加载源图像

1 = 使用起始图像作为源

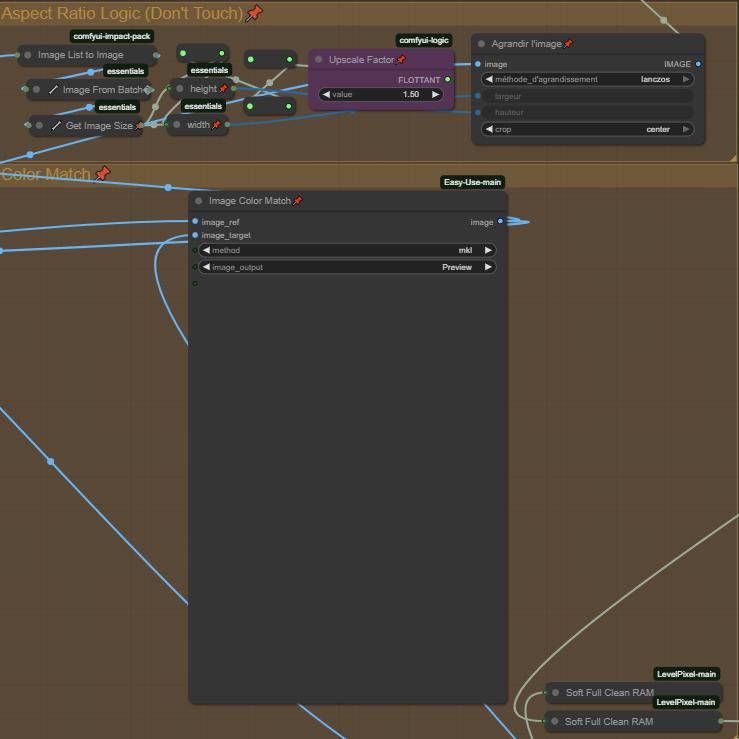

步骤 6:宽高比逻辑 + 色彩匹配

宽高比逻辑是一个简单的逻辑缩放,用于略微改善视频效果,调整“超分辨率因子”可改变缩放比例。

图像色彩匹配旨在保留源图像的色彩并进行匹配,无法禁用,即使您绕过它,也不会向下一节点传递任何内容。若您遇到色彩问题,可更改“方法”或删除该节点。此问题将在未来更新中修复。

(重要)

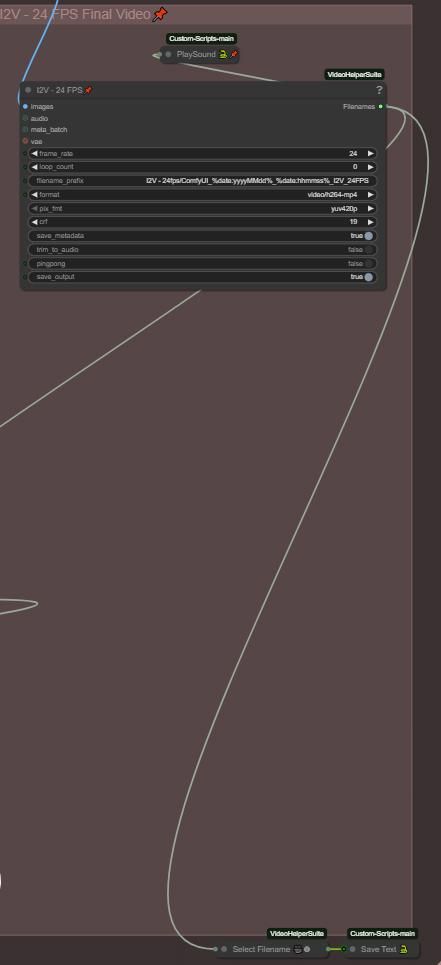

步骤 7:最终视频与链式功能

每个最终视频的文件夹路径均保存在文本文件中(“保存文本”节点),目的是实现链式生成:完成 I2V 后,您可加载文本文件中保存的最后一个生成视频的文件名,并由下一组在启动时自动加载。如需更改文本文件名,请确保其与“保存文本”和“加载文本”节点中的其他文件名一致!

最终视频默认设置为 24 FPS,以与 MMAudio 兼容(MMAudio 在 24 FPS 下训练)。若您不打算为视频生成音频,可将其降至 16 FPS。

您还拥有一个“播放声音”节点,用于在工作流完成生成时发出提示音。非必需,如不需要可删除。

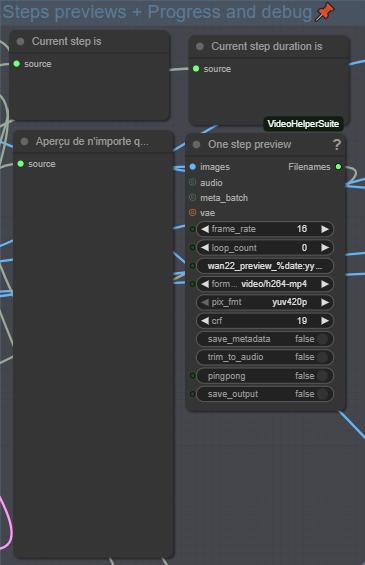

步骤 8:监控与调试

此部分将显示当前正在处理的索引、其总帧数、提示词及每个索引的预览。这有助于您监控生成过程并进行必要调整。

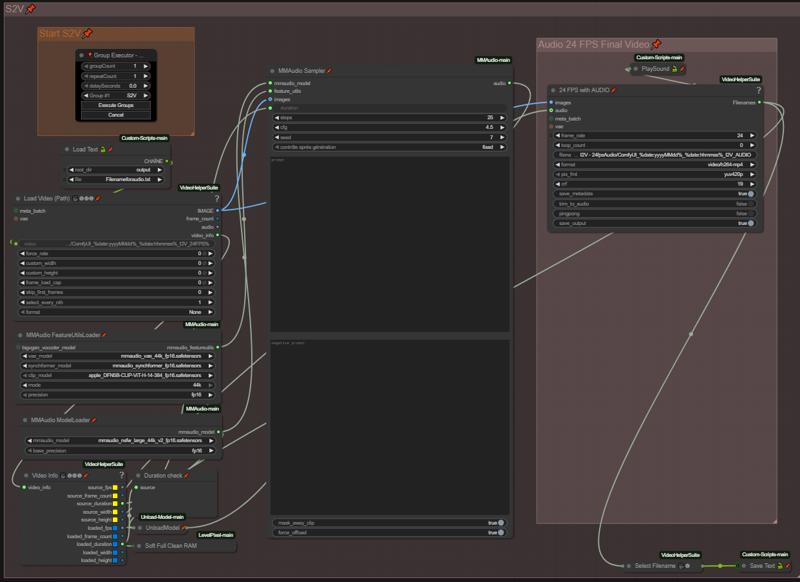

S2V

在这里输入您的音频提示词,我建议使用 NSFW MMAudio,其效果远优于基础模型。所有步骤均已自动化,当您完成正向与负向提示词后,只需运行该组即可。它将自动通过“加载文本”节点加载上一个 I2V 生成的视频,并为其添加音频。

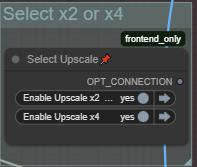

超分辨率 x2-x4

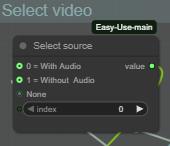

步骤 1:选择您的源视频(带或不带音频)

此处仅需选择是超分辨率来自 MMAudio 组的带音频视频,还是来自 I2V 组的无音频视频。

此处选择正在运行的超分辨率组。

注意:

x2 超分辨率比 x4 慢得多,因为它未使用 TensorRT。若您有更好的 x2 快速超分辨率方案,请随时提出建议。

x4 超分辨率使用 TensorRT,若您已在 .\models\upscale_models 中有超分辨率模型,它们将被自动导入。仅支持 x4 超分辨率;我曾尝试导入并转换 x2 模型,但失败了。

别忘了根据需要调整超分辨率参数,并使用“GroupExecutor”节点运行该组。

帧插值(转至 72 FPS)

逻辑与上一组相同。

步骤 1:选择您的源视频(是否带超分辨率或音频)

根据上一个生成组选择:

0 = 无超分辨率(加载 MMAudio 24 FPS 音频视频)

1 = 有超分辨率(加载超分辨率后的视频)

2 = 无音频 & 无超分辨率(加载 I2V 组的视频)

步骤 2:调整

最终视频设置为 72 FPS 仅用于在使用音频组时保持音画同步。若您未使用音频组,可根据需要降至 60 FPS。

与上一组相同,别忘了根据需要调整插值器参数。

资源

自定义节点应可通过 ComfyUI Manager 自动找到,若缺少某些节点,请告知我。

我在配备 RTX 5080 16GB 显存和 64GB 内存的设备上使用此工作流。

GGUF 模型和 VAE:

https://huggingface.co/QuantStack/Wan2.2-T2V-A14B-GGUF/tree/main

NSFW ClipVision:

https://huggingface.co/ricecake/wan21NSFWClipVisionH_v10/tree/main

Umt5 xxl 编码器 GGUF:

https://huggingface.co/city96/umt5-xxl-encoder-gguf/tree/main

NSFW MMAudio:

https://huggingface.co/phazei/NSFW_MMaudio(下载后重命名为 "mmaudio_nsfw_large_44k_v2_fp16.safetensors")

Lightx2v LoRAs:

https://huggingface.co/lightx2v/Wan2.2-Lightning/tree/main/Wan2.2-I2V-A14B-4steps-lora-rank64-Seko-V1

https://huggingface.co/lightx2v/Wan2.2-Lightning/tree/main/Wan2.2-T2V-A14B-4steps-lora-250928

FusionX LoRA:

https://huggingface.co/vrgamedevgirl84/Wan14BT2VFusioniX/tree/main/FusionX_LoRa

此工作流持续优化中,未来有望推出 V2 版本。若我遗漏了什么,请告诉我,我会补充。如有任何问题,欢迎随时提问(请使用我个人资料中的 Discord 链接,对大家来说更方便)。

_感谢您使用此 ComfyUI 工作流。请负责任且尊重地使用。

本工作流专为创意、技术与个人实验而创建,绝非用于伤害、骚扰或任何形式的滥用。_