aimaginedworlds: Z-Image Turbo LoRA Guide (Best Version)

세부 정보

파일 다운로드

모델 설명

최고의 결과: V1 어댑터 학습

스타일: 애니메이션 / 일러스트레이션

트리거 단어: aimaginedworlds

베이스 모델: Tongyi-MAI/Z-Image-Turbo

📖 내 이야기: "완벽한" LoRA를 향한 여정

저는 단순히 최종 결과물이 아니라, 전체 여정을 공유하고자 합니다. 투명성이 커뮤니티의 학습에 도움이 된다고 믿기 때문입니다.

🚫 시도 1: 1000장 이미지 데이터셋 + V2 어댑터

저는 큰 규모로 시작했습니다. 더 많은 데이터 = 더 나은 결과라고 생각해, 1000장의 이미지를 수집하고 최신 어댑터를 사용했습니다:

결과: 완전한 실패. LoRA는 애니메이션 스타일을 전혀 포착하지 못했습니다. 출력물은 일반적이고, 학습 데이터에서의 개성은 전혀 없었습니다.

⚠️ 시도 2: 엄선된 100장 이상 이미지 데이터셋 + V2 어댑터

저는 품질이 양보다 중요하다는 것을 깨달았습니다. 자세한 캡션을 가진 약 118장의 고품질 애니메이션 이미지로 작은 데이터셋을 엄선했습니다.

- 결과: 더 나아졌지만, 아직 뛰어나진 않았습니다. V2 어댑터는 강력한 스타일 전이에 어려움을 겪는 것 같았습니다. 출력물은 "괜찮았지만", 제가 원하던 인상적인 애니메이션 미학은 아니었습니다.

🔄 시도 3: Z-Image-De-Turbo 사용

완전히 방향을 바꿨습니다. 터보가 아닌 기본 모델에서 학습하면 더 많은 제어가 가능할 것이라 생각했습니다:

결과: 별로 좋지 않았습니다. 기술적으로는 가능했지만, 제가 원하던 생동감 있고 스타일리시한 애니메이션 룩을 만들어내지 못했습니다. "평평해 보였습니다."

✅ 시도 4: V1 어댑터 – 승자!

좌절한 나머지, 원래의 V1 어댑터로 돌아갔습니다. 그리고 뭐가 나왔을까요?

어댑터:

ostris/zimage_turbo_training_adapter_v1.safetensors데이터셋: 엄선한 118장의 애니메이션 이미지

결과: 놀라웠습니다! 이것이 돌파구였습니다. V1 어댑터에 적절한 설정을 결합하니, 애니메이션 스타일을 아름답게 포착했습니다. 빠른 추론, 강력한 스타일, 일관된 품질.

가끔, "오래된" 버전이 더 잘 작동합니다.

💸 진짜 비용: 이 학습이 저에게 든 비용

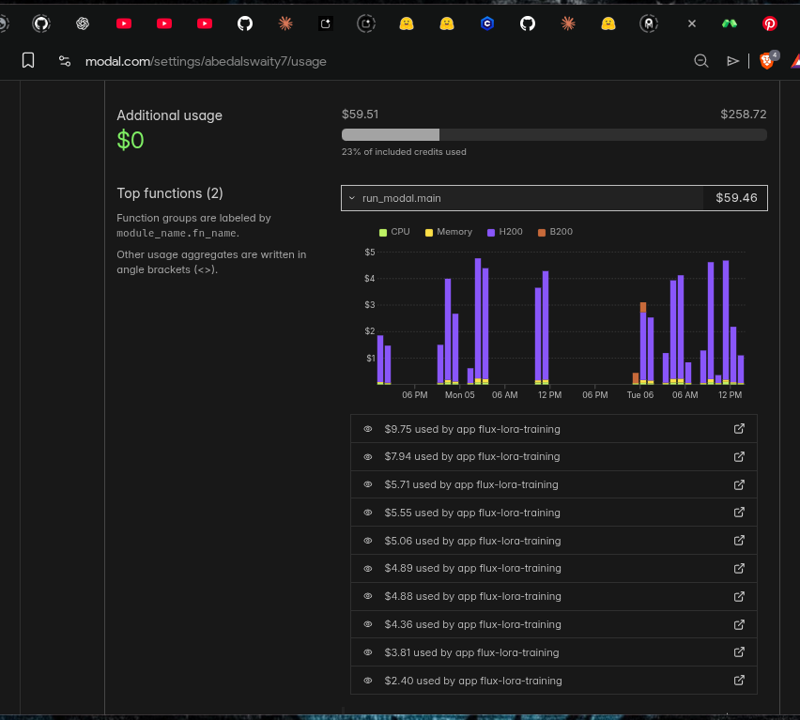

LoRA 학습은 무료가 아닙니다. 이 결과를 얻기 위해 Modal 클라우드 컴퓨팅에 제가 지출한 비용을 정직하게 정리해 드립니다:

사용된 GPU: NVIDIA H200

총 학습 횟수: 10회 이상

총 비용: 약 $60

투자한 시간: 여러 날의 실험...

이것은 $60과 수많은 시간의 디버깅, 다양한 어댑터 테스트, 하이퍼파라미터 조정, 학습 작업 완료 대기의 결과입니다. 완벽한 조합을 찾기 위한 과정이었습니다.

⚙️ 승리한 설정

아래는 최고의 결과를 만들어낸 정확한 설정입니다. 자신의 학습을 시작할 때 이 설정을 기준으로 사용하세요!

job: "extension"

config:

name: "aimaginedworlds_turbo"

process:

- type: "diffusion_trainer"

training_folder: "/root/ai-toolkit/modal_output"

device: "cuda"

trigger_word: "aimaginedworlds"

network:

type: "lora"

linear: 32

linear_alpha: 32

conv: 16

conv_alpha: 16

save:

dtype: "bf16"

save_every: 250

max_step_saves_to_keep: 4

datasets:

- folder_path: "/root/ai-toolkit/training_data/aimaginedworlds"

caption_ext: "txt"

caption_dropout_rate: 0.05

resolution:

- 512

- 768

- 1024

train:

batch_size: 1

steps: 5000

gradient_checkpointing: true

noise_scheduler: "flowmatch"

optimizer: "adamw8bit"

lr: 0.0001

dtype: "bf16"

model:

name_or_path: "Tongyi-MAI/Z-Image-Turbo"

arch: "zimage:turbo"

assistant_lora_path: "ostris/zimage_turbo_training_adapter/zimage_turbo_training_adapter_v1.safetensors"

sample:

sampler: "flowmatch"

sample_every: 250

guidance_scale: 1

sample_steps: 8

핵심 설정:

랭크 32/알파 32: 과적합 없이 스타일을 최적화하는 포인트입니다.

V1 어댑터: 비밀의 핵심!

5000 스텝: 완전한 수렴에 충분한 횟수입니다.

FlowMatch 스케줄러: Z-Image Turbo에 내장된 방식입니다.

🚀 이 LoRA 사용법

이 LoRA는 애니메이션/일러스트레이션 스타일에 특화되어 학습되었습니다. 프롬프트를 단순히 유지하고 트리거 단어에 무게를 두는 것이 가장 효과적입니다.

✨ 트리거 단어

프롬프트 시작에 단순히 aimaginedworlds를 추가하세요:

aimaginedworlds, a girl with blue hair sitting in a cafe

그것뿐입니다! 복잡한 프롬프팅이 필요 없으며, 스타일이 이미 내장되어 있습니다.

❤️ 제 작업을 지원해주세요

고품질 LoRA를 만드는 데는 실제 시간, 노동, 비용이 필요합니다. 위에서 보셨듯이, 이 프로젝트 하나만으로도 클라우드 컴퓨팅에 약 $60과 수일의 실험이 소요되었습니다.

이 LoRA가 아름다운 이미지를 만드는 데 도움이 된다면, 제 작업을 지원해 주세요. 작은 기부라도 저에게 큰 도움이 됩니다:

🖥️ 향후 모델의 클라우드 컴퓨팅 비용을 커버

🎨 더 많은 고품질 애니메이션 LoRA를 학습

📚 커뮤니티와 제 발견을 공유

모든 지원은 저에게 세상처럼 소중하며, 제가 계속할 수 있게 해줍니다!

🛠️ 도구 및 크레딧

이 LoRA는 Ostris의 놀라운 AI-Toolkit을 사용해 학습되었습니다:

🔗 https://github.com/ostris/ai-toolkit

자신만의 LoRA를 학습하고 싶다면, 꼭 확인해 보세요. 강력하고, 잘 문서화되어 있으며, 활발히 유지보수되고 있습니다!

🙏 당신이 할 수 있는 도움

이 내용이 도움이 되셨다면, 아래 방법으로 지원해 주세요:

💸 PayPal로 지원 — GPU 비용을 커버하는 데 도움이 됩니다!

📢 자신의 작품 공유 — 제가 만든 작품을 보고 싶다면, 저를 태그해 주세요!

사랑, 좌절, 그리고 수많은 GPU 시간으로 만들어졌습니다.