aimaginedworlds: Z-Image Turbo LoRA Guide (Best Version)

详情

下载文件

模型描述

最佳结果: V1 适配器训练

风格: 动漫 / 插画

触发词: aimaginedworlds

基础模型: Tongyi-MAI/Z-Image-Turbo

📖 我的故事:通往“完美”LoRA的道路

我想分享我训练这个LoRA的全过程,而不仅仅是最终成果,因为我相信透明度能帮助社区共同学习。

🚫 尝试1:1000张图像数据集 + V2适配器

我一开始就大干一场。我以为数据越多,效果越好,于是收集了1000张图片,并使用了最新的适配器:

结果: 彻底失败。 LoRA完全没能捕捉到动漫风格,输出结果非常普通,毫无训练数据中的个性。

⚠️ 尝试2:精选100+张图像数据集 + V2适配器

我意识到质量胜过数量。我精心挑选了一个较小的数据集,包含约118张高质量动漫图像,并配有详细描述。

- 结果: 有所改善,但仍不够出色。 V2适配器似乎难以实现强烈的风格迁移,输出结果“还可以”,但并非我追求的那种鲜明的动漫美学。

🔄 尝试3:尝试Z-Image-De-Turbo

我彻底换了个思路,认为也许在非Turbo基础模型上训练能获得更好的控制:

结果: 毫无亮点。 虽然技术上可行,但未能生成我想要的那种鲜艳、风格化的动漫效果,整体感觉“平淡无奇”。

✅ 尝试4:V1适配器——胜利者!

在沮丧之下,我回到了最初的V1适配器。你猜怎么着?

适配器:

ostris/zimage_turbo_training_adapter_v1.safetensors数据集: 我精选的118张动漫图像

结果: 惊艳! 这是突破性的进展。V1适配器配合正确的设置,终于完美捕捉了动漫风格:推理速度快、风格强烈、质量稳定。

有时候,“旧”版本反而更有效。

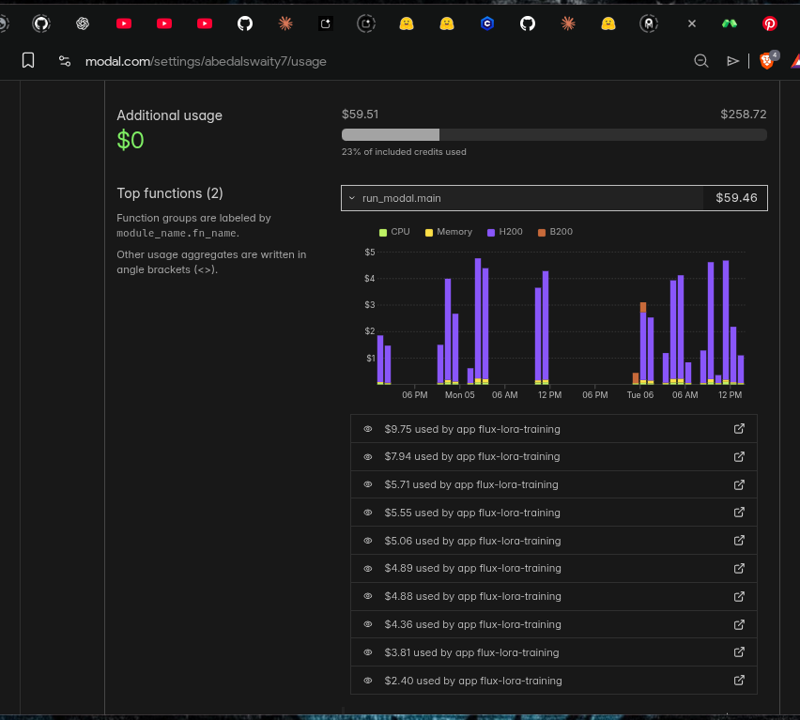

💸 真实成本:这次训练花了我多少钱

训练LoRA并非免费。以下是我在Modal云算力上为达成这一成果所花费的明细:

使用的GPU: NVIDIA H200

总训练次数: 10+次

总花费: 约60美元

投入时间: 数日实验...

仅为了找到最佳组合,我就花了60美元和无数小时调试、测试不同适配器、调整超参数、等待训练完成。

⚙️ 获胜配置

以下是产生最佳结果的确切配置,欢迎直接作为你训练的起点!

job: "extension"

config:

name: "aimaginedworlds_turbo"

process:

- type: "diffusion_trainer"

training_folder: "/root/ai-toolkit/modal_output"

device: "cuda"

trigger_word: "aimaginedworlds"

network:

type: "lora"

linear: 32

linear_alpha: 32

conv: 16

conv_alpha: 16

save:

dtype: "bf16"

save_every: 250

max_step_saves_to_keep: 4

datasets:

- folder_path: "/root/ai-toolkit/training_data/aimaginedworlds"

caption_ext: "txt"

caption_dropout_rate: 0.05

resolution:

- 512

- 768

- 1024

train:

batch_size: 1

steps: 5000

gradient_checkpointing: true

noise_scheduler: "flowmatch"

optimizer: "adamw8bit"

lr: 0.0001

dtype: "bf16"

model:

name_or_path: "Tongyi-MAI/Z-Image-Turbo"

arch: "zimage:turbo"

assistant_lora_path: "ostris/zimage_turbo_training_adapter/zimage_turbo_training_adapter_v1.safetensors"

sample:

sampler: "flowmatch"

sample_every: 250

guidance_scale: 1

sample_steps: 8

关键设置:

- Rank 32 / Alpha 32: 风格表现与过拟合之间的最佳平衡点。

- V1适配器: 秘密武器!

- 5000步: 足够实现完全收敛。

- FlowMatch调度器: Z-Image Turbo的原生调度器。

🚀 如何使用这个LoRA

该LoRA专为动漫/插画风格训练,使用时建议保持提示词简洁,让触发词承担主要风格引导。

✨ 触发词

只需在提示词开头添加 aimaginedworlds:

aimaginedworlds, a girl with blue hair sitting in a cafe

就这样!无需复杂提示,风格已内嵌。

🔌 推荐:Z-Image-Turbo提示模板节点

为获得最佳效果,请使用我的 ComfyUI-OllamaGemini 节点配合新版 Z-Image-Turbo 提示模板:

该节点利用Flux、Veo3.1、Qwen、Gemini、Banana Pro、Imagen4等模型实现魔法提示!

❤️ 支持我的工作

创建高质量LoRA需要真实的时间、精力与金钱。如上所述,仅此项目就耗费了我约60美元云算力和数日实验。

如果你用这个LoRA创作出美丽的图像,请考虑支持我的工作。哪怕小额捐助也能帮助我:

- 🖥️ 覆盖未来模型的云算力成本

- 🎨 训练更多高质量动漫LoRA

- 📚 与社区分享我的经验

每一份支持都意义非凡,让我能持续前行!

🛠️ 工具与致谢

本LoRA使用Ostris开发的杰出工具 AI-Toolkit 训练:

🔗 https://github.com/ostris/ai-toolkit

如果你有兴趣训练自己的LoRA,我强烈推荐你试试它——功能强大、文档详尽、持续维护!

🙏 你可以如何帮助

如果你觉得这个分享有用,以下是几种支持方式:

- 💸 通过PayPal支持 — 帮助覆盖GPU成本!

- 📢 分享你的作品 — 标注我,让我看看你创作了什么!

用热爱、挫败与无数GPU小时打造。