Wan 2.2 First-to-Last Frame Workflow

详情

下载文件

模型描述

想立即尝试此工作流? 此 Wan 2.1 首帧到末帧工作流已在 SeaArt 上预配置完毕,适合希望跳过设置步骤的用户。

注意:这是一个指向工作流托管版本的直接链接。如果您不想手动下载和本地设置模型与 LoRAs,这是一个绝佳选择。

停止猜测你的 AI 视频会如何结束,开始定义它。

在 AI 视频生成中,最大的挑战之一是控制力。你通常有一个出色的起始图像,但视频到最后一帧时却陷入混乱。如果能同时锁定起始帧和结束帧,让 AI 自动填充两者之间的过渡,会怎样?

这正是 Wan 2.2 首帧到末帧 工作流所实现的功能。借助 Wan 2.2 的 140 亿参数模型与“闪电”速度优化,此 ComfyUI 工作流可让你以专业级的一致性实现角色姿态变形、光影变化,或在完全不同的场景间平滑过渡。

为何使用此工作流?

根据我们的测试与结果,此工作流解决了三大核心痛点:

精准控制:它不只是简单地向前动画,而是精确插值你提供的两张图像。

高速高质量:采用 Wan 2.2 闪电 LoRAs,显著缩短渲染时间,同时保留 140 亿参数模型的细节表现。

丝滑流畅播放:内置 RIFE VFI(视频帧插值) 系统,可自动将原始输出平滑为流畅的 32 FPS 视频。

分步指南:工作流原理

以下是工作流的逻辑分解,助你立即开始创作。

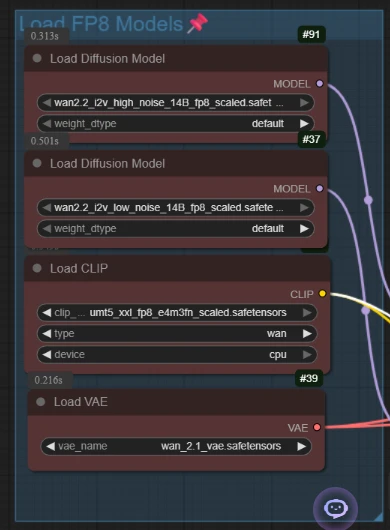

1. 设置:高性能模型

工作流首先加载核心模型:Wan 2.2 的 140 亿参数扩散模型(分为高噪声与低噪声版本)及 T5 编码器。

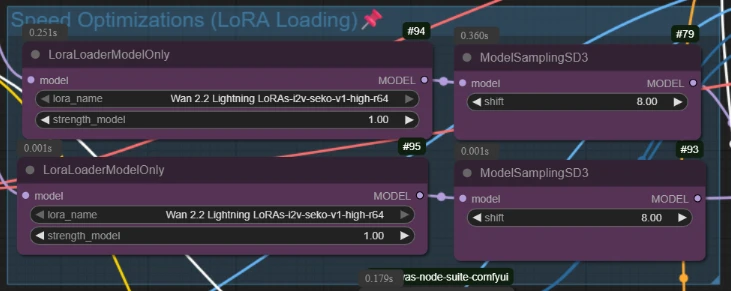

- 专业提示:此设置使用强度为 1.0 的“闪电 LoRAs”,这是实现快速生成、支持高效实验的关键秘诀!

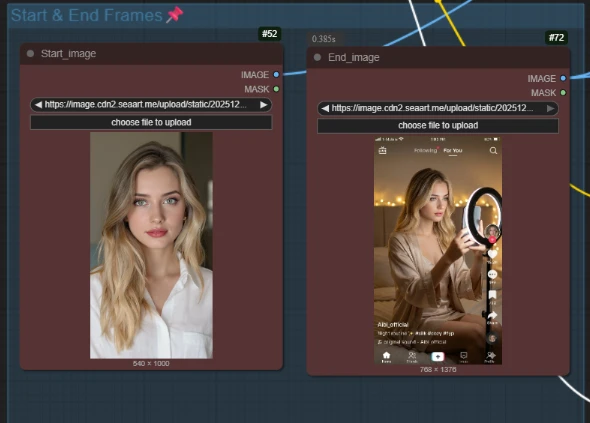

2. 定义你的叙事(起始帧与结束帧)

这是魔法发生之处。你并非仅上传一张图像,而是上传两张:

- 起始图像:初始场景(例如:身穿白衬衫的女孩)。

- 结束图像:目标场景(例如:同一女孩在 TikTok 灯光环境下手持手机)。

工作流通过专用节点 WanFirstLastFrameToVideo 计算这两幅视觉图像之间的潜在过渡路径。

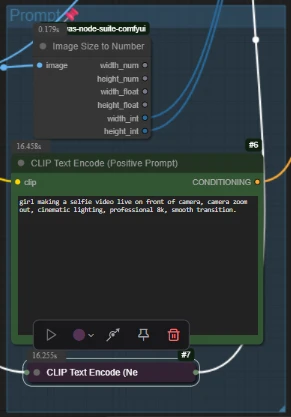

3. 文本引导

通过简单文本提示引导过渡过程。

- 正向提示:描述正在发生的动作(例如:“女孩正在拍摄自拍视频……镜头后拉”)。

- 负向提示:标准质量过滤器,防止模糊或畸变。

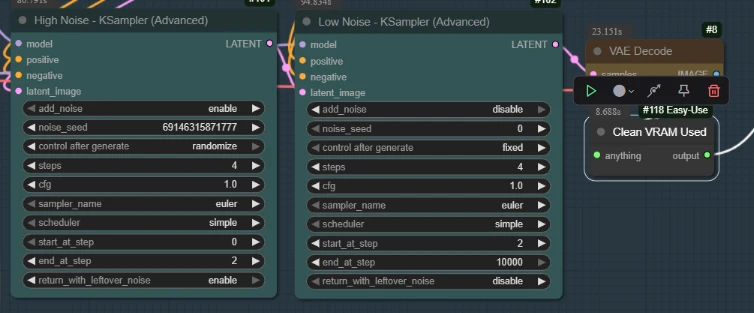

4. “双采样器”引擎

不同于基础工作流,此系统采用智能的两阶段采样:

- 高噪声采样器(步骤 0–2):确立主要结构变化。

- 低噪声采样器(步骤 2–结束):细化细节与纹理,确保最终图像清晰锐利。

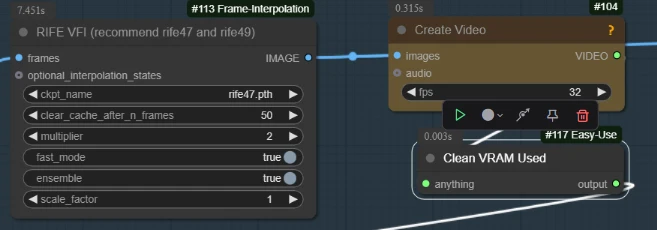

5. 最终润色(RIFE 插值)

原始输出可能仅有 14–16 帧。工作流会自动将此输出通过 RIFE VFI 节点,设置倍数为 2。

- 结果:原本卡顿的低帧率动画,瞬间被平滑为流畅的专业级视频文件。

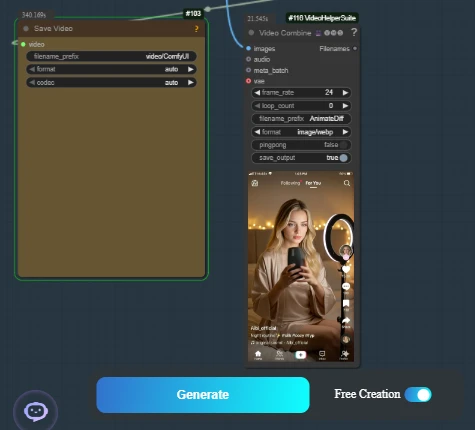

最终效果

结果是连贯、合乎逻辑的过渡。在我们的示例视频中,我们看到从标准人像无缝演变为动态社交媒体拍摄场景。角色身份保持一致,而光影、姿态与背景则精准匹配“结束帧”目标。

立即开始

准备好全面掌控你的 AI 视频生成了吗?此 AI 应用已打包完毕,即刻可运行。