ADetailer foot_yolov8x.pt

详情

下载文件

关于此版本

模型描述

V3 开发通知

时间:2025年5月11日

大家好,

继近期的一些讨论之后,我想简要更新一下备受期待的V3脚部模型,以及新的手部和面部/头部分割模型的进展。

我知道许多人对此充满期待,而我也同样急切地想把这些模型交到你们手中!以下是目前的进展:

数据集稳固,欢迎补充独特样本:构成V3(以及新手部/面部模型)基础的超过1000张图像的综合数据集已准备就绪。我有信心它涵盖了广泛的情景,以确保强大的检测能力。不过,如果你恰好拥有或知道一些展示独特姿势、角度或构图的图像,认为它们可能有益且当前数据集中代表性不足,请随时分享你的建议! 我很乐意查看。如果是我遗漏但能提升模型表现的场景,我愿意额外选取并标注几幅精心挑选的图像。尽管当前基础已非常扎实,但多一两个独特的样本不会打乱流程,反而可能进一步优化模型。

标注流程优化以追求精度:在初步尝试了SAM等自动化工具后,我决定为每张图像采用完全手动标注的方式。虽然SAM提供了起点,但高质量分割掩码所需的精度(避免影响背景或留下伪影)意味着逐点手动描边是最有效的方法。这确保了掩码达到尽可能高的准确性,而这正是我在V3中追求质量提升的关键所在。这过程确实繁琐,但至关重要!

细致标注正在进行中:目前,手动标注数据集中每一个脚、手和面部/头部的细节工作已成为我的首要任务。这是一场马拉松,而非短跑,因为每个元素都需要仔细勾勒。

V3脚部模型是优先事项:正如我所提及的,我的承诺是V3脚部分割模型将是我发布的下一个模型。所有LoRA和检查点训练都已暂停,直到V3完成并上传——这正是我全力推进这一细致标注阶段的动力!一旦完整数据集标注完毕,脚部模型将首先进行训练和发布,随后是手部和面部/头部模型。

流程文档正在编写中:对于对细节感兴趣的朋友,我正在详细记录整个过程——从标注工具的艰难配置(真的是一场冒险!)、标注策略,到最终这些yolo-seg模型的训练流程。我希望未来能分享这些信息,或许能为其他进入分割模型训练领域的人提供帮助。

因此,通往V3的旅程已全面展开!这是一个复杂且耗时的项目,尤其在转向高精度分割并扩大范围之后,但我们的目标是交付显著提升、值得等待的模型。

再次感谢你们非凡的耐心与支持。我会继续专注于质量,并在有重大进展时及时分享更新!

V1/V2

感谢 sp00ns 的指南:

训练自定义 Adetailer 模型 | Civitai

我使用 yolov8x 创建了一个自定义脚部模型。

sp00ns 提供的脚部模型很有帮助,但我希望尝试自己制作一个。

ComfyUI 工作流:

我知道许多用户使用 ComfyUI,并在使模型正常工作时遇到困难。因此,我专门为你们重新安装了 ComfyUI,并设计了一个初步的工作流,不仅适用于 v2.0 脚部模型,也适用于手部和面部模型。请自由调整设置以获得最佳效果。只需将下方固定图片拖入你的 ComfyUI 窗口,即可复现生成该图像所使用的精确参数。(我也会将这张图片的固定版本发布在 v2.0 模型页面上)

版本 1.0 和 2.0 是 BBOX 模型,因此请确保将它们放置在 ~\ComfyUI\models\ultralytics\bbox 文件夹中。使用 SAM 模型意味着它实际上可以作为 SEG 模型工作——至少这是我所理解的。此外,请确保安装 FaceDetailer 插件以及 UltralyticsDetectorProvider 节点,以使这一切正常运行。

祝你顺利使用~

版本 1.0:

我曾尝试使用 AutoDistiller 和 Grounded SAM 自动标注这1000张图像,但部分失败了,因为它有时会将手误判为脚。(而且我讨厌 Colab,因为在那里工作总会被提前终止)

因此,我使用 Mac 上的 RectLabel 逐张手动标注,然后在我的 PC 上花费约8小时训练 YOLO 模型。

虽然我原计划训练500个周期,但训练提前结束,系统判定第93个周期为最佳结果。

我加入了大量自己生成的图像,以及一些图库图像:包括动漫、3D模型、写实图像;男女不同肤色;各种穿鞋与赤脚的配置。但仍有某些情况它处理不佳,例如非常规姿势(如旋转90度的图像),以及脚作为画面主体的图像。我猜测,这是因为绝大多数训练图像中脚只占画布的一小部分,因此对脚部特写的训练不足。另一方面,我的初衷是用此模型优化那些容易被忽视的脚部,例如在全身图中脚仅占极小画布空间的情况。

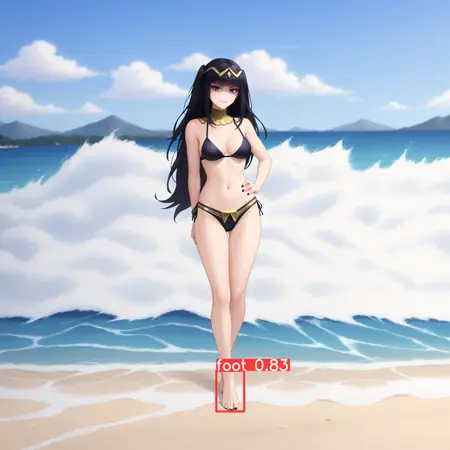

简而言之,此版本在处理站立姿势、尤其是全身图中的脚部时表现极佳,但在其他场景中可能表现不佳。

版本 2.0:

我注意到我在版本1中误标了训练/验证文件夹——我的训练文件夹实际是验证文件夹,反之亦然。我随后更正了名称,但仅凭此操作并假设像版本1一样100个周期就足够,却引发了其他问题:模型开始将整个身体误判为脚。这白白浪费了3小时。于是我将周期设为200,将大量旧的验证图像移入训练集,并新增约160张图像(使用 RectLabel 手动逐张标注)。这次经过12小时训练,系统判定第148个周期为最佳版本,这就是本版。

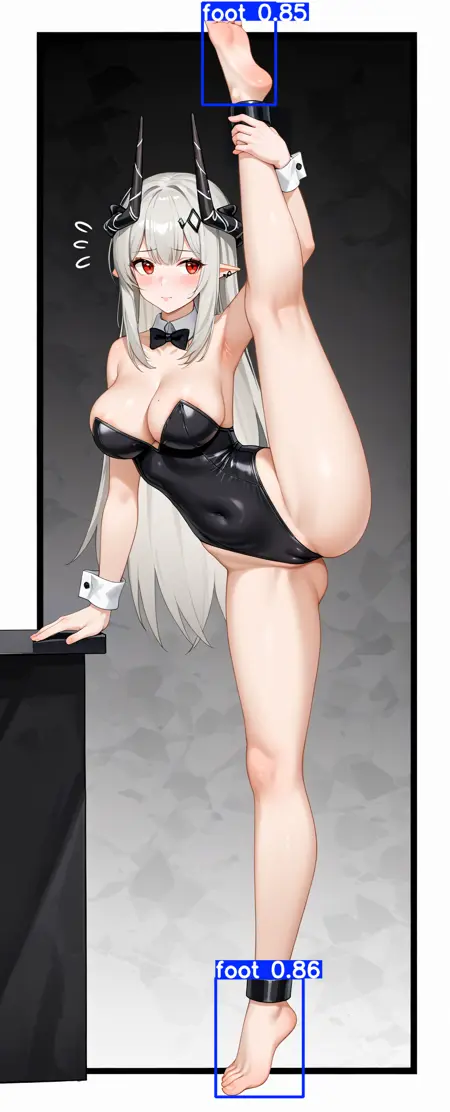

据我测试,它在各种配置下检测脚部的表现远优于 v1.0,极少出错;能检测脚底;能检测旋转90度的脚;基本能检测非常规姿势的脚——具体取决于姿势。

不过,我也发现一些问题:它偶尔会将手、膝盖或其他物体误判为脚,但置信度低于真实脚部。若出现此类情况,建议将 Adetailer 检测设置中的检测模型置信度阈值至少提高到 0.5。

对于脚部占据画布大部分面积的图像,有时能完整检测,有时仅部分检测,有时只检测一只脚而忽略另一只。可以说,这个模型本不是为这类图像设计的,即使训练集中包含此类图像,因为该模型的作用是裁剪整个画布以聚焦目标(脚),从而集中大量图像生成资源来优化/修改脚部。如果脚已是图像主体,占据画布50%或以上,那么此模型在优化目标方面实际上作用有限。你当然仍可尝试使用它,但根据使用方式,它可能带来更多问题而非解决方案。

安装:

只需将文件移至 ~\stable-diffusion-webui\models\adetailer 文件夹,然后重启 WebUI。它肯定也能在 ComfyUI 中运行;但我尚未在 ComfyUI 中测试过我已测试过,并有对应工作流,见上图。当然,你需要在 Automatic 1111 中安装 ADetailer 扩展,或在 ComfyUI 中安装等效的 FaceDetailer 和 UltralyticsDetectorProvider 才能使用。

提示:你可以在 Automatic 1111 中通过前往:设置 > ADetailer > 最大模型数,来增加 ADetailer 模型数量。

注意:Civitai 似乎没有 ADetailer 相关分类,因此我将其设为检查点——尽管它并非检查点。关于剪枝/完整版和精度设置,我随意选择了默认值。

另外,如今 Stable Diffusion 在至少竖版构图中对脚部的生成效果已相当不错,因此我很难为竖版找到合适的使用场景。于是我用该模型在示例中绘制了 Tharja 的脚趾甲。但此模型在横版构图中将特别有用,因为这类图像中的脚部通常质量较低。