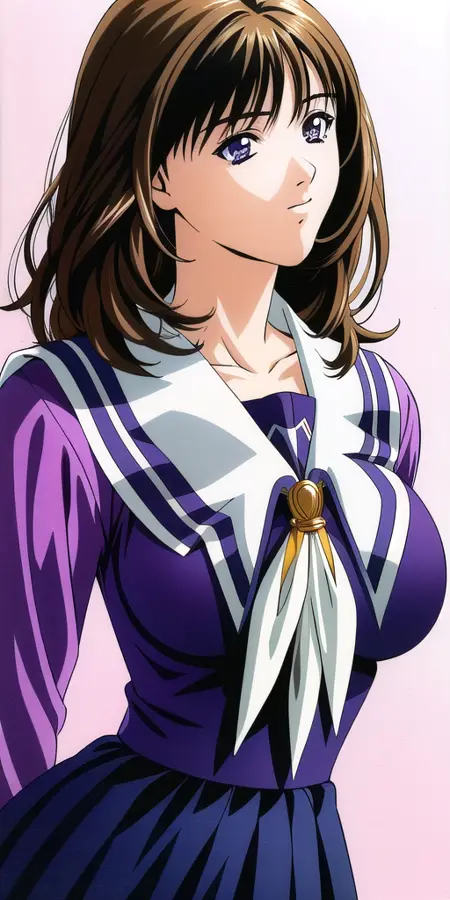

Iori Yoshizuki ( diag-oft experiment version ) - I''s

详情

下载文件

模型描述

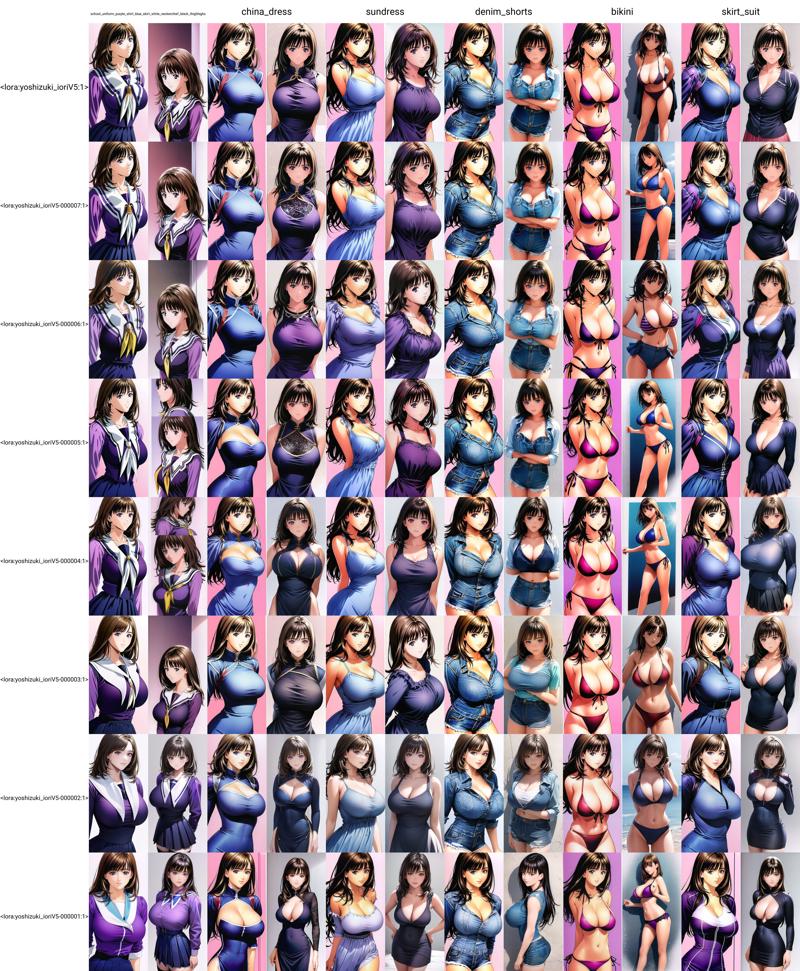

这再次源于我对这种新型“LORA”方法的好奇心。结果如何?它的质量似乎介于IA3和LORA之间。你可以与IA3版本、LORA版本或LOCON版本进行比较。它们都使用相同的数据集,仅通过调整重复次数,使总训练轮数保持在8轮。

从图像效果来看,它能够反映数据集的特征,但训练模型并未带来太多“创造性”。基本上,它处于IA3和LORA之间的位置。

以下是我在优缺点方面的分析:

优点:

由于它不会覆盖之前的训练,因此较难过度拟合。

文件体积较小,因为它以相当于dim=2的配置进行训练。

使用Prodigy训练相对较快,每个概念每轮需要150~200步。我在第5轮(每轮使用300步)时已获得良好效果,并且直到第8轮都保持稳定。每个迭代步骤耗时约为LORA的1.58倍,因此在效率上略有折损。

缺点:

它对数据集的缺陷更为敏感,而这些缺陷通常会被模型自行填补(如缺失角度、头发细节不足、织物纹理模糊、色彩偏低、模糊不清等)。

质量与训练时间的比率并不理想,因为IA3训练更快,而LORA/LOCON的最终效果更好。

结论:

目前,Diag-OFT似乎只是Lycoris工具箱中的又一个新增选项,没有特别新奇或令人兴奋之处,唯一的优点是较难过度拟合。

我将附上数据集、之前的训练轮次、训练用的TOML文件,以及一个比较6种不同模型、8轮训练结果的XYZ文件。

顺便提一下,使用以下提示词效果不错:lora:yoshizuki_IoriV5:1 yoshizuki_Iori,

唯一标注的服装是:

- school_uniform_purple_shirt_blue_skirt_white_neckerchief_black_thighhighs