Style Components (ComfyUI & Forge)

詳細

ファイルをダウンロード

このバージョンについて

モデル説明

スタイルコンポーネント(ComfyUI & Forge)

詳細と手順については、Forge拡張機能 / ComfyUIノード のGitHubページをご覧ください。今後、このCivitaiページには小さな変更は追加されません。最新情報はGitHubページをご確認ください。

v0.2.0用の旧説明

スタイルコンポーネント(Forge拡張機能)

Stable Diffusion 1.xおよびSDXLアニメモデル用のスタイル制御。

(モデルファイルをダウンロードする必要はありません。Colabデモ をお試しください。)

v0.1.0より、Forge 拡張機能が提供されています。

v0.2.0では、SDXL(AutismmixPony)専用の追加Forge拡張機能が追加されました。v0.1(SD1)とは異なり、現在のスタイルコンポーネントの意味が変更されていることにご注意ください。

これは何ですか?

これはIP-Adapterですが、(アニメ)スタイル用です。CLIP画像埋め込みではなく、画像生成はスタイル埋め込みに条件付けされます。このスタイル埋め込みは画像から抽出するか、手動で作成できます。コンポーネント値はPNGの情報で確認できます。

なぜ必要ですか?

現在、スタイル制御の主な手段はアーティストタグです。しかし、この方法ではスタイルの盗用という懸念が生じます。すべてのアーティストに共通する解釈可能なコンポーネントにスタイルを分解することで、スタイルの直接コピーを回避できます。さらに、スタイルコンポーネントの強度を操作することで新しいスタイルを簡単に作成でき、アーティストタグやLoRAの重ね合わせよりも高い制御性を提供します。

また、この仕組みは汎用的な学習にも有用である可能性があります。スタイル条件付きで学習することで、概念へのスタイルの漏れが弱まる可能性があります。さらに、画像モデルがテキストや画像以外の任意のテンソルに条件付け可能であることを示すデモンストレーションにもなります。今後、本来数値的な性質を持つもの(美的スコア、日付など)をテキストタグに無理に変換する必要がないという理解が広まることを期待しています。

使い方は?

現在、Gradioインターフェース付きのColabノートブックが利用可能です。これは実験的なプレビュー版であるため、モデルがより安定した状態になるまで、人気のあるWeb UIへの正式な対応は追加されません。

Forge拡張機能をダウンロードし、extensionsディレクトリに展開してください。有効化チェックボックスを必ずオンにしてください。SD V1にはv0.1.0、SDXLにはv0.2.0を使用してください。

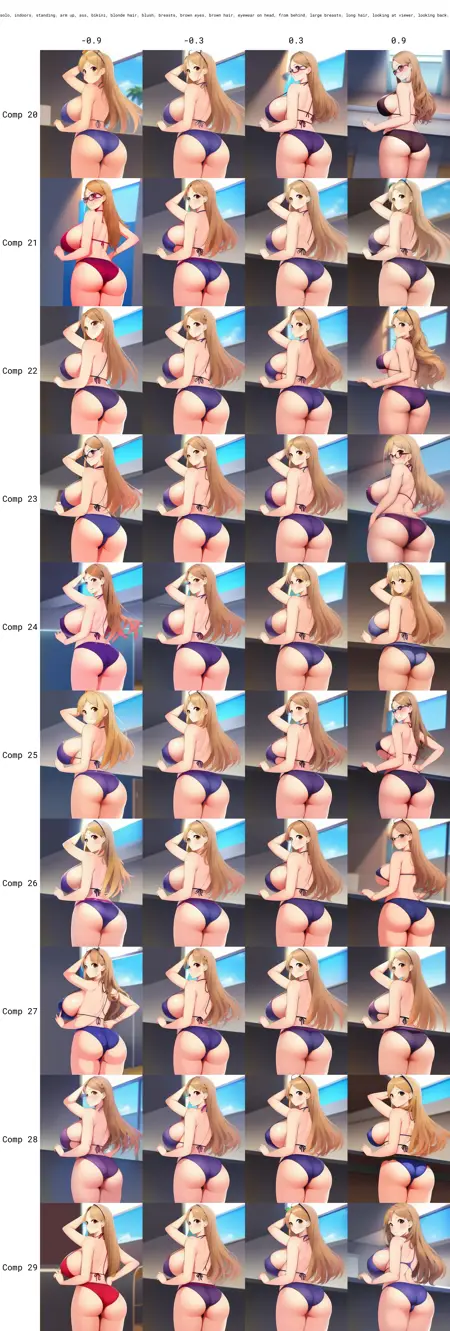

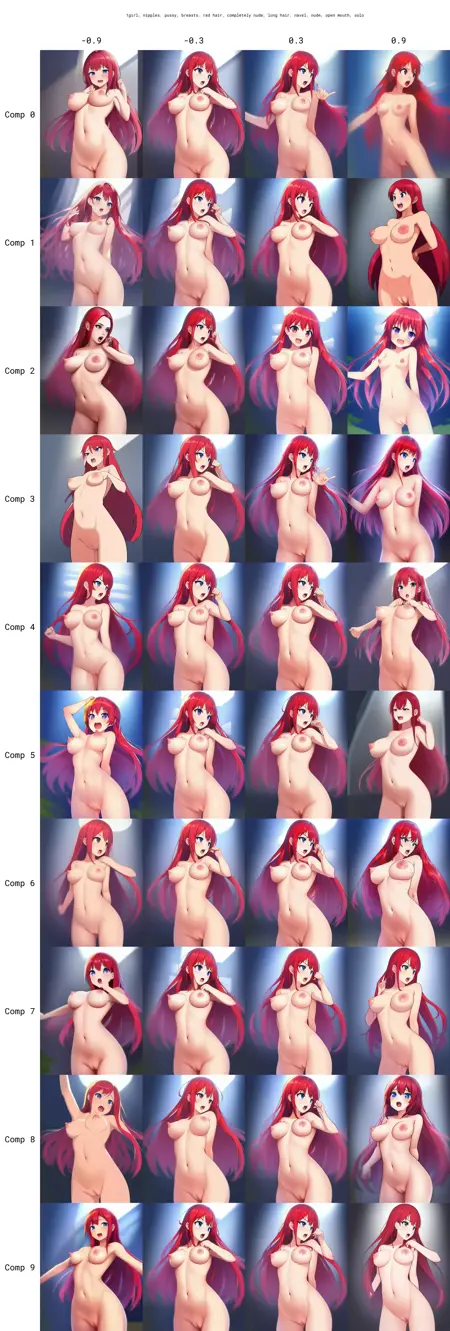

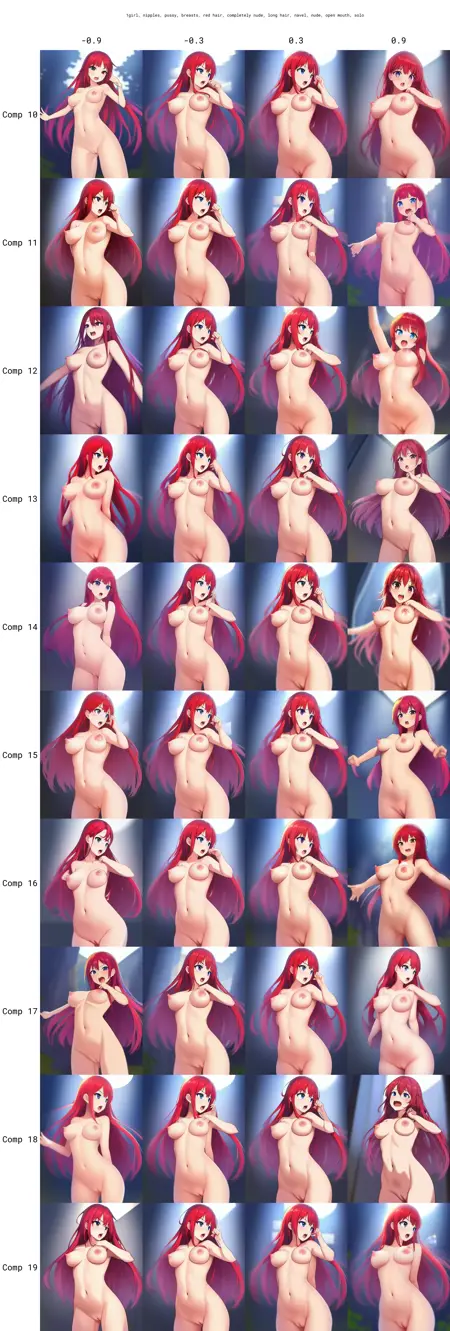

スライダー値を操作してスタイル埋め込みを作成するか、通常の画像からインポートできます。各コンポーネントの効果のリファレンスグリッドはプレビュー画像に提供されています。

SDXLのヒント:このモデルはAutismmixPonyで学習されています。現在サポートされている唯一のモデルです。アダプターはPonyタグ(source_anime、score_9など)を用いて学習されていないため、プロンプトではこれらのタグを省略できます。

技術的詳細

まず、アーティストデータセットに対して監視対照学習を用いてスタイル埋め込みモデルを構築します。次に、学習された埋め込みからPCAの最初のコンポーネントを抽出します。最後に、同じデータセット(WD1.4タグと射影された埋め込みを使用)でアニメ-final-prunedを用いて修正版IP-Adapterを学習します。学習解像度は576×576(SD1)/ 1024×1024(SDXL)、アスペクト比は可変です。

SDXL版では、スタイル操作と条件付けを分離するように設計を改良しました。スタイル抽出器はより大きなデータセットとより多くのパラメータで更新されています。

モデルの学習方法の関係上、スタイル埋め込みはグローバルな構成よりもローカルなスタイルをよりよく捉えています。また、学習時のクロッピングに顔を含めるための特別な配慮は行っていないため、スタイル埋め込みは顔や目に関するスタイルを十分に捉えられない可能性があります。

謝辞

このプロジェクトは、Inserting Anybody in Diffusion Models via Celeb BasisおよびIP-Adapterに大きく影響を受けました。学習および推論コードはIP-Adapter(ライセンス)を基に改変されています。