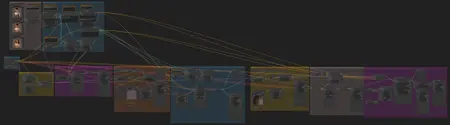

AnimateDiff Workflow: IPAdapter Transformations

詳細

ファイルをダウンロード

モデル説明

このワークフローの目的は、静的な背景のままキャラクター間をスムーズに移行させることです。完璧ではありませんが、良いスタートになると私は思います。48フレームの完全生成には、私の3090で17GBのVRAMと50分かかりました。VRAMを節約したい場合は、ワークフローのハイレゾセクションをスキップすることをお勧めします。

ベースワークフローの完全なクレジットはLatent Visionに帰します:

私がもう少し試してみたいこと:

- キャラクター/カメラが回転しても効果があるか確認するために、ライティングの一貫性を高めるためにIC-lightを使用する

- 顔にIPAdapterを使用する

最後に一つ:Limitless Visionモデルは十分ですが、Realistic VisionやDreamshaperなどの他のモデルの方がおそらくより良い結果をもたらすでしょう。私が直面した問題は、これらのモデルが私が入力したIPAdapter画像を「理解」していないことです。さらに実験が必要です!

必要なモデルが不足している場合は、以下の部分的なリストをご覧ください。また、IPadapter/clipvisionモデルとopenpose controlnetも必要です。

/models/controlnet内にcontrolGIF_normal.ckptとして名前を変更:https://huggingface.co/crishhh/animatediff_controlnet/resolve/main/controlnet_checkpoint.ckpt?download=true

/models/animatediff_modelsに配置:https://huggingface.co/wangfuyun/AnimateLCM/resolve/main/AnimateLCM_sd15_t2v.ckpt

/models/lorasに配置:https://huggingface.co/latent-consistency/lcm-lora-sdv1-5/tree/main

/models/lorasに配置:https://huggingface.co/guoyww/animatediff/blob/main/v3_sd15_adapter.ckpt

tip jar: https://www.patreon.com/blankage