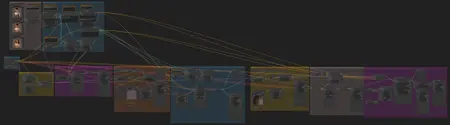

AnimateDiff Workflow: IPAdapter Transformations

세부 정보

파일 다운로드

모델 설명

이 워크플로의 아이디어는 정적인 배경을 유지한 채 캐릭터 간 부드러운 전환을 가능하게 하는 것입니다. 완벽하지는 않지만, 좋은 출발점이라고 생각합니다. 48프레임 전체 생성에 제 3090 GPU는 17GB의 VRAM과 50분이 소요되었습니다. VRAM을 절약하고 싶다면, 워크플로의 hires 섹션을 건너뛰시기를 권장합니다.

기본 워크플로는 Latent Vision에게 완전한 신뢰를 드립니다:

추가로 시도해보고 싶은 것들

IC-light를 사용해 조명 일관성을 높이기 (캐릭터/카메라가 회전할 경우 이 방법이 작동할까?)

얼굴에 IPAdapter 사용하기

마지막으로 한 가지: Limitless Vision 모델은 괜찮지만, 이 작업은 Realistic Vision이나 Dreamshaper 같은 다른 모델과 더 잘 어울릴 것 같습니다. 제가 겪은 문제는 이러한 모델들이 제가 입력한 IPAdapter 이미지를 잘 "이해"하지 못한다는 점이었죠. 더 많은 실험이 필요합니다!

필요한 모델이 누락되었다면, 아래에 일부 목록을 제공합니다. 또한 IPadapter/clipvision 모델 및 openpose controlnet도 필요합니다.

/models/controlnet에 controlGIF_normal.ckpt로 이름 변경: https://huggingface.co/crishhh/animatediff_controlnet/resolve/main/controlnet_checkpoint.ckpt?download=true

/models/animatediff_models에 저장: https://huggingface.co/wangfuyun/AnimateLCM/resolve/main/AnimateLCM_sd15_t2v.ckpt

/models/loras에 저장: https://huggingface.co/latent-consistency/lcm-lora-sdv1-5/tree/main

/models/loras에 저장: https://huggingface.co/guoyww/animatediff/blob/main/v3_sd15_adapter.ckpt