LOKI - Live Portrait w/ Video BG + Fastest Face Swap + Batch Modes

詳細

ファイルをダウンロード

モデル説明

Video tba

V5新機能 /Loki-Multiperson/

Loki-Faceswap-Multi-2(2人用)

Loki-Faceswap-Multi-3(3人用)

静的・動的背景を置き換えたライブポートレート。

V4新機能 - /Loki-combineLayers/

Loki-LivePortrait-StaticBG

Loki-LivePortrait-videoBG

(注意:これはInsightFaceの実装用に構築され、研究・非商用ライセンスでした。現在、新しいオープンソース実装が登場しており、今後のバージョンではこれを利用します。)

LOKI - ComfyUI用 最速フェイススワップ

UPDATE V27 - LOKIパックにMimicMotion対応を追加。

UPDATE V12 - LOKIパックにLivePortrait対応を追加。

RELEASE V8 - 最速フェイススワップ(オールインワン)ワークフローを初リリース。

例として、LOKI Faceswapを使ってキャラクター用の顔モデルを作成し、その後Trio-Tposeでその顔モデルを使用してキャラクターを生成できます。LivePortraitでリップシンク音声アニメーション、またはMimicMotionでキャラクターのポーズアニメーションを実現できます。

Mimic Motion 使用方法:

駆動動画を使用して、画像内の頭部・顔をアニメーション化し、ソースのFPSと音声を含む動画を保存します。

話す顔の動画を使用

(パックにドライバー動画が同梱されています)アニメーション対象のキャラクター画像を使用

(パックにtpose画像が同梱されています)ワークフローを実行すると動画が生成されます

(オプション)補間タイプを切り替える

補間時のFPS合わせに関する注意事項を参照してください

必要なモデル:

ノード:(マネージャーを使用)

https://github.com/kijai/ComfyUI-MimicMotionWrapper

モデル:

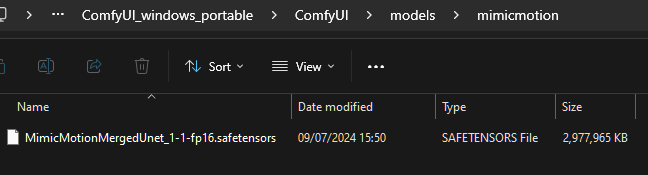

https://huggingface.co/Kijai/MimicMotion_pruned/tree/main

- すべてを /models/mimicmotion/ 内に配置

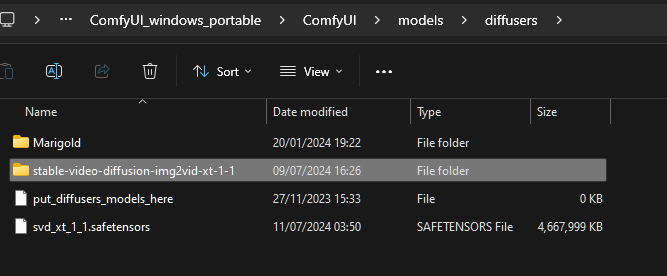

また、Diffusers SVD XTが必要です

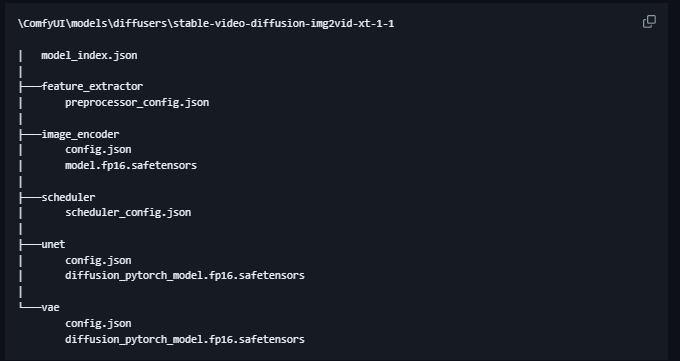

https://huggingface.co/stabilityai/stable-video-diffusion-img2vid-xt-1-1/tree/main

- /models/diffusers/stable-video-diffusion-img2vid-xt-1-1/ に配置

- 「svd_xt_1_1.safetensors」を /models/diffusers/ に移動

すべては動画で解説されています :)

すべては動画で解説されています :)

Live Portrait 使用方法:

LOKI-LivePortraitを使用して、キャラクター画像と、スマホ、ウェブカメラ、その他のデバイスで記録したビデオチャット動画でキャラクターをアニメーション化できます。

駆動動画を使用して、画像内の頭部・顔をアニメーション化し、ソースのFPSと音声を含む動画を保存します。

話す顔の動画を使用

(パックにドライバー動画が同梱されています)アニメーション対象のキャラクター画像を使用

(パックにtpose画像が同梱されています)ワークフローを実行すると動画が生成されます

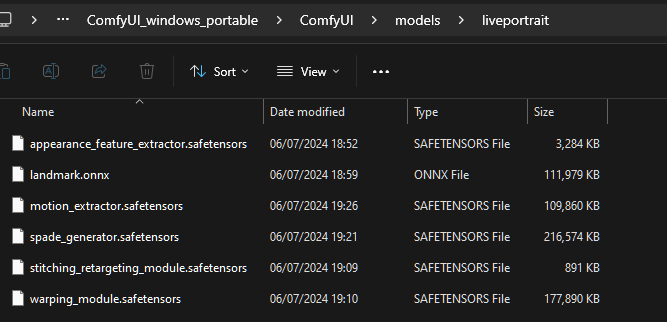

必要なモデル: https://huggingface.co/Kijai/LivePortrait_safetensors/tree/main

https://huggingface.co/Kijai/LivePortrait_safetensors/tree/main

上記リンクからすべてのモデルをダウンロードし、上記のように /models/liveportrait に配置してください。詳細な説明とデモはLoki LivePortrait動画をご覧ください。

以上:V12-LivePortraitワークフロー

以下:V8-FaceSwapワークフロー

すべての必要なノードとモデルはLauncherから入手可能、または動画の説明欄で確認できます(例:初めてSUPIRアップスケーラを設定する方法)。

記事へジャンプ:https://civitai.com/articles/5915

注:SUPIRはバッチモードのアップスケーリングには使用しません(処理に非常に時間がかかります)。通常の方法で作成後の動画をアップスケーリングすることを試してください。