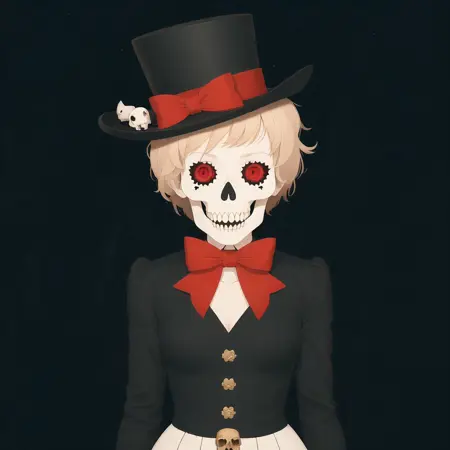

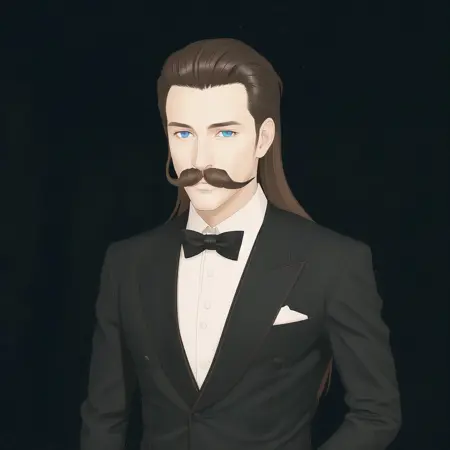

One-image LoRAs vol.1

详情

下载文件

模型描述

这是一个实验性合集,由每个仅基于1张图像训练的LoRA组成。它们显然存在过拟合,但这正是预期的结果。

请注意,结果经常不稳定,因此请根据需要使用或不使用触发词。如果你使用了触发词,不妨随时调整LoRA的权重或任何触发词。

基础模型为 Suzumehachi。

更新:

工作流程如下。

我的制作方式是:找到一张有趣的照片,将其调整为正方形,或手动裁剪成一至两个有趣的部分。接着使用BLIP(有时配合DeepDanbooru)生成描述文字,并检查其是否合适。之后,我通常会添加一个特殊触发词以备不时之需(在LoRA可能面对非常规提示环境时增强其表现力)。

我使用kohya进行训练,参数如下(仅列出最重要的几项):

数据集图像的训练步数 - 100-200

--network_alpha="128"

--text_encoder_lr=5e-5

--unet_lr=0.0001

--network_dim="128"

--lr_scheduler_num_cycles="1"

--learning_rate="0.0001"

--lr_scheduler="constant"

--train_batch_size="2"

--mixed_precision="bf16"

--clip_skip=2

--noise_offset=0.1

--min_snr_gamma=5

由于我的其他工作流程,我会用不同种子生成4个LoRA变体,然后两两组合,使用约0.7的乘数因子:

python.exe "networks\merge_lora.py" --save_precision fp16 --precision fp16 --save_to combined_lora.safetensors --models lora_1.safetensors lora_2.safetensors --ratios 0.7 0.7

如果出现异常,我会尝试使用不同乘数因子重新组合,或剔除某些表现异常的LoRA。