FLUX.1-DEV & Kontext Workflows Megapack

세부 정보

파일 다운로드

이 버전에 대해

모델 설명

업데이트됨 2025.02.07

02.07. SDXL-to-Flux 워크플로우를 4.6으로 업데이트함(SDXL CN 부분 수정, 이전에는 제대로 작동하지 않음)

02.07. Kontext 워크플로우를 1.4로 업데이트하고, 그와 함께 Kontext inpaint 워크플로우를 포함함.

기본 설정:

1) ComfyUI 휴대용 버전 다운로드:

https://docs.comfy.org/installation/comfyui_portable_windows

정기적으로 Update 폴더에서 ComfyUI를 업데이트하세요(update_comfyui_and_python_dependencies.bat 사용).

2) Node Manager가 필요하며, 이를 사용하여 몇 가지 커스텀 노드를 설치해야 합니다.

https://github.com/ltdrdata/ComfyUI-Manager

노드를 정기적으로 업데이트하세요.

3) 최근 _Get and Set nodes_가 설치 매니저에서 찾지 못하는 문제가 발생하고 있습니다. 이 노드들은 매우 유용하므로, 직접 저장소에서 수동으로 설치하세요:

https://github.com/kijai/ComfyUI-KJNodes

다음 위치에 압축 해제하세요:

ComfyUI\custom_nodes

필요한 항목 설치 방법: _ComfyUI\custom_nodes\ComfyUI-KJNodes_ 폴더로 이동하여 "requirements.txt" 파일을 복사하고, python_embeded 폴더에 붙여넣으세요.

그 후, python_embeded 폴더 내에서 _cmd_를 실행하세요(이 폴더는 ComfyUI가 모든 종속성에 사용하는 폴더입니다). 다음 명령을 실행하세요:

pip install -r requirements.txt

4) Civitai 페이지 상단에서 필요로 하는 워크플로우를 선택하고, .zip 파일을 다운로드한 후 다음 폴더에 압축 해제하세요:

ComfyUI\user\default\workflows

5) ComfyUI에서 .json 파일을 로드(또는 드래그)하여 워크플로우를 열어주세요.

참고: ComfyUI에 이미지를 직접 로드하면 이전 버전의 워크플로우가 로드될 수 있습니다. 대신 .json 파일을 사용하세요.

참고: 프롬프트 박스에는 두 개의 박스가 있습니다. clip_l 박스에 프롬프트를 입력하지 마세요. 이 박스는 프롬프트를 제대로 따르지 않으며 이상한 결과를 낼 수 있습니다.

노드 색상 안내:

녹색 노드: 여기서 숫자를 자유롭게 변경하여 원하는 결과를 얻을 수 있습니다.

빨간색 노드: 제 권장 설정입니다. 자유롭게 실험해보세요.

파란색 노드: 로더 노드입니다. 여기서 파일을 로드하세요(파일명을 클릭하고 옵션에서 선택). 옵션이 보이지 않는다면, 파일을 올바른 경로에 넣지 않았거나, 이미 넣었다면 ComfyUI를 새로 고쳐야 할 수 있습니다.

- ComfyUI 실행 중 모델을 추가할 경우, "R" 키를 눌러 새로 고치세요.

=============================================

기능:

LORAs

\ComfyUI\models\loras

와일드카드

\ComfyUI\custom_nodes\ComfyUI-Impact-Pack\wildcards

- 하위 폴더에도 배치할 수 있습니다.

와일드카드 노드:

Populate 모드: 상단 박스에 와일드카드를 사용하여 프롬프트를 입력할 수 있습니다.

Fixed 모드: 하단 박스에 와일드카드 없이 프롬프트를 입력할 수 있습니다.

LLM

\ComfyUI\models\llm_gguf\

짧은 프롬프트를 입력하면 LLM AI 모델이 이를 자세한 설명문으로 생성해줍니다.

제가 사용하는 모델 링크: (Mistral-7B-Instruct-v0.3-GGUF)

https://huggingface.co/MaziyarPanahi/Mistral-7B-Instruct-v0.3-GGUF/tree/main

- 자신의 PC에 맞는 양자화 레벨을 선택하세요.

ControlNet (CN)

\ComfyUI\models\controlnet

최고의 Depth 전처리기: DepthAnythingv2

최고의 OpenPose 전처리기: DWPreprocessor

참고: 이상한 결과가 나오면 설정을 조정해보세요.

ADetailer

\ComfyUI\models\ultralytics\bbox

\ComfyUI\models\ultralytics\segm

"No Dill" 경고가 나타나면, bbox 모델을 사용하거나 Huggingface의 Anzhc가 제공하는 "No Dill" 세그멘테이션 모델을 사용하세요.

ADetailer용 추가 모델을 설치하려면 CivitAI나 Huggingface에서 검색하세요.

Ultimate SD Upscaler

\ComfyUI\models\upscale_models

Ultimate SD Upscaler는 많은 시스템 자원을 사용합니다! 최종 이미지를 만들기 위해 4개 이상의 타일을 생성하고 병합하지만, 놀라운 수준의 디테일로 이미지를 향상시킵니다.

업스케일러 모델로 여러 가지를 테스트해본 결과, SwinIR 카테고리의 모델이 가장 좋았습니다.

Flux Redux (IP Adapter)

두 개의 파일이 필요합니다.

flux1-redux-dev:

https://huggingface.co/black-forest-labs/FLUX.1-Redux-dev/tree/main

ComfyUI\models\style_models

siglicp_vision_patch14_384

https://huggingface.co/Comfy-Org/sigclip_vision_384/blob/main/sigclip_vision_patch14_384.safetensors

ComfyUI/models/clip_vision

Flux Infill Inpaint

필요한 파일:

FLUX.1-Fill-dev:

https://huggingface.co/black-forest-labs/FLUX.1-Fill-dev/tree/main

ComfyUI\models\diffusion_models

=============================================

워크플로우:

F.1 img2img

버전 1.1: LORA 지원 추가 및 이미지 해상도 설정 기능 추가.

참고: img2img를 사용할 때 인물 LORA를 사용하면, LORA의 얼굴을 img2img 대상 신체에 적용하여 얼굴 교체 기능처럼 작동합니다.

=============================================

F.1 Style Changer (RF Inversion)

이 워크플로우는 이미지를 입력받아 FLUX와 LORAs를 사용해 스타일을 변경합니다.

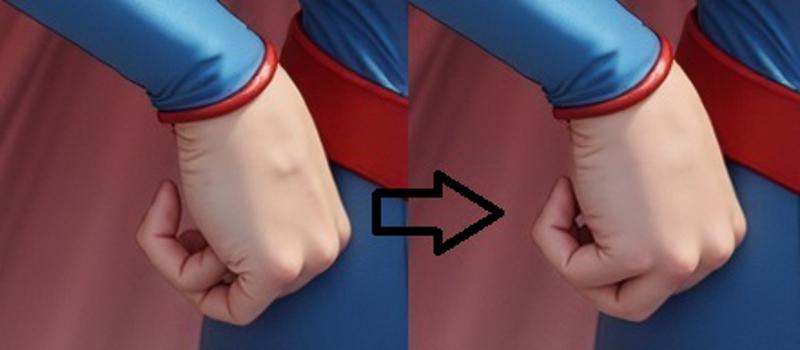

그 후 출력물을 Ultimate SD Upscaler를 거쳐 Adetailer로 전달하여 손 등 세부 요소를 개선합니다.

참고: 프롬프트는 비워두세요. 스타일링에는 LORAs만 사용하세요. 이 방식이 가장 효과적입니다.

참고: 캐릭터 LORA + 얼굴 Adetailer를 사용하면 이 단계에서 얼굴을 교체할 수 있습니다.

=============================================

F.1 text2img 4.0

이 워크플로우는 다음을 수행합니다:

text2img. 와일드카드, LORAs, 2x ControlNet을 사용할 수 있습니다.

Flux를 사용한 고해상도 보정

Ultimate SD Upscaler

LORA 지원을 포함한 최대 3개의 Adetailer

감지용 추가 모델은 CivitAI에서 손톱, 안경, 눈 등 찾을 수 있습니다. LORAs를 사용할 수 있습니다.

모델은 제안된 자원 섹션을 참조하세요. 현재 제가 사용하는 모델입니다.

참고: 어떤 노드나 기능을 사용하지 않으려면, 노드를 클릭하거나 Ctrl 키를 누른 채로 여러 노드를 선택한 후 Ctrl+B를 눌러 **무시(Bypass)**하세요(토글 기능).

LLM에 대한 참고사항: 현재 이 기능은 사용하지 않는 것이 좋습니다. 이미 오버홀드되었습니다. ChatGPT에 아이디어를 입력해 프롬프트를 생성해달라고 요청하세요. 무료 버전이라도 충분히 좋은 결과를 줍니다.

PRO TIP!

이 워크플로우는 각 단계마다 이미지를 생성합니다.

어떤 단계에서나 나쁜 결과가 나오면:

큐에서 프로세스를 취소하세요.

ComfyUI에 마지막으로 좋은 결과를 낸 이미지를 불러오세요(인터페이스에 드래그 앤 드롭).

문제를 일으킨 옵션을 수정하세요(예: Adetailer에서 노이즈를 증가하거나 감소시켜야 할 수 있음).

이미지를 생성하세요. 프로세스는 처음부터 다시 시작되지 않고, 현재 사용하는 이미지에서 이어서 진행됩니다. 따라서 시간을 절약할 수 있습니다! (적어도 캐시에 존재하는 경우, Adetailer에 일반적으로 적용됨).

예시에서 손 부분 보정이 부족했기 때문에 프로세스를 중단하고 마지막 좋은 이미지를 다시 불러온 후, 손부분 Adetailer 노드의 노이즈 값을 증가시켰습니다. 그 결과, 전체를 다시 생성하지 않고 마지막 단계(이 경우 Adetailer #2)에서 이어서 처리되었습니다.

예시에서 손 부분 보정이 부족했기 때문에 프로세스를 중단하고 마지막 좋은 이미지를 다시 불러온 후, 손부분 Adetailer 노드의 노이즈 값을 증가시켰습니다. 그 결과, 전체를 다시 생성하지 않고 마지막 단계(이 경우 Adetailer #2)에서 이어서 처리되었습니다.

=============================================

F.1 text2img LLM (即将到来 업데이트)

간단한 개념 프롬프트를 긴 설명문으로 변환하는 "모든 기능 통합" 개념은 흥미롭지만, ChatGPT를 사용해 프롬프트를 얻는 것이 훨씬 쉽고, 리소스를 소모하지 않으며 추가 모델이 필요하지 않습니다.

=============================================

SD TO FLUX Ultimate

참고: 이 워크플로우는 SD ControlNets(FLUX가 아님)를 필요로 합니다!

이 워크플로우는 다음을 수행합니다:

STEP 1: SD txt2img (SD1.5 또는 SDXL/PonyXL)

이 단계에서 ControlNet을 사용하므로, 올바른 모델(SD1.5 또는 SDXL)을 사용해야 합니다.

와일드카드와 SD LORAs 지원을 포함합니다.

STEP 2: Flux 고해상도 보정

SD LORAs 지원을 포함합니다.

STEP 3: Flux USDU. 업스케일과 향상용 각각 하나씩.

STEP 4: Adetailer(최대 6개, 일반적으로 얼굴과 손 사용)

중요한 점: 필요한 노이즈 값은 이미지에 따라 달라집니다. 어떤 단계에서나 나쁜 결과가 나오면 위의 PRO TIP을 사용하세요.

여기서는 품질이 가장 좋은 얼굴, 손, 발을 위한 3개의 Flux Adetailer를 추가했고, NSFW 지원을 위해 최대 3개의 SD Adetailer를 추가했습니다(SD는 특히 사진적이지 않은 스타일에서 훨씬 나은 결과를 내기 때문입니다).

=============================================

F.1 Fill Inpainting

1. "업로드할 파일 선택"을 클릭하고 인페인팅할 이미지를 선택하세요.

2. 이미지를 마우스 오른쪽 클릭하고 "Mask Editor에서 열기"를 선택하세요. 여기서 마스크를 그릴 수 있습니다.

3. 인페인팅을 완료하면 "저장"을 누르세요.

- 참고: 이 방식은 전체 이미지를 다시 계산하기 때문에 느리지만, 일반적으로 더 나은 결과를 제공합니다.

=============================================

F.1 Inpainting (다른 이미지에서 샘플링 사용)

1. "업로드할 파일 선택"을 클릭하고 인페인팅할 이미지를 선택하세요.

2. 이미지를 마우스 오른쪽 클릭하고 "Mask Editor에서 열기"를 선택하세요. 여기서 마스크를 그릴 수 있습니다.

3. 인페인팅을 완료하면 "노드에 저장"을 누르세요.

4. 샘플링: 동일한 이미지 또는 다른 이미지에서 요소를 가져와 인페인팅할 수 있습니다. 두 번째 이미지는 어떤 이미지라도 가능하지만, 크기는 동일해야 하거나 해당 크기로 조정해야 합니다. 두 번째 Load Image 노드에 이미지를 로드하고, 인페인팅 원본 이미지에 사용할 부분을 마스크로 지정하세요.

이 기능을 사용하지 않으려면, 두 번째 이미지 노드를 비활성화하세요 (Ctrl+B)

이 방식은 빠릅니다. 인페인팅된 영역만 다시 계산됩니다.

=============================================

SDXL 인페인팅 (다른 이미지에서 샘플링 사용)

이 워크플로우를 여기에 추가한 이유는?

현재 LORAs에서 특정 이미지 디테일을 얻지 못하고 있기 때문에, 이런 해결책이 필요합니다.

먼저 FLUX로 이미지를 생성한 후, SDXL, Pony 또는 SD1.5 모델을 사용하여 젖꼭지 등 세부 요소를 인페인팅하여 원하는 결과를 얻으세요.

왜 Adetailer를 사용하지 않나요? 매번 전체 이미지를 재생성해 세부 요소가 제대로 나오길 기다리는 것보다, 원하는 디테일만 여러 번 생성하는 것이 훨씬 빠릅니다. 특히 ComfyUI에서 그렇습니다.

샘플링: 이제 동일한 이미지 또는 다른 이미지에서 요소를 가져와 인페인팅할 수 있습니다. 두 번째 이미지는 어떤 이미지라도 가능하지만, 크기는 동일해야 하거나 해당 크기로 조정해야 합니다. 두 번째 Load Image 노드에 이미지를 로드하고, 인페인팅 원본 이미지에 사용할 부분을 마스크로 지정하세요.

- 이 기능을 사용하지 않으려면, 두 번째 이미지 노드를 비활성화하세요 (Ctrl+B)

=============================================

아웃페인팅:

100% 완벽하진 않지만, 한 변당 최대 256픽셀까지 확장하면 괜찮은 결과를 얻을 수 있습니다. 약간의 RNG(무작위성)가 필요할 수 있습니다.

=============================================

=============================================

더 이상 지원되지 않음 (폐기됨)

High-Res fix 1.3 LITE (폐기됨)

이 워크플로우는 2단계로 작동합니다:

text2img: 녹색 노드에서 dimension 버튼을 클릭하여 Flux 안전 해상도를 선택할 수 있는 노드를 추가했습니다.

img2img: 더 높은 해상도로 이미지를 재생성합니다. 녹색 노드에서 업스케일 팩터를 선택합니다(A1111과 유사).

버전 1.1: 각 단계의 미리보기를 추가했습니다.

버전 1.2: 전용 Flux 프롬프트 노드를 추가했습니다. 가이던스 스케일을 포함하지만, T5XXL 박스(하단)만 사용하세요.

버전 1.3: 보조 업스케일링을 제거했습니다. 별도의 워크플로우로 분리했습니다.

=============================================

High-Res fix CN (와일드카드, LORAs, ControlNet) (폐기됨)

참고: 버전 1.6+를 사용하세요. 이전 버전은 LORAs와 제대로 작동하지 않았습니다.

2단계 워크플로우:

Flux txt2img

Flux 고해상도 보정

이 워크플로우는 High-Res fix 1.3 LITE의 모든 기능에 와일드카드 및 LORAs 지원을 추가한 것입니다.

High-Res fix CN + Upscale (ControlNet, 와일드카드, LORAs, Ultimate SD Upscaler) (폐기됨)

3단계 워크플로우:

Flux txt2img

Flux img2img

Ultimate SD Upscale

이 워크플로우는 High-Res fix의 모든 기능과 함께 Ultimate SD Upscaler(최종 이미지의 한 타일씩 생성하여 확장)를 추가한 것입니다.

=============================================

text2img CN (ControlNet, 와일드카드, LORAs) (폐기됨)

1단계 워크플로우:

- Flux txt2img

와일드카드 및 LORA 지원을 갖춘 text2img. 이 워크플로우에는 고해상도 보정 기능이 없습니다.

이제 해상도 선택기를 포함합니다(자세한 설명은 위의 고해상도 버전 참조).

text2img CN + 업스케일 (ControlNet, 와일드카드, Loras, Ultimate SD 업스케일러) (폐기됨)

2단계 워크플로우:

Flux txt2img

Ultimate SD 업스케일

text2img와 동일하지만 Ultimate SD 업스케일러를 추가로 사용합니다.

text2img Adetailer (와일드카드, Loras, Adetailer) (폐기됨)

최대 3단계 워크플로우:

Flux txt2img

Adetailer #1

Adetailer #2 (필요하지 않으면 CTRL+B로 노드 비활성화)

각 Adetailer 단계는 독립적인 프롬프트와 LORA를 지원합니다.

=============================================

SDXL to FLUX CN (ControlNet, 와일드카드 및 Loras)

SDXL / PonyXL / SD1.5와 호환

2단계 워크플로우:

SD txt2img

Flux 고해상도 수정

이를 통해 선호하는 스타일로 이미지를 생성한 후 자동으로 FLUX를 사용해 img2img로 전송할 수 있습니다. 최상의 결과를 얻으려면 노이즈 제거 값(denoise value)을 조정해야 할 수 있습니다.

SDXL to FLUX CN + 업스케일러 (ControlNet, 와일드카드, Loras, Ultimate SD 업스케일러)

SDXL / PonyXL / SD1.5와 호환

3단계 워크플로우:

SD txt2img

Flux 고해상도 수정

Ultimate SD 업스케일러

=============================================

업스케일링: A1111 / Forge의 "EXTRA" 탭과 동일

\ComfyUI\models\upscale_models

제가 생각하기에 이미지를 업스케일하는 좋은 방법은 아니지만, 원하시면 포함했습니다.

업스케일링:

수학이 조금 특이합니다. x4 업스케일러를 사용하는 경우, x4는 자동으로 적용되므로 원하는 최종 확대 배율을 얻기 위해 해당 숫자에 원하는 배율을 곱해야 합니다.

예: 4 x 0.25 = 1 (업스케일링 없음)

원하는 어떤 업스케일러라도 사용하세요.