ControlNet Cannyでディテールアップ / DetailUpWithControlNetCanny

세부 정보

파일 다운로드

모델 설명

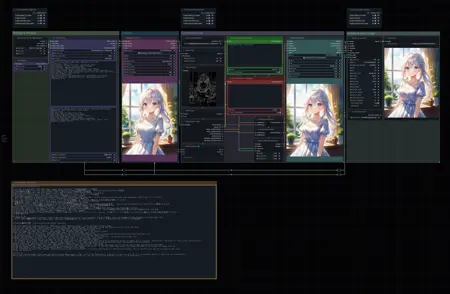

t2i에 이어 ControlNet Canny로 디테일을 업그레이드하는 ComfyUI 샘플 워크플로우입니다. UltimateSDUpscale을 통한 업스케일링을 지원합니다. 자유롭게 커스터마이징하여 사용해 주세요.

전제 조건 / Prerequisites

ComfyUI 및 ComfyUI-Manager가 설치되어 있어야 합니다.

ComfyUI and ComfyUI-Manager are installed.

커스텀 노드 / Custom nodes

다음 커스텀 노드를 사용합니다.

The following custom nodes are used.

사용 방법 / How to use

동일한 내용은 워크플로우 내의 Note 노드에도 기재되어 있습니다.

The same information is also written in the Note node in the workflow.

Settings & Prompts 그룹의 “SDXL Empty Latent Image (rgthree)”에서 생성할 이미지 크기를 설정하세요.

Settings & Prompts 그룹의 “Eff. Loader SDXL”에서 “base_ckpt_name”에 사용할 모델을, “base_clip_skip”에 CLIP Skip 값을 설정하세요.

LoRA를 사용하는 경우, Settings & Prompts 그룹의 “LoRA Stacker”에 사용할 LoRA를 설정하세요.

Settings & Prompts 그룹의 “Eff. Loader SDXL”에 포지티브 프롬프트와 네거티브 프롬프트를 입력하세요.

Generate 그룹의 “KSampler SDXL (Eff.)”에 스텝 수, CFG, 샘플러, 스케줄러를 설정하세요.

ControlNet Canny 그룹의 “Load ControlNet Model”에 사용할 Canny 모델을 설정하세요.

Canny 모델이 없는 경우 https://huggingface.co/diffusers/controlnet-canny-sdxl-1.0에서 diffusion_pytorch_model.fp16.safetensors을 다운로드하세요.

다운로드 후 파일 이름을 Canny 모델임을 알 수 있도록 리네임해두면 편리합니다.ControlNet Canny 그룹의 “Canny Edge” 파라미터를 원하는 대로 조정하세요. (잘 모르겠으면 그대로 사용하세요)

ControlNet Canny 그룹의 “CLIP Text Encode++ (Positive)”에 추가 포지티브 프롬프트를 입력하세요.

비워둬도 되지만, 추가 프롬프트를 입력하면 다양한 조정이 가능합니다.

예를 들어 샘플 워크플로우처럼 “Light particles”를 입력하면 t2i 이미지에 빛의 입자가 추가로 생성되고, “Satin dress”를 입력하면 드레스가 더 사틴 텍스처가 됩니다.

“Blue texture”를 입력하면 이미지 전체가 푸른 빛을 띠고, “Cat ears”를 입력하면 나중에 고양이 귀를 추가할 수 있습니다. 가능성은 무한합니다.ControlNet Canny 그룹의 “CLIP Text Encode++ (Negative)”에 추가 네거티브 프롬프트를 입력하세요.

ControlNet Canny 그룹의 “Apply ControlNet (Advanced)”의 strength 값을 원하는 대로 조정하세요. 이 값이 클수록 ControlNet의 효과가 강해집니다.

ControlNet Canny 그룹의 “KSampler (Efficient)”에 스텝 수, CFG, 샘플러, 스케줄러, denoise를 설정하세요. denoise 값이 클수록 t2i에 비해 변화가 커집니다.

Upscale & Save Image의 “Load Upscale Model”에 사용할 업스케일러를 설정하세요.

Upscale & Save Image의 “Ultimate SD Upscale”에 스텝 수, CFG, 샘플러, 스케줄러, denoise 및 기타 파라미터를 설정하세요. (잘 모르겠으면 그대로 사용하세요)

생성을 실행하세요.

Set the image size to be generated in “SDXL Empty Latent Image (rgthree)” in the Settings & Prompts group.

In the "Eff. Loader SDXL" in the Settings & Prompts group, set "base_ckpt_name" to the model to use and "base_clip_skip" to the CLIP Skip.

If you use LoRA, set the LoRA you want to use in "LoRA Stacker" in the Settings & Prompts group.

Enter positive and negative prompts in "Eff. Loader SDXL" in the Settings & Prompts group.

Set the number of steps, CFG, sampler, and scheduler in “KSampler SDXL (Eff.)” in the Generate group.

Set the Canny model to be used in “Load ControlNet Model” of the ControlNet Canny group.

If you don’t have the Canny model, download diffusion_pytorch_model.fp16.safetensors from https://huggingface.co/diffusers/controlnet-canny-sdxl-1.0.

After downloading, it is convenient to rename the file so that it can be identified as a Canny model.Adjust the parameters of "Canny Edge" in the ControlNet Canny group to your liking. (If you are not sure, use the settings as they are.)

Enter additional positive prompt to "CLIP Text Encode++ (Positive)" in the ControlNet Canny group.

You can leave this blank, but you can make various adjustments by entering additional prompts.

For example, if you enter "Light particles" as in the sample workflow, additional light particles will be generated in the t2i image, and if you enter "Satin dress", the dress will have a more satin texture.

If you input "Blue texture" the entire image will have a blue tint, if you input "Cat ears" you can add cat ears later; the possibilities are endless.Enter additional negative prompts to "CLIP Text Encode++ (Negative)" in the ControlNet Canny group.

Adjust the strength of "Apply ControlNet (Advanced)" in the ControlNet Canny group to your liking. The higher the value here, the stronger the effect of ControlNet.

Set the number of steps, CFG, sampler, scheduler, and denoise in the "KSampler (Efficient)" of the ControlNet Canny group. The larger the denoise, the larger the change from t2i.

Set the upscaler to be used for "Load Upscale Model" in Upscale & Save Image.

Set the number of steps, CFG, sampler, scheduler, denoise, and other parameters in "Ultimate SD Upscale" of Upscale & Save Image. (If you are not sure, use the settings as they are.)

Run the generation.

포인트 / Point

상단의 “Fast Groups Muter (rgthree)”에서 ControlNet Canny 그룹과 Upscale & Save Image 그룹을 “No”로 설정하면 t2i만 실행되므로 생성을 반복하기가 더 쉬워집니다.

워크플로우가 가로로 길기 때문에 “Fast Groups Muter (rgthree)”를 여러 개 추가했습니다. 각 그룹의 “->”를 클릭하면 해당 그룹으로 이동할 수 있습니다.

If you set the ControlNet Canny group and Upscale & Save Image group to "No" in the "Fast Groups Muter (rgthree)" at the top, only t2i will be executed, making it easier to retry generation.

Since the workflow is horizontal, I added multiple "Fast Groups Muter (rgthree)". You can jump to each group by clicking "->" of each group.

英文은 Google翻訳を使用して翻訳されています。

The English text has been translated using Google Translate.