Lighting based picture control controlnet

詳細

ファイルをダウンロード

モデル説明

ioclab/control_v1u_sd15_illumination_webui · Hugging Face

先週、詳細な説明を追加できず、誠に申し訳ありませんでした。勤務時間の関係で今から補足させていただきます。

これは深度と似たControlNetですが、0から1までの光影構成を制御可能なControlNetでもあります。

先週、詳細な説明を追加できず、誠に申し訳ありませんでした。勤務時間の関係で今から補足させていただきます。

これは深度と似たControlNetですが、0から1までの光影構成を制御可能なControlNetでもあります。

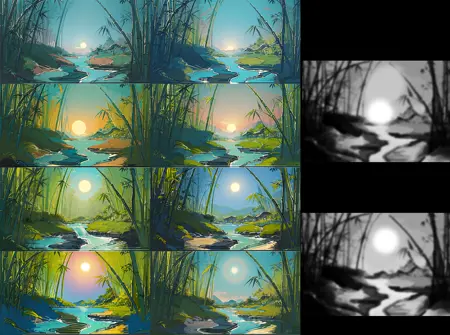

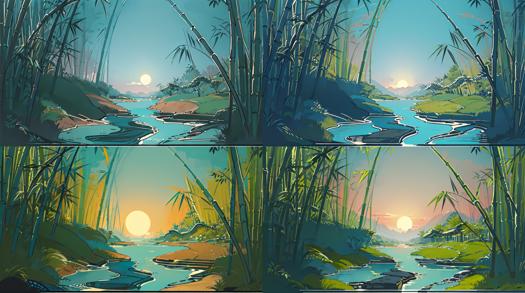

0-1の光影構成制御 —— テキスト to 画像

- 0-1の光影構成制御 —— テキスト to 画像

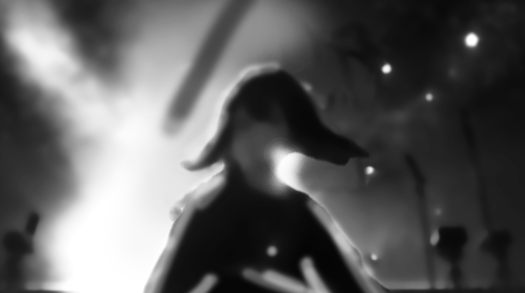

絵師の方、またはPhotoshopなどのソフトで画像を移動・合成できる方は、以下のように、ご希望の構図を表す画像を制作できます。下の図のように、左側にスポットライトのような視覚的焦点を、空気中にちらちらと浮かぶ輝く光点を設定したいと思っています。

- 絵師の方、またはPhotoshopなどのソフトで画像を移動・合成できる方は、以下のように、ご希望の構図を表す画像を制作できます。下の図のように、左側にスポットライトのような視覚的焦点を、空気中にちらちらと浮かぶ輝く光点を設定したいと思っています。

この画像をControlNetの入力として使用し、ウェイトを0.6、エントリー時間を0.65(後述)に調整。プロンプトに「masterpiece, best quality, High contrast, dim environment, bright lights, 1girl, standing in the center of the stage, spotlight hit her, ((floating stars))」を入力します。

以下の結果を得ることができます:

この画像をControlNetの入力として使用し、ウェイトを0.6、エントリー時間を0.65(後述)に調整。プロンプトに「masterpiece, best quality, High contrast, dim environment, bright lights, 1girl, standing in the center of the stage, spotlight hit her, ((floating stars))」を入力します。

以下の結果を得ることができます:

従来の画像生成と比べ、この方法により明暗の関係がより明確に制御できることがわかります。それでは、次の修正を行いましょう。

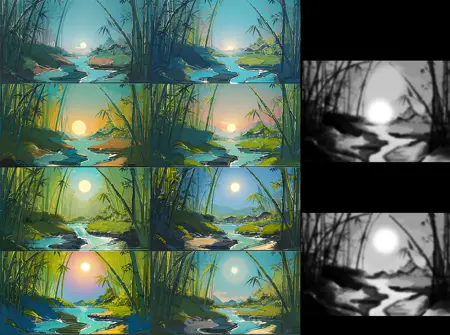

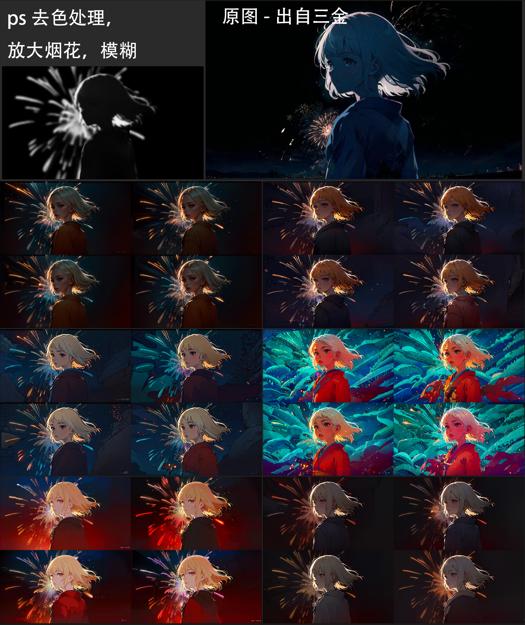

右下の構図が気に入っていますが、女の子の光影の層がもっと豊かで、服に反射光が入るようにしたいです。また、比率の調整も行いたいです。Photoshopや他の画像ソフトを使って、色を落とし、ガウスぼかし、マット作成のステップを経て、以下の画像を得ることができます。あるいは、ご自身の好みに応じて再描画することも可能です。

従来の画像生成と比べ、この方法により明暗の関係がより明確に制御できることがわかります。それでは、次の修正を行いましょう。

右下の構図が気に入っていますが、女の子の光影の層がもっと豊かで、服に反射光が入るようにしたいです。また、比率の調整も行いたいです。Photoshopや他の画像ソフトを使って、色を落とし、ガウスぼかし、マット作成のステップを経て、以下の画像を得ることができます。あるいは、ご自身の好みに応じて再描画することも可能です。

画像を提供する際には、ぼやけた画像を選ぶと、AIがより多くの詳細を補完してくれます。

次にプロンプトとControlNetの入力を調整し、画像を出力します。この過程でLoRAや他のControlNetを使用して、より強い画面制御を実現できます。このControlNetは、HDRコントラストの調整を保持しており、過曝・過暗になることなく、画像の細部が失われません。一般的なノイズオフセットなどのコントラストを高める映像LoRAと併用可能です。この過程で過適合などの現象が見られたら、ControlNetの重みやエントリー時間を適度に下げてください。

以下のような画像が得られます:

画像を提供する際には、ぼやけた画像を選ぶと、AIがより多くの詳細を補完してくれます。

次にプロンプトとControlNetの入力を調整し、画像を出力します。この過程でLoRAや他のControlNetを使用して、より強い画面制御を実現できます。このControlNetは、HDRコントラストの調整を保持しており、過曝・過暗になることなく、画像の細部が失われません。一般的なノイズオフセットなどのコントラストを高める映像LoRAと併用可能です。この過程で過適合などの現象が見られたら、ControlNetの重みやエントリー時間を適度に下げてください。

以下のような画像が得られます:

「floating star」のように明るさを含む語は、画面内の最も明るい部分へと誘導されていることがわかります。この原理を活かして、刀の光、星、水しぶきなど従来困難だった要素の誘導が可能になります。最後の例をご覧ください。

生成された画像が以下のように、人物が希望の位置に出現しない場合は、以下の対応が可能です。

「floating star」のように明るさを含む語は、画面内の最も明るい部分へと誘導されていることがわかります。この原理を活かして、刀の光、星、水しぶきなど従来困難だった要素の誘導が可能になります。最後の例をご覧ください。

生成された画像が以下のように、人物が希望の位置に出現しない場合は、以下の対応が可能です。

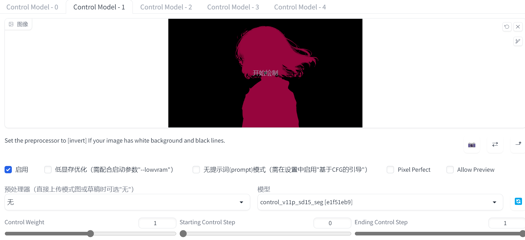

この場合、ロールを継続するか、構図を調整する選択が可能です。しかし、私たちは独りではない!これはControlNetであり、他のControlNetと完璧に連携可能です。過去のControlNetには、以下のようなセグメントを使用することができます(やや不格好ですが、AIは理解可能です):

- この場合、ロールを継続するか、構図を調整する選択が可能です。しかし、私たちは独りではない!これはControlNetであり、他のControlNetと完璧に連携可能です。過去のControlNetには、以下のようなセグメントを使用することができます(やや不格好ですが、AIは理解可能です):

第二のControlNetを有効にすると、キャラクターが正しい位置に表示されることがわかります。この論理により、他のControlNetとも連携できます。

- 第二のControlNetを有効にすると、キャラクターが正しい位置に表示されることがわかります。この論理により、他のControlNetとも連携できます。

今後、tileやimg2imgで高精細化を行うことも可能で、解像度を上げてhiresを有効化し、シードを変更することで、AIがt2iでどのように異なる結果を生成するかを確認できます。保持された星、左端の焦点、照らされた髪や首など、以下のように確認できます。

- 今後、tileやimg2imgで高精細化を行うことも可能で、解像度を上げてhiresを有効化し、シードを変更することで、AIがt2iでどのように異なる結果を生成するかを確認できます。保持された星、左端の焦点、照らされた髪や首など、以下のように確認できます。

別のckptを試してみましょう。この関係は維持されますか?

答えは「はい」です!

別のckptを試してみましょう。この関係は維持されますか?

答えは「はい」です!

このControlNetにより、AIは画像生成時に、どこが影で、どこが明るい部分であるべきかを認識できるようになります。

- このControlNetにより、AIは画像生成時に、どこが影で、どこが明るい部分であるべきかを認識できるようになります。

1-1.5の光影調整

- 1-1.5の光影調整

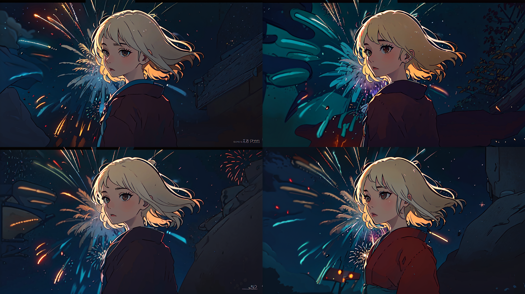

この例画像では、髪の端の光や背景の花火が非常に気に入っています。自分専用のckptでこれを再現したいと考えています。しかし、SDを再度ロールさせると、保持したい構図が失われる可能性があるため、Photoshopで花火をカットして、以下の入力を作成しました。

- この例画像では、髪の端の光や背景の花火が非常に気に入っています。自分専用のckptでこれを再現したいと考えています。しかし、SDを再度ロールさせると、保持したい構図が失われる可能性があるため、Photoshopで花火をカットして、以下の入力を作成しました。

さらに、オリジナル画像があったため、以下のsegを作成しました。

- さらに、オリジナル画像があったため、以下のsegを作成しました。

- 以下をどうぞ!

はい、同じ構図、同じ髪の端の光ですが、より大きな花火が出現しました!ControlNetとSDがプロンプトを理解することで、花火が明るい関係として、期待通りの場所に出現しました!

ベースを変更して、さらに効果を確認してみましょう。保持したいすべての要素はそのまま維持されています:

はい、同じ構図、同じ髪の端の光ですが、より大きな花火が出現しました!ControlNetとSDがプロンプトを理解することで、花火が明るい関係として、期待通りの場所に出現しました!

ベースを変更して、さらに効果を確認してみましょう。保持したいすべての要素はそのまま維持されています:

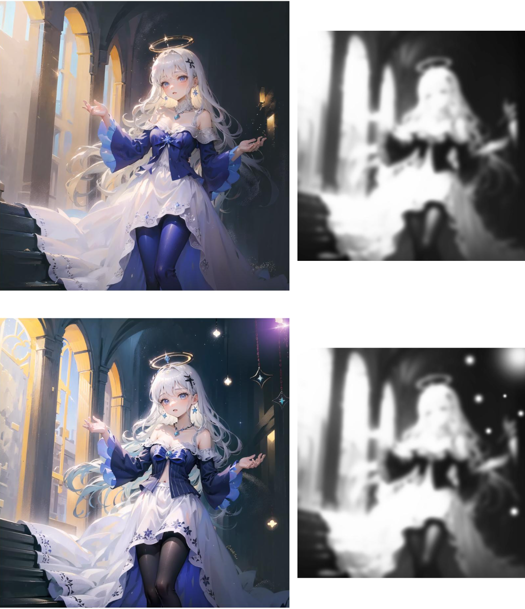

同様に、画像に新しい光源や浮遊物を追加することも可能です。

- 同様に、画像に新しい光源や浮遊物を追加することも可能です。

刀身に金属光を追加し、周囲に水しぶき/刀の光を誘導することもできます。背後に灯を加えることも可能。しっかり描く必要はありません。意図さえ伝われば十分です。

- 刀身に金属光を追加し、周囲に水しぶき/刀の光を誘導することもできます。背後に灯を加えることも可能。しっかり描く必要はありません。意図さえ伝われば十分です。

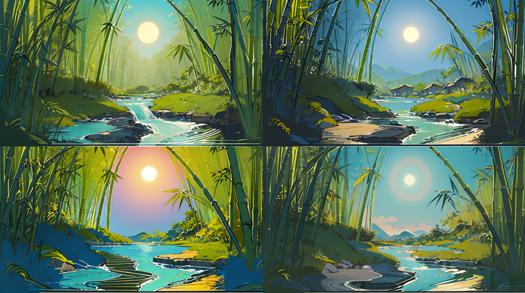

他の場面でも、このControlNetは意味を保存しており、以下のような画像を作ることができます:

- 他の場面でも、このControlNetは意味を保存しており、以下のような画像を作ることができます:

使い方:

- 使い方?

ControlNetと同じモデルフォルダにダウンロードして入れれば完了。モデルリストを更新するだけでOKです。現在、統一されたプレプロセッサは用意されていませんが、ご意見があればコメントをお願いします。

- ControlNetと同じモデルフォルダにダウンロードして入れれば完了。モデルリストを更新するだけでOKです。現在、統一されたプレプロセッサは用意されていませんが、ご意見があればコメントをお願いします。

QA:

img2imgも似た効果が得られますが、何が違いますか?

はい、過去にはimg2imgや他の方法で明暗の出現を制御していた事例もありましたが、制御には複数回のロールやより詳細な操作が必要な場合が多くありました。ControlNetを使うことで、t2i段階でより多くの制御と可能性が得られるだけでなく、0からの構図の実現や、ラフレイアウトの作成をよりサポートします。

img2imgも似た効果が得られますが、何が違いますか?

はい、過去にはimg2imgや他の方法で明暗の出現を制御していた事例もありましたが、制御には複数回のロールやより詳細な操作が必要な場合が多くありました。ControlNetを使うことで、t2i段階でより多くの制御と可能性が得られるだけでなく、0からの構図の実現や、ラフレイアウトの作成をよりサポートします。

なぜ画像がうまくいかず、過適合しているように見えるのですか?

このControlNetは大量の実データセットで学習されたため、現実の明暗と画像の対応関係を学習しています。アニメなどのシーンで使用する際は、重みとエントリー時間を下げて調整する必要があります。0.6の重み、0.6のエントリー時間で試してみてください。次のバージョンで改善を進める予定ですので、皆様のごフィードバックをお待ちしています!

なぜ画像がうまくいかず、過適合しているように見えるのですか?

このControlNetは大量の実データセットで学習されたため、現実の明暗と画像の対応関係を学習しています。アニメなどのシーンで使用する際は、重みとエントリー時間を下げて調整する必要があります。0.6の重み、0.6のエントリー時間で試してみてください。次のバージョンで改善を進める予定ですので、皆様のごフィードバックをお待ちしています!

他の例や討論がありますか?

私もControlNetをトレーニングしたいのですが、どう始めればいいですか?