AnimateDiff LCM Workflow - Img2Vid with SparseNet

詳細

ファイルをダウンロード

このバージョンについて

モデル説明

SparseCtrl アニメーション ComfyUI ワークフロー ガイド

この AnimateDiff LCM アニメーションワークフロー は、細かなアニメーションを簡単に実現し、低VRAM環境でも互換性を持たせるように設計されています。このワークフローは、複数のモデル、コントロールネット、カスタムノードを統合し、Stable Diffusionを用いて洗練された高品質なアニメーションを生成します。

システム設定とダウンロード:はじめに

この設定を再現するには、複数のモデルファイルとカスタムノードが必要です。以下に必要な項目をリストアップします:

推奨チェックポイント:AniVerse - V5.0、IMP、PerfectDeliberate、および PhotonLCM などの高品質なStable Diffusionチェックポイント。

AnimateDiff モーションモデルとLoRA:wangfuyunによるAnimateLCM – スムーズなフレーム単位のアニメーションを実現するためのモーションモデルとLoRAを含みます。

高度なControlNet:KosinkadinkによるAdvanced ControlNet – スケジューリング、マスキング機能、スライディングコンテキスト対応を追加し、洗練されたアニメーション制御を可能にします。

SparseCtrl コントロールネット:SparseCtrl – 精密なモーションガイドのためのスパース制御を提供します。

QRcode Monster コントロールネット:QRcode Monster – 本ノードは変形アニメーションを担当します。

Clip Vision モデル:Clip Vision – 画像条件付けを強化するために不可欠です。

アップスケーラーモデル:4x NMKD Siax アップスケーラー – アニメーションの最終アップスケール処理に使用され、鮮明で高品質な仕上がりを保証します。

ヒント:これらのモデルをComfyUIの適切なディレクトリに配置してください(例:./models/checkpoints、./models/controlnets、./models/upscalers)。

アニメーション作成の入力ステップ

初期設定を構成する:

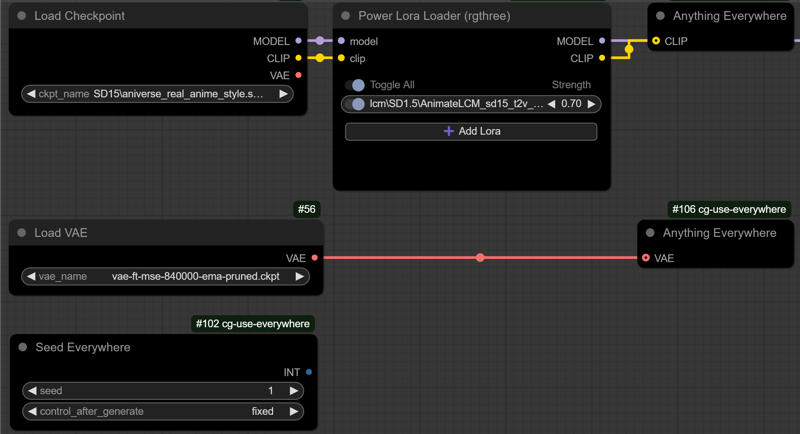

チェックポイント:AniVerse V5.0 などのStable Diffusionチェックポイントを選択します。

必須LoRA:AnimateLCM_sd15_t2v_lora(強度:0.5 - 1.0)

オプションLoRA:特定の機能を強化するために、使用したいLoRAモデルを追加してください。

VAE、シード、プロンプト:画像品質用にVAEを設定し、一貫性を保つためにシードを指定します。

追加制御用モデル:詳細ノードで使用されるCLIP VisionおよびSAMモデルを選択してください。

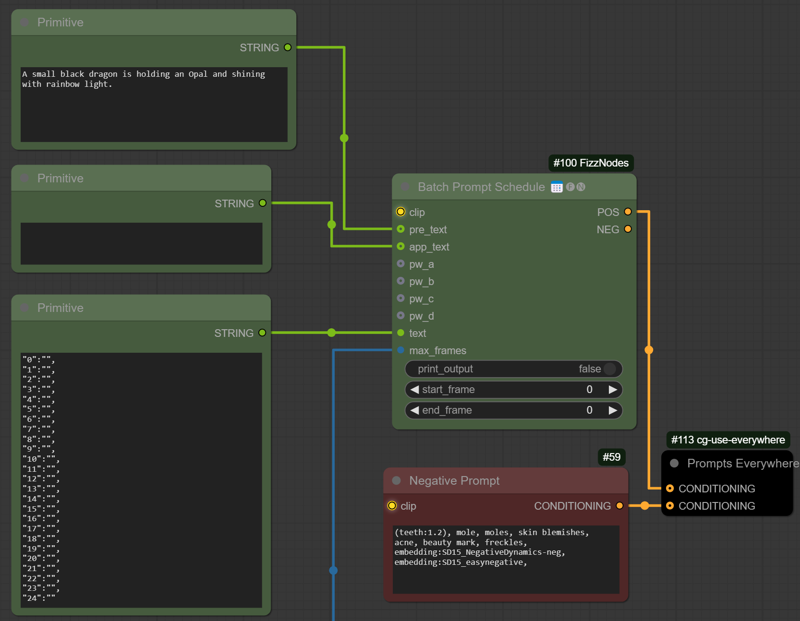

プロンプト作成:

簡潔さが重要です。特定のフレームでプロンプトを変更するには「プロンプト移動」機能を利用できます。

入力画像の準備:

* **リサイズと調整**:アニメーションのベースとなる入力画像をアップロードし、IPAdapterとSparseCtrlコントロールネットとの互換性を確保するためにリサイズしてください。

* **品質チェック**:画像の寸法を最適化することで、IPAdapterとSparseCtrlがより効果的に処理し、滑らかなアニメーションを生成できます。

(ヒント:ワークフロー全体をキューに追加する前に、右クリックで「queue group output nodes (rgthree)」を選択して、画像のリサイズやトリミングの調整を確認してください。)

AnimateDiff 設定:

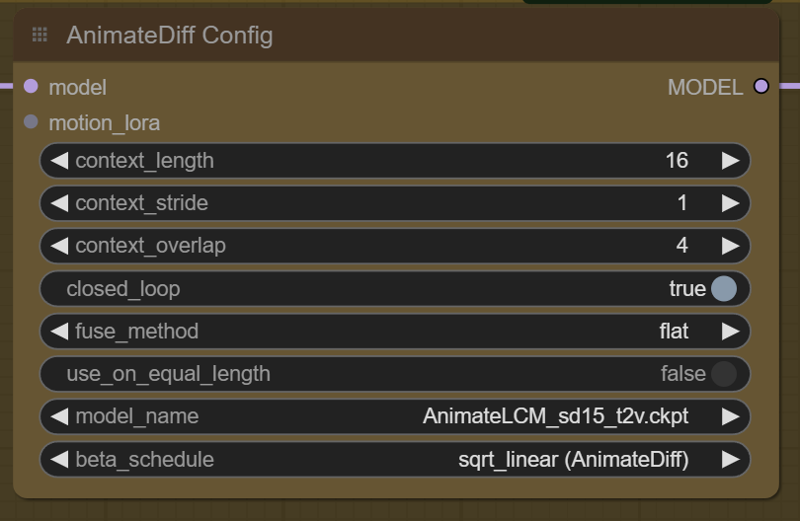

AnimateDiff モデル:スムーズな動きを意図して設計されたAnimateDiff LCMモデルを読み込みます。

スケジューラとループの設定:フレームの変化を制御するためにベータスケジューラを使用し、継続的なアニメーションのためにループを有効にしてください。(モデルはcontext_length=16、context_overlap=4で学習されています。調整は可能ですが、結果は変わる可能性があります。)closed_loopオプションでループの有無を選択してください。

コントロールネット設定:

コントロールネット強度の調整:SparseCtrlとQRcode Monsterコントロールネットはデフォルト設定で良好に動作しますが、強度を調整することでアニメーションの動きを微調整できます。

オプションのカスタマイズ:アニメーションのスタイルにさらに影響を与えるには、コントロールネットのパラメータを実験的に調整し、望ましい効果に合わせてください。

アニメーション品質の向上のための処理ステップ

初期粗いサンプル作成:

- このステップは動きの基盤となる粗いアニメーションを生成します。最初はカクカクして見えるかもしれませんが、これは後続の精緻化のための基礎的な処理です。

潜在変数のアップスケールと再サンプリング(Highres Fix):

- 画像品質を向上させるために高解像度修正を適用します。この潜在変数のアップスケールはアーティファクトを低減し、特に低VRAM環境で生成されたアニメーションの明瞭度を向上させます。

顔と目の詳細化:

クローズアップアニメーションで一般的なアーティファクトを軽減するために、顔と目の詳細化ノードを使用します。このオプションステップにより、より滑らかで自然な顔のアニメーションが実現できます。

VRAMの制限が発生する場合は、このステップをスキップして処理速度を最適化してください。

最終アップスケールと30 FPSへの補間:

最終アップスケール処理では、4x NMKD Siax アップスケーラーモデルを用いて解像度を向上させます。

30 FPS 補間:この最終ステップではフレームを補間して動きを滑らかにし、30フレーム/秒の流動的なアニメーションを完成させます。

ヒントと推奨事項

設定の実験:チェックポイントモデル、画像サイズ、コントロールネット強度、IPAdapter設定などのパラメータを調整すると、アニメーション品質に大きな影響を与えます。

VRAM制約への対応:このワークフローは低VRAM環境でも十分に動作します。メモリ問題が発生した場合は、顔の詳細化ステップをスキップしたり、画像解像度を下げることで簡素化してください。

カスタムノード:この設定ではComfyUIマネージャーの複数のカスタムノード(MTB、Efficiency、AnimateDiff、RIFE、Face Detailer)を使用しています。すべてのカスタムノードがインストールされ、最新であることを確認してください。

最後に

このSparseCtrlアニメーションワークフローは、強力な動き、高品質、詳細なツールを組み合わせて、表現豊かなアニメーションを簡単に作成できる方法を提供します。Stable Diffusionアニメーションに初めて挑戦する方にとって、このガイドは堅実な出発点となるでしょう。

実験を楽しんでください。フィードバックやトラブルシューティングの質問は遠慮なくお寄せください。

このページに画像を投稿していただけると、コミュニティの反響が高まります ⚡⚡⚡😊