Hunyuan 🌻 AllInOne

详情

下载文件

模型描述

HUNYUAN | 全能一体化

别给我发消息了. 更欢迎反馈。| 最后更新:2025年3月6日

⬇️ 官方图像转视频 V2 模型已发布!⬇️ 需要更新 COMFYUI !

下载文件:

链接 1 请粘贴至:\models\clip_vision

链接 2 或 链接 3 请粘贴至:\models\diffusion_models(请选择最适合你的版本)

⚠️ I2V 模型已于 2025年3月7日更新 ⚠️

这些工作流经过多次测试与优化逐步演进,

也感谢本社区巨大的贡献。

所需条件、特别致谢及鸣谢详见上方。

评论前请务必注意:

高级(Advanced) 和 极致(Ultra) 工作流专为有经验的 ComfyUI 用户设计。

若你选择安装不熟悉的节点,需自行承担全部责任。我只是在空闲时间出于兴趣随机制作这些工作流。

你可能遇到的大多数问题,都已在 Discord、Reddit、GitHub 上被广泛讨论并解决,

并在你所使用的工作流对应的说明中已有阐述,因此请…仔细阅读…

并在评论前先做些搜索。我最初独自开启这个项目,如今已有一小群人怀着热情、实验与新发现积极贡献。详见下方鸣谢。

正是由于他们的贡献,这个小项目才持续成长与优化,

惠及所有人。快速 LoRA 在与其他 LoRA 结合使用时效果可能最佳,可减少步数。

- Wave Speed 可显著缩短推理时间,但可能引入伪影。

- 要获得理想结果,需测试不同设置。默认配置未必始终有效,尤其在使用 LORA 时,建议多尝试以找到最适配的参数。不存在适用于所有情况的通用设置。

- 你还可以尝试切换不同的采样器/调度器,看看哪种最适合你的情况,例如:UniPC simple、LCM simple、DDPM、DDMPP_2M beta、Euler normal/simple/beta,或全新的“Gradient_estimation”

(采样器/调度器需为每个阶段和模式单独设置;它们不是控制台中的常规设置)

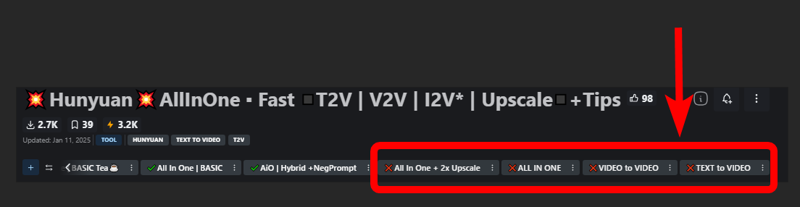

帮助你选择合适工作流的图例:

✔️ 绿色对勾 = 该类别最新版本。

包含最新设置、技巧、更新节点和采样器,兼容最新版 ComfyUI。

🟩🟧🟪 颜色 = 基础 / 高级 / 极致

❌ = 基于已弃用节点,若坚持使用,需自行修复。

快速提示:

显存低?试试这个:

并/或尝试使用此处提供的 GGUF 模型: https://huggingface.co/city96/HunyuanVideo-gguf/tree/main

并/或尝试使用此处提供的 GGUF 模型: https://huggingface.co/city96/HunyuanVideo-gguf/tree/main

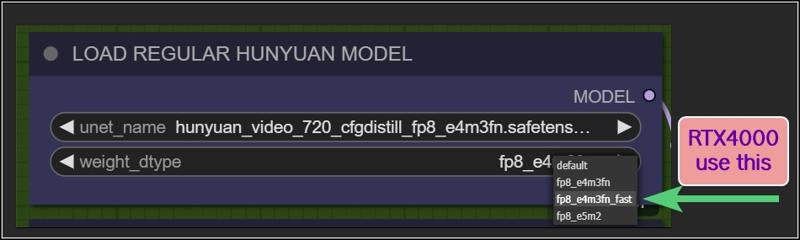

RTX 4000?使用这个:

想要更多提示?

查看我的文章: https://civitai.com/articles/9584

本页面所有工作流均以效率为先,力求快速输出高质量结果。

用户可通过直观、快速访问的控制界面轻松自定义设置。

若追求极致画质与模型所能实现的最佳输出,可能需要调整设置,例如:增加步数、修改分辨率、降低 TeaCache / WaveSpeed 的影响,或完全禁用快速 LoRA 以提升效果。

我个人追求的是质量与速度的最佳平衡。我分享的所有示例视频均采用这些工作流的默认设置。虽然我可能根据场景微调宽高比、分辨率或步数,但这些默认设置通常提供最全面的性能表现。

工作流说明:

🟩"I2V 官方版"_

所需文件:

llava_llama3_vision: ➡️链接 请粘贴至:\models\clip_vision

https://github.com/pollockjj/ComfyUI-MultiGPU

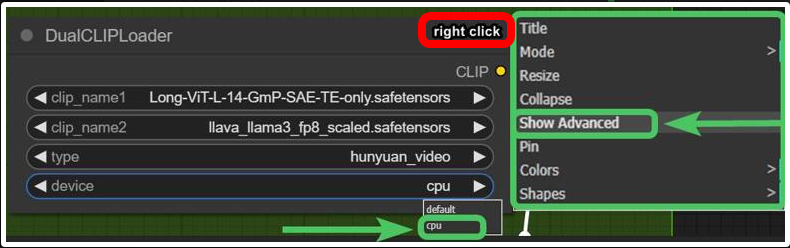

下方节点用于 SAGE ATTENTION,若未安装,请直接跳过:

🟩"基础版 全能一体化"

使用原生 Comfy 节点,支持三种操作模式:

T2V

I2V(某种形式:将图像重复 *x 帧后送入潜空间,去噪水平被平衡以保留原始图像的结构、构图与色彩。我发现该方法极具价值,既能节省推理时间,又能更精准地引导结果。但显然,这会牺牲整体运动性——若过度降低去噪水平,最终结果会趋于静止、运动微弱。去噪阈值由你根据需求自行决定。)

有其他方法可实现更精确的图像转视频,但速度较慢。我甚至未在工作流中加入负向提示,因它会使等待时间翻倍。

V2V 概念同上 I2V

所需文件:

https://github.com/chengzeyi/Comfy-WaveSpeed

https://github.com/pollockjj/ComfyUI-MultiGPU

🟧 "高级版 全能一体化 TEA ☕"

基础版全能一体化 TEA ☕ 的增强版本,新增更快的上采样方法,并为 I2V 和 V2V 集成轻量级字幕系统,仅额外占用 100MB 显存。

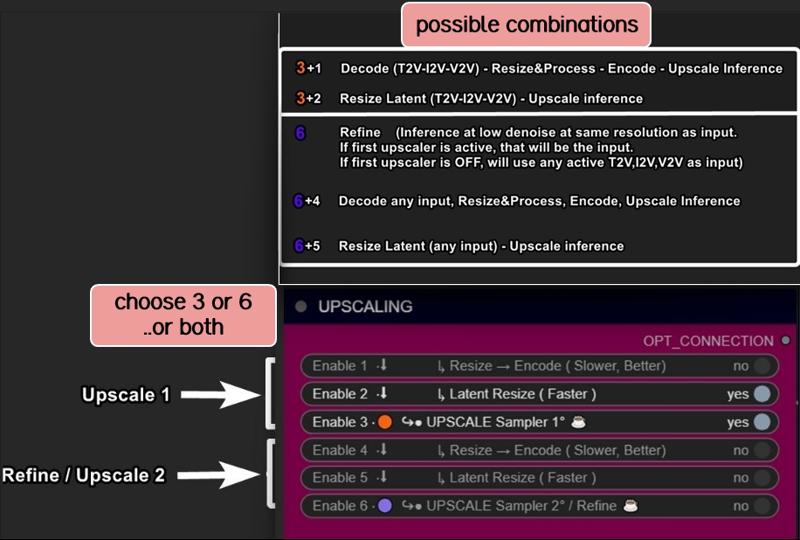

上采样可通过三种方式实现:

使用模型上采样。画质最佳。速度较慢(“精炼”为可选步骤)

经典上采样 + 精炼。采用我从大量视频上采样模型中精选的特殊模型,是速度最快之一,可获得对比度良好、线条清晰的结果。单独使用并非最优,但与“精炼”步骤结合时,能生成清晰视频。此选项为前两种方法之间的折中方案。

潜空间上采样 + 精炼。我最偏爱的方式。最快,效果尚可。

此方法本质上与第一种相同,即 V2V,但步数和去噪水平略低。

三种方法,更多选择,按你偏好任选。

所需文件:

- ClipVitLargePatch14

下载 model.safetensors

将其重命名为 clip-vit-large-patch14_OPENAI.safetensors

粘贴至 \models\clip

- RealESR General x4 v3

粘贴至 \models\ESRGAN\

- -LongCLIP-SAE-ViT-L-14

- https://github.com/pollockjj/ComfyUI-MultiGPU

- https://github.com/chengzeyi/Comfy-WaveSpeed

更新日志:

|1.1|

上采样更快

设置优化

|1.2|

移除冗余,逻辑优化

修复若干错误

新增视频加载框,可直接加载视频进行上采样

|1.3|

全新提示系统。

现可复制粘贴任何网络上的提示,系统将自动修改你不喜欢的词,或添加额外随机词。

修复了若干潜空间自动切换的 Bug(曾让我头疼不已)

修复种子问题:锁定种子现在会同步锁定采样过程

UI 界面清理

|1.4|

批量视频处理 – 节省大量时间!

现在可以先以最低画质生成多段视频,再统一排队进行上采样、精炼或插值处理。

只需指定视频保存的文件夹,系统将自动完成后续处理。

为每个阶段(上采样/精炼)添加种子选择器

现在可以,例如:在初始生成阶段锁定种子,而在上采样或精炼阶段随机化种子。

增加视频预览空间

生成高竖屏视频时不再出现节点重叠(当然,比例不要过度夸张)

扩展采样器预览空间

在管理器中启用预览功能,可实时观察生成进度。

若你对当前结果不满意,可随时中止。(我通常关闭预览,因启用会略微延长处理时间,但某些情况下非常有用。)

UI 优化

清理了部分线路连接(“面条”),移除冗余,全面提升效率。

所有核心节点均用蓝色高亮,并紧贴在对应视频节点下方,而开关、逻辑、数学等后台复杂模块则移至下方。现在你可以更轻松地更改设置或替换为你喜欢的节点。通知功能

所有与浏览器通知相关的节点(部分用户觉得烦人)已被移至最底部并用灰色标注。若你觉得干扰,可快速找到、选中并删除。

|1.5|

- 通用优化,修复若干 Bug

NB:

控制台中的这两个错误完全无需担心,忽略即可。

WARNING: DreamBigImageSwitch.IS_CHANGED() got an unexpected keyword argument 'select'

WARNING: SystemNotification.IS_CHANGED() missing 1 required positional argument: 'self'_

🟪 "全能一体化 | 极致版 "

拥抱这款强大的批量视频生产猛兽!

此版本专为真正勇敢的专业用户设计,解锁海量可能性。

同时提供更高画质、更锐利视频、更快速度,且几乎无故障。

所有旧版工作流均已更新以最小化故障,详见我上一篇文章。

从概念到创作,速度创纪录!

我们正实现世界纪录级的速度,但代价是复杂度提升。尽管我们努力保持界面整洁,尽可能将自动化隐藏在后台,这些工作流仍变得愈发令人望而生畏。

因此,我称此工作流为 “极致版”:专为执着的 Hunyuan 用户打造,助你在最短时间内,凭借手边所有工具,达成最佳效果。

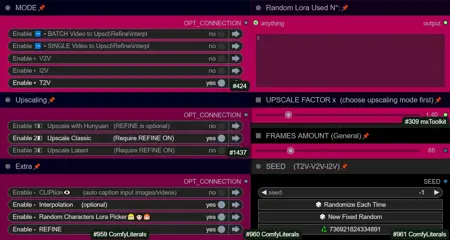

核心功能与改进:

便捷控制台:内置按钮,无需连接线缆或切换界面即可激活各阶段。所有功能集中于一个“控制中心”,操作极为便捷。

支持 T2V、I2V*、V2V、T2I、I2I:不同工作流间无缝切换。

*I2V:图像被复制为 *x 帧后送入潜空间。官方 I2V 模型尚未发布,当前可用此处技巧实现,需配合 Kijai 的节点。

通配符 + 自定义提示选项:可在经典提示+通配符与专用框中添加随机词之间切换,支持自动自定义词替换或屏蔽。

视频加载:可直接将视频导入上采样器/精炼器,跳过初始推理阶段。

批量视频处理:通过指定自定义文件夹,可依次上采样或精炼多个视频。

插值:平滑帧过渡,提升视频质量。

随机角色 LoRA 选择器:除固定 LoRA 加载器外,额外包含 9 个 LoRA 节点。

放大选项:支持放大、双放大和缩小过程。

通知:每个阶段完成后接收通知,通知集中在一个独立区域,方便必要时移除。

轻量级字幕:为 I2V 和 V2V 提供字幕功能,仅额外占用 100MB VRAM。

虚拟 VRAM 支持。

使用 GGUF 模型配合虚拟 VRAM 来生成更长的视频或提升分辨率。

Hunyuan/Skyreel (T2V) 快速合并滑块

通过滑块在常规模型与虚拟 VRAM/GGUF 之间切换

潜在预览:缩短放大过程。

专用的 LoRA 线 仅用于放大器,可通过专用按钮开启/关闭。

RF 编辑织机

使用 放大倍数 或“设为最长尺寸”目标进行放大

一个按钮可按需切换波速与 FastLoRA,仅用于放大时。

基于用户反馈的 UI 改进

- 1x 以下顺序放大 / 双放大

现在可以通过放大过程进行缩小,再使用精炼器重新放大;或自定义放大倍数实现 2 倍放大。

新功能:

放大值范围现已支持低至 0.5 的数值。

提供两个滑块:一个用于初始放大,另一个用于精炼器(本质上是另一个采样器,始终为 V2V)。

应用场景:

放大、精炼或两者结合快速放大(潜在调整大小 + 采样)或精确放大(调整大小 + 采样)

精炼(工作方式与放大相同,可单独使用或作为辅助放大器)

双放大:从较小尺寸开始,在最终阶段大幅放大。

缩小后重新放大:在低分辨率下分解,再在高画质下重建。

组合:放大 & 精炼 / 缩小 & 放大

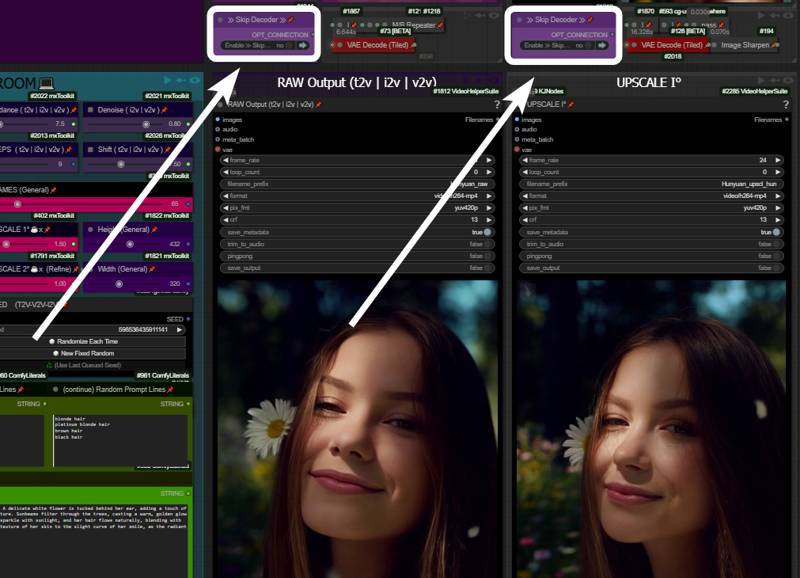

- 跳过解码器/编码器选项

通过跳过每个所需阶段的原始解码,直接生成最终结果,大幅节省时间。

工作原理:若你的提示词预期能产生良好输出,且管理器中启用了预览方法(“latent2RGB”),你可以实时监控处理过程。通过仅在潜在空间中操作,跳过编码/解码,直接将潜在数据发送至放大器,直至流程完成。

示例:

一个典型的中/高质量生成可能涉及:分辨率:~ 432x320

帧数:65

一次放大:1.5x(至 640x480)

总耗时:162 秒

在此示例中,若在管理器中启用预览并跳过第一个解码器(放大前的预览),可节省约 30 秒。处理时间从 162 秒降至 133 秒。

跳过额外解码器(如进一步放大或精炼)可节省更多时间。

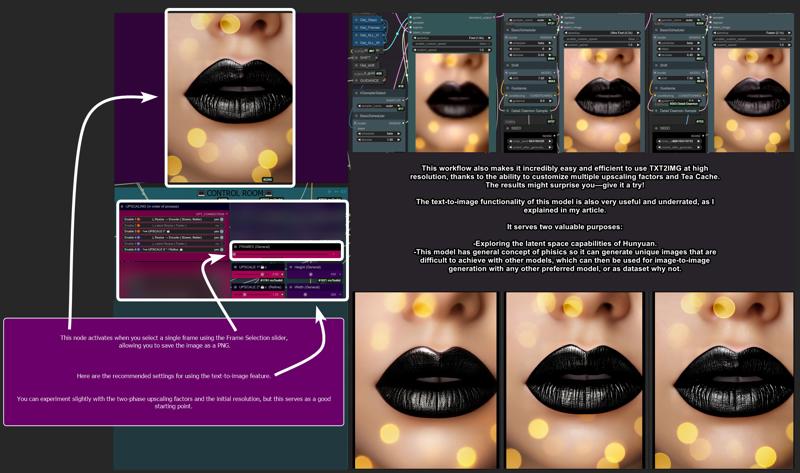

- 图像生成(T2I 和 I2I)

利用此图像生成功能探索 Hunyuan 潜在空间。

当帧数设置为 1 时,图像节点将自动激活,允许将图像保存为 PNG 格式。

为获得最佳效果,请使用以下设置:

- T2I 示例图库:Hunyuan 展示

- 结构性更改 / 额外功能

I2V 运动引导器

此功能增强图像到视频工作流的动态效果,降低生成静态视频的可能性。9 个随机角色 LoRA 加载器:此前限制为 5 个,现扩展至 9 个。

随机角色 LoRA 锁定/解锁:

默认情况下,每个种子对应一个随机 LoRA

(例如,种子 667 = LoRA 7)。现在,你可以解除“种子固定角色 LoRA”锁定,使用不同随机 LoRA 重新生成相同视频,同时保持主种子不变。

澄清说明:

让我们用真实名称称呼事物:“精炼”和“放大”在这里都是采样器,各自针对特定阶段优化:

放大:更多步数/降噪,快速结果,均衡画质。

精炼:较少步数/降噪,专注于修复问题与增强细节。

精炼可单独使用,无需放大,以解决小问题或提升细微细节。

UI 简化:

“经典放大”现已由更快、性能更好的“调整大小 + 锐化”操作取代,并隐藏在后端以节省空间。帧数限制问题(101+ 帧):

使用潜在放大生成超过 101 帧可能导致问题。为解决此问题,我新增了在切换至潜在处理前先放大视频的选项。

- Bug 修复

潜在放大更改:

潜在放大现使用双三次插值而非最近邻精确插值,经测试表现更优。“Cliption” Bug 已修复

201 帧修复:

生成 201 帧完美循环时,潜在放大会引起伪影。现在通过粉红色控制台按钮切换为“调整大小”已解决此问题。

- 性能及其他信息:

一旦你掌握它,便不愿再回头。此工作流专为满足所有需求、处理所有情况而设计,最大限度减少在面板间频繁切换。所有功能均由中央“控制室”统一控制。

传统上,管理这些功能需要连接/断开线缆或加载多种工作流。而此处,只需几次点击即可自动执行所有操作。

默认设置(如降噪、步数、分辨率)已针对简洁性优化,高级用户可轻松调整以满足自身需求。

- 限制:

无音频集成:

虽然我有支持音频的工作流,但此处并不适用。为获得专业效果,音频应单独处理。无后期特效:

色彩校正、胶片颗粒等后期增强效果交由专业编辑软件或工作流处理。本工作流专注于输出纯净视频。插值注意事项:

此处已包含插值功能。我设置了目前已知最快的插值方法,未必是最好的。为获得最佳效果,我通常在处理后使用 Topaz 进行额外放大和插值,但用户可根据偏好自行选择插值方法或最终放大方案。

需求:

ULTRA 1.2:

-Tea 缓存

ULTRA 1.3:

- 需更新至最新版 Comfy!

-Wave Speed

ULTRA 1.4 / 1.5:

-需更新至最新版 Comfy!

https://github.com/pollockjj/ComfyUI-MultiGPU

https://github.com/chengzeyi/Comfy-WaveSpeed

https://github.com/city96/ComfyUI-GGUF

https://github.com/logtd/ComfyUI-HunyuanLoom

https://github.com/kijai/ComfyUI-VideoNoiseWarp

NB:

控制台中的以下警告完全正常,请忽略:

WARNING: DreamBigImageSwitch.IS_CHANGED() got an unexpected keyword argument 'select'

WARNING: SystemNotification.IS__CHANGED() missing 1 required positional argument: 'self'

_

更新日志:

|1.1|

优化配色方案,便于理解放大各阶段的工作方式

查看图像以理解

|1.2|

通配符。

现在可从经典提示系统(支持通配符)切换至之前可用的高级系统。

|1.3|

为放大器新增额外的 WaveSpeed 加速。

将采样器改为原生 Comfy——不再使用 TTP,无中断错误消息。

Tea 缓存现为独立节点。

修复通知时间错误与文本。

替换导致部分用户出错的节点:“if any” 现替换为 “eden_comfy_pipelines”。

新增 SPICE,一种超快 LoRA 开关,仅在放大器中激活,以在低步数下加速推理并减少噪声。

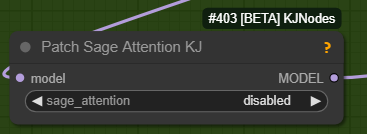

在设置中添加 Block Cache 和 Sage。已启用它们的用户可选择开启。

将默认采样器从 Euler Beta 更改为最新 Comfy 更新中引入的“gradient_estimation”采样器。

为每个阶段添加视频信息框(尺寸、时长)。

移除“随机行”。

调整通用默认值。

放大 1 现可作为精炼器使用。

点击“潜在调整大小”或“调整大小”时,将自动激活正确采样器。

单帧图像现在也会在其他阶段显示(当激活时)。

感谢所有在 Discord 上为本工作流提供改进意见的用户!

|1.4|

虚拟 VRAM 支持

Hunyuan/Skyreel 快速合并滑块

切换常规模型与虚拟 VRAM/GGUF 的开关

现可生成更长视频、更高分辨率、极端放大

默认分辨率更改为 480x320,这是低分辨率快速视频与大多数用户的均衡选择。

潜在预览用于跳过预览模式

切换开关以启用/禁用放大器专属 LoRA

RF 编辑织机

V2V 加载时间优化

放大至“最长尺寸”目标

修复滑块放大不匹配问题

信息节点位置调整

清理与修复

优化通用设置

放大 1 现可使用“调整至最长尺寸”可选滑块

为放大器新增额外 WaveSpeed 开关

为放大器添加专属 LoRA 线

一般性修复

基于用户反馈改进 UI

修复放大器中 FastLoRA 字符串绕过问题

进一步清理

再次调整放大器专属 LoRA:主 FastLoRA 不再通过该线,因其已有独立开关(“使用超快 LoRA 放大”),原名 SPICE FOR UPSCALING。

修复视频输出节点尺寸

将“按最长尺寸”调整大小开关移至额外菜单

新增额外 WaveSpeed 开关

控制室已完成……目前如此。我不愿再给 Aidoctor 增加压力,他已经做得很好了。

降低 FastLoRA 默认值至 0.4

修复 VIDEO BATCH LOADING

|1.5|

一般性改进、UI 优化、部分 Bug 修复

Leap Fusion 支持

Go With The Flow 支持

附赠提示:

以下是我测试此模型时撰写的全部技巧与窍门文章:

https://civitai.com/articles/9584

如果你因任何原因难以使用我的工作流,至少可以参考上述文章。你将获得大量提升生活质量的宝贵建议,助你构建并优化你的 Hunyuan 体验。

所有标有 ❌的工作流均为旧版本且高度实验性,依赖于 Kijai 在开发早期阶段发布的节点。

如你想探索这些,请自行修复,相信这会很容易。

鸣谢

我所有工作均在业余时间出于个人乐趣完成。

但若你愿贡献支持,

有比我还更值得支持的人,

比如 Kijai。

我会留下 他的链接,

如果你慷慨,请去支持他。

谢谢!

最后但同样重要的是:

感谢这个社区,尤其是那些给我建议、测试我工作流并帮助改进它们的用户。

特别感谢:

https://civitai.com/user/galaxytimemachine

因其独特而精准的操作方法,帮助找到了最佳设置,并进行了大量测试。

https://civitai.com/user/TheAIDoctor

感谢他的卓越才华,以及为本工作流的疯狂而投入时间创建和修改专用节点!真是了不起的人。

以及

https://github.com/pollockjj/ComfyUI-MultiGPU

特别感谢:

Tr1dae

感谢他创建了HunyClip,一个用于快速视频剪辑的实用工具。如果你使用DaVinci Resolve或Premiere等重型编辑软件,你会发现这个工具在无需打开资源密集型程序的情况下,能进行快速操作,极其有用。

立即查看:[link]

玩得开心