HyperFlux Diversity

세부 정보

파일 다운로드

모델 설명

HyperFlux 다양성

나는 인종적 다양성을 이미지의 현실감을 위한 중요한 요소로 보며, dAIversity Flux(/model/711900?modelVersionId=796248)의 성능에 매우 기뻐합니다.

대부분의 Flux 모델에서, 나는 일반적으로 깊이의 범위를 확장하기 위해 AntiBlur LoRA(/model/675581/anti-blur-flux-lora)와 함께 dAIversity Flux를 사용합니다. 또한 HyperFlux LoRA에 매료되었으며, 이는 HyperFlux 베이스 모델 시리즈(/model/705444?modelVersionId=789074)에서 확인할 수 있습니다.

RuinedFooocus와 dAIversity Flux의 safetensors 파일을 실행할 때 성능 문제를 겪었는데, 이는 GGUF 사용에 최적화되어 있기 때문입니다. 이 요인과 위에 언급된 두 LoRA를 dAIversity Flux와 최적화하여 사용하고자 하는 욕구가 결합되어, GGUF 형식으로 새로운 병합 모델을 제작하게 되었습니다.

HyperFlux 다양성은 dAIversity Flux에 HyperFlux LoRA를 강도 0.12로, AntiBlur를 강도 1.0으로 혼합한 것입니다.

이 리소스를 만들어준 각 제작자의 라이선스를 존중해 주세요. 예를 들어, 온라인 이미지 생성과 같은 이미지 생성을 수익화하는 서비스에 HyperFlux 다양성을 사용하지 마세요. 또한 이 모델을 유료로 판매하거나 다른 가치 있는 대가를 받고 라이선스를 부여하지 마세요.

사용 방법:

HyperFlux 다양성의 내 설정은 CFG를 3.5로 하지만, 특수 효과를 위해 최대 6.5까지 올립니다. 모든 8단계 Flux1 Dev 기반 모델과 마찬가지로 샘플링 단계를 20으로 설정하고, euler 샘플러와 simple 스케줄러를 사용합니다.

기본적으로 HyperFlux 다양성은 깊은 심도의 이미지를 생성합니다. 얕은 심도를 원한다면 긍정 프롬프트에 "bokeh"를 포함하세요.

이 모델이 NSFW 이미지를 생성한다면 그 의도는 아닙니다.

크레딧:

dAIversity Flux: /model/711900?modelVersionId=796248

AntiBlur LoRA: /model/675581/anti-blur-flux-lora

HyperFlux 8 LoRA: https://huggingface.co/ByteDance/Hyper-SD

이 프로젝트는 다음 훌륭한 리소스를 사용하여 생성되었습니다:

https://civitai.com/articles/8322/merge-a-lora-into-flux-for-better-speed-and-quantize-it

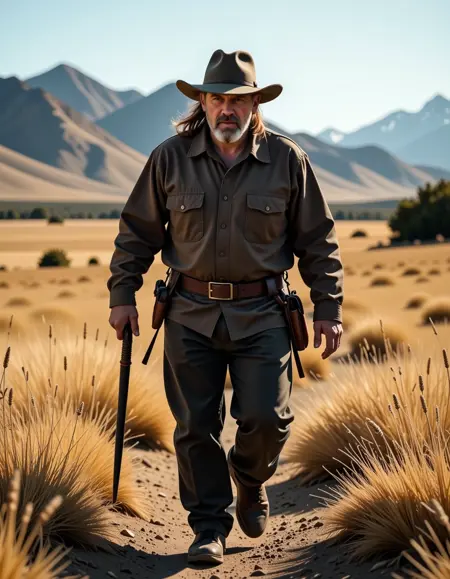

이미지에 관하여:

각 GGUF 버전의 첫 번째 이미지는 해당 양자화 수준에서의 테스트 생성 결과를 보여줍니다. 각 버전을 전환하여 그 이미지가 GGUF 수준에서 어떻게 보이는지 비교해 보세요.

Q8 버전은 가장 많은 세부 정보를 제공하며, 그 다음은 Q6입니다. 둘 다 12GB의 VRAM을 필요로 합니다. Q5는 10GB의 VRAM에서 실행되며 거의 동일한 품질을 제공합니다. Q4에서 Q2까지는 점차 세부 정보가 줄어들지만 저장 공간은 줄어들고 로드 속도는 약간 빨라집니다. 고양자화된 모델이 더 적은 VRAM을 차지한다는 오해가 흔하지만, 테스트 결과 이는 사실이 아닙니다: Q4에서 Q2까지 모두 Q5와 동일한 약 10GB의 VRAM을 사용합니다.

나머지 특징 이미지들은 HyperFlux 다양성에 Pure Fooocus Base Model Reviews 가이드에서 적용된 10개의 표준 테스트에서 추출된 샘플입니다:

https://www.facebook.com/groups/fooocus/learning_content/?filter=519238867322550&post=753347100153801

(Facebook 링크는 신뢰성이 낮으므로, 이 가이드에 접근하려면 위나 아래로 스크롤해야 할 수도 있습니다)