EML_LTX_STG_TTV-ITV-IM_v1.1

詳細

ファイルをダウンロード

このバージョンについて

モデル説明

------------------------------------------

------------------------------------------

## ワークフローガイド:説明

------------------------------------------

この「EML_LTX_TTV/ITV」と呼ばれる生産ワークフローは、LightricksのLTX-Videoに基づく高品質な動画を実現するための高度な技術を備えています。

✅ 8GB VRAM以下のグラフィックカードで動作します!

✅ モデルを使用するための最良の技術を1つのワークフローに集約しました💪

✅ ユーザーにやさしいインターフェース

✅ 1つのスイッチでテキスト→動画、画像→動画、インスパイレーションモードの3つの動作モードを切替可能

✅ 生成画像対応:ユーザーは「凍結した動画」の問題(画像のノイズが不足している)に直面することがよくあります。このワークフローは自動的にcrfを介してノイズを追加し、ニューラルネットワークに「全体像」の理解を促します。詳細は(1)を参照

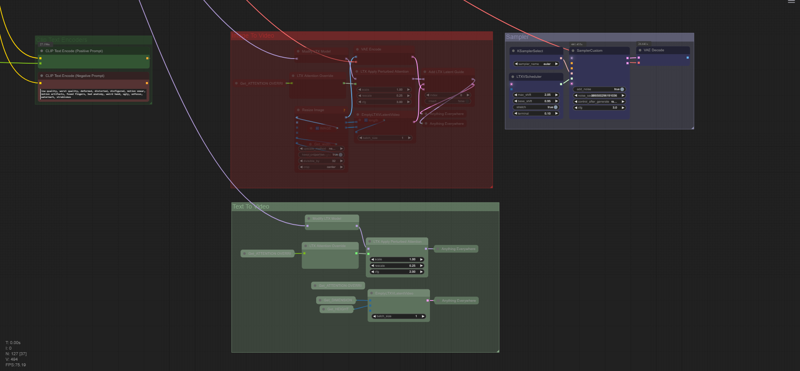

✅ STG Perturbed Attentionのサポート

✅ ファイル名の自動リネーム

✅ サンプル比較ファイルはzipに圧縮され、パラメータ付きのワークフローは.mp4形式で保存されるため、Comfy UIのワークスペースにドラッグアンドドロップするだけで使用できます

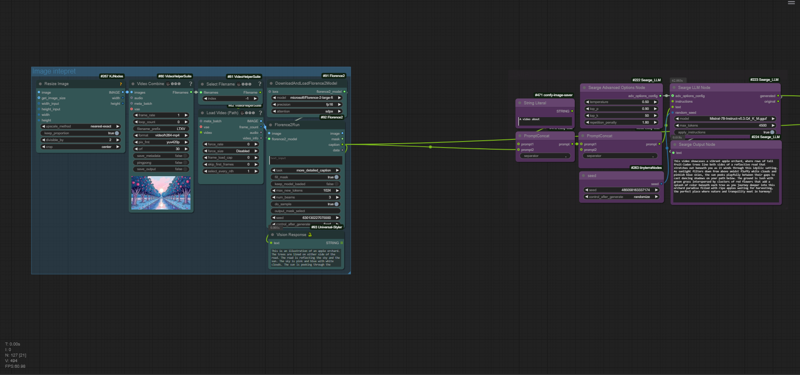

✅ Florence2モデルによる画像認識

✅ LLM Mistral-7bを用いて1文で複雑なプロンプトを生成

✅ MP4への保存

✅ 方向比の一覧が便利

✅ RunwayおよびEMLから提供されたカメラ設定と指示のプリセット

デフォルトでは、モデルの解像度は768x512、アスペクト比は3:2です。カスタム解像度を使用する場合は自己責任で、より安全な選択肢としてノードヘルパー「LTXV Model Configurator」の公式リストを使用してください。画像→動画では、サイズは自動的に判定されます。

ワークフローの基盤として使用:

XODA-LTXV /model/974859

ComfyUI-LTXTricks https://github.com/logtd/ComfyUI-LTXTricks/tree/main/example_workflows

❤❤❤❤❤❤❤❤❤❤

⚠注意:多くのノードは「SetNode」と「GetNode」を通じて接続され、ワークフローを整理するためです。

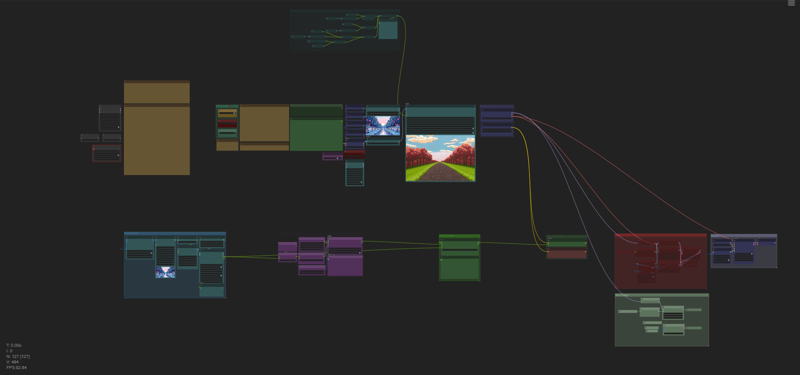

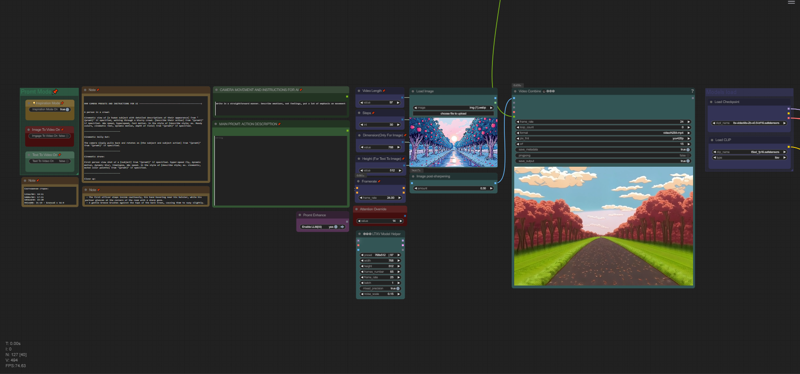

ワークフロー - 主要なシンプルUI:

ワークフロー - AIセクター:

ワークフロー - プロセッサ:

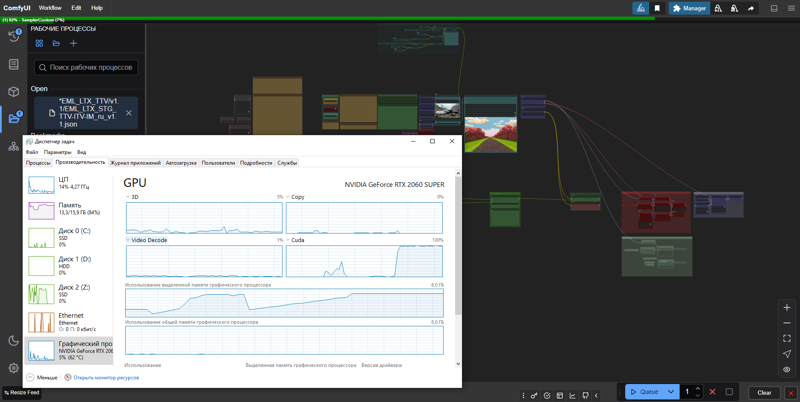

RTX 2060s 8GB VRAMでの実際の生成速度(デフォルト設定、画像→動画):

VRAM最適化:

------------------------------------------

## ワークフローガイド:準備

------------------------------------------

0. ワークスペースを起動後、必要なノードが欠落している可能性があります。

Manager → Install Missing Custom Nodes → 全てを選択(IDの横)→ Install

インストール後、Comfy UIが再起動を促すので、クリックして次のステップに進んでください。最初の実行はFlorence2モデルのダウンロードにより時間がかかる場合があります。

0.1 モデルを選択します。

私はltx-2b-v0.9-bf16.safetensorsモデルとMochiのt5xxl_fp16.safetensorsを組み合わせて使用しています。

https://huggingface.co/MayensGuds/ltx-video-quants

VRAMが6GB以下の場合は、ltx-video-2b-v0.9-fp8_e4m3fn.safetensorsモデルとclip loader、t5xxl_fp8_e4m3fn.safetensorsを使用してください。

「ltxv」モードが有効になっていることを確認してください。

💡ヒント:Flux1を使用して画像を生成することをお勧めします。同じテキスト変換アルゴリズムを使用しているためです。

0.2 LLMモデルmistral-7b-instruct-v0.3-q4_k_m.ggufをダウンロードします。

ComfyUI/modelsディレクトリ内に新しいllm_ggufフォルダを作成し、Mistral-7B-Instruct-v0.3.Q4_K_M_M.gguf(4.37GB)をHuggingFaceのMaziyarPanahi/Mistral-7B-Instruct-v0.3-GGUFリポジトリからダウンロードしてください。

0.3 最適化のヒント。

私のNVIDIA RTX 2060s 8GB VRAMグラフィックカードでは、デフォルト設定(768x512、25fps、97フレーム、30ステップ)で約10秒/イテレーション、つまり動画1本あたり約5分かかります。「🅛🅣🅧 LTXV Model Configurator」の左側で推奨値を確認できます。

このモジュール(およびその他の同様のモジュール)は空間上どこにも接続されておらず、参照用としてのみ使用されます。

スピードアップのためには、解像度を変えるよりもフレーム数を減らす方が望ましいですが、その場合、画像の長さとニューラルネットワークの理解度が低下します。

通常、私は約50フレームで十分です(25fpsで2秒の動画)。オブジェクトの識別性が高まり、変形が少なくなるため、ステップ数は30以上に設定することをおすすめします。試験には20ステップでも構いません。まとめると、最適化された状態で約5秒/イテレーション(2倍速)となり、動画1本あたりの総時間は約1分30秒になります。後処理(例:スロー再生)には、2秒の動画があれば十分なフレームが得られます。

動画の長さを変更すると最終結果に影響するため、長いプロンプトが逆に結果を改善する場合もあります。

## ワークフローガイド:動画生成

1.0 画像を準備してください(重要です!)。標準的なサイズより少し大きめの画像を使用してください。標準の768x512では多くのディテールが失われ、またcrfノイズのランダム性が高まるためです。影響の程度はまだ明確ではありませんが、生成動画の1.5倍程度の大きさの画像をアップロードすると、結果ははるかに良質になります。実写映像を使用する場合は、画質が「石鹸のような」ものにならないよう注意してください。画像生成器を使用する場合は(強く推奨)、ニューラルネットワークの「言語」を理解し、画質は良好であるべきですが、過度にシャープにしないでください。そうでないと、ニューラルネットワークが波打ったり、幻覚を生じたりします(アップロード前に画像にシャープネスを加えて確認してください)。油絵や再撮影された映画のような質感になるべきで、処理された写真のようなものであってはなりません。写真の品質≠動画の品質という可能性もあります。Flux1では、DCFG値と以下のサンプラー(Euler、または[Forge] Flux Realistic)をDDIMまたはBetaサンプラーと組み合わせることで実現できます(私はDDIMでの結果が好きです)。ダウンロードしたzipアーカイブのexamplesフォルダ内の例を参照してください。

1.1 画像をアップロード(load image > choose file to upload)

*ワークフローは自動的に画像に説明をマッチさせます。

2. ディレクターとしてプロンプトを指定:

-- 説明:「Promt Mode」の選択グループで、ImgToVideo、TextToVideo、Inspiration Modeを切り替えられます。画像、テキスト、またはInspiration Modeを使用してテキスト→画像のスクリプトを考案するかを選択してください。メインコントロールパネルは上部に配置されており、デフォルトで十分な基本設定を備えていますが、良い映像を得る鍵は、適切に準備された画像や高品質なプロンプト、そしてあなたのディレクションのビジョンと実験的なスキルにかかっています。

--

2.(1). LLM Mistral-7bは、プロンプトに基づいてヒントを生成できます。この機能を使うには、「Promt Enhance」で「Enable LLM」をオンにしてください。動き、光の演出、その他の動的要素についてすべて記述し、静的プロンプトについてはFlorence2が担当します。カメラの動きについては、Runwayから取得したプリセットを基準としています。プリセットを適用するには、希望するプリセットを「CAMERA MOVEMENT AND INSTRUCTIONS FOR AI」ウィンドウにコピーしてください。このウィンドウ内では、モデルに以下の要求を追加できます:「カメラは‘{promt}’からゆっくり後退する」など、50語以内で簡潔に記述してください。これらはすべて最終結果に強く影響するため、この部分に集中し、実験してください。「MAIN PROMT: ACTION DESCRIPTION」ボックスには、プリセットが要求する内容(例:[被写体の行動])を記述する必要があります。私は「DisneyとPixarのプリンセスが若いヒロインの顔に光のきらめきを放つ」といった幻覚が発生する可能性があるものの、「CAMERA MOVEMENT AND INSTRUCTIONS FOR AI」ウィンドウでより直接的なリクエストをニューラルネットワークに調整できる「強化モード」を使用することをお勧めします。

⚙ 現在、プリセットのカスタマイズはやや曖昧で、テキストがそのまま保持されます。あなたの観察結果も共有してください!

2.(2). 手動モード:

- 簡潔で明確に、さらにはストレートに記述してください。

- フレーム内で何が起こるかを説明してください:誰かが歩く、振り返る、次のシーンの方向を示すなど。

- シーンのジャンルとトーン(リアリスティック、シネマティック、アニメ調)を強調してください。

シーンが特定のメディア形式(映画、アニメ、写真)に触発されていることを示してください。

- カメラは固定のままか、キャラクターの前、後、回転、または特殊な1人称視点で動くかを明示してください。

例:

暗い青の制服と同色の帽子を着用した2人の警察官が、フレーム左側のドアから薄明かりの部屋に入る。最初の警察官は短い茶色の髪と口ひげで、その後ろに禿げ頭でヒゲを生やしたパートナーが続く。両者は真剣な表情で、部屋の奥へ着実に進む。カメラは固定されたまま、やや低い角度から彼らの進入を捉える。部屋の壁は露出した煉瓦、天井は波板の金属で、背景にはバーのついた窓が見える。照明はローライティングで、警察官の顔に影を落とし、重苦しい雰囲気を強調する。このシーンは映画やテレビ番組から切り取られたように見える。

💡ヒント:英語が苦手な場合は、GoogleストアのDeepL AIブラウザ拡張機能を使用して翻訳できます。テキストを選択し、Ctrl+Shift+Xを押して、あらかじめ翻訳言語を選択してください。

公式の手引き:

主なアクションを1文で始める

動きやジェスチャーについて具体的な詳細を追加

キャラクター/オブジェクトの外見を正確に記述

背景や環境の詳細を含める

カメラのアングルと動きを指定

照明と色を記述

変化や急なイベントを注記

プロンプトウィンドウの下(カメラプリセットの横)にさらに詳しい手引きがあります。

2.(3). インスピレーションモード:

私はテストを行いましたが、フィールドを空にすると平均〜低い結果になります。これは、このネットワークが画像に特化して訓練されているため、動きを正しく解釈できないためです。そのため、いくつかの明確化を記述します:

「彼女は泣いている」、「人が歩いている」、「彼は踊っている」

あるいは上記のようなより複雑な例:

「彼はカメラを見つめ、その後振り返る。カメラは踊る孔雀を見つめる」

このパラグラフ内のすべてのヒントは相互に関連し、3つのパラグラフに共通するルールがあります:プロンプトは明確かつシンプルでなければなりません。感情を記述することは不適切です。なぜなら感情は内面的な体験であり、代わりに「感情」(見られるもの)を記述すべきだからです。

💡ヒント:Runway Academyで、動画生成器の動作原理についてより深く理解してください。

https://help.runwayml.com/hc/en-us/articles/30586818553107-Gen-3-Alpha-Prompting-Guide

p.s. 私が好むのは?答え:画像→動画です。最終的な画質レベルが高く、動きのディテールはやや劣るものの、私はこの方法を好みます。

3. すべてのカスタマイズはプロンプト入力の横にあります。よりエキゾチックな設定が必要な場合は、「Perturbed Attention」を調整してみてください。主要パラメータは「Video Length」「Steps」「Dimension」「Framerate」です。

3.1 CFGも調整できます。デフォルトは3.0、公式推奨は3.0–3.5ですが、多くのユーザーが5を使用しています。私の観察によれば、このパラメータはより動的な結果やコントラストの強い画像に必要ですが、PixArt-XL-2-1024-MSモデルのテキストエンコーダではより安定した結果を生み、YouTubeの動画からもその傾向が確認できます。ただし、メモリをより多く消費するため、低性能のグラフィックカードでは3.0–3.5の控えめな値を使用してください。ただし、このパラメータが具体的にどのように影響するかは、まだ完全に解明できていません。

3.2 非現実的、ホラー映画、あるいは不気味な谷間のファンの場合は、Attention Override値を20以上に設定してください(デフォルトは14)。

3.3 「Dimension(画像専用)」と「Height(テキスト→画像用)」という2つのノードがあります。Dimensionは画像の解像度を自動選択し、Heightはテキスト→画像モードで高さとして使用されますが、このモードではDimensionが横幅を担当します。これは便利さのために設計されています。

公式マニュアル:

4.「Queue」をクリックし、結果を待ってください。ファイルは ComfyUI\output フォルダに保存されます。出力は動画:.mp4(ワークフローとパラメータがファイルに埋め込まれています)と一時的な画像 .png です。これらは削除できます。

💡ヒント:.mp4 チェーンから .mp4 を削除し、「SaveAnimatedWEBP」ノードを追加することで、品質を落とすことなく動画を .WebP 形式で保存できます。WebP形式を他の形式に変換する必要がある場合は、私のWebP変換ツールをダウンロードしてください。

▶️ https://github.com/dvl12000/webp-converter/releases/tag/v1.0.1

💡ヒント:処理後、Topaz Video AI の「Theia」モードで画像を2倍または4倍に拡大し、シャープネスを約50に設定し、デフォルトでグレインを適用してください。これにより大幅な品質向上が実現できます!

----------------------------

ビルドを評価し、コメントをお寄せください。楽しい生成を!🔥