EML_LTX_STG_TTV-ITV-IM_v1.1

세부 정보

파일 다운로드

이 버전에 대해

모델 설명

------------------------------------------

------------------------------------------

## 워크플로 가이드: 설명

------------------------------------------

이 생산 워크플로우는 “EML_LTX_TTV/ITV”라고 하며, Lightricks의 LTX-Video를 기반으로 고품질 비디오를 생성하기 위한 고급 기술을 사용합니다.

✅ 8GB VRAM 이하의 그래픽 카드에서도 작동합니다!

✅ 이 모델을 사용하기 위한 최고의 기술들을 하나의 워크플로우로 통합했습니다💪

✅ 사용자 친화적인 인터페이스

✅ 한 번의 스위치로 텍스트를 비디오로 변환(Text To Video), 이미지를 비디오로 변환(Image To Video), 영감 모드(Inspiration Mode)의 세 가지 운영 모드 제공

✅ 생성된 이미지 지원: 사용자들은 종종 이미지에 노이즈 부족으로 인해 “정지된 비디오” 문제에 직면합니다. 이 생산 프로세스는 crf를 통해 자동으로 노이즈를 추가하여 신경망이 “전체적인 그림”을 이해하도록 돕습니다. 자세한 설명은 (1) 참조

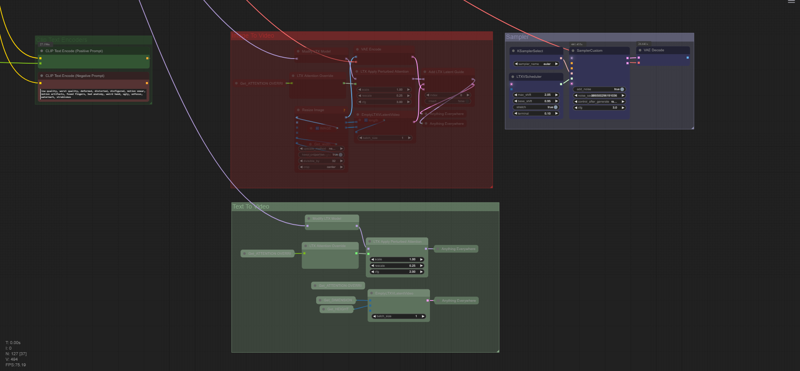

✅ STG 편향된 주의(Attention) 지원

✅ 자동 파일 이름 변경

✅ 샘플 비교 파일은 zip 파일로 압축되어 있으며, 매개변수를 포함한 워크플로우는 .mp4 형식으로 저장되므로 Comfy UI 작업 공간에 드래그 앤 드롭만 하면 됩니다.

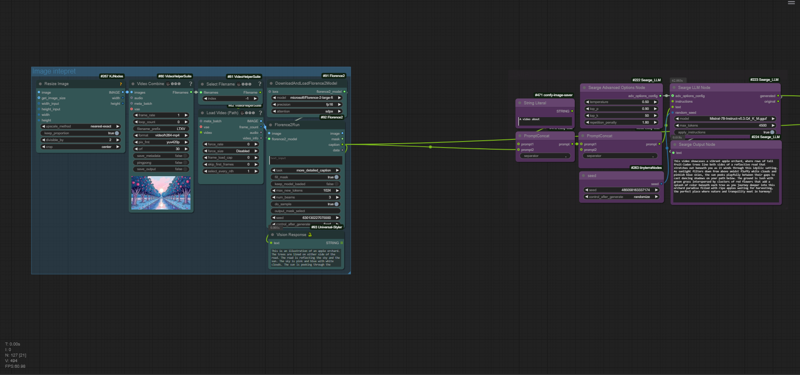

✅ Florence2 모델을 통한 이미지 인식

✅ LLM Mistral-7b를 사용하여 단일 문장으로 복잡한 프롬프트 생성

✅ MP4로 저장 가능

✅ 편리한 비율 목록 제공

✅ Runway 및 EML에서 제공하는 카메라 및 지시 사항 사전 설정

기본적으로 모델의 해상도는 768x512, 비율은 3:2입니다. 사용자 정의 해상도는 본인 책임 하에 사용하시며, 노드 헬퍼 “LTXV Model Configurator”에서 공식 목록을 선택하는 것이 좋습니다. 이미지에서 비디오로 변환할 경우, 측면은 자동으로 결정됩니다.

이 워크플로우는 다음을 기반으로 합니다:

XODA-LTXV /model/974859

ComfyUI-LTXTricks https://github.com/logtd/ComfyUI-LTXTricks/tree/main/example_workflows

❤❤❤❤❤❤❤❤❤❤

⚠ 참고: 많은 노드는 워크플로우를 더 깔끔하게 만들기 위해 “SetNode” 및 “GetNode” 노드를 통해 연결됩니다.

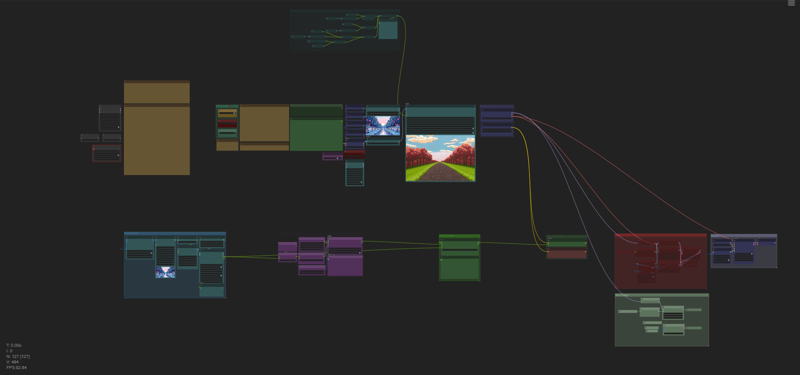

워크플로우 - 기본 간단한 UI:

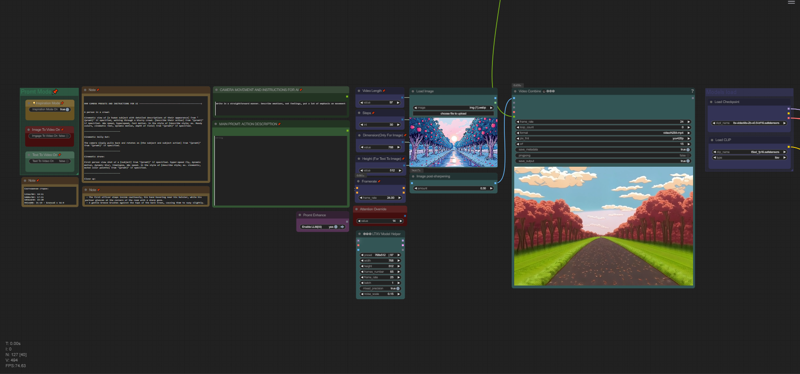

워크플로우 - AI 섹터:

워크플로우 - 프로세서:

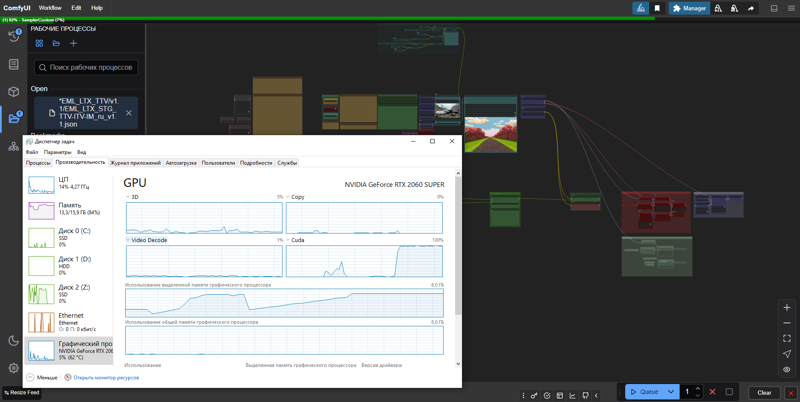

RTX 2060s 8GB VRAM에서의 실제 생성 속도, 기본 설정, 이미지에서 비디오로 변환:

VRAM 최적화:

------------------------------------------

## 워크플로우 가이드: 준비

------------------------------------------

- 워크스페이스를 시작한 후, 필요한 노드가 누락되어 있을 가능성이 높습니다.

Manager → Missing Custom Nodes 설치 → 모두 선택(ID 옆) → 설치

설치 후, Comfy UI에서 재시작을 요청할 것이며, 클릭하고 다음 단계로 진행하세요. 첫 실행 시 Florence2 모델 다운로드로 인해 시간이 오래 걸릴 수 있습니다.

0.1 모델 선택

저는 ltx-2b-v0.9-bf16.safetensors 모델과 Mochi의 t5xxl_fp16.safetensors를 함께 사용하는 것을 선호합니다.

https://huggingface.co/MayensGuds/ltx-video-quants

6GB VRAM 이하의 그래픽 카드를 사용하는 경우, ltx-video-2b-v0.9-fp8_e4m3fn.safetensors 모델과 clip 로더 t5xxl_fp8_e4m3fn.safetensors를 함께 사용해 보세요.

“ltxv” 모드가 활성화되어 있는지 확인하세요.

💡 팁: 유사한 텍스트 변환 알고리즘을 사용하기 때문에 이미지 생성에 Flux1을 사용하세요.

0.2 LLM 모델 mistral-7b-instruct-v0.3-q4_k_m.gguf 다운로드

ComfyUI/models 디렉토리에 새로운 llm_gguf 폴더를 생성하세요. HuggingFace의 MaziyarPanahi/Mistral-7B-Instruct-v0.3-GGUF 저장소에서 Mistral-7B-Instruct-v0.3.Q4_K_M_M.gguf (4.37 GB) 파일을 다운로드하세요.

0.3 최적화 팁

저의 NVIDIA RTX 2060s 8GB VRAM 그래픽 카드에서는 기본 설정인 768x512, 25fps, 97프레임, 30스텝으로 약 10초/프레임(즉, 약 5분/비디오)의 속도를 얻습니다. “🅛🅣🅧 LTXV Model Configurator” 왼쪽에서 권장 값을 확인할 수 있습니다.

이 모듈은 공간의 모든 복제본과 마찬가지로 아무것에도 연결되어 있지 않으며, 참고용으로만 사용됩니다.

가속을 위해서는 해상도를 변경하는 것보다 프레임 수를 줄이는 것이 더 좋습니다. 그러나 그럴 경우 이미지의 지속 시간과 신경망의 이해도는 낮아질 수 있습니다.

일반적으로 저는 약 50프레임으로 충분하며, 25fps로 2초의 비디오가 됩니다. 또한 물체가 더 구분 가능하고 왜곡에 덜 취약하도록 >=30 스텝을 설정해야 합니다. 테스트용으로는 20 스텝을 사용할 수 있습니다. 요약하면, 최적화된 상태에서 좋은 속도/품질 균형을 얻을 수 있으며, 이는 약 5초/프레임으로, 2배 빠르고 전체 시간은 비디오당 약 1분 30초가 됩니다. 후속 처리(예: 느린 속도)를 위해 2초의 비디오로도 충분한 프레임을 만들 수 있습니다.

지속 시간을 변경하면 최종 결과에 영향을 미치며, 이 경우 긴 프롬프트가 오히려 결과를 향상시킬 수 있습니다.

## 워크플로우 가이드: 비디오 생성

1.0. 이미지 준비 (이것은 매우 중요합니다!). 표준 이미지보다 약간 더 큰 이미지를 사용해야 합니다. 왜냐하면 표준 768x512 해상도에서는 많은 세부 사항이 손실되며, 이 방식은 crf 노이즈에 더 큰 랜덤성을 부여하기 때문입니다. 아직 정확히 얼마나 영향을 미치는지는 모르지만, 예를 들어 생성된 비디오의 1.5배 크기로 이미지를 업로드하면 결과가 훨씬 더 나은 품질을 얻을 수 있습니다. 실제 촬영 영상을 사용할 경우, 품질이 “비누처럼” 흐릿하지 않도록 주의하세요. 이미지 생성기를 사용할 경우(강력히 권장함), “신경망의 언어”를 잡으려 노력하세요. 품질은 좋지만 너무 선명하지 않아야 합니다. 그렇지 않으면 신경망이 파동이나 환각을 일으키기 시작합니다(업로드 전에 이미지에 선명도를 추가해 직접 확인하세요). oil painting처럼, 또는 재촬영된 영화처럼 보여야 하며, 처리된 사진처럼 보이면 안 됩니다. 아마도 사진의 품질 ≠ 비디오의 품질일 수 있습니다. Flux1에서는 DCFG 값을 선택하고 다음 샘플러를 사용하면 됩니다: Euler 또는 [Forge] Flux Realistic, DDIM 또는 Beta 샘플러와 함께 (저는 DDIM과 비디오의 결과가 더 좋아요). 다운로드한 zip 아카이브의 예제 폴더에서 예제를 확인하세요.

1.1 이미지 업로드 (이미지 로드 > 업로드할 파일 선택)

* 워크플로우는 자동으로 이미지에 설명을 매칭합니다.

2. 감독으로서 프롬프트 지정:

-- 설명: “Promt Mode” 선택 그룹에서 ImgToVideo, TextToVideo, Inspiration Mode를 전환할 수 있습니다. 이미지, 텍스트를 사용할지, 아니면 Inspiration Mode로 텍스트에서 이미지를 생성하여 시나리오를 작성할지 선택하세요. 주 제어판은 상단에 편리하게 위치해 있습니다. 패널에는 기본적으로 잘 작동하는 기본 설정이 있으며, 좋은 결과를 얻기 위한 전체 비밀은 소스 자료, 즉 잘 준비된 이미지인지, 고품질의 프롬프트인지에 달려 있으며, 이는 모두 당신의 연출적 비전과 실험 능력에 달려 있습니다.

--

2.(1). LLM Mistral-7b는 프롬프트를 기반으로 힌트를 생성할 수 있습니다. 이 목적을 위해 “Promt Enhance”에서 “Enable LLM”을 켜주세요. 움직임, 빛의 연출 및 모든 움직이는 요소에 관한 내용을 모두 작성해야 하며, Florence2는 정적 프롬프트를 담당합니다. 카메라 움직임에는 Runway에서 가져온 사전 설정이 기준으로 사용되었습니다. 사전 설정을 적용하려면 원하는 사전 설정을 “CAMERA MOVEMENT AND INSTRUCTIONS FOR AI” 창에 복사하세요. 이 창에서 모델에 대한 희망을 추가할 수도 있습니다. 예: “카메라가 ‘{promt}’에서 천천히 뒤로 물러납니다.” 50단어 이내로 간결하고 명확하게 작성하세요. 이 모든 내용은 최종 결과에 특히 큰 영향을 미치므로 이 부분에 집중하고 실험하세요. “MAIN PROMT: ACTION DESCRIPTION” 상자에 사전 설정이 요구하는 설명을 작성해야 합니다. 즉, [] 안에 있는 모든 내용입니다. 예: [주체의 행동]. “Disney와 Pixar의 작은 여주인공 얼굴에 빛나는 반짝임” 같은 환각이 있을 수 있지만, “CAMERA MOVEMENT AND INSTRUCTIONS FOR AI” 창에서 더 직접적인 요청을 위해 신경망을 조정하는 것이 가능합니다.

⚙ 현재 사전 설정의 사용자 정의는 다소 모호하며, 텍스트가 고정되어 있습니다. 또한 여러분의 관찰을 공유해 주세요!

2.(2). 수동 모드:

- 간단하고 명확하게 작성하세요. 오히려 직설적이어야 합니다.

- 프레임에서 일어날 일을 설명하세요: 누군가 걷거나, 돌아서거나, 다음 장면이 어디로 갈지 설명하세요.

- 장면의 장르와 분위기를 강조하세요(현실적, 영화적, 만화적).

- 장면이 특정 미디어 형식(영화, 애니메이션, 사진)에서 영감을 받았는지 명시하세요.

- 카메라가 정지해 있을지, 그 앞, 뒤, 주변을 따라 움직일지, 아니면 특별한 제1인칭 시점일지 설명하세요.

예시:

어두운 파란색 복장과 같은 모자를 쓴 두 명의 경찰관이 프레임 왼쪽의 문을 통해 어두운 방에 들어섭니다. 첫 번째 경찰관은 단발에 수염이 있고 먼저 들어서며, 뒤에 이어지는 동료는 머리를 밀고 수염이 있습니다. 두 경찰관 모두 진지한 표정을 지으며 방 안으로 꾸준히 진입합니다. 카메라는 정지한 채 그들이 들어서는 것을 약간 낮은 시점으로 포착합니다. 방은 노출된 벽돌벽과 골판지 천장, 배경에 보이는 철창이 있는 구조입니다. 조명은 저조도이며 경찰관들의 얼굴에 그림자를 드리우고 어두운 분위기를 강조합니다. 장면은 영화나 TV 쇼에서 나온 것처럼 보입니다.

💡 팁: 영어를 구사하지 않는 경우, Google 스토어의 DeepL AI 브라우저 확장 프로그램을 사용하여 텍스트를 번역하세요. 텍스트를 선택한 후 Ctrl + Shift + X를 누르고 미리 번역 언어를 선택하세요.

공식 지침:

단일 문장으로 주요 행동으로 시작하세요.

움직임과 제스처에 대한 구체적인 세부 사항을 추가하세요.

캐릭터/오브젝트의 외형을 정확히 설명하세요.

배경 및 환경 세부 사항을 포함하세요.

카메라 각도와 움직임을 명시하세요.

조명과 색상을 설명하세요.

변화나 갑작스러운 사건을 기록하세요.

프롬프트 창 옆(카메라 사전 설정 아래)에 더 자세한 지침이 있습니다.

2.(3). 영감 모드(Inspiration Mode):

저는 테스트를 진행했으며, 이 모드에서 필드를 비워두면 평균에서 낮은 결과를 얻습니다. 이는 이 모델이 이미지에 맞춰 튜닝되어 있고 움직임에는 적합하지 않기 때문입니다. 그래서 몇 가지 명확화를 작성합니다:

“그녀는 울고 있다”, “사람이 걷고 있다”, “그는 춤을 추고 있다”

또는 위의 예시처럼 더 복잡한 표현들:

“그는 카메라를 바라보며 돌아선 다음, 카메라는 춤추는 공작새를 바라본다”

이 문단의 모든 단서는 서로 연결되어 있으며, 세 문단 모두에 공통된 규칙이 있습니다: 프롬프트는 명확하고 직설적이어야 하며, 감정을 묘사하는 것은 적절하지 않습니다. 왜냐하면 이는 내면의 경험으로, 감정의 대안은 감정이며, 우리는 그것을 볼 수 있기 때문입니다.

💡 팁: 비디오 생성기가 어떻게 작동하는지 더 잘 이해하려면 Runway Academy를 방문하세요.

https://help.runwayml.com/hc/en-us/articles/30586818553107-Gen-3-Alpha-Prompting-Guide

p.s. 어떤 방식을 선호하나요? 답변: 이미지에서 비디오로 변환입니다. 저는 최종 품질 수준이 우수하기 때문이며, 움직임 세부 정보는 다소 적지만 말입니다.

3. 모든 사용자 정의는 프롬프트 입력 옆에 있습니다. 더 특이한 설정이 필요하다면 Prebuted Attention을 시도해보세요. 기본 매개변수로는 “Video Length”, “Steps”, “Dimension”, “Framerate”가 있습니다.

3.1 CFG도 활성화할 수 있습니다. 기본값은 3.0이며, 공식 권장값은 3.0–3.5입니다. 그러나 많은 사용자가 5를 사용합니다. 제 관찰에 따르면, 이 매개변수는 더 움직임이 많은 결과 또는 대비가 강한 이미지를 원할 때 필요하지만, PixArt-XL-2-1024-MS 모델의 텍스트 인코더에서는 더 안정적인 결과를 만들어냅니다(YouTube 비디오를 보고 판단). 또한 메모리도 더 많이 필요하므로, 약한 그래픽 카드에서는 3.0–3.5의 낮은 값을 사용하는 것이 좋습니다. 그러나 이 매개변수가 정확히 어떻게 영향을 주는지는 아직 완전히 파악하지 못했습니다.

3.2 초현실주의, 호러 영화, 혹은 이상한 골짜기 효과를 좋아한다면, 주의(Attention) 오버라이드 값을 20 이상으로 설정하세요(기본값 14).

3.3 “Dimension(이미지 전용)”과 “Height(텍스트에서 이미지로 전환 시)”라는 두 개의 노드가 있습니다. 이 노드들은 다음과 같이 작동합니다: Dimension은 이미지의 해상도를 자동으로 선택하고, Height는 텍스트에서 이미지로 전환 시 높이로 사용되며, 이 모드에서는 Dimension이 가로 크기를 담당합니다. 편의를 위해 이렇게 구성했습니다.

공식 매뉴얼:

- 큐를 클릭하고 결과를 기다리세요. 파일은 ComfyUI\output 폴더에 저장되며, 출력은 비디오: .mp4(작업 흐름과 매개변수가 파일에 포함됨)와 임시 이미지 .png입니다. 이 임시 이미지는 삭제할 수 있습니다.

💡 팁: .mp4 체인에서 .mp4를 제거하고 “SaveAnimatedWEBP” 노드를 추가하면 품질을 잃지 않고 비디오를 .WebP 형식으로 저장할 수 있습니다. WebP 형식을 다른 형식으로 변환해야 하는 경우, 제 WebP 변환기를 다운로드하세요.

▶️ https://github.com/dvl12000/webp-converter/releases/tag/v1.0.1

💡 팁: 처리 후, Topaz Video AI에서 “Theia” 모드로 이미지를 2배 또는 4배 확대하고, 샤프닝을 약 50으로 설정한 후 기본적으로 그레인을 적용하세요. 이를 통해 큰 향상이 가능합니다!

----------------------------

빌드를 평가하고 댓글을 남기세요! 즐거운 생성 되세요! 🔥