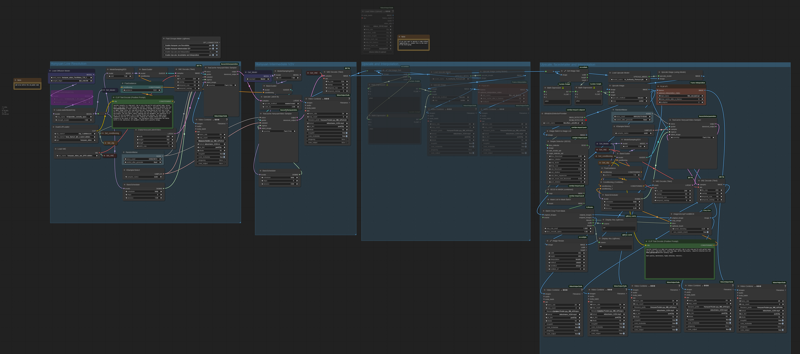

Hunyuan video t2v with facedetailer POC

详情

下载文件

关于此版本

模型描述

HUNYUAN 视频面部细节增强器 更新 V1.2

修复了问题:获取潜变量尺寸节点在处理 Hunyuan 潜变量视频时失效,导致输出视频宽度异常,破坏了图像宽高比。感谢 GoonyBird 指出该问题。

HUNYUAN 视频面部细节增强器 更新 V1.1

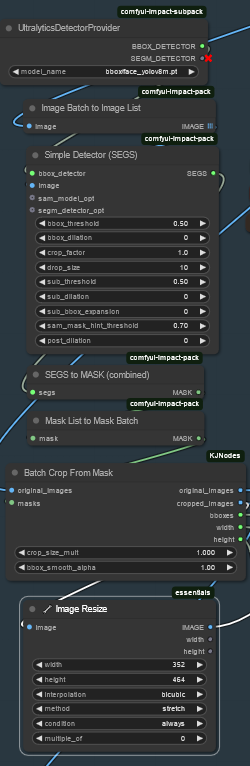

我尝试对面部细节增强组进行了一些改进,主要针对在许多场景(如小脸或慢动作)中令人困扰的闪烁问题(包括我自己也深受其扰)。

我采用了 Animatediff 检测器来对 BBOX 在相邻帧间进行平均处理,增加了 BBOX 膨胀值,并降低了位移、条件控制和去噪强度。

希望这比 V1 版本效果更好,但代价是面部细节定义略有下降。

进一步优化取决于第一阶段生成的视频,若出现闪烁,建议在面部细节增强模块中尝试以下调整:

使用 Animatediff 的简单检测器

增加 bbox_dilation(最大值 100)Modelsampling

降低 shift(最小值 0)Fluxguidance

降低 guidance(最小值 1)Basicscheduler

降低 denoise 至 0.4 以下

若仍无法消除闪烁,我另提供了一种静态 BBOX 的面部细节增强器作为替代方案。该方案通过取视频中人脸所有可能位置的并集,生成一个静态 BBOX。显然,该选项仅适用于视频中人脸运动幅度较小的情况。在我看来,其画质略低于动态 BBOX,但完全无闪烁,且对人脸消失、侧脸等复杂情况更具鲁棒性。

此外,我还改进了其他几点:

将采样器更换为 TTP_teaCache。超快模式可用于中间 V2V 或面部细节增强阶段的精炼,虽略有画质损失,但显著提升速度。

改进了放大算法,使其符合 Hunyuan 视频所需的 x16 放大要求。

修复了面部处理尺寸(约 368x5xx),以适配最新面部细节增强采样器框;若您拥有超过 12GB 显存,可自行调整。

优化了流程,使您可以独立选择放大、两种面部细节增强模式及插值器。

用绿色标注了您可能需要调整的节点。

祝您使用愉快!

基于优秀的 bonetrousers T2V 工作流:

/model/1092466/hunyuan-2step-t2v-and-upscale?modelVersionId=1294744

我思考是否能在最后一阶段的简单放大之外,做得更好。

受面部细节增强原理的启发,我认为有必要对面部放大给予额外关注——因为面部通常尺寸小、分辨率低且晃动剧烈,此时单纯放大效果甚微。

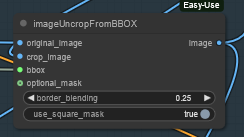

我的设想是:对人脸进行 BBOX 标定并裁剪,送入独立的 Hunyuan 细节增强工作流(附加专用于人脸的提示词),处理后再将结果粘贴回原图。

图像缩放是为了匹配 Hunyuan 潜变量尺寸,以便输入 VAE 编码器和采样器,确保输入高质量图像供 Hunyuan 精炼器使用。在完成 VAE 编码、Hunyuan 采样和 VAE 解码后,再粘贴回原图并进入后续步骤。就是这样。

我用附带的工作流进行了基本测试,仅作为概念验证,结果颇具前景。

当然,效果很大程度依赖于人脸大小(若人脸极小则无能为力)。该工作流对静态主体处理不佳,但毕竟我们讨论的是动画,对吧?

我观察到主体细节明显改善,模糊和晃动减少。本帖中部分示例(仅最后一个经过插值):

我是个 ComfyUI 新手,花了数小时才搞懂图像列表和批次,我的工作流非常基础,也未做精细调优,我相信专家用户仍有巨大优化空间,例如根据 BBOX 大小动态决定精炼视频尺寸,甚至为 Hunyuan 构建专用的面部细节增强节点。

如有时间,我下周末将尝试改进,例如将其整合进优秀的 LatentDream 全功能工作流。

一如既往,欢迎打赏咖啡: