Runpod WAN 2.1 Img2Video Template - ComfyUI

详情

下载文件

关于此版本

模型描述

🎥 WanVideo ComfyUI RunPod 设置指南

本综合指南将引导您在 RunPod 上设置和使用 WanVideo ComfyUI 环境以进行 AI 视频生成。Wan 需要大量显存才能以合理速度生成输出。48GB 显存每小时仅需 $0.44,我认为这是一笔非常划算的交易。

无需从此处下载任何内容。这是一个已包含所有模型和工作流程的 RunPod 模板。

WAN 2.1 视频 - ComfyUI 全功能 - T2.0 - 在 CUDA 2.5 上运行

https://runpod.io/console/deploy?template=6k2saccgx8&ref=0eayrc3z

## 更新

20/03/25

注意在使用社区云 GPU 时存在 Pytorch 错误。

编辑:仅限使用 Blackwell 架构的 5090 显卡。

19/03/25

修复错误:'NoneType' 对象不可调用

我在 ComfyUI 中添加了深度 0,并实现了减少容器大小的节点,但这些更改引入了多个错误。我已将其移除,现在一切应能更好地运行。

17/03/25

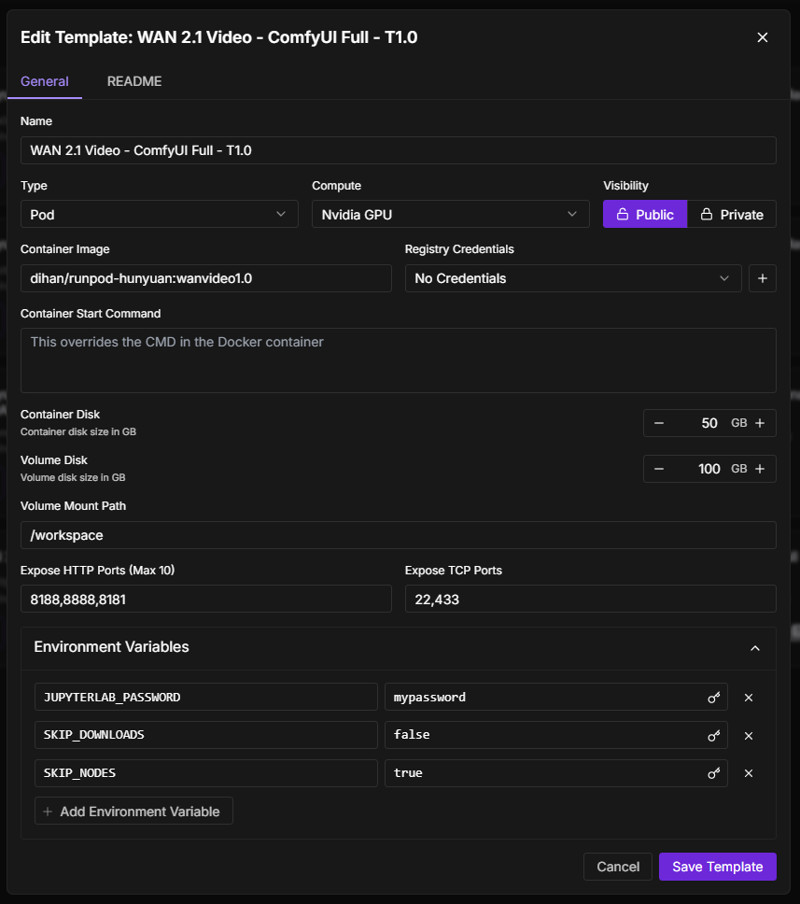

- 添加了环境变量以控制设置行为:

- `SKIP_DOWNLOADS=true`:跳过模型下载

- `SKIP_NODES=true`:跳过自定义节点验证(节点已打包进容器以加快构建)

🚀 开始使用

第一步:部署您的 Pod

注册/登录 RunPod

进入“部署” → “模板”

搜索模板“WAN 2.1 视频 - ComfyUI 全功能 - T1.0”

选择硬件:

推荐 GPU:RTX A40(最低 48GB 显存)

存储:最低 60GB(推荐 100GB)

筛选 CUDA 2.4 以上的 GPU

点击“部署”以启动您的 Pod

第二步:初始设置

部署完成后,您的 Pod 将自动:

下载所有必需模型(约需 10 分钟)

安装自定义节点

配置环境

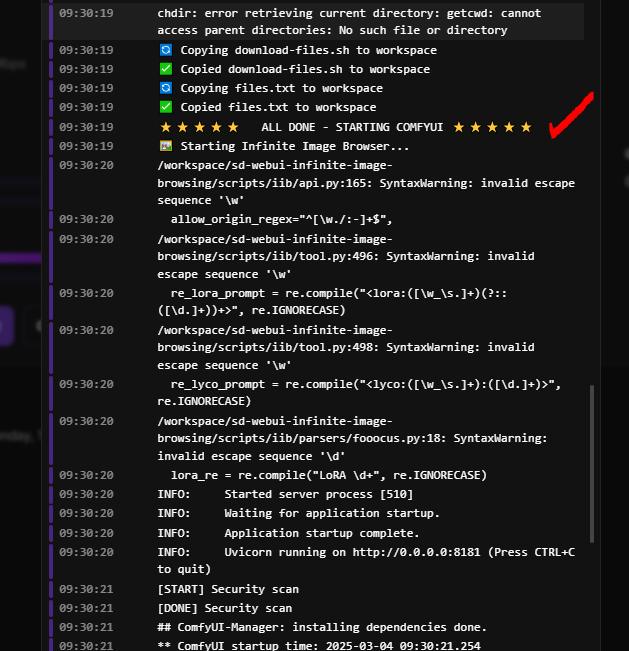

设置完成后,您将看到以下提示:

⭐⭐⭐⭐⭐ 全部完成 - 启动 ComfyUI ⭐⭐⭐⭐⭐

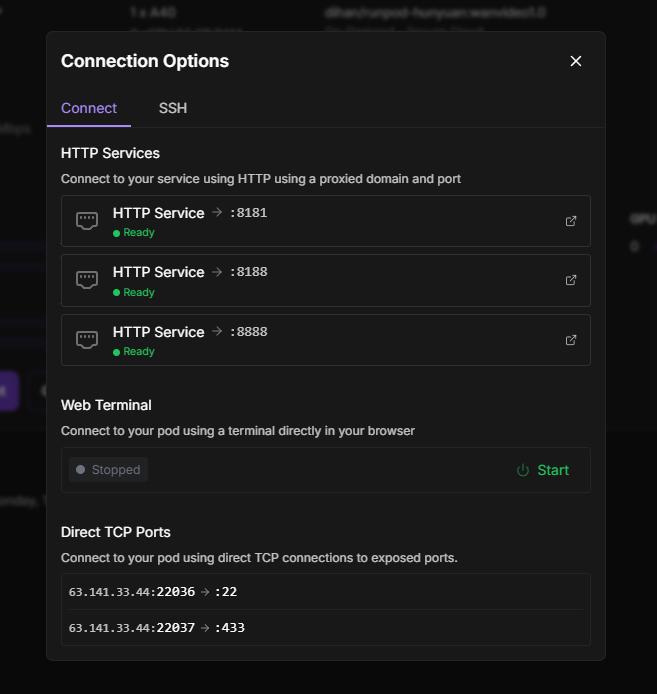

第三步:访问您的环境

从您的 Pod 详情页访问:

ComfyUI 界面:

端口 8188(创建视频的主要界面)

设置完成后等待其变为绿色

JupyterLab:

端口 8888(设置过程中即可立即使用)

用于文件管理、终端访问和笔记本交互

图片浏览器:

端口 8181(用于管理输出文件)

查看和整理生成的视频与图像

💾 模型管理

下载额外模型

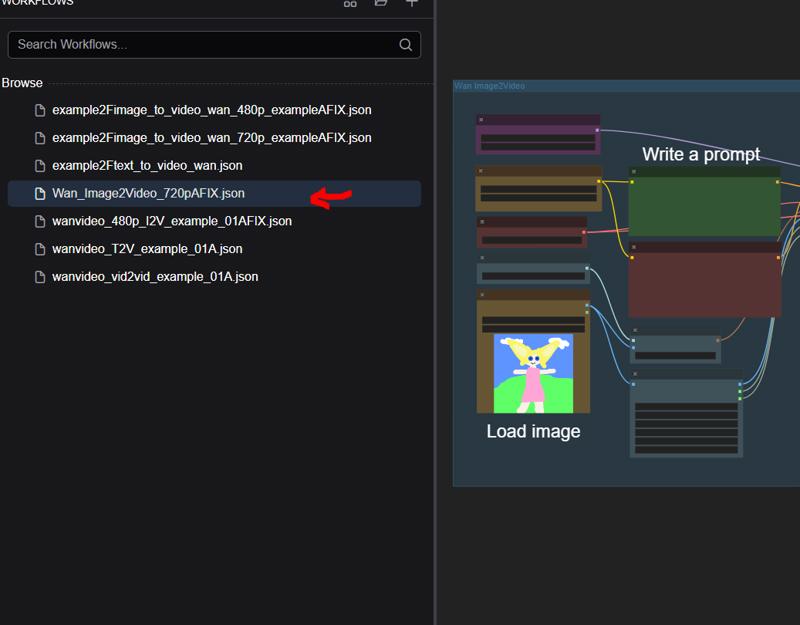

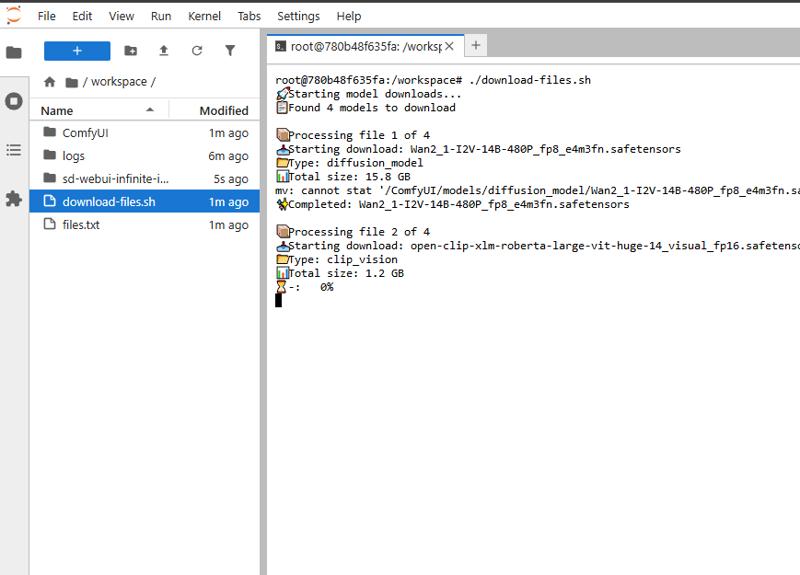

此模板仅下载 Wan_Image2Video_720pAFIX.json 工作流所需的所有内容。若您想使用其他工作流,请在终端中运行 ./[download-files.sh](http://download-files.sh),它将下载 Kajai 工作流所需的所有模型。

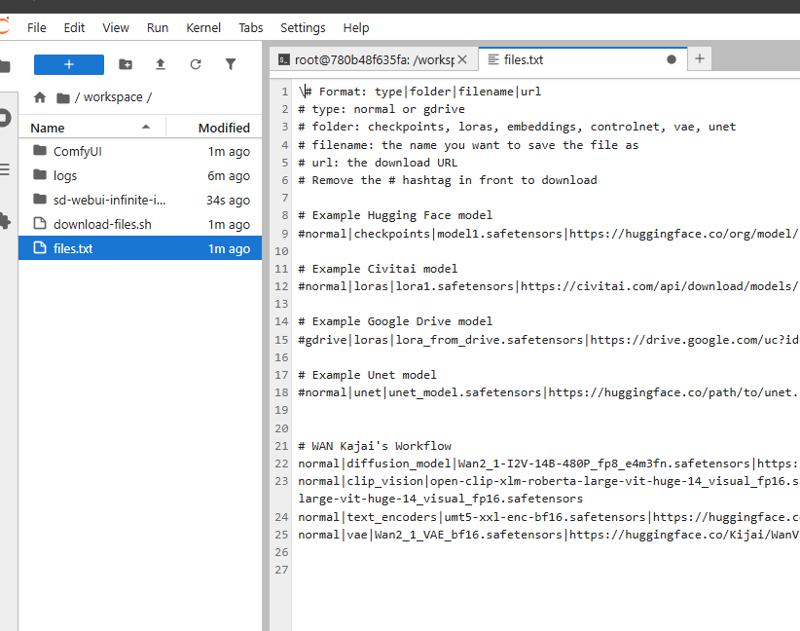

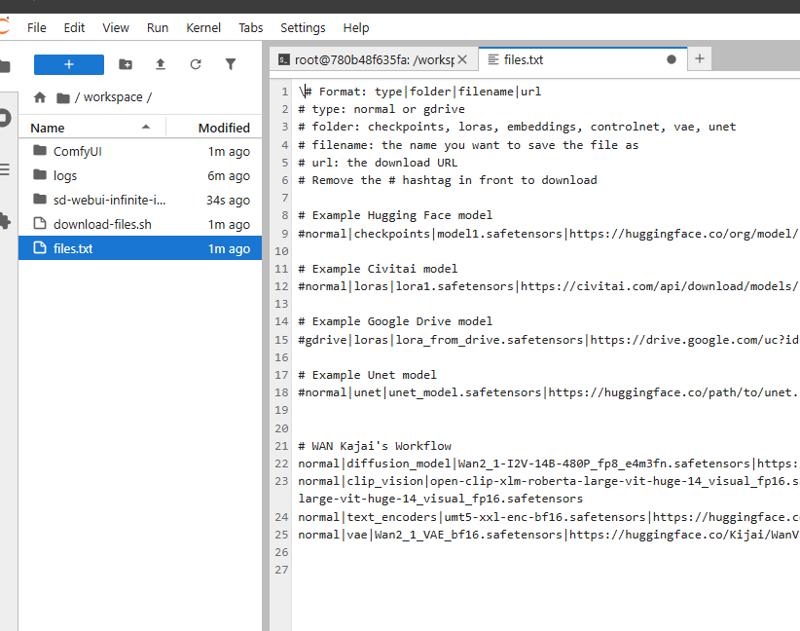

使用灵活的模型下载系统:

编辑配置文件:

files.txt

按以下格式添加模型条目:

type|folder|filename|url示例:

normal|checkpoints|realistic_model.safetensors|https://huggingface.co/org/model/resolve/main/model.safetensors gdrive|loras|animation_style.safetensors|https://drive.google.com/uc?id=your_file_id运行下载脚本:

./download-files.sh

WAN 2.1 模型

https://huggingface.co/Kijai/WanVideo_comfy/tree/main

https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/tree/main/split_files

预装模型

该模板已包含以下关键模型:

Wan 2.1 模型:

Wan2_1-I2V-14B-720P_fp8_e4m3fn.safetensors(基础视频模型)wan_2.1_vae.safetensors(VAE)

文本编码器:

umt5_xxl_fp16.safetensors(高级文本编码器)

CLIP 视觉模型:

clip_vision_h.safetensors(增强型视觉模型)

🎨 使用 ComfyUI 生成视频

第一步:加载工作流

访问 ComfyUI 界面(端口 8188)

点击顶部菜单中的文件夹图标

导航至默认工作流文件夹

选择一个预配置的工作流

第二步:自定义生成

修改文本提示,描述您期望的视频内容

调整设置:

CFG 值:推荐 7-9 以获得高质量(数值越高,越贴近提示)

步数:建议 25+ 步以提升质量(步数越多,细节越丰富)

分辨率:测试时使用 512x512,最终输出可提高分辨率

帧数:决定视频时长

第三步:生成并查看结果

点击“排队提示”开始生成

在 ComfyUI 界面中监控进度

完成后,在输出面板查看视频

通过图片浏览器(端口 8181)访问所有输出结果

📊 文件管理

使用 JupyterLab

访问 JupyterLab(端口 8888)

工作区文件夹包含:

/ComfyUI- 主程序与模型用于下载额外模型的文件

图像/视频浏览笔记本

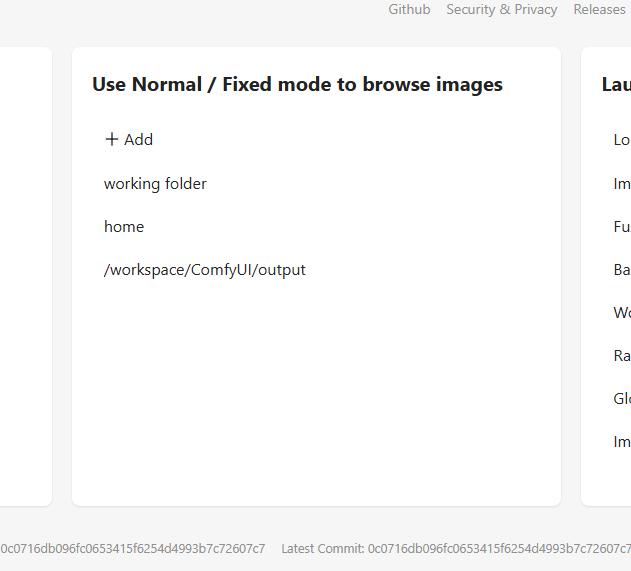

使用图片浏览器

访问浏览器界面(端口 8181)

通过以下方式浏览生成内容:

创建日期

文件名

元数据

右键点击项目获取更多选项(下载、删除等)

🔧 高级功能

SSH 访问

启用 SSH:

在部署前于模板设置中配置您的

PUBLIC_KEY使用 Pod 连接选项中显示的命令连接

自定义节点

该模板预装以下节点集合:

工作流工具(

cg-use-everywhere、ComfyUI-Manager)界面增强(

rgthree-comfy、was-node-suite-comfyui)视频专用节点(

ComfyUI-WanVideoWrapper、ComfyUI-VideoHelperSuite)性能优化器(

ComfyUI-Impact-Pack)

🛠️ 故障排除

如遇问题:

ComfyUI 无法启动:

在 JupyterLab 终端中查看日志

确保模型已正确下载

模型无法加载:

检查

/ComfyUI/models/目录下文件是否存在核对文件大小以确认下载完整

自定义节点异常:

尝试通过 ComfyUI Manager 重新安装

必要时重启您的 Pod

🎯 获得最佳效果的建议

使用包含详细描述的提示词

提高 CFG 和步数以获得更高质量视频

保存成功的 workflows 供未来重复使用

监控显存使用情况,并相应调整分辨率

使用图片浏览器整理和审查输出结果

需要更多帮助?请查看 JupyterLab 中的 readme.md 文件,或联系 RunPod 社区!