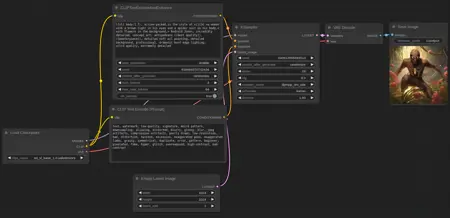

CLIP Text Encode And Enhance

詳細

ファイルをダウンロード

モデル説明

バージョン4の更新:

コードの小さな最適化を行いました。提示ベクトルとコンテキストベクトル間の角度計算を、計算負荷が高く効率が低いため削除しました。コンテキストベクトルは「mean」を設定することで無効化できます。提示ベクトルとコンテキストベクトルの中間にあるベクトルを含む、2番目の出力を追加しました。この出力は「negative」入力に接続することを目的としています。

バージョン3の更新:

注:現在、clip経由で何らかのものを接続する場合、正しく動作させるためにCFGを2~2.5倍に減らす必要があります。提示文に区切り文字が含まれていない場合のバグを修正しました。GPTが生成する単語の一意性と再現性に影響する新しい設定を3つ追加しました。GPTモデルをFredZhang7が提供するdistilgpt2-stable-diffusion-v2に置き換えました(ファイルサイズがわずかに軽く、多様性がわずかに向上)。GPTへの入力では停止語(冠詞、接続詞、代名詞)を除去して提示文が渡されます。テンソル形成段階では、提示文そのもののベクトルと、それと中心化されたベクトルの間の角度の余弦を掛けたベクトルを連結します。これにより、提示文だけでなくそのコンテキスト、および両者の意味的近接性も考慮されます。

バージョン2の更新:

テキストを入力に変換する際のバグを修正しました。GPTを無効化するオプションを追加しました。デフォルト設定を変更しました。無駄で繰り返しの多い文字列の妥当性チェックを簡素化しました。GPTには「Please continue with the descriptive prompt: 」という指示を与えています。GPTによる継続部分は、単語の途中で改行されないように最後のカンマまで切り詰められます。

バージョン1:

プロンプト作成体験を向上させるため、テキストエンコーダにいくつかの変更を加えました。

BREAKオペレータやCutoff拡張と同様の機能を持つ新しいオペレータ「>」を導入しました。これはプロンプトの意味的パートを互いに分離します。例えば、「青い髪 > 緑の目」とすると、青緑色の髪や緑の髪よりも青い髪を生成しやすくなります。プロンプトにこのようなオペレータを多用すると生成品質が低下する可能性があります。75トークンを超えるプロンプトも同様の方法で小さな部分に分割できます。

組み込みのGPT-2モデルはプロンプトの末尾を補完するのに役立ちます。正しく動作させるには、モデルのフォルダをノードのフォルダ内に配置する必要があります。使用しているモデルはAr4ikovのgpt2-pt-2-stable-diffusion-prompt-generatorですが、他のモデルに変更したり、独自にトレーニングすることも可能です。4つの設定があります:seed — 固定可能;num_beams — 1より大きい場合、複数の生成結果から答えを選択し、速度に大きく影響;max_new_tokens — 最大トークン数;do_sample — Trueの場合、次のトークンは前のトークンを基に選択されます。

テキスト入力ウィンドウのサイズは、ノードの右下隅を下にドラッグすることで変更できます。