Nakaseko Kaori/中世古香織 (Sound! Euphonium)

详情

下载文件

关于此版本

模型描述

- 由于 Civitai 的服务条款,部分图像无法上传。完整预览图像请见 HUGGINGFACE。

- 对于模型版本 v1.5.1 或 v2.0+,您可以像使用其他 LoRA 一样直接在 WebUI 中使用,它们是用 kohya 脚本训练的。

- 对于模型版本 v1.5 或 v1.4-,您必须同时使用两个文件才能运行。详细方法请参见描述中的“如何使用 Pivotal Tuned 模型”。

- 精简后的角色标签为:棕色头发、短发、痣、眼下痣、红眼。当角色的核心特征(例如发色)不够稳定时,您可以在提示词中添加这些标签。

- pt 文件推荐权重为 0.7-1.1,LoRA 权重为 0.5-0.85。

- 图像使用一些固定提示词和基于数据集的聚类提示词生成,采样种子为随机值,排除了人为挑选。您看到的就是您能得到的。

- 服装未进行专门训练。您可查看我们提供的预览图以获取对应服装的提示词。

- 本模型使用 522 张图像 训练而成。

- 训练配置文件请见:这里。

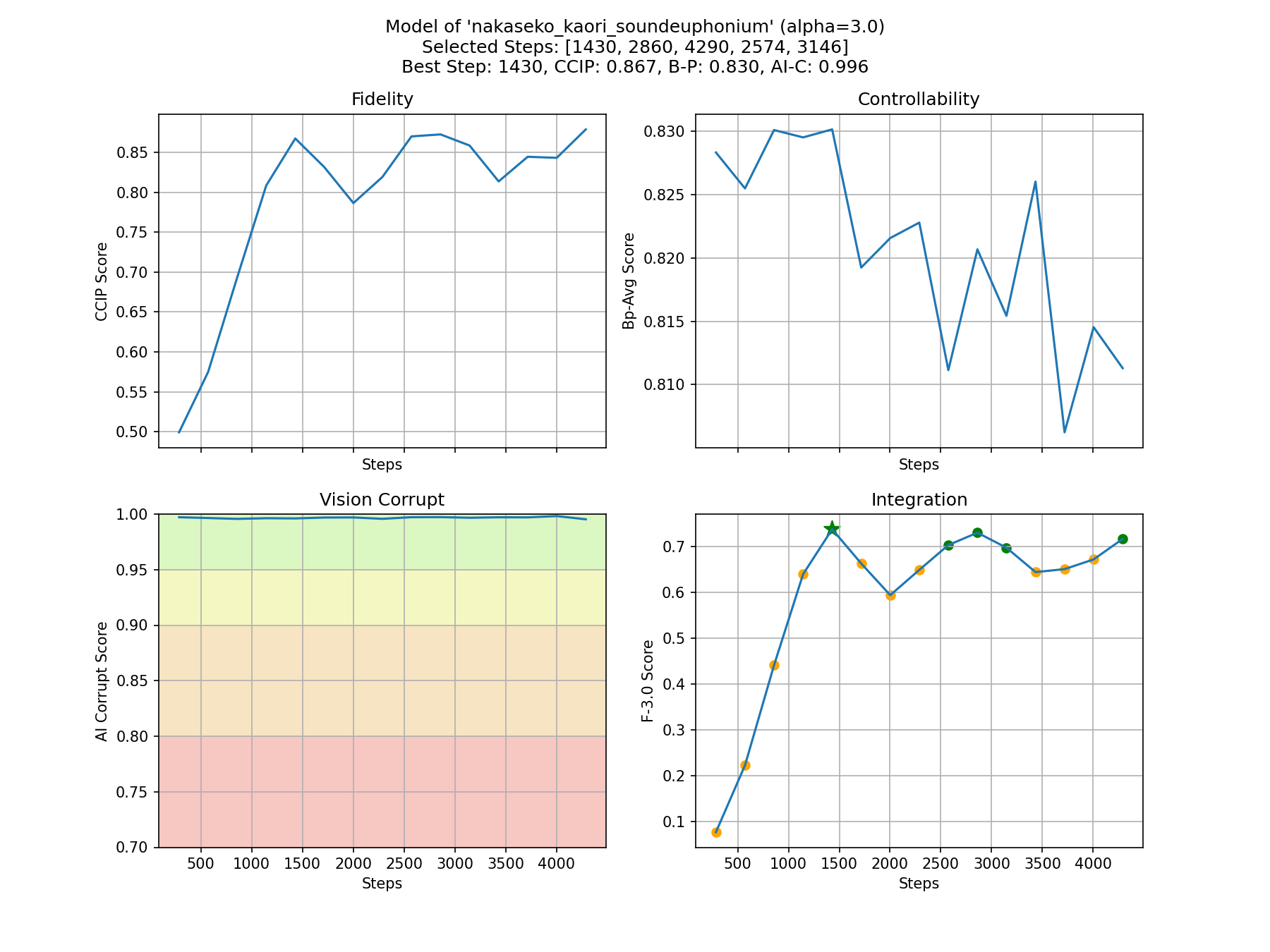

- 我们自动选择的训练步数为 1430,以平衡模型的保真度与可控性。以下是所有步骤的概览,您可以在 huggingface 仓库 - CyberHarem/nakaseko_kaori_soundeuphonium 中尝试其他推荐步数。

如何使用此模型

本部分仅适用于模型版本 v1.5.1 或 v2.0+。

您可以像使用其他 LoRA 一样直接使用它。我们使用 kohya 脚本训练了此模型。

他のLoRAと同様に簡単に使用できます。このモデルはkohyaスクリプトで訓練されました。

다른 LoRA처럼 간단히 사용할 수 있습니다. 우리는 이 모델을 kohya 스크립트로 훈련했습니다。

您可以像其他LoRAs一样简单地使用它。我们使用kohya脚本对该模型进行了训练。

(由 ChatGPT 翻译)

如果您正在寻找模型中的女角色,或对我们的技术感兴趣,欢迎加入我们的 Discord 服务器。

模型训练方式

- 本模型使用 kohya-ss/sd-scripts 训练,图像由 a1111 的 WebUI 和 API SDK 生成。

- 自动训练框架 由 DeepGHS 团队 维护。

- 训练使用的数据集为 CyberHarem/nakaseko_kaori_soundeuphonium 中的

stage3-p480-1200,共包含 522 张图像。 - 我们自动选择的步数为 1430,以平衡模型的保真度与可控性。

- 训练配置文件请见:这里。

更多训练细节和推荐步数,请参阅 huggingface 仓库 - CyberHarem/nakaseko_kaori_soundeuphonium。

如何使用 Pivotal Tuned 模型

本部分仅适用于模型版本 v1.5 或 v1.4-。

本模型包含两个文件。若您使用的是 WebUI v1.6 或更低版本,请务必同时使用这两个文件!!! 此时您需要下载 nakaseko_kaori_soundeuphonium.pt 和 nakaseko_kaori_soundeuphonium.safetensors 两个文件,然后将 nakaseko_kaori_soundeuphonium.pt 放入 embeddings 文件夹,并同时将 nakaseko_kaori_soundeuphonium.safetensors 作为 LoRA 加载。若您使用的是 WebUI v1.7+,则只需像常规 LoRA 一样使用 safetensors 文件即可。这是因为嵌入式 LoRA/Lycoris 模型目前已得到 a1111 WebUI 的官方支持,详情请见 此处。

このモデルには2つのファイルがあります。WebUI v1.6 以下のバージョンを使用している場合は、これらを一緒に使用する必要があります!!! この場合、nakaseko_kaori_soundeuphonium.pt と nakaseko_kaori_soundeuphonium.safetensors の両方をダウンロードする必要があり、 その後、nakaseko_kaori_soundeuphonium.pt を embeddings フォルダに入れ、同時に nakaseko_kaori_soundeuphonium.safetensors をLoRAとして使用します。 webui v1.7+を使用している場合、一般的なLoRAsのようにsafetensorsファイルを使用してください。 これは、埋め込みバンドルされたLoRA/Lycorisモデルが現在、a1111のwebuiに公式にサポートされているためです。 詳細についてはこちらをご覧ください。

此模型包含两个文件。如果您使用的是 WebUI v1.6 或更低版本,您需要同时使用这两个文件! 在这种情况下,您需要下载 nakaseko_kaori_soundeuphonium.pt 和 nakaseko_kaori_soundeuphonium.safetensors 两个文件, 然后将 nakaseko_kaori_soundeuphonium.pt 放入 embeddings 文件夹中,并同时使用 nakaseko_kaori_soundeuphonium.safetensors 作为 LoRA。 如果您正在使用 webui v1.7 或更高版本,只需像常规 LoRAs 一样使用 safetensors 文件。 这是因为嵌入式 LoRA/Lycoris 模型现在已经得到 a1111's webui 的官方支持, 更多详情请参见这里。

(由 ChatGPT 翻译)

触发词为 nakaseko_kaori_soundeuphonium,精简标签为 brown_hair, short_hair, mole, mole_under_eye, red_eyes。当某些特征(例如发色)在某些时候不够稳定时,您可以将这些标签加入您的提示词中。

为何部分预览图像看起来不像角色本人

所有预览图所使用的提示词(可通过点击图片查看)均是基于训练数据集中提取的特征信息,通过聚类算法自动生成的。图像生成时使用的种子也是随机选取,未经过任何筛选或修改。因此,可能出现上述问题。

在实际使用中,根据我们的内部测试,大多数遇到此类问题的模型,其真实使用效果通常优于预览图所呈现的结果。您唯一可能需要做的,是调整所使用的标签。

我觉得这个模型可能过拟合或欠拟合,该怎么办?

您在这里看到的步数是自动选择的。我们还为您推荐了其他优秀步数供您尝试。点击 这里 选择您喜欢的步数。

我们的模型已发布在 huggingface 仓库 - CyberHarem/nakaseko_kaori_soundeuphonium,所有步数的模型均已被保存。此外,我们还发布了训练数据集于 huggingface 数据集 - CyberHarem/nakaseko_kaori_soundeuphonium,可能对您有帮助。

为何不直接使用挑选出的最佳图像?

本模型从数据采集、训练,到生成预览图和发布,全过程 100% 自动化,无人工干预。这是我们团队进行的一项有趣实验,为此我们开发了一整套软件基础设施,包括数据过滤、自动训练和自动化发布。因此,若您能提供任何反馈或建议,我们将非常感激,因为它们对我们极其宝贵。

为何无法精确生成角色期望的服装?

我们当前的训练数据来源于多个图片网站,对于全自动流程而言,准确预测某角色拥有哪些官方图像极具挑战。因此,服装生成依赖于基于训练数据集标签的聚类,以尽可能还原最佳效果。我们会持续改进该问题并尝试优化,但目前仍难以彻底解决。服装还原的准确性也难以达到人工训练模型的水平。

事实上,本模型最大的优势在于精准还原角色本身的固有特征,以及得益于更大规模数据集所具备的较强泛化能力。因此,本模型非常适合用于更换服装、调整角色姿态,当然,也适用于生成角色的 NSFW 图像!😉

对于以下群体,我们不推荐使用此模型,并深表歉意:

- 无法容忍角色设计中哪怕最细微偏差的用户。

- 对角色服装还原准确性要求极高的应用场景使用者。

- 无法接受基于 Stable Diffusion 算法生成图像时潜在随机性的用户。

- 不适应使用 LoRA 自动训练角色模型的流程,或认为训练角色模型必须完全手动操作以避免“不尊重角色”的用户。

- 认为生成图像内容违背其价值观的用户。