Wan 2.1 Image to Video Loop | Workflow

详情

下载文件

关于此版本

模型描述

此工作流以一张图像作为起始和结束帧,用于创建循环视频。它能够移除视频开头和结尾的帧,以实现更平滑的循环过渡。我建议至少配备12GB显存。视频生成需要良好的硬件支持。

- 降低CFG值可加快生成速度,但会减少运动效果。

- 超过4秒的视频可能失败或耗时极长,3秒是循环视频的理想长度。 ----------

此工作流结合了 IMG to VIDEO simple workflow WAN2.1 和 Wan 2.1 seamless loop workflow。

我推荐配合 Live Wallpaper Fast Fusion 模型使用此工作流。

我不了解任何许可证信息,请自行承担使用风险。

---------- 自动提示功能需要 Ollama。安装过程不仅仅是安装 ComfyUI 中的一个节点。

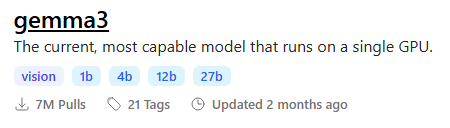

我推荐使用带有视觉能力的 gemma3 模型

为最大化输出质量,您可在 Ollama 中输入以下内容,为您的图像生成运动感知提示:

你是一位擅长无缝动画循环的运动设计专家。

给定一张单张图像作为输入,生成一份丰富详尽的描述,说明如何将其转化为流畅、无缝的动画。

你的回答必须包括:

✅ 哪些元素**应当运动**:

- 头发

- 眼睛

- 衣物或布料元素

- 光效

- 明显非刚性或非固定状态的漂浮物体

🚫 并**明确指定哪些元素应保持静止**:

- 刚性结构(例如:椅子、武器、金属盔甲)

- 未参与细微运动的身体部位(例如:躯干、四肢,除非存在轻微晃动)

- 无视觉运动暗示的背景元素

⚠️ 准则:

- 动画必须**流畅、一致且无缝**,适合循环播放

- 不得包含突兀动作、瞬移、场景切换或姿势变化

- 不得添加图像中不存在的物体或效果(例如:树叶、粒子、灰尘)

- 不得描述静态特征,如颜色、名称或环境主题

- 仅返回描述内容(无需列表、无Markdown、无指令、无需思考)

---------- 📂文件:

我推荐配合 Live Wallpaper Fast Fusion 模型使用此工作流。

将其放入 models/diffusion_models

常规版本

CLIP: umt5_xxl_fp8_e4m3fn_scaled.safetensors

置于 models/clip

GGUF 版本

24 GB 显存:Q8_0

16 GB 显存:Q5_K_M

<12 GB 显存:Q3_K_S

量化 CLIP: umt5-xxl-encoder-QX.gguf

置于 models/clip

CLIP-VISION: clip_vision_h.safetensors

置于 models/clip_vision

VAE: wan_2.1_vae.safetensors

置于 models/vae

任意超分模型:

写实风格: RealESRGAN_x4plus.pth

置于 models/upscale_models

----------

节点:

ComfyUI-Custom-Scripts

rgthree-comfy

ComfyUI-Easy-Use

ComfyUI-KJNodes

ComfyUI-VideoHelperSuite

ComfyUI_essentials

ComfyUI-Frame-Interpolation

comfyui-ollama

ComfyUI-mxToolkit

was-node-suite-comfyui

ComfyUI-WanStartEndFramesNative