Roukin8-character-LoHa/LoCon/FullCkpt ろうきん8

세부 정보

파일 다운로드

모델 설명

이 게시물은 동일한 데이터셋을 사용해 세 가지 종류의 최적화된 결과를 포함합니다: LoHa, LoCon, 및 전체 체크포인트 (모두 clip skip 1 사용).

관련 허깅페이스 레포지터리: https://huggingface.co/alea31415/roukin8-characters-partial (여기서 더 많은 버전을 찾을 수 있습니다).

모델들은 BP를 기반으로 최적화되었으며, 이는 BP를 사용함으로써 아래에서 보여주는 스타일을 얻을 수 있음을 의미합니다. 이러한 모델을 오렌지 전용으로 사용할 경우, 적절한 가중치 조절 없이 사용하면 오렌지 스타일이 손상될 수 있습니다.

LoHa/LoCon은 무엇인가요?

LoHa: 히드라마드 분해를 이용한 LoRA (참고 https://arxiv.org/abs/2108.06098)

LoCon: 잔차 결합 블록으로 확장된 LoRA

자세한 설명은 https://github.com/KohakuBlueleaf/LyCORIS/blob/lycoris/Algo.md를 참조하세요.

사용 방법

웹 UI 설치를 위해 https://github.com/KohakuBlueleaf/a1111-sd-webui-locon을 설치하고 LoRA처럼 사용하세요.

왜 LoHa인가요?

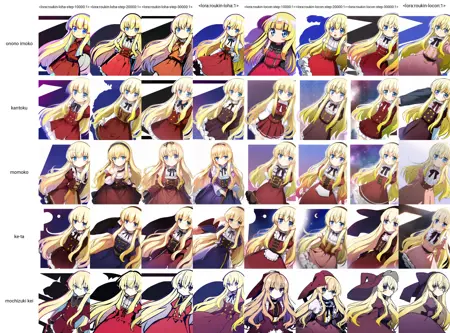

아래 비교 결과는 매우 설득력 있습니다.

(왼쪽 4개: 다양한 학습 스텝 수를 가진 LoHa; 오른쪽 4개: 동일한 조건의 LoCon; 동일한 시드, 동일한 학습 파라미터로 학습)

또한, 5명의 캐릭터 외에도 모델에는 다양한 스타일들을 학습시켰습니다 (이것은 제가 항상 해왔던 방식입니다).

그러나 LoRa와 LoCon은 캐릭터와 스타일을 잘 조합하지 못합니다 (캐릭터는 오로지 애니메이션 이미지만으로 학습됨). 이 문턱은 LoHa에서 크게 향상되었습니다.

두 파일의 크기는 거의 동일합니다 (약 30MB). 이 경우 LoCon은 (linear_dim, conv_dim) = (16,8), LoHa는 **(8,4)**로 설정했습니다. 그러나 히드라마드 곱을 사용함으로써 선형층에서는 8x8=64 등급, 합성곱층에서는 4x4=16 등급의 결과 행렬이 가능해졌습니다.

P.S. 20000 스텝 파일은 이곳에 제공됩니다. 다른 버전이 필요하시면 허깅페이스를 확인하세요.

전체 체크포인트는 어떨까요?

아래와 같이 여전히 가장 뛰어난 성능을 보입니다. 아마도 더 큰 차원, 합성곱층의 개선된 분해, 그리고 LoCon/LoHa 구현에서 아직 학습되지 않은 일부 계층을 다시 추가함으로써 LoHa로도 유사한 결과를 얻을 수 있을 것입니다. 지켜보면 됩니다.

학습 자세한 사양

- LoCon/LoHa: alpha 1, 위에서 지정한 차원, 배치 크기 8, 일정 스케줄러를 사용한 학습률 2e-4, AdamW

- 전체 체크포인트: 배치 크기 8, 코사인 스케줄러 사용 학습률 2.5e-6, Adam8bit, 조건부 드롭아웃 0.08

예시 이미지

이미지 1과 4는 LoCon에서 나왔고, 2와 3은 LoHa에서 나왔으며, 5와 6은 전체 체크포인트에서 나왔습니다.

데이터셋

3000장의 애니메이션 화면 캡처로 이루어진 애니메이션 데이터셋을 업로드했습니다. 현재 형식은 Everydream과 함께 사용할 수 있으며, multiply.txt 파일과 함께 사용하시면 됩니다. kohya trainer를 사용하시는 경우, 다음 스크립트를 사용하세요: https://github.com/cyber-meow/anime_screenshot_pipeline/blob/develop/utilities/flatten_folder.py

python flatten_folder.py --src_dir /path/to/dir