FlashAttention VS Test

详情

下载文件

模型描述

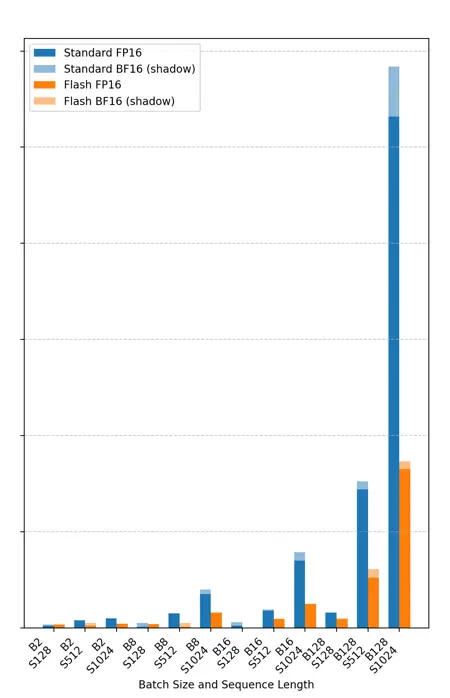

FlashAttention 与测试

基于您的系统测试和图表注意力。

待办:添加 Sage Attention

Comfy UI 用户推荐:

cmd /k python main.py --fp32-text-enc --fp32-vae --bf16-unet --use-flash-attention

注意:包含的 Flash Attention 编译版本适用于 Cuda 12.9

(已在 Comfy UI 中测试可用)