Uncensored Portable Ai Prompt Assistant for Wan, SDXL, Flux.1, and more

详情

下载文件

关于此版本

模型描述

便携式AI提示助手,这是我开发的一款免费开源桌面应用,专为此目的而生。它是一个完全在您本地机器上运行的简单工具,为您提供一个私密且多功能的环境,以大幅提升您的创意工作流程。

我为何开发这个工具?

虽然在线服务很棒,但我希望拥有一种能提供更强控制力、隐私性和灵活性的工具。我需要一个能实现以下功能的应用程序:

本地运行,无需将我的图像发送到第三方服务器。

与我已在使用中的Ollama和LM Studio的强大的开源模型无缝对接。

对比不同模型的输出结果。

专门针对为各类AI艺术模型生成高质量提示而设计。

支持生成无审查图像的提示。

Image-to-Prompt AI助手正是这一愿景的成果。

适用于任何模型的提示生成利器

核心设计目标之一是打造一款不局限于单一生态系统的工具。本应用生成的提示可精细调整,适配大量文本到图像模型。

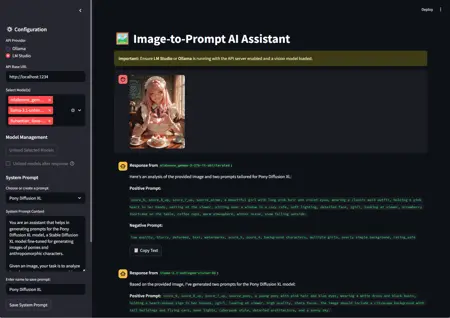

通过自定义系统提示词,您可以指导AI生成专为以下模型格式优化的提示:

SDXL & SD 1.5/2.1: 生成详细、逗号分隔的提示,包含关键词和负面提示。

Stable Diffusion 3(及Flux.1): 生成利用这些模型最新自然语言理解能力的提示。

DALL-E 3: 构建对话式、句子结构的提示。

Midjourney: 生成注重氛围与构图的风格化艺术提示。

Wan2.1: 从参考图像生成视频,或优化文本用于T2V任务。

您可以保存您喜爱的系统提示(如“创建电影感SDXL提示”或“生成简约动漫风格提示”),并一键切换。

(可对比输出结果,或为您的目标模型设置最佳系统提示。)

核心功能

这不仅仅是一个基础界面,而是集成了众多专为流畅高效体验而设计的功能。

本地优先,隐私至上: 与您本地的Ollama或LM Studio服务器协作。您的图像和提示永远不会离开您的设备。

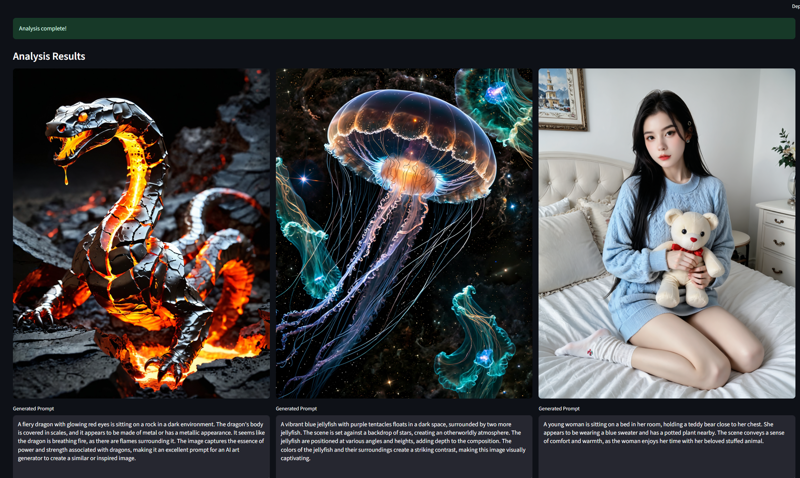

多模型对比: 选择多个视觉模型,同时获取每个模型的响应,快速判断哪个AI的描述最出色!

高级模型管理(Ollama): 响应后可手动或自动卸载模型以释放VRAM。

仅图像分析: 没有具体问题?只需上传图像并点击“分析”,即可立即获得描述。

完全用户控制: “停止生成”按钮让您可随时中断冗长响应。

对话历史记录: 查看整个会话内容,并导出为.txt或.json文件以供存档。

可定制工作流: 保存并重复使用无限数量的自定义系统提示,精准定制AI输出以满足您的需求。

快速上手

本应用使用Python和Streamlit构建,安装简单。

先决条件:

Windows 10 或 11。

已安装并运行Ollama或LM Studio(推荐)。

已下载并加载一个具备视觉能力的模型(如llava、Gemma 3等)。

🚀 安装步骤

下载压缩文件并解压内容。

打开 AiPromptAssistant 安装程序。

点击 安装 开始安装。

4. 从以下链接下载并安装 LM Studio:https://lmstudio.ai/

⚙️ 如何使用本应用

安装后,请按以下步骤操作:

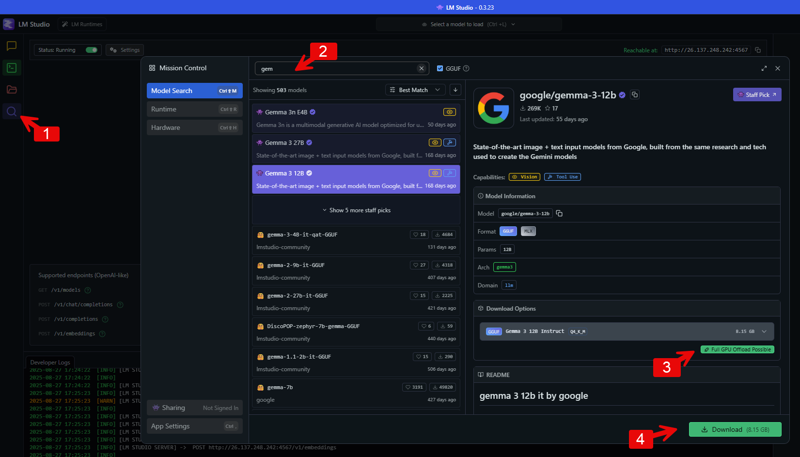

步骤1:在LM Studio中下载具备视觉能力的模型

进入模型搜索界面: 打开LM Studio,点击左侧菜单中的搜索图标(放大镜)进入模型搜索页面。

搜索模型: 在顶部搜索框中输入您要下载的模型名称。为查找支持图像处理的模型,可搜索“vision”等关键词。图片中展示了搜索“gemma”(谷歌的一系列模型)的结果,将显示多个版本。

选择并下载模型: 查找标注有“Vision”标签的模型。点击搜索结果中的模型,右侧将显示其详细信息。在“下载选项”下,您会看到不同可用文件。选择合适的版本,点击“下载”按钮保存到本地。

我使用的无审查模型:

我使用的无审查模型:

https://model.lmstudio.ai/download/concedo/llama-joycaption-beta-one-hf-llava-mmproj-ggufhttps://model.lmstudio.ai/download/bartowski/mlabonne_gemma-3-27b-it-abliterated-GGUF

https://model.lmstudio.ai/download/mlabonne/gemma-3-12b-it-abliterated-GGUF

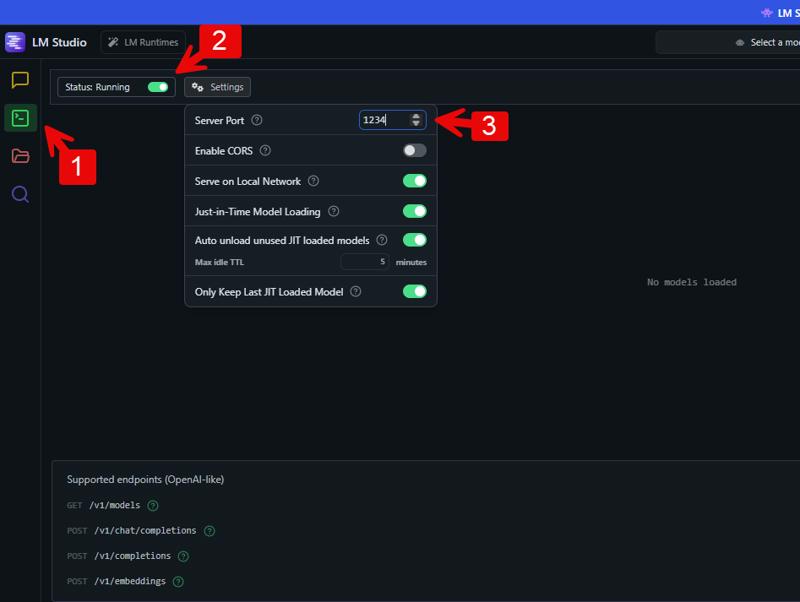

步骤2:在LM Studio中启用API服务器

切换至高级视图: 要访问本地服务器设置,需先启用相应视图。在LM Studio底部,点击 “Power User” 或 “Developer”。

进入本地服务器标签页: 在LM Studio左侧菜单中,点击形如 <_> 的图标,打开本地服务器设置。

启动服务器: 在此页面顶部,您会看到“状态”旁的开关。点击将其从“已停止”切换为“运行中”,即可启动本地API服务器。

设置服务器端口: 在服务器设置中,可指定API端口号。示例中端口设为“1234”,您可使用默认值,或更改为其他可用端口。

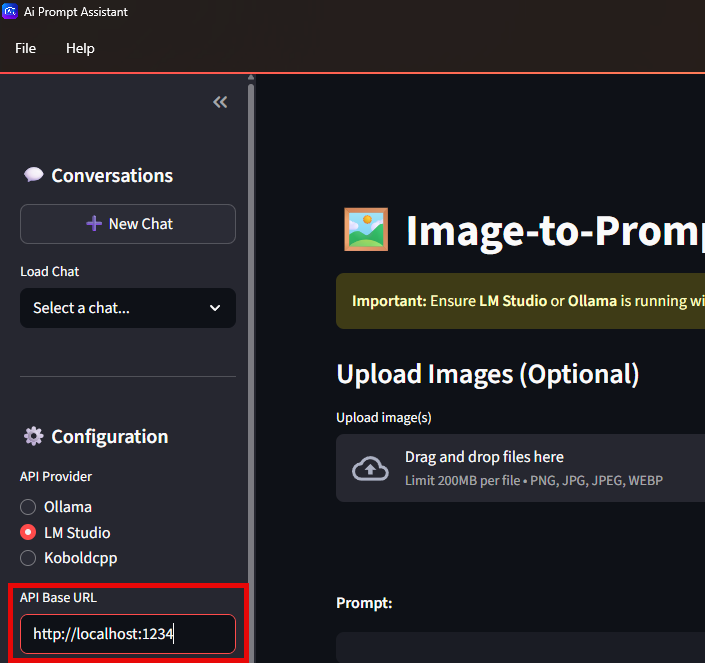

步骤3:将您的应用连接到LM Studio API

打开AI提示助手。

配置API端点: 在应用设置中找到“配置”部分,输入API基础URL。该URL应指向您的本地机器(localhost)及您在LM Studio中设置的端口。

输入API基础URL: 在“API基础URL”字段中,输入 http://localhost: 后接您在LM Studio中设置的端口号。例如,若使用端口1234,则输入 http://localhost:1234。这将告知您的应用向运行在LM Studio中的模型发送请求。

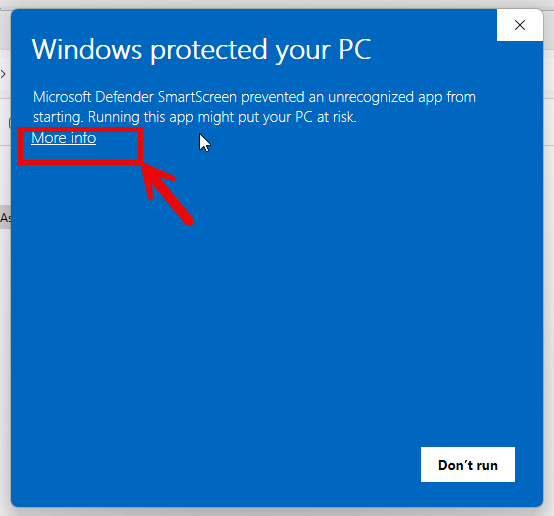

⚠️ 重要提示

安装程序时,您可能会看到多个安全警告。这是因为软件包包含一个.exe文件,这在从非官方应用商店或知名度较低的开发者处下载的应用中非常正常。

请不必担心——这不代表程序包含病毒。与任何从互联网下载的文件一样,建议使用可信杀毒软件扫描后再安装,然后忽略这些警告即可。

如果您对安装.exe程序感到不安,也可以尝试开源的Python版本。请注意,该版本需要额外的设置步骤,且缺少部分功能。您可在此处获取:

👉 开源Python版本

更新日志

V1.3:通过Files API集成,新增对Google Gemini模型的视频上传与分析支持。

V1.1:新增“批量分析”标签页,可分析选定文件夹中的所有图像。现在您可以输入文件夹路径,并选择将生成的提示保存为同目录下的文本文件。

V1.2:新增对Google Gemini Flash模型(1.5、2.0和2.5)的支持。