Pusa

詳細

ファイルをダウンロード

モデル説明

Pusaは、LoRAフォーマットのWan 2.2向けファインチューニングモデルです。動画品質を向上させます。

必要条件:Kijai WanWrapperノード https://github.com/kijai/ComfyUI-WanVideoWrapper

注意:2025年9月3日現在、ComfyUIは昨日Pusaノードを更新しました。現在はやや使いやすくなっています。

1つのモデルで複数のタスクを支援。すべてLightX2Vで4ステップ推論をサポート:画像から動画、開始・終了フレーム、動画補完、動画拡張、テキストから動画、動画トランジションなど。

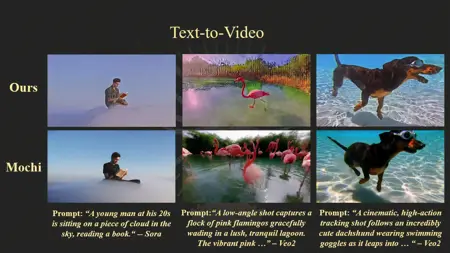

Wan 2.2 Pusaの機能

動画生成タスク:テキストから動画、画像から動画(静止画を動くシーンに変換)、動画拡張、トランジション、さらには開始フレームと終了フレームを両方指定して動画にシームレスにマッピングするような複雑なタスクも対応可能です。

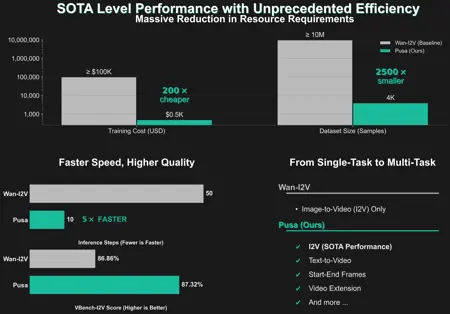

マルチ入力・マルチタスク:従来のモデルは各タスクごとに別々のモデルやトレーニングが必要でしたが、Wan 2.2 Pusaの独自設計(「Pusaパラダイム」)により、1つの統合システムでさまざまな動画タスクを一般化でき、追加トレーニングが最小限で済みます。

高速かつ効率的:「LightX2V」の高速化と「ベクトル化されたタイムステップ適応(VTA)」のおかげで、わずか数ステップの推論で高品質な結果を実現し、動画生成に必要な計算リソースと時間を大幅に削減します。

動作原理

ベクトル化されたタイムステップ適応(VTA):核心的な革新点は、各動画フレームに対して複数の「タイムステップ」を使用し、動画全体で動きやトランジションを独立して適応させることです。これにより、動画の各部分がカスタマイズされた動きで進化し、元のベース動画モデルの強みを損なうことなく、時間的スムーズさと創造的な制御が可能になります。

エキスパート混合(MoE):Wan 2.2は2つの専門サブモデルを用いています。1つは「高ノイズ」(複雑な動き)用、もう1つは「低ノイズ」(静的ディテールの保持)用。これらの長所を組み合わせることで、より優れた動画品質を実現します。

LoRAファインチューニング:Pusaモデルは軽量で「手術的」な適応手法(LoRA)を使用して、画像から動画などの新機能を追加しながら、ベースモデルがすでに優れている機能(例:テキストから動画)を上書きしません。効率的に新機能を追加しつつ、既存の能力を維持します。

Wan 2.2 Pusa

https://github.com/Yaofang-Liu/Pusa-VidGen

https://huggingface.co/RaphaelLiu/Pusa-Wan2.2-V1

https://huggingface.co/Kijai/WanVideo_comfy/tree/main/Pusa

これらのLoRAはランク256です。そのためファイルサイズが非常に大きくなっています。これらのLoRAは、Wan 2.2の動画・画像品質を向上させることを目的としています。個人的な使用では、その効果は控えめですが、常に動画の品質は改善されます。NSFW用にトレーニングされたかどうかは不明ですが、NSFWコンテンツでも問題なく動作します。

作者のページによると、重みは約1.4–1.5で使用することを推奨しています。LightX2Vを用いて4〜8ステップで使用するか、通常のステップ数で通常通り使用できます。